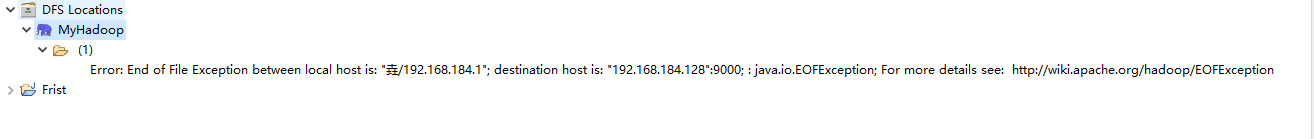

从MapReduce连接到hadoop上提示。

Error: End of File Exception between local host is: "垚/192.168.184.1"; destination host is: "192.168.184.128* :9000; : java.io.EOFException; For more details see: http://wikiapache.org/hadoop/EOFException

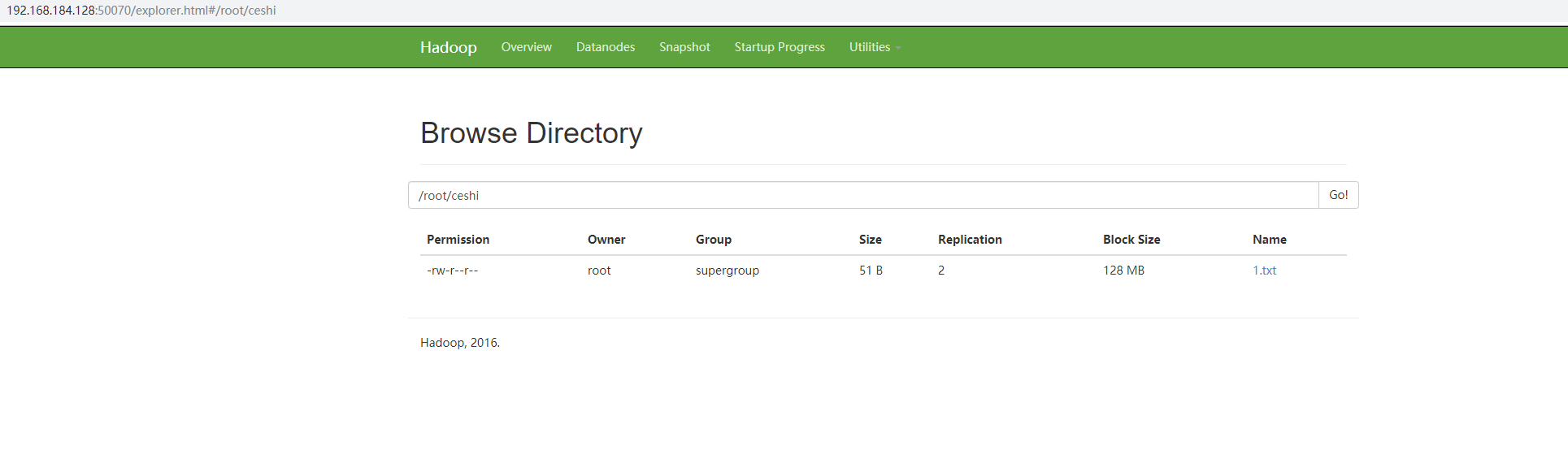

但是,我的虚拟机可以连接到hadoop:50070的页面

萌新求解,实在搞不懂为啥MapReduce为什么连不上hadoop

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到这个错误提示,通常意味着在尝试与Hadoop的NameNode通信时出现了问题。具体来说,EOFException(End Of File Exception)表明客户端在尝试读取数据时遇到了意外的文件结束,可能是因为连接被提前关闭或者数据传输不完整。

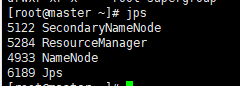

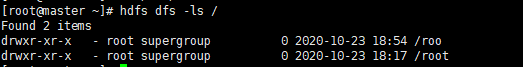

根据你描述的情况,虽然能访问Hadoop Web UI(通过50070端口),这说明NameNode服务是运行正常的,但MapReduce作业无法成功提交到Hadoop集群,这可能是由以下几个原因造成的:

网络配置问题:确保你的虚拟机网络设置正确,且能够与Hadoop集群中的所有节点(特别是NameNode)正常通信。检查虚拟机的网络配置,包括IP地址、子网掩码和路由设置,以及是否有防火墙或安全组规则阻止了9000端口的访问。

Hadoop配置问题:

core-site.xml),确认fs.defaultFS配置项指向的是正确的NameNode地址(即192.168.184.128:9000)。确保这个地址与实际运行NameNode的地址一致。版本兼容性问题:如果你使用的是不同版本的Hadoop客户端和服务端,可能会出现兼容性问题。请确认客户端和服务端的Hadoop版本一致。

资源或权限问题:检查NameNode是否有足够的资源来处理请求,以及执行MapReduce任务的用户是否具有必要的权限访问HDFS。

时间同步问题:虽然不常见,但系统时间不同步也可能导致一些难以预料的问题。确保所有节点的时间同步。

解决步骤建议如下: - 首先,再次仔细检查并验证所有的网络配置和Hadoop配置文件。 - 使用netstat -an | grep 9000命令在NameNode服务器上检查9000端口是否正在监听。 - 尝试从运行MapReduce任务的机器直接使用telnet 192.168.184.128 9000或nc -zv 192.168.184.128 9000来测试网络连通性。 - 查看Hadoop的日志文件(通常位于$HADOOP_HOME/logs/目录下),寻找更详细的错误信息,这些日志可能会提供失败的具体原因。

如果以上步骤都无法解决问题,考虑查阅Apache Hadoop官方文档或社区论坛寻求帮助,同时提供的错误链接http://wiki.apache.org/hadoop/EOFException也是一个很好的起点,尽管请注意该链接可能需要更新为当前Apache Hadoop项目的最新文档页面。