代码如下:

package SQL

import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

import org.apache.spark.SparkConf

import org.apache.spark.sql.SQLContext

import org.apache.log4j.{Level,Logger}

/**

* Created by hduser on 16-3-9.

*/

object SparkSQL {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("SparkSQL Application").setMaster("local")

val sc = new SparkContext(conf)

val sqlContext = new org.apache.spark.sql.SQLContext(sc)

import sqlContext.implicits._

Logger.getLogger("org.apache.spark").setLevel(Level.WARN)

Logger.getLogger("org.apache.spark.sql").setLevel(Level.WARN)

val df = sqlContext.read.json("/home/hduser/spark/examples/src/main/resources/people.json")

df.show()

df.printSchema()

df.select("name").show()

df.select("age").show()

df.select(df("name"), df("age") + 1).show()

df.filter(df("age") > 21).show()

df.groupBy("age").count().show()

}

}

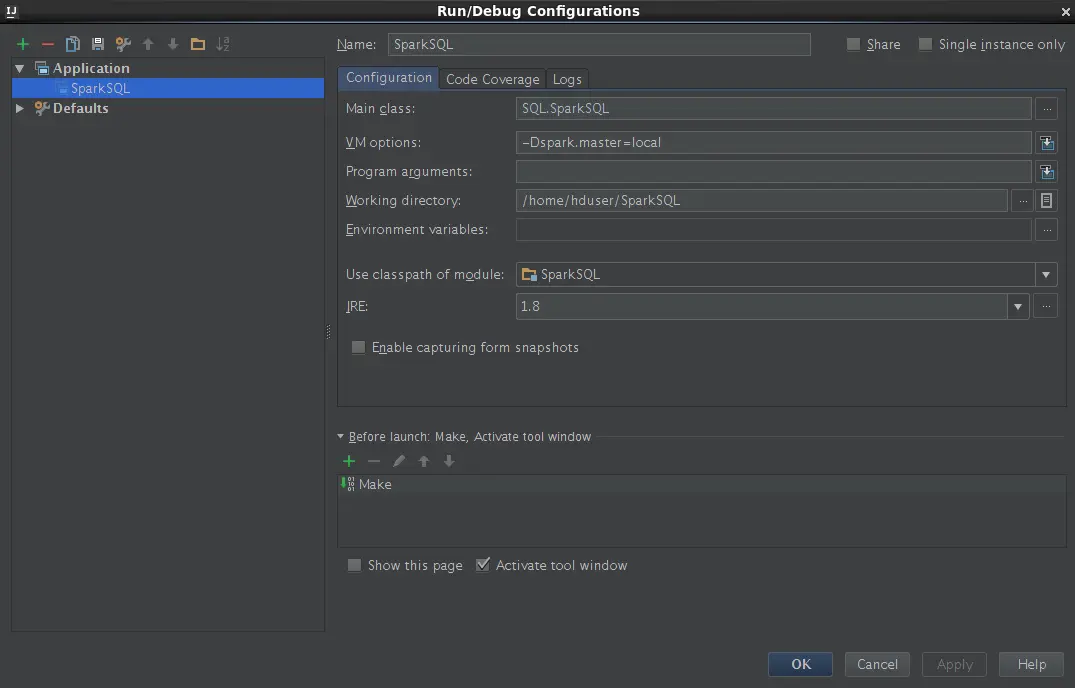

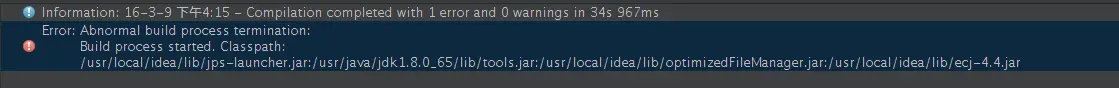

补充error信息:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

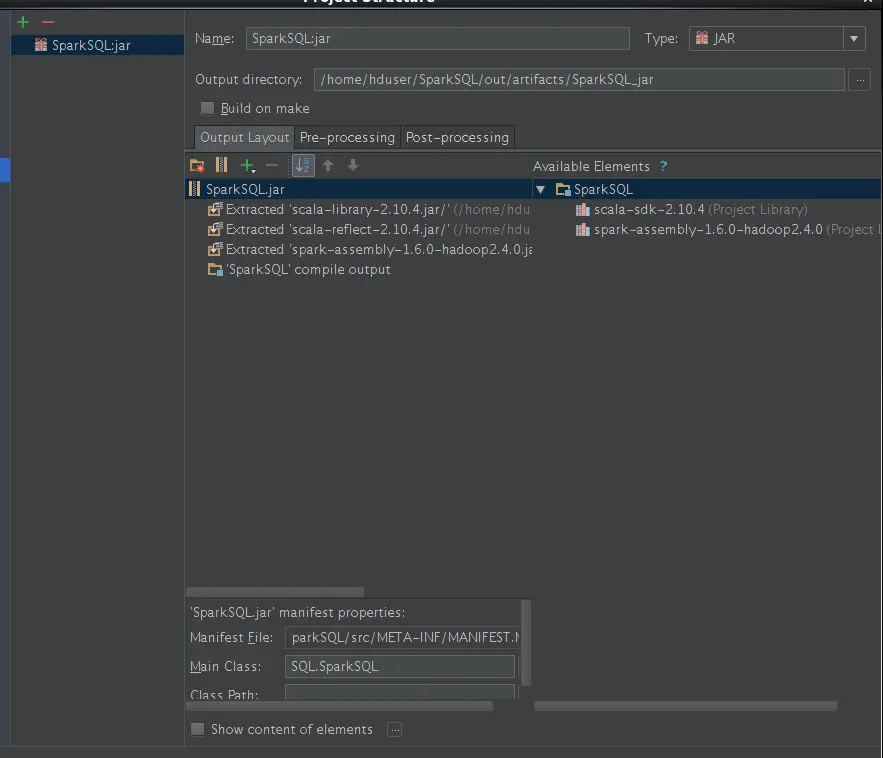

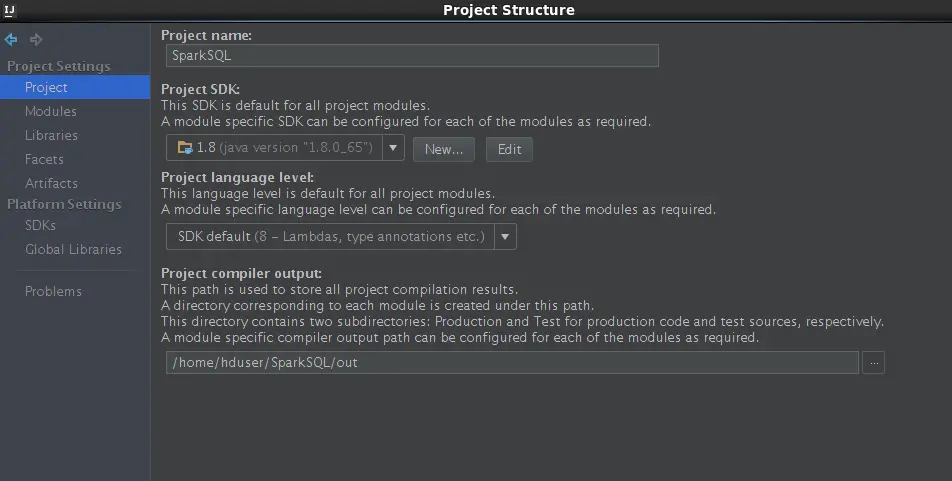

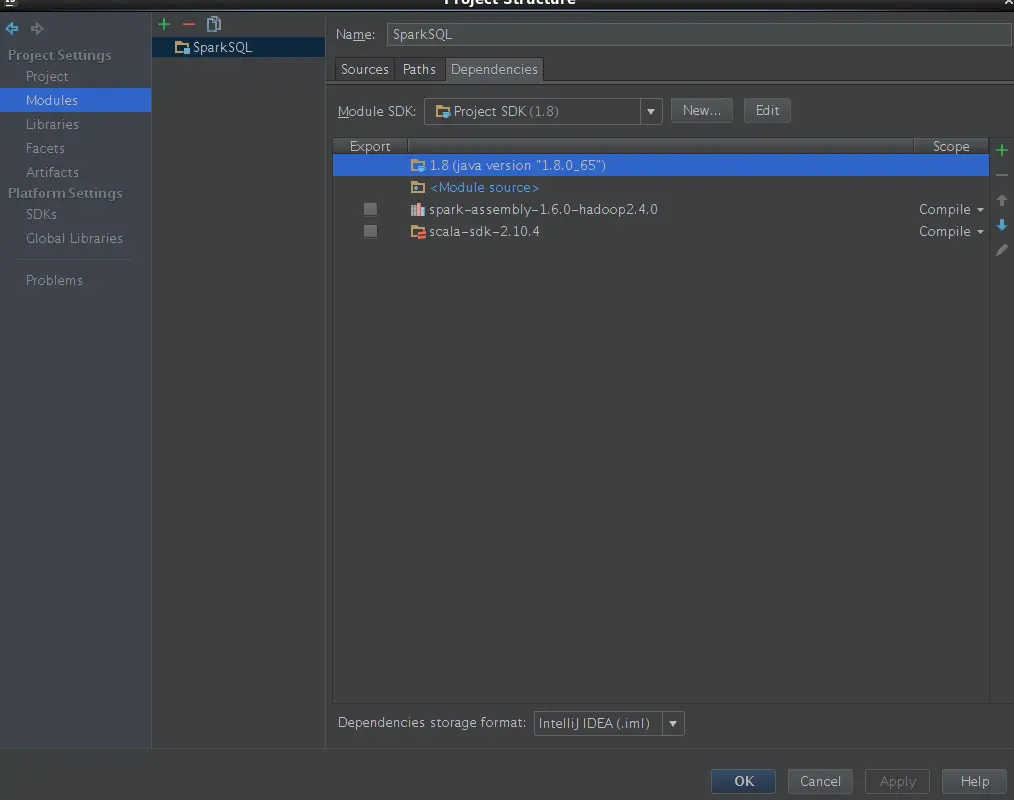

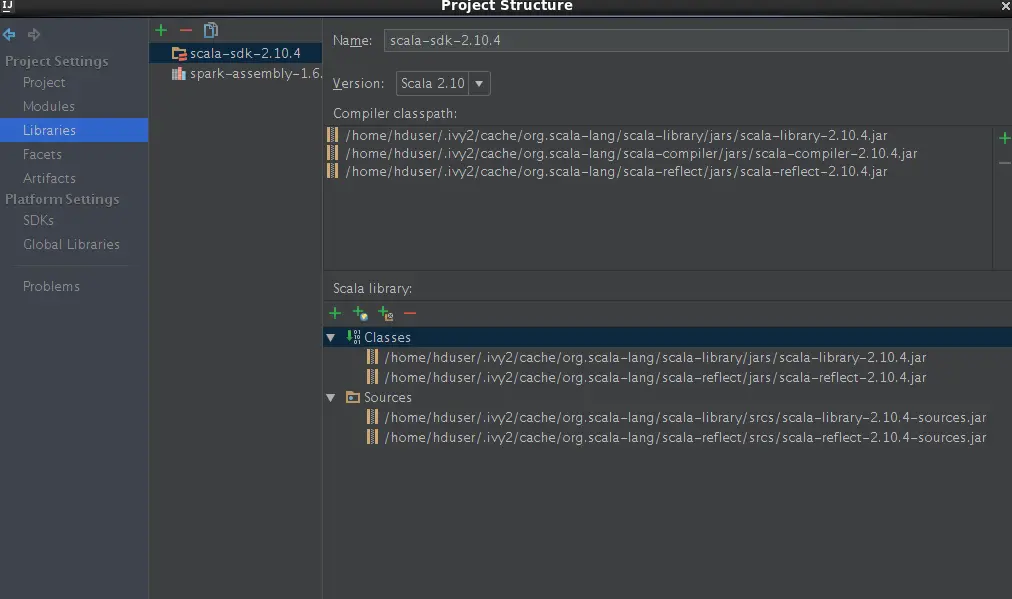

仔细检查一下,估计是少依赖包了,你在开发工具中,有些依赖包是它默认自带的.少了依赖包,运行应该不会成功吧