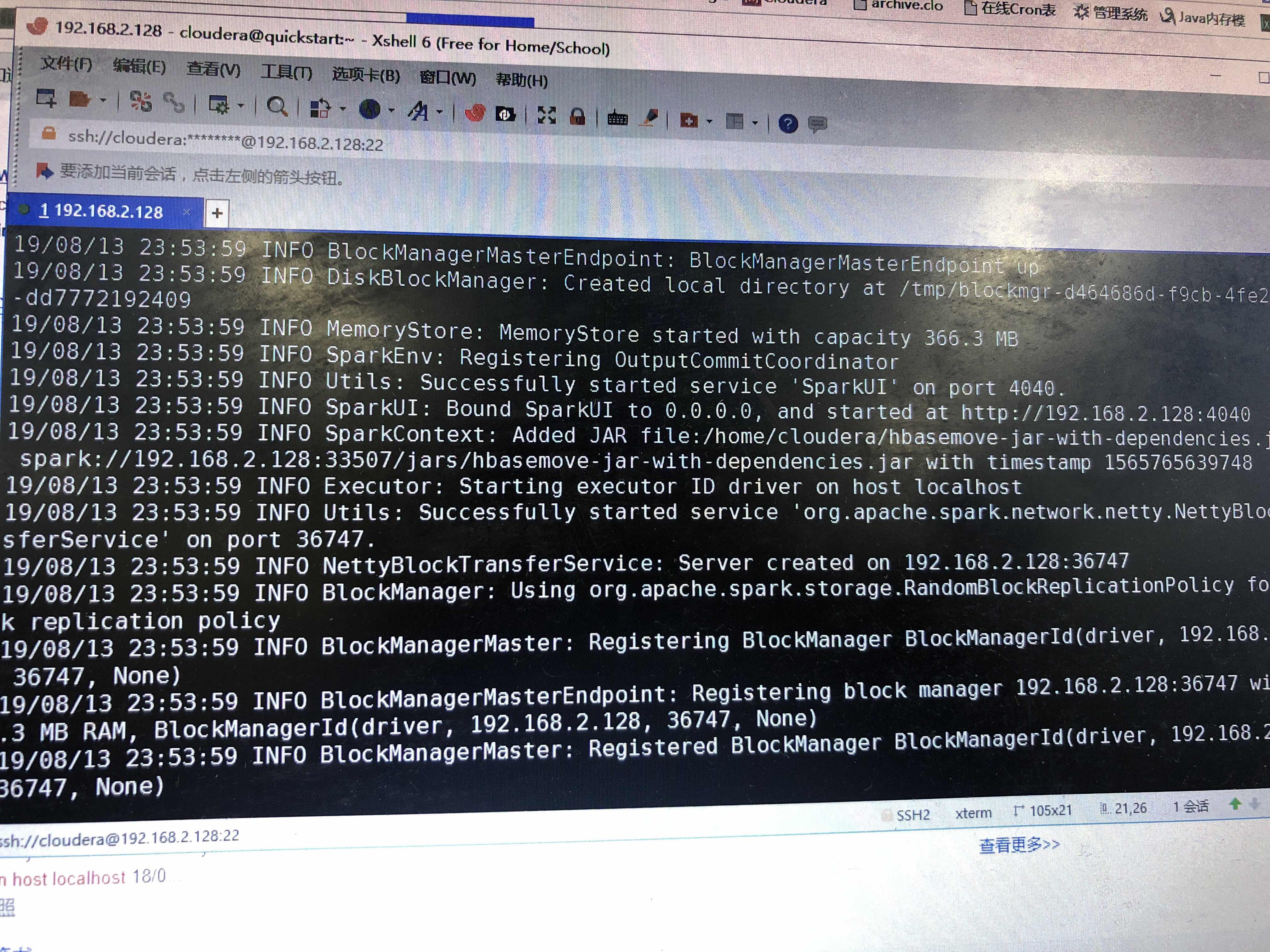

请问下我spark-submit指定yarn模式为什么还是运行在本地?

executor还是在本地

提交命令是

spark-submit --class hbase.SparkExToHBase

hbasemove-jar-with-dependencies.jar --

master yarn--deploy-mode client --driver-

memory 1g --num-executors 1 --executor-

memory 2g --executor-cores 2

试了deploy-mode cluster也不行

使用yarn提交一直没有提交上

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

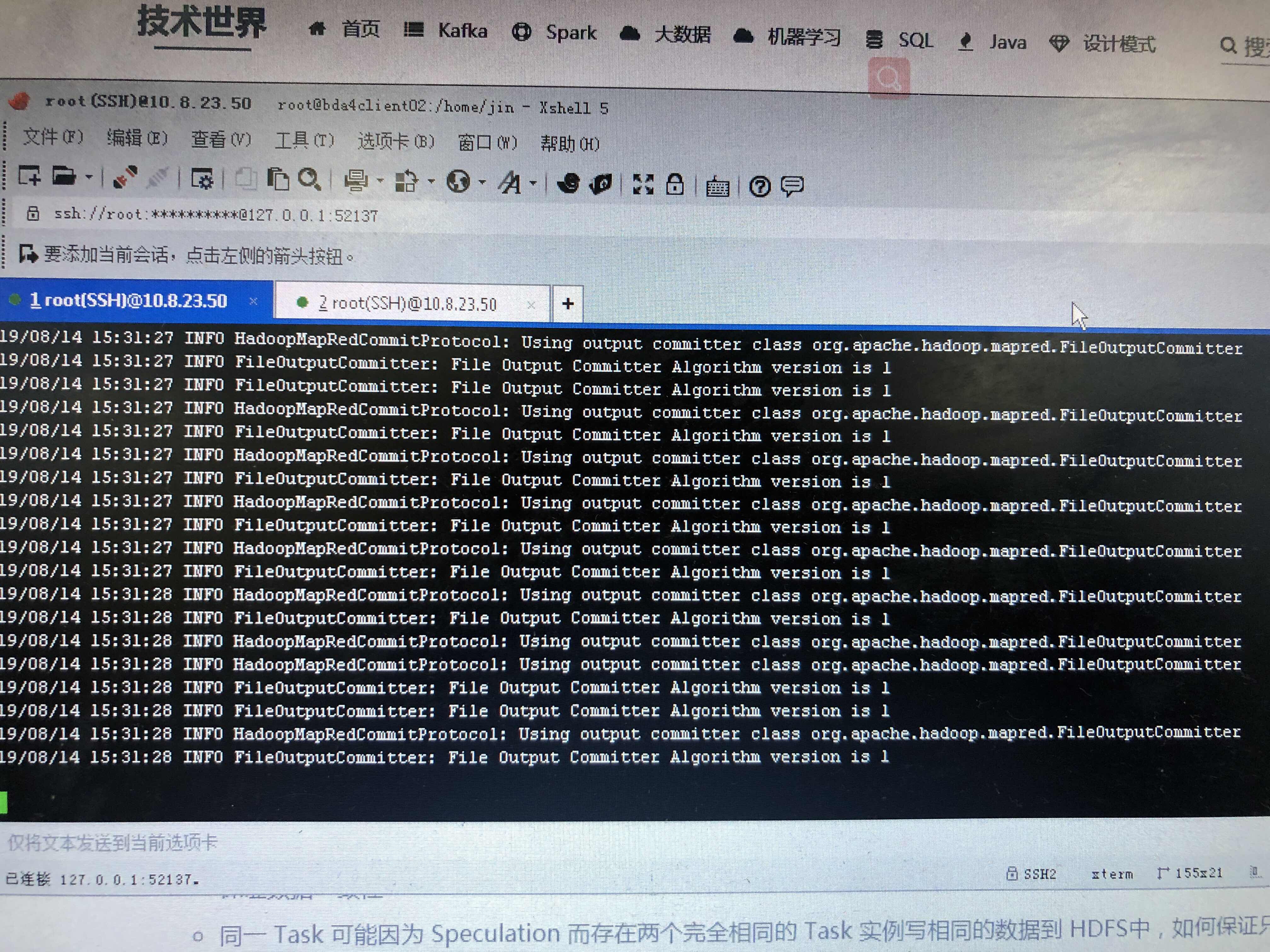

--executor-memory 是指定每个executor(执行器)占用的内存 --total-executor-cores是所有executor总共使用的cpu核数 --executor-cores是每个executor使用的cpu核数 对于spark-shell还可以在yarn上执行: --master yarn-client 这里必须是client,不同于spark-submit的yarn-cluster, 因为spark-shell作为一个与用户交互的命令行,必须将Driver运行在本地,而不是yarn上, 其他的参数与submit一样.

答案来源于网络