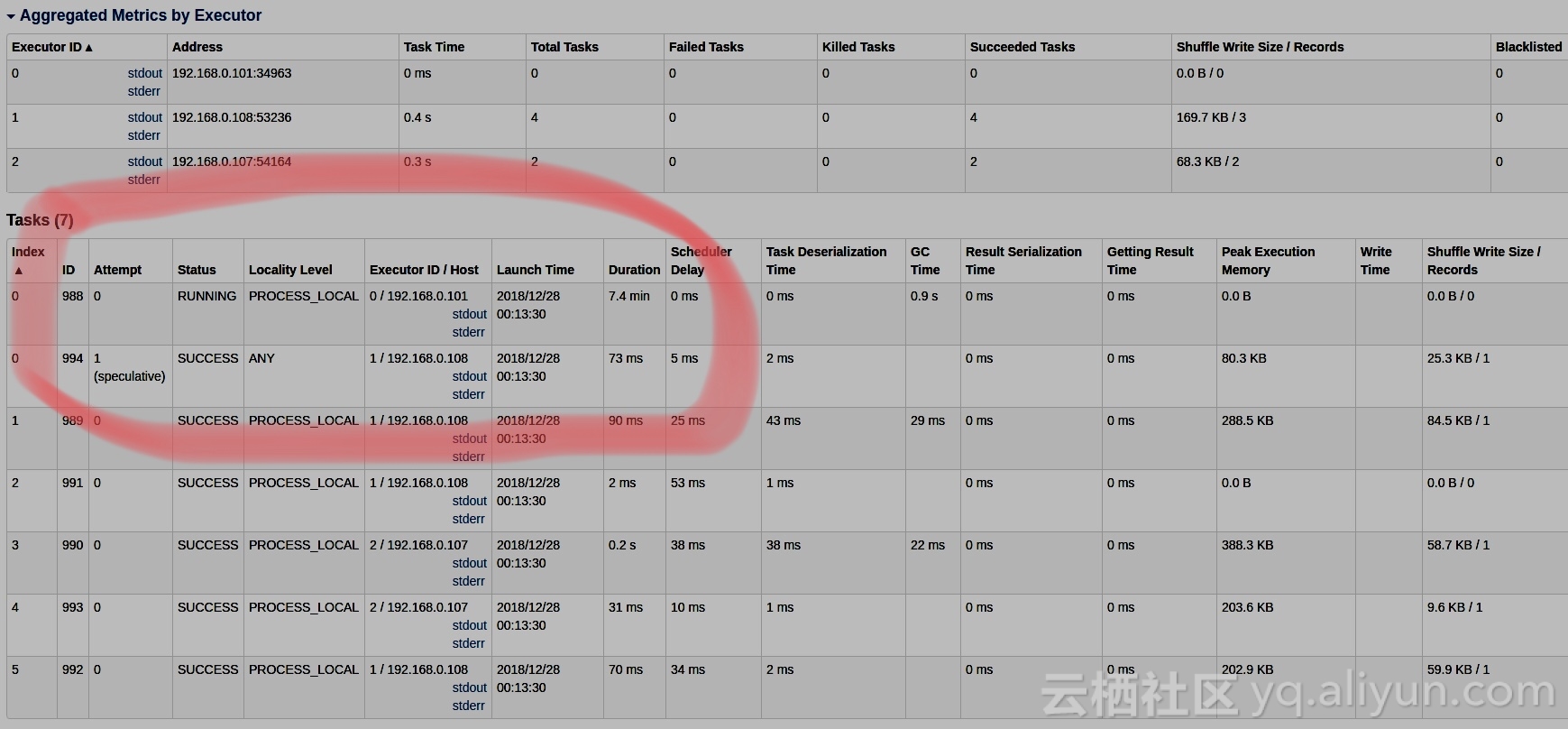

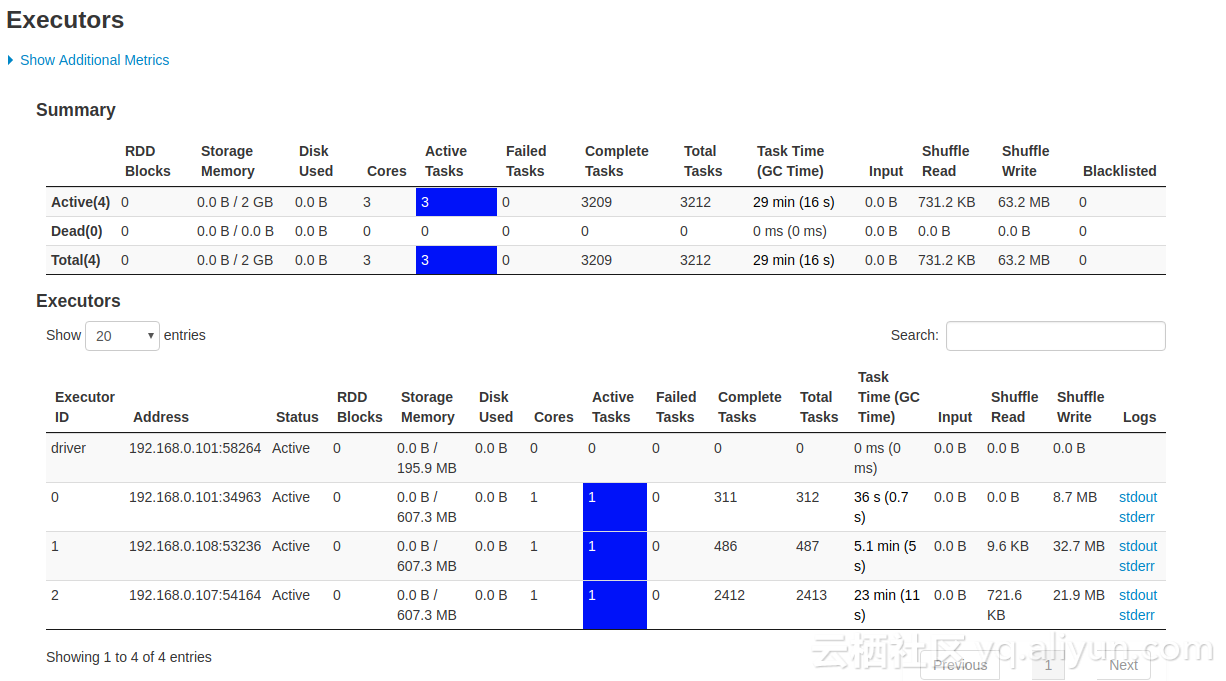

正常运转时各结点数据本地性都是process_local,当某个节点(下图executor 0)的task运行太慢,推测执行生效,该task被分发到其他节点执行完成

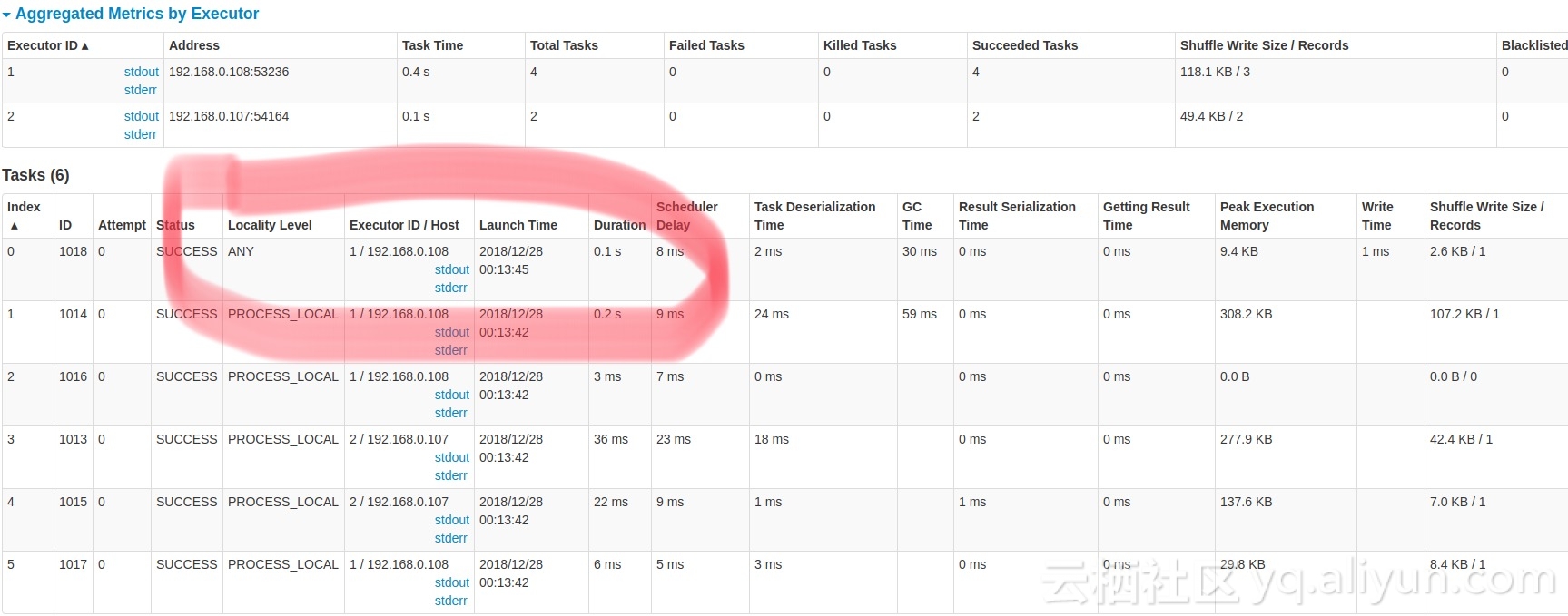

但发现后续所有sparkstreaming 的task就不会分发到executor 0上了,数据本地性也变成 any,导致task调度执行总要等多一点分配时间

spark没有开启黑名单机制,如何让executor 0可以重新执行task?恢复到 process_local的数据本地性?

为什么task不再分配到executor 0上了?

spark v2.2.0

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

解决方法, 升级kafka 到v0.10.2.x

参考https://issues.apache.org/jira/browse/SPARK-20780