勋章

我关注的人

粉丝

技术能力

- Python

- BI

- 数据建模

- SQL

- Linux

- flink

- hologress

- dataworks

- RDS

- quickbi

-

数据库

高级

能力说明:

掌握Java开发环境下所需的MySQL高级技巧,包括索引策略、innodb和myisam存储引擎,熟悉MySQL锁机制,能熟练配置MySQL主从复制,熟练掌握日常SQL诊断和性能分析工具和策略。可对云数据库进行备份恢复与监控、安全策略的设置,并可对云数据库进行性能优化。掌握主要NOSQL数据库的应用技术。

-

-

云原生容器Clouder认证:容器应用的高弹性架构

获得于2024-05-10 18:58:19

云原生容器Clouder认证:容器应用的高弹性架构

获得于2024-05-10 18:58:19 -

云原生容器Clouder认证:容器应用更新与灰度发布

获得于2024-05-08 10:05:21

云原生容器Clouder认证:容器应用更新与灰度发布

获得于2024-05-08 10:05:21 -

云原生Clouder认证:函数计算的功能与使用入门

获得于2024-04-29 15:34:41

云原生Clouder认证:函数计算的功能与使用入门

获得于2024-04-29 15:34:41 -

云原生数据库Clouder认证:PolarDB 快速入门

获得于2024-04-25 20:35:07

云原生数据库Clouder认证:PolarDB 快速入门

获得于2024-04-25 20:35:07 -

弹性计算Clouder认证:企业级ECS集群运维管理

获得于2024-01-02 16:57:25

弹性计算Clouder认证:企业级ECS集群运维管理

获得于2024-01-02 16:57:25

-

暂无个人介绍

-

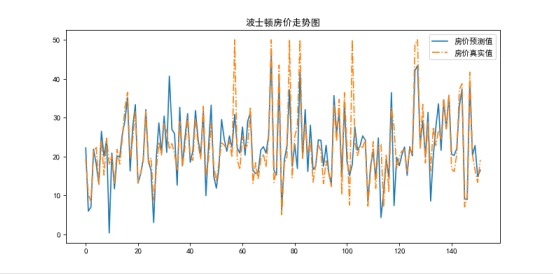

线性回归模型使用技巧3天前【5月更文挑战第14天】线性回归基础及进阶应用概述:探讨模型假设、最小二乘法和系数估计;通过多项式特征处理非线性关系;应用正则化(Lasso、Ridge)减少过拟合;特征选择优化模型复杂度;使用GridSearchCV进行超参数调优;处理分组数据、缺失值;集成方法(Bagging)提升性能;尝试岭回归、弹性网络、高斯过程回归和鲁棒回归;利用模型融合增强预测力;应对大规模数据挑战;分析特征重要性;自动特征工程;增强模型解释性;集成模型多样性及权重调整;应用序列最小优化(SMO)、预测区间估计;动态特征选择;模型校验与调优;稳定性分析;迁移学习。19来自: 开发与运维

线性回归模型使用技巧3天前【5月更文挑战第14天】线性回归基础及进阶应用概述:探讨模型假设、最小二乘法和系数估计;通过多项式特征处理非线性关系;应用正则化(Lasso、Ridge)减少过拟合;特征选择优化模型复杂度;使用GridSearchCV进行超参数调优;处理分组数据、缺失值;集成方法(Bagging)提升性能;尝试岭回归、弹性网络、高斯过程回归和鲁棒回归;利用模型融合增强预测力;应对大规模数据挑战;分析特征重要性;自动特征工程;增强模型解释性;集成模型多样性及权重调整;应用序列最小优化(SMO)、预测区间估计;动态特征选择;模型校验与调优;稳定性分析;迁移学习。19来自: 开发与运维 -

gateway基本配置10天前【5月更文挑战第7天】API Gateway在微服务架构中起着关键作用,作为客户端与后端服务的统一入口,负责路由转发、安全控制和负载均衡。本文深入介绍了API Gateway的基本配置、常见问题、跨平台配置差异及避免错误的方法。内容包括路由和过滤器配置、动态路由、安全性配置、限流和熔断机制,以及自定义过滤器和服务降级策略。通过示例代码和实践指南,帮助读者理解和部署API Gateway。29来自: 开发与运维

gateway基本配置10天前【5月更文挑战第7天】API Gateway在微服务架构中起着关键作用,作为客户端与后端服务的统一入口,负责路由转发、安全控制和负载均衡。本文深入介绍了API Gateway的基本配置、常见问题、跨平台配置差异及避免错误的方法。内容包括路由和过滤器配置、动态路由、安全性配置、限流和熔断机制,以及自定义过滤器和服务降级策略。通过示例代码和实践指南,帮助读者理解和部署API Gateway。29来自: 开发与运维 -

2024年的选择:为什么Go可能是理想的后端语言17天前【4月更文挑战第27天】Go语言在2024年成为后端开发的热门选择,其简洁设计、内置并发原语和强大工具链备受青睐。文章探讨了Go的设计哲学,如静态类型、垃圾回收和CSP并发模型,并介绍了使用Gin和Echo框架构建Web服务。Go的并发通过goroutines和channels实现,静态类型确保代码稳定性和安全性,快速编译速度利于迭代。Go广泛应用在云计算、微服务等领域,拥有丰富的生态系统和活跃社区,适合作为应对未来技术趋势的语言。31来自: 开发与运维

2024年的选择:为什么Go可能是理想的后端语言17天前【4月更文挑战第27天】Go语言在2024年成为后端开发的热门选择,其简洁设计、内置并发原语和强大工具链备受青睐。文章探讨了Go的设计哲学,如静态类型、垃圾回收和CSP并发模型,并介绍了使用Gin和Echo框架构建Web服务。Go的并发通过goroutines和channels实现,静态类型确保代码稳定性和安全性,快速编译速度利于迭代。Go广泛应用在云计算、微服务等领域,拥有丰富的生态系统和活跃社区,适合作为应对未来技术趋势的语言。31来自: 开发与运维 -

后端性能优化的实践与经验分享2天前【5月更文挑战第15天】在互联网环境中,后端性能优化对提供卓越用户体验至关重要。关键领域包括:数据库优化(查询优化、索引优化、表结构优化、数据库维护)、缓存策略(内存缓存、CDN内容分发、HTTP缓存)、服务器配置优化(硬件升级、网络优化、操作系统调整)和代码优化(算法与数据结构、懒加载与异步处理、减少冗余计算、多线程与并发)。通过这些方法,可以提升响应速度,增强用户满意度,促进业务增长。14来自: 开发与运维

2024年05月

-

05.17 09:55:31

发表了文章

2024-05-17 09:55:31

发表了文章

2024-05-17 09:55:31

R-Tree算法:空间索引的高效解决方案

【5月更文挑战第17天】R-Tree是用于多维空间索引的数据结构,常用于地理信息系统、数据库和计算机图形学。它通过分层矩形区域组织数据,支持快速查询。文章介绍了R-Tree的工作原理、应用场景,如地理信息存储和查询,以及Python的`rtree`库实现示例。此外,还讨论了R-Tree的优势(如空间效率和查询性能)与挑战(如实现复杂和内存消耗),以及优化和变种,如R* Tree和STR。R-Tree在机器学习、实时数据分析等领域有广泛应用,并与其他数据结构(如kd-trees和quad-trees)进行比较。未来趋势将聚焦于优化算法、动态适应性和分布式并行计算。 -

05.17 09:26:08

发表了文章

2024-05-17 09:26:08

发表了文章

2024-05-17 09:26:08

Java一分钟之-高级集合框架:LinkedList与TreeSet

【5月更文挑战第17天】这篇博客对比了Java集合框架中的LinkedList和TreeSet。LinkedList是双向链表,适合中间插入删除,但遍历效率低且占用空间大;TreeSet基于红黑树,保证元素有序且不重复,插入删除速度较LinkedList慢但查找快。选择时需根据操作需求和性能考虑。 -

05.17 09:24:04

发表了文章

2024-05-17 09:24:04

发表了文章

2024-05-17 09:24:04

Java一分钟之-设计模式:策略模式与模板方法

【5月更文挑战第17天】本文介绍了策略模式和模板方法模式,两种行为设计模式用于处理算法变化和代码复用。策略模式封装不同算法,允许客户独立于具体策略进行选择,但需注意选择复杂度和过度设计。模板方法模式定义算法骨架,延迟部分步骤给子类实现,但过度抽象或滥用继承可能导致问题。代码示例展示了两种模式的应用。根据场景选择合适模式,以保持代码清晰和可维护。 -

05.17 09:20:27

发表了文章

2024-05-17 09:20:27

发表了文章

2024-05-17 09:20:27

Java一分钟之-设计模式:装饰器模式与代理模式

【5月更文挑战第17天】本文探讨了装饰器模式和代理模式,两者都是在不改变原有对象基础上添加新功能。装饰器模式用于动态扩展对象功能,但过度使用可能导致类数量过多;代理模式用于控制对象访问,可能引入额外性能开销。文中通过 Java 代码示例展示了两种模式的实现。理解并恰当运用这些模式能提升代码的可扩展性和可维护性。 -

05.17 09:17:58

发表了文章

2024-05-17 09:17:58

发表了文章

2024-05-17 09:17:58

Java一分钟之-设计模式:观察者模式与事件驱动

【5月更文挑战第17天】本文探讨了Java中实现组件间通信的观察者模式和事件驱动编程。观察者模式提供订阅机制,当对象状态改变时通知所有依赖对象。然而,它可能引发性能问题、循环依赖和内存泄漏。代码示例展示了如何实现和避免这些问题。事件驱动编程则响应用户输入和系统事件,但回调地狱和同步/异步混淆可能造成困扰。JavaFX事件驱动示例解释了如何处理事件。理解这两种模式有助于编写健壮的程序。 -

05.17 09:13:19

发表了文章

2024-05-17 09:13:19

发表了文章

2024-05-17 09:13:19

Java一分钟之-设计模式:工厂模式与抽象工厂模式

【5月更文挑战第17天】本文探讨了软件工程中的两种创建型设计模式——工厂模式和抽象工厂模式。工厂模式提供了一个创建对象的接口,延迟实例化到子类决定。过度使用或违反单一职责原则可能导致问题。代码示例展示了如何创建形状的工厂。抽象工厂模式则用于创建一系列相关对象,而不指定具体类,但添加新产品可能需修改现有工厂。代码示例展示了创建颜色和形状的工厂。根据需求选择模式,注意灵活性和耦合度。理解并恰当运用这些模式能提升代码质量。 -

05.17 08:29:52

回答了问题

2024-05-17 08:29:52

回答了问题

2024-05-17 08:29:52

滑动日志算法有哪些劣势?

赞0 踩0 评论0 -

05.17 08:28:52

回答了问题

2024-05-17 08:28:52

回答了问题

2024-05-17 08:28:52

Sentinel单机模式下有哪些限流控制器?

赞0 踩0 评论0 -

05.17 08:27:50

回答了问题

2024-05-17 08:27:50

回答了问题

2024-05-17 08:27:50

RateLimiter支持哪些限流策略?

赞0 踩0 评论0 -

05.17 08:26:53

回答了问题

2024-05-17 08:26:53

回答了问题

2024-05-17 08:26:53

如何在Nginx的速率限流配置中考虑突发请求?

赞0 踩0 评论0 -

05.17 08:25:54

回答了问题

2024-05-17 08:25:54

回答了问题

2024-05-17 08:25:54

如何使用Nginx控制并发连接数?

赞0 踩0 评论0 -

05.17 08:24:52

回答了问题

2024-05-17 08:24:52

回答了问题

2024-05-17 08:24:52

Nginx如何作为前置网关进行限流?

赞0 踩0 评论0 -

05.16 10:26:28

发表了文章

2024-05-16 10:26:28

发表了文章

2024-05-16 10:26:28

Java 18新特性

【5月更文挑战第16天】Java 18于2022年3月发布,包含多项新特性和改进,如文件系统链接、文本块、表达式求值API、`ForkJoinPool`优化、`Optional`新方法等。亮点还包括预览特性:Record Pattern Matching for Switch和增强的开关表达式。此外,还有日期时间API扩展、Vector API的进一步孵化、默认UTF-8字符集的研究以及对Security Manager的弃用等。这些更新旨在提升开发效率、性能和安全性。 -

05.16 09:08:24

发表了文章

2024-05-16 09:08:24

发表了文章

2024-05-16 09:08:24

Java一分钟之-设计模式:单例模式的实现

【5月更文挑战第16天】本文介绍了单例模式的四种实现方式:饿汉式(静态初始化)、懒汉式(双检锁)、静态内部类和枚举单例,以及相关问题和解决方法。关注线程安全、反射攻击、序列化、生命周期和测试性,选择合适的实现方式以确保代码质量。了解单例模式的优缺点,谨慎使用,提升设计效率。 -

05.16 09:01:30

发表了文章

2024-05-16 09:01:30

发表了文章

2024-05-16 09:01:30

Java一分钟之-Java内存模型与垃圾回收机制概览

【5月更文挑战第16天】本文简述Java内存模型(JMM)和垃圾回收(GC)机制。JMM包括栈、堆、方法区、程序计数器和本地方法栈。GC负责回收不再使用的对象内存,常用算法有新生代、老年代和全堆GC。文章讨论了内存溢出、死锁和GC性能等问题,提出了解决方案,如调整JVM参数和优化GC策略。此外,还强调了避免内存泄漏、大对象管理及正确释放资源的重要性。理解这些概念有助于提升Java应用的性能和稳定性。 -

05.16 08:57:46

发表了文章

2024-05-16 08:57:46

发表了文章

2024-05-16 08:57:46

Java一分钟之-Log4j与日志记录的重要性

【5月更文挑战第16天】Log4j是Java常用的日志框架,用于灵活地记录程序状态和调试问题。通过设置日志级别和过滤器,可避免日志输出混乱。为防止日志文件过大,可配置滚动策略。关注日志安全性,如Log4j 2.x的CVE-2021-44228漏洞,及时更新至安全版本。合理使用日志能提升故障排查和系统监控效率。 -

05.16 08:53:38

发表了文章

2024-05-16 08:53:38

发表了文章

2024-05-16 08:53:38

Java一分钟之-单元测试:JUnit与TestNG

【5月更文挑战第16天】本文介绍了Java常用的单元测试框架JUnit和TestNG,JUnit以其简洁注解受到青睐,而TestNG则提供更高级功能如参数化测试。常见问题包括测试未执行、断言失败等,解决办法包括检查项目配置、调整测试顺序。注意保持测试简单独立,确保高覆盖率。选择合适的框架可提升代码质量。 -

05.16 08:41:19

发表了文章

2024-05-16 08:41:19

发表了文章

2024-05-16 08:41:19

Java一分钟之-Gradle:构建自动化工具

【5月更文挑战第16天】本文介绍了Gradle,一个基于Groovy的灵活构建工具,强调其优于Maven的灵活性和性能。文中通过示例展示了基本的`build.gradle`文件结构,并讨论了常见问题:版本冲突、缓存问题和构建速度慢,提供了相应的解决策略。此外,还提醒开发者注意插件ID、语法错误和源代码目录等易错点。掌握这些知识能提升开发效率,使构建过程更顺畅。 -

05.16 08:28:45

回答了问题

2024-05-16 08:28:45

回答了问题

2024-05-16 08:28:45

-

05.16 08:26:17

回答了问题

2024-05-16 08:26:17

回答了问题

2024-05-16 08:26:17

flink本地可以执行,在服务器上不能执行

赞1 踩0 评论0 -

05.16 08:23:43

回答了问题

2024-05-16 08:23:43

回答了问题

2024-05-16 08:23:43

PolarDB 主备没有同步该变量,怎么回事?

赞0 踩0 评论0 -

05.16 08:22:22

回答了问题

2024-05-16 08:22:22

回答了问题

2024-05-16 08:22:22

容器镜像服务ACR这里面为什么要根据cpu数量创建 对应个数的redis实例呢?

赞0 踩0 评论0 -

05.16 08:20:55

回答了问题

2024-05-16 08:20:55

回答了问题

2024-05-16 08:20:55

阿里云OpenAPI能不能通过接口的方式 创建服务容器,并且可以挂载自定义目录?

赞0 踩0 评论0 -

05.15 17:17:27

发表了文章

2024-05-15 17:17:27

发表了文章

2024-05-15 17:17:27

后端性能优化的实践与经验分享

【5月更文挑战第15天】在互联网环境中,后端性能优化对提供卓越用户体验至关重要。关键领域包括:数据库优化(查询优化、索引优化、表结构优化、数据库维护)、缓存策略(内存缓存、CDN内容分发、HTTP缓存)、服务器配置优化(硬件升级、网络优化、操作系统调整)和代码优化(算法与数据结构、懒加载与异步处理、减少冗余计算、多线程与并发)。通过这些方法,可以提升响应速度,增强用户满意度,促进业务增长。 -

05.15 16:10:26

发表了文章

2024-05-15 16:10:26

发表了文章

2024-05-15 16:10:26

Java一分钟之-Maven项目管理工具使用

【5月更文挑战第15天】Maven是Java开发的项目管理工具,用于自动化构建、依赖管理和项目信息管理。通过POM模型管理项目,依赖中央仓库。基本目录包括`src/main/java`、`src/main/resources`、`src/test/java`和`src/test/resources`。常用命令有`clean`、`compile`、`test`、`package`和`install`。面对依赖冲突、找不到依赖或编译错误,可以调整`pom.xml`或`settings.xml`。理解Maven的工作原理和解决常见问题能提升开发效率。 -

05.15 16:03:34

发表了文章

2024-05-15 16:03:34

发表了文章

2024-05-15 16:03:34

Java一分钟之-Hibernate:ORM框架实践

【5月更文挑战第15天】Hibernate是Java的ORM框架,简化数据库操作。本文列举并解决了一些常见问题: 1. 配置SessionFactory,检查数据库连接和JDBC驱动。 2. 实体类需标记主键,属性映射应匹配数据库列。 3. 使用事务管理Session,记得关闭。 4. CRUD操作时注意对象状态和查询结果转换。 5. 使用正确HQL语法,防止SQL注入。 6. 根据需求配置缓存。 7. 懒加载需在事务内处理,避免`LazyInitializationException`。理解和避免这些问题能提升开发效率。 -

05.15 10:53:37

发表了文章

2024-05-15 10:53:37

发表了文章

2024-05-15 10:53:37

Java一分钟之MyBatis:持久层框架基础

【5月更文挑战第15天】MyBatis是Java的轻量级持久层框架,它分离SQL和Java代码,提供灵活的数据库操作。常见问题包括:XML配置文件未加载、忘记关闭SqlSession、接口方法与XML映射不一致、占位符使用错误、未配置ResultMap和事务管理不当。解决这些问题的关键在于正确配置映射文件、管理SqlSession、避免SQL注入、定义ResultMap以及确保事务边界。遵循最佳实践可优化MyBatis使用体验。

-

05.15 10:28:17

发表了文章

2024-05-15 10:28:17

发表了文章

2024-05-15 10:28:17

Java一分钟之Spring MVC:构建Web应用

【5月更文挑战第15天】Spring MVC是Spring框架的Web应用模块,基于MVC模式实现业务、数据和UI解耦。常见问题包括:配置DispatcherServlet、Controller映射错误、视图解析未设置、Model数据传递遗漏、异常处理未配置、依赖注入缺失和忽视单元测试。解决这些问题可提升代码质量和应用性能。注意配置`web.xml`、`@RequestMapping`、`ViewResolver`、`Model`、`@ExceptionHandler`、`@Autowired`,并编写测试用例。 -

05.15 10:23:56

发表了文章

2024-05-15 10:23:56

发表了文章

2024-05-15 10:23:56

Spring框架入门:IoC与DI

【5月更文挑战第15天】本文介绍了Spring框架的核心特性——IoC(控制反转)和DI(依赖注入)。IoC通过将对象的创建和依赖关系管理交给容器,实现解耦。DI作为IoC的实现方式,允许外部注入依赖对象。文章讨论了过度依赖容器、配置复杂度等常见问题,并提出通过合理划分配置、使用注解简化管理等解决策略。同时,提醒开发者注意过度依赖注入和循环依赖,建议适度使用构造器注入和避免循环引用。通过代码示例展示了注解实现DI和配置类的使用。掌握IoC和DI能提升应用的灵活性和可维护性,实践中的反思和优化至关重要。 -

05.15 09:18:44

回答了问题

2024-05-15 09:18:44

回答了问题

2024-05-15 09:18:44

DataWorks一个同步报错,是为什么?

赞0 踩0 评论0 -

05.15 09:06:34

回答了问题

2024-05-15 09:06:34

回答了问题

2024-05-15 09:06:34

怎么 清空 单个分区的数据 ?

赞0 踩0 评论0 -

05.15 09:03:54

回答了问题

2024-05-15 09:03:54

回答了问题

2024-05-15 09:03:54

DataWorks想请问一下是否支持通过接口单独触发业务流程里面的某些节点运行?

赞0 踩0 评论0 -

05.15 09:02:01

回答了问题

2024-05-15 09:02:01

回答了问题

2024-05-15 09:02:01

如何实现dataworks脱敏配置的流程?

赞0 踩0 评论0 -

05.15 08:59:46

回答了问题

2024-05-15 08:59:46

回答了问题

2024-05-15 08:59:46

-

05.14 16:29:35

回答了问题

2024-05-14 16:29:35

回答了问题

2024-05-14 16:29:35

为什么程序员害怕改需求?

赞6 踩0 评论0 -

05.14 16:27:15

回答了问题

2024-05-14 16:27:15

回答了问题

2024-05-14 16:27:15

“AI黏土人”一夜爆火,图像生成类应用应该如何长期留住用户?

赞31 踩0 评论0 -

05.14 15:45:54

发表了文章

2024-05-14 15:45:54

发表了文章

2024-05-14 15:45:54

线性回归模型使用技巧

【5月更文挑战第14天】线性回归基础及进阶应用概述:探讨模型假设、最小二乘法和系数估计;通过多项式特征处理非线性关系;应用正则化(Lasso、Ridge)减少过拟合;特征选择优化模型复杂度;使用GridSearchCV进行超参数调优;处理分组数据、缺失值;集成方法(Bagging)提升性能;尝试岭回归、弹性网络、高斯过程回归和鲁棒回归;利用模型融合增强预测力;应对大规模数据挑战;分析特征重要性;自动特征工程;增强模型解释性;集成模型多样性及权重调整;应用序列最小优化(SMO)、预测区间估计;动态特征选择;模型校验与调优;稳定性分析;迁移学习。 -

05.14 15:01:00

发表了文章

2024-05-14 15:01:00

发表了文章

2024-05-14 15:01:00

Java一分钟之-JPA:Java持久化API简介

【5月更文挑战第14天】Java Persistence API (JPA) 是Java的ORM规范,用于简化数据库操作。常见问题包括实体映射、事务管理和性能问题。避免错误的关键在于明确主键策略、妥善使用事务、优化查询及理解实体生命周期。示例展示了如何定义实体和使用`EntityManager`保存数据。JPA通过标准化API让开发者更专注于业务逻辑,提升开发效率和代码维护性。 -

05.14 14:57:34

发表了文章

2024-05-14 14:57:34

发表了文章

2024-05-14 14:57:34

Java一分钟之-JDBC:Java数据库连接基础

【5月更文挑战第14天】JDBC是Java与关系数据库交互的API,常见问题包括资源管理、SQL注入和性能优化。易错点涉及驱动加载、空指针异常和事务管理。避免这些问题的方法有使用try-with-resources自动关闭资源、预编译PreparedStatement以防止SQL注入,以及正确管理事务。示例代码展示了基本的JDBC连接和查询。在实际开发中,推荐使用ORM框架如Hibernate或JPA来简化数据库操作。 -

05.14 14:53:51

发表了文章

2024-05-14 14:53:51

发表了文章

2024-05-14 14:53:51

Java一分钟之-Java序列化与反序列化

【5月更文挑战第14天】Java序列化用于将对象转换为字节流,便于存储和网络传输。实现`Serializable`接口使类可被序列化,但可能引发隐私泄露、版本兼容性和性能问题。要避免这些问题,可使用`transient`关键字、控制`serialVersionUID`及考虑使用安全的序列化库。示例代码展示了如何序列化和反序列化对象,强调了循环引用和未实现`Serializable`的错误。理解并妥善处理这些要点对优化代码至关重要。 -

05.14 14:51:56

发表了文章

2024-05-14 14:51:56

发表了文章

2024-05-14 14:51:56

Java一分钟之-正则表达式在Java中的应用

【5月更文挑战第14天】正则表达式是Java中用于文本处理的强大力量,通过`java.util.regex`包支持。常见问题包括元字符的理解、边界匹配和贪婪/懒惰量词的使用。错误通常涉及未转义特殊字符、不完整模式或过度匹配。要避免这些问题,需学习实践、使用在线工具和测试调试。示例代码展示了如何验证邮箱地址。掌握正则表达式需要不断练习和调试。 -

05.14 14:47:05

发表了文章

2024-05-14 14:47:05

发表了文章

2024-05-14 14:47:05

Java一分钟之-NIO:非阻塞IO操作

【5月更文挑战第14天】Java的NIO(New IO)解决了传统BIO在高并发下的低效问题,通过非阻塞方式提高性能。NIO涉及复杂的选择器和缓冲区管理,易出现线程、内存和中断处理的误区。要避免这些问题,可以使用如Netty的NIO库,谨慎设计并发策略,并建立标准异常处理。示例展示了简单NIO服务器,接收连接并发送欢迎消息。理解NIO工作原理和最佳实践,有助于构建高效网络应用。 -

05.14 08:31:08

回答了问题

2024-05-14 08:31:08

回答了问题

2024-05-14 08:31:08

Flink 写入Doris数据异常

赞0 踩0 评论0 -

05.14 08:28:39

回答了问题

2024-05-14 08:28:39

回答了问题

2024-05-14 08:28:39

-

05.14 08:27:35

回答了问题

2024-05-14 08:27:35

回答了问题

2024-05-14 08:27:35

在视觉智能平台中24计时计时是从最后一次比对完成时间开始吗?

赞1 踩0 评论0 -

05.14 08:26:03

回答了问题

2024-05-14 08:26:03

回答了问题

2024-05-14 08:26:03

如何解决多页面环境下webpack打包慢的问题。

赞1 踩0 评论0 -

05.14 08:24:12

回答了问题

2024-05-14 08:24:12

回答了问题

2024-05-14 08:24:12

线性回归分析其中“β、 T 、F”分别是什么含义?

赞2 踩0 评论0 -

05.13 22:05:15

发表了文章

2024-05-13 22:05:15

发表了文章

2024-05-13 22:05:15

FPGA学习笔记

【5月更文挑战第13天】本文介绍了FPGA的基础知识,包括其构成(CLBs、IOBs、Interconnects和存储器块)和HDL编程(Verilog或VHDL)。文章强调了同步电路设计、时序约束和资源优化的重要性,并提供了代码示例展示如何实现LED闪烁和状态机设计。此外,还讨论了高级设计优化、软硬核CPU、高速接口设计以及功耗管理和验证技术。推荐使用Xilinx Vivado和Intel Quartus等工具,并鼓励读者通过动手实践来提升FPGA技能。 -

05.13 21:42:15

发表了文章

2024-05-13 21:42:15

发表了文章

2024-05-13 21:42:15

Java一分钟之-Java网络编程基础:Socket通信

【5月更文挑战第13天】本文介绍了Java Socket编程基础知识,包括使用`ServerSocket`和`Socket`类建立连接,通过`OutputStream`和`InputStream`进行数据传输。常见问题涉及忘记关闭Socket导致的资源泄漏、网络异常处理及并发同步。理解Socket通信原理并掌握异常处理、资源管理和并发控制,能帮助开发者构建更稳定的网络应用。 -

05.13 21:37:01

发表了文章

2024-05-13 21:37:01

发表了文章

2024-05-13 21:37:01

Java一分钟之-文件与目录操作:Path与Files类

【5月更文挑战第13天】Java 7 引入`java.nio.file`包,`Path`和`Files`类提供文件和目录操作。`Path`表示路径,不可变。`Files`包含静态方法,支持创建、删除、读写文件和目录。常见问题包括:忽略异常处理、路径解析错误和权限问题。在使用时,注意异常处理、正确格式化路径和考虑权限,以保证代码稳定和安全。结合具体需求,这些方法将使文件操作更高效。

-

发表了文章

2024-05-17

发表了文章

2024-05-17

R-Tree算法:空间索引的高效解决方案

-

发表了文章

2024-05-17

发表了文章

2024-05-17

Java一分钟之-高级集合框架:LinkedList与TreeSet

-

发表了文章

2024-05-17

发表了文章

2024-05-17

Java一分钟之-设计模式:策略模式与模板方法

-

发表了文章

2024-05-17

发表了文章

2024-05-17

Java一分钟之-设计模式:观察者模式与事件驱动

-

发表了文章

2024-05-17

发表了文章

2024-05-17

Java一分钟之-设计模式:装饰器模式与代理模式

-

发表了文章

2024-05-17

发表了文章

2024-05-17

Java一分钟之-设计模式:工厂模式与抽象工厂模式

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java一分钟之-单元测试:JUnit与TestNG

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java一分钟之-Log4j与日志记录的重要性

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java一分钟之-Gradle:构建自动化工具

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java 18新特性

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java一分钟之-设计模式:单例模式的实现

-

发表了文章

2024-05-16

发表了文章

2024-05-16

Java一分钟之-Java内存模型与垃圾回收机制概览

-

发表了文章

2024-05-15

发表了文章

2024-05-15

后端性能优化的实践与经验分享

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-Maven项目管理工具使用

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-Hibernate:ORM框架实践

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-JPA:Java持久化API简介

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之Spring MVC:构建Web应用

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-Optional类:优雅处理null值

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-NIO:非阻塞IO操作

-

发表了文章

2024-05-15

发表了文章

2024-05-15

Java一分钟之-Lambda表达式与函数式接口

-

回答了问题

2024-05-17

回答了问题

2024-05-17

滑动日志算法有哪些劣势?

您提到的“滑动日志算法”可能是指与日志管理相关的滑动窗口概念,特别是在分布式系统中用于日志记录和流处理的场景。在这种情况下,滑动窗口机制常用于处理时间序列数据,如监控系统日志或流式计算。滑动窗口的一个主要目标是限制存储或处理的数据量,以便有效地管理和分析。然而,这种机制也有一些潜在的劣势:

窗口大小的确定:

- 窗口大小的选择是一个挑战,过大的窗口可能导致存储和计算资源的浪费,而过小的窗口可能错过重要的长期趋势或事件。

时间同步问题:

- 在分布式系统中,各个节点的时间同步至关重要,如果时间不一致,可能会导致窗口计算错误。

数据丢失风险:

- 如果窗口移动得太快,可能会导致一些尚未处理的数据丢失,尤其是在高并发和低延迟要求的场景下。

复杂性增加:

- 实现和管理滑动窗口机制可能需要复杂的逻辑,尤其是在需要处理跨窗口事件关联或状态追踪时。

延迟问题:

- 虽然滑动窗口可以快速处理数据,但如果窗口移动太快,可能会导致实时性较低,因为需要等待整个窗口期结束才能得出结果。

回溯困难:

- 如果需要回溯或重新处理旧数据,滑动窗口机制可能不支持,因为数据可能会被定期清除。

资源管理:

- 窗口需要存储和管理历史数据,这可能会消耗大量内存或磁盘空间,尤其是在长时间窗口或高数据速率的情况下。

依赖于时间戳:

- 滑动窗口算法通常依赖于准确的时间戳,如果时间戳不准确或存在漂移,可能导致限流或数据分析错误。

实时性和一致性:

- 在处理实时数据时,滑动窗口可能难以保证全局的一致性,特别是在分布式环境中,数据可能在多个节点间异步处理。

正确地设计和配置滑动窗口算法对于克服这些劣势至关重要。需要根据具体的应用场景和需求来权衡窗口大小、窗口移动速度、数据保留策略等因素,以实现最佳的性能和效率。

赞0 踩0 评论0 -

回答了问题

2024-05-17

回答了问题

2024-05-17

Sentinel单机模式下有哪些限流控制器?

在Sentinel中,限流控制器主要是指用于实现不同限流策略的组件。在单机模式下,Sentinel 提供了多种限流策略来控制服务的流量。以下是几种主要的限流策略:

直接限流(Direct Control) :

- 直接限流是最基础的限流策略,它基于资源的QPS(每秒请求数)或线程数来决定是否限流。例如,可以设置一个资源每秒只允许10个请求通过。

滑动窗口限流(Slide Window Control) :

- 滑动窗口限流是基于时间窗口的限流策略,可以分为固定窗口和滚动窗口两种。它在一段时间内统计请求数量,一旦超过设定的阈值,就会开始限流。

令牌桶限流(Token Bucket Control) :

- 令牌桶算法是Sentinel中的一个重要限流策略,它维护一个令牌池,每秒按照预设速率填充令牌,请求需要消耗令牌,当令牌不足时则限流。

滑动窗口平均限流(Slide Window Average Control) :

- 此策略基于滑动窗口,但计算的是平均QPS,例如,可以在1分钟内平均不超过特定的QPS。

热点限流(Hotspot Control) :

- 热点限流主要用于限制热点资源的访问,例如,防止大量请求集中在某一特定资源上。

自适应限流(Adaptive Control) :

- 自适应限流是一种动态调整限流阈值的策略,它基于系统的实时状态(如CPU使用率、系统负载等)来调整限流策略。

资源关联限流(Resource Association Control) :

- 可以将多个资源关联起来,当其中一个资源达到限流条件时,其他关联的资源也会一起限流,实现流量的联动控制。

在Sentinel中,这些限流策略可以通过配置

FlowRule来实现,并通过FlowController来执行。在单机模式下,Sentinel会直接在本地执行这些限流决策,无需集群协调。在集群模式下,Sentinel提供了集群限流的能力,通过passClusterCheck来判断是否通过集群的限流规则,然后可能再执行本地限流规则passLocalCheck。赞0 踩0 评论0 -

回答了问题

2024-05-17

回答了问题

2024-05-17

RateLimiter支持哪些限流策略?

RateLimiter通常用来实现基于令牌桶算法的限流策略,这种策略允许在给定时间内有一定的请求速率,并且可以处理突发请求。除此之外,RateLimiter还可以根据具体实现支持其他限流策略。以下是一些常见的限流策略:

固定速率限流(Fixed Rate Limiting) :

- 这是最基础的限流策略,它限制了单位时间内的请求数量。例如,每秒不超过N个请求。

滑动窗口限流(Sliding Window Limiting) :

- 这种策略使用一个可滑动的时间窗口,窗口内的请求数量被限制在一定的范围内。它可以是简单的固定窗口(如过去1分钟内的请求)或滚动窗口(如过去60个1秒窗口的请求总数)。

漏桶限流(Leaky Bucket Limiting) :

- 类似于令牌桶,但不同的是,它有一个固定的容量,超出容量的请求会被丢弃。请求以恒定的速度流出,而不是积累令牌。

令牌桶限流(Token Bucket Limiting) :

- 这是RateLimiter最常用的策略,它有一个有限的令牌池,每次请求需要消费一个令牌,如果没有令牌则请求被限制。令牌按固定速率补充,可以处理突发请求,因为桶可以暂时存储超出平均速率的令牌。

动态限流(Dynamic Limiting) :

- 根据系统负载或其他指标动态调整限流速率,例如,在系统资源紧张时降低限流阈值,资源充足时提高阈值。

自适应限流(Adaptive Limiting) :

- 根据系统性能、历史请求模式或外部条件自动调整限流策略。

在Java的Guava库中,

RateLimiter类提供了对令牌桶算法的实现,可以创建一个RateLimiter实例来配置固定的令牌生成速率,并使用acquire()或tryAcquire()方法来控制请求。其他编程语言或框架可能有类似的实现,支持这些或更多限流策略。在微服务和分布式系统中,限流策略可能会变得更加复杂,例如,使用Spring Boot的RateLimiter注解可以针对不同的服务或功能实现不同的限流策略,这通常涉及到更高级的配置和策略选择。

赞0 踩0 评论0 -

回答了问题

2024-05-17

回答了问题

2024-05-17

如何在Nginx的速率限流配置中考虑突发请求?

在Nginx的速率限流配置中,考虑突发请求通常意味着允许在短时间内超过预设的平均速率,但不超过一定的阈值。Nginx的

limit_req_module提供了burst参数来处理这种情况。burst参数允许在一段时间内有突发的请求量,超过平均速率但不超过burst指定的请求数。以下是一个配置示例,展示了如何在限制请求速率的同时处理突发请求:

http { limit_req_zone $binary_remote_addr zone=myratezone:10m rate=1r/s burst=5; # 设置限流区域 server { listen 80; server_name example.com; location / { limit_req zone=myratezone burst=5; # 应用限流规则,允许5个突发请求 # 其他配置... } } }在这个配置中:

myratezone是我们定义的限流区域名称,它是一个10MB大小的内存区域,用于存储限流信息。rate=1r/s表示每个IP地址每秒允许一个请求。burst=5表示如果请求速率超过了1r/s,Nginx会允许最多5个额外的请求在短时间内完成。这些请求会立即执行,而不是按限流速率逐步处理。

这样,当短时间内有突发的请求到达时,Nginx会先处理这5个请求,然后才开始按照1r/s的速率限制后续的请求。如果没有设置

burst,所有超过限流速率的请求都会被立即拒绝。请注意,配置

burst参数时,需要权衡允许的突发请求数量和可能对后端服务造成的影响。过多的突发请求可能会对后端造成压力,而太少则可能过于严格,影响用户体验。因此,需要根据实际流量和后端系统的承受能力来调整这个值。赞0 踩0 评论0 -

回答了问题

2024-05-17

回答了问题

2024-05-17

如何使用Nginx控制并发连接数?

在Nginx中控制并发连接数主要是通过

limit_conn_module模块来实现的。这个模块允许你限制每个IP地址或者基于其他变量的最大并发连接数。以下是配置Nginx来控制并发连接数的步骤:- 创建共享内存区域: 首先,你需要定义一个共享内存区域来存储连接计数信息。在

http上下文中添加以下配置:

http { limit_conn_zone $binary_remote_addr zone=conn_limit_per_ip:10m; # 创建一个名为conn_limit_per_ip的共享内存区域,大小为10MB }$binary_remote_addr是一个内置变量,代表客户端的二进制IP地址。你可以根据需要选择其他变量或自定义变量。- 在服务器或location块中应用限制: 在需要限制并发连接数的

server或location块中,使用limit_conn指令来设置最大并发连接数:

server { listen 80; server_name example.com; location / { limit_conn conn_limit_per_ip 10; # 每个IP地址最多10个并发连接 # 其他配置... } }这里的

conn_limit_per_ip是之前定义的共享内存区域的名称,10是允许的最大并发连接数。- 配置调整: 根据你的服务器资源和应用需求,你可能需要调整

limit_conn_zone的大小以及limit_conn的限制值。更大的共享内存区域可以存储更多的连接计数信息,而限制值则决定了允许的最大并发连接数。 - 重启Nginx: 修改完配置后,记得要重启Nginx服务以使更改生效:

sudo nginx -s reload通过这种方式,Nginx将限制每个客户端IP地址同时打开的连接数,有助于防止某些恶意用户或DDoS攻击者占用过多的服务器资源。请注意,过高的并发连接限制可能会对合法用户造成不便,因此需要根据实际情况进行调整。同时,配合使用

limit_req_module进行请求速率限制,可以提供更全面的保护。赞0 踩0 评论0 - 创建共享内存区域: 首先,你需要定义一个共享内存区域来存储连接计数信息。在

-

回答了问题

2024-05-17

回答了问题

2024-05-17

Nginx如何作为前置网关进行限流?

Nginx 作为一款流行的反向代理服务器,可以很好地用作前端网关来实现限流,保护后端服务免受过大流量冲击。Nginx 提供了内置的限流模块,如

limit_req_module和limit_conn_module,来限制客户端的请求速率和并发连接数。下面是使用这两个模块进行限流的基本配置示例:基于请求速率限流(limit_req_module) :

- 使用

limit_req_zone定义一个限流区域,指定限流规则。 - 在需要限流的 server 或 location 配置块中,使用

limit_req指令应用限流规则。

示例配置:

- 使用

http { limit_req_zone $binary_remote_addr zone=myzone:10m rate=1r/s; # 每秒限制一个请求,保留10分钟的统计信息 server { listen 80; server_name example.com; location /api { limit_req zone=myzone burst=5; # 允许短暂的突发请求,最多5个请求 proxy_pass http://backend_server; } } }这里,

$binary_remote_addr是一个变量,表示客户端IP地址的二进制形式。rate参数定义了允许的平均请求速率,burst参数允许在限制速率之上有短暂的请求峰值。基于并发连接限流(limit_conn_module) :

- 使用

limit_conn_zone定义一个连接限制区域。 - 在需要限制连接的 server 或 location 配置块中,使用

limit_conn指令应用限制。

示例配置:

- 使用

http { limit_conn_zone $binary_remote_addr zone=one:10m; # 保留10分钟的统计信息 server { listen 80; server_name example.com; location / { limit_conn one 10; # 每个IP地址最多10个并发连接 proxy_pass http://backend_server; } } }在这个例子中,

limit_conn指令限制了每个客户端IP的最大并发连接数。请注意,Nginx 的限流配置需要根据实际的流量和后端服务的承受能力进行调整。过度限流可能导致合法请求被拒绝,而不足的限流可能无法有效防止DDoS攻击。因此,需要定期监控和调整限流策略以达到最佳平衡。

赞0 踩0 评论0 -

回答了问题

2024-05-16

回答了问题

2024-05-16

Flink CDC增加时间窗口后,有办法让source源,在完成上一次的sink之后,再继续读取吗?

Flink CDC本身是基于Apache Flink构建的,因此它天然支持流处理的时间窗口特性。当你在Flink CDC的数据流处理中引入时间窗口时,Flink会自动处理窗口内的数据聚合或其他窗口操作,并确保窗口的完整性,即在窗口结束时才会触发计算并输出结果。

如果你希望source在完成上一个sink操作之后再继续读取新的数据,这实际上是对处理流程顺序性的要求。在流处理领域,尤其是基于事件时间(event time)或处理时间(processing time)窗口的应用中,直接“等待sink完成后再读取”不是典型的处理模式,因为Flink设计为持续不断地从source读取数据并推进处理管道。

但是,可以通过一些间接的方式来实现类似的效果:

- 使用两阶段处理:首先,使用一个流处理作业仅做数据的摄取与初步处理(如通过Flink CDC读取数据并转换),然后将结果输出到一个中间topic或表。其次,设置另一个流处理作业,从这个中间存储消费数据,并在这个阶段应用时间窗口逻辑进行聚合或其他处理,最后sink到目标系统。这样,第二阶段的处理可以在第一阶段数据完全到达后再开始。

- 基于事件时间的窗口:如果关心的是数据的事件时间顺序,可以利用Flink的事件时间语义和 watermark机制,确保窗口是在所有属于该窗口的事件都到达之后才被触发计算。但这依然不是等待sink完成,而是基于数据的时间属性来保证处理的顺序性。

- Side Outputs:如果sink操作特别耗时或需要确保上游处理完毕,可以考虑使用Flink的Side Outputs功能,在数据流中分出一个旁路输出,先sink到一个快速响应的存储(如Kafka的一个临时topic),待这部分数据处理完成后再通过另一个流处理任务sink到最终目的地。这样,主数据流可以继续不受阻碍地处理新数据。

- 异步Sink:Flink 1.12及以上版本支持异步Sink,可以减少sink操作对整体处理流程的影响,使得source可以继续读取数据,而sink的操作在后台异步进行。虽然这不直接实现“sink完成后继续读取”的逻辑,但它可以提高整体的吞吐量和响应速度。

赞0 踩0 评论0 -

回答了问题

2024-05-16

回答了问题

2024-05-16

flink本地可以执行,在服务器上不能执行

遇到在本地IDEA中运行Flink任务正常,但在服务器上运行时报错的情况,通常与以下几个因素相关:

- 环境差异:确保服务器上的Java环境与本地一致,包括Java版本和环境变量设置。Flink对Java版本有特定要求,不同版本的Flink可能需要特定版本的Java运行时环境。

- 依赖冲突:从错误信息来看,

ClassNotFoundException: org.apache.flink.api.common.ExecutionConfig表明可能存在类路径问题或依赖冲突。检查服务器上的应用程序包是否完整,确保所有依赖都已正确打包进去,没有遗漏。同时,确认没有其他版本的Flink库或与其冲突的库存在于服务器的类路径中。有时候,服务器上可能有全局的Maven仓库或旧版库,这些可能会干扰你的应用。 - Flink配置:检查服务器上的Flink配置文件(如

flink-conf.yaml),确保配置正确且与本地开发环境相匹配,特别是关于网络、内存、并行度等方面的设置。 - 打包方式:确认你的项目在打包时是否正确地包含了所有必要的依赖。使用Maven或Gradle打包时,确保使用了正确的命令,如Maven的

mvn clean package -DskipTests,并且检查是否使用了正确的打包类型(如jar或war)。 - Classpath问题:如果项目中有自定义类或依赖,确保它们在服务器上运行时也能正确加载。可能需要检查启动脚本或命令,确认CLASSPATH环境变量是否正确设置了。

- 权限问题:虽然错误信息未直接指出,但有时服务器上的权限问题也会导致任务无法正常启动,确保Flink运行用户有足够的权限访问相关目录和资源。

解决思路:

- 验证依赖:首先,通过查看项目的依赖树(使用Maven的

mvn dependency:tree或Gradle的gradle dependencies命令)确认所有依赖正确无冲突。 - 检查打包内容:解压服务器上的应用包,确认所有依赖库都已包含其中。

- 日志分析:查看Flink在服务器上的详细日志,可能会有更多的错误信息提示问题所在。

- 环境一致性:确保服务器上的Java版本、Flink配置等与本地开发环境保持一致。

- 启动脚本:如果使用自定义脚本启动应用,检查脚本中是否正确指定了Java路径、Flink配置路径以及是否正确设置了CLASSPATH。

如果以上步骤都无法解决问题,考虑将服务器上的Flink运行环境完全复刻到本地进行调试,或者进一步提供详细的错误日志进行分析。

赞1 踩0 评论0 -

回答了问题

2024-05-16

回答了问题

2024-05-16

PolarDB 主备没有同步该变量,怎么回事?

PolarDB 是阿里云推出的一种云原生数据库服务,它在架构上与传统的MySQL数据库有差异,特别是关于主备切换和只读属性的管理方面。根据您的描述,如果在使用ProxySQL对PolarDB进行主备监测时,发现通过

SELECT @@read_only查询不到预期的结果,这可能是由于以下原因:- PolarDB特有机制:PolarDB采用的是与传统MySQL略有不同的高可用架构,它内部可能使用了不同于标准MySQL的主备同步和读写分离机制。PolarDB可能并不直接依赖于MySQL的

@@read_only系统变量来标识主备状态或控制只读属性。PolarDB可能有自己的一套服务发现和状态同步机制,用于自动管理主备状态和流量路由。 - ProxySQL配置不匹配:如果ProxySQL配置中依赖于检查

@@read_only变量来区分主库和备库,而在PolarDB中这个变量没有按预期工作,那么可能是ProxySQL的配置与PolarDB的实际行为不匹配。PolarDB可能使用其他系统变量或者自定义的方法来标记节点的角色。 - PolarDB管理接口:PolarDB可能提供了API或者其他方式供外部系统查询其主备状态,而不是直接暴露MySQL的标准系统变量。在这种情况下,需要调整ProxySQL的监测逻辑,使用PolarDB提供的接口来准确识别主备角色。

- 版本兼容性问题:虽然可能性较小,但也不排除是因为PolarDB或ProxySQL的特定版本之间存在兼容性问题,导致某些特性未能正确生效。

解决这个问题的途径可能包括:

- 查阅PolarDB官方文档:确认PolarDB如何表示和管理主备状态,是否有推荐的监测方法或API。

- 调整ProxySQL配置:根据PolarDB的实际情况,修改ProxySQL的监测规则,比如使用PolarDB提供的API或状态检查命令来替代

@@read_only。 - 咨询技术支持:联系阿里云的技术支持,获取关于PolarDB与ProxySQL集成的最佳实践和可能的配置示例。

赞0 踩0 评论0 - PolarDB特有机制:PolarDB采用的是与传统MySQL略有不同的高可用架构,它内部可能使用了不同于标准MySQL的主备同步和读写分离机制。PolarDB可能并不直接依赖于MySQL的

-

回答了问题

2024-05-16

回答了问题

2024-05-16

容器镜像服务ACR这里面为什么要根据cpu数量创建 对应个数的redis实例呢?

在容器镜像服务(如阿里云的ACR)中,根据CPU数量创建对应个数的Redis实例,主要是出于性能优化和资源充分利用的考虑。这种做法基于以下几个原因:

- 资源分配与隔离:Redis作为一个内存数据库,其性能与CPU、内存资源紧密相关。在多核CPU环境下,为每个Redis实例分配独立的CPU核心,可以减少CPU上下文切换的开销,提高处理效率。每个Redis实例独享一定数量的CPU核心,有利于避免资源争抢,尤其是在高并发场景下。

- 横向扩展:根据CPU数量创建实例,是一种简单的水平扩展策略。随着CPU核心数的增加,通过创建更多Redis实例,可以线性地提升系统的处理能力,满足更高的并发访问需求。这种方式也便于后续的扩展和管理。

- 优化与调优:你提到的

redis_keentune.sh脚本可能是指一种针对Redis实例的性能调优脚本。根据CPU数量定制Redis实例数量,可能是为了配合特定的调优策略,比如利用KeenTune等工具进行自动调优,确保每个实例能够根据其所在CPU环境进行最佳配置。 - 高可用与负载均衡:在某些部署架构中,创建多个Redis实例还可能与高可用性和负载均衡策略有关。例如,通过创建主从复制或集群模式,每个实例负责一部分数据,不仅可以提高数据安全性,还能通过负载均衡技术分散请求,进一步提升系统性能。

赞0 踩0 评论0 -

回答了问题

2024-05-16

回答了问题

2024-05-16

阿里云OpenAPI能不能通过接口的方式 创建服务容器,并且可以挂载自定义目录?

阿里云提供了多种服务容器化的产品,如ECS(Elastic Compute Service)可以搭配Docker容器技术,或者使用ACK(Apsara Container Service for Kubernetes)来管理容器服务。创建服务容器并挂载自定义目录通常需要通过API或者CLI工具来完成,具体步骤如下:

对于ECS,你可以通过阿里云开放API或SDK来创建带有Docker容器的实例,并挂载自定义目录。这通常涉及到以下步骤:

- 创建ECS实例: 使用ECS的API,你可以创建一个新的ECS实例,指定镜像、实例规格、网络配置等。参考官方文档。

- 安装Docker: 在ECS实例上安装Docker,确保Docker服务启动并运行。

- 创建Docker容器: 使用Docker API或

docker run命令创建容器,挂载ECS实例上的目录。例如,你可能会这样运行一个容器,挂载本地目录/data到容器内的/app目录:

docker run -v /data:/app -d your_image:tag这里的

-v /data:/app参数就是挂载卷的命令。如果你使用的是ACK(Kubernetes),流程会有所不同:

- 创建Kubernetes集群: 通过ACK API创建一个Kubernetes集群,参考官方文档。

- 编写YAML文件: 编写一个Kubernetes的Deployment或StatefulSet YAML文件,定义Pod的容器、镜像、挂载卷等信息。

apiVersion: apps/v1 kind: Deployment metadata: name: my-app spec: replicas: 1 selector: matchLabels: app: my-app template: metadata: labels: app: my-app spec: containers: - name: my-container image: your_image:tag volumeMounts: - mountPath: /app name: custom-volume volumes: - name: custom-volume hostPath: path: /data- 应用YAML文件: 使用

kubectl apply命令应用YAML文件来创建Pod。

kubectl apply -f your_deployment.yaml- 检查Pod状态: 使用

kubectl get pods确认Pod是否成功创建并运行。

请确保你具有相应的权限,并遵循阿里云的安全最佳实践。在实际操作前,建议先在测试环境中尝试。如果有特定的API调用或SDK使用问题,可以提供更详细的信息,以便给出更具体的指导。

赞0 踩0 评论0 -

回答了问题

2024-05-15

回答了问题

2024-05-15

DataWorks一个同步报错,是为什么?

这个错误信息表明在DataWorks中提交数据同步任务时遇到了问题。错误信息包含了几个关键点:

- State: 4(FAIL) :任务状态为失败(状态4通常代表失败)。

- ErrorMessage: Submit job failed:提交作业失败。

- Submit instance ... to alisa failed:提交实例到某个服务(可能是内部服务"alisa")时失败。

- execute task failed, uniquekey conflict:执行任务时遇到唯一键冲突。

这可能是因为以下原因:

- 并发问题:同一时间有多个相同任务或作业在尝试执行,导致唯一键冲突。在DataWorks中,每个任务实例都有一个唯一的标识符,如果两个任务实例试图同时使用相同的标识符,就会发生冲突。

- 系统问题:可能是由于DataWorks内部服务的暂时性问题,如服务器故障或资源争抢。

- 配置错误:任务的配置可能有误,比如源表或目标表的配置不正确,导致冲突。

- 数据一致性问题:在数据同步过程中,可能存在数据一致性约束,如主键冲突,导致任务失败。

解决方法:

- 检查任务配置:确认任务配置是否正确,特别是源表和目标表的设置,确保没有重复的任务实例或错误的唯一键设置。

- 重启任务:尝试重新启动失败的任务,看是否能成功执行。

- 检查依赖:确认任务的依赖关系是否正确,避免并发执行可能导致冲突的其他任务。

- 联系阿里云支持:如果问题持续存在,联系阿里云客服或技术支持,他们可以查看更详细的系统日志,帮助诊断和解决问题。

- 查看LogView:虽然在这个情况下LogView没有生成,但通常LogView会有更详细的错误信息,所以一旦LogView可用,务必查看以获取更多线索。

请尝试这些步骤,并根据反馈进一步解决问题。如果需要更深入的分析,可能需要查看具体的任务配置和系统日志。

赞0 踩0 评论0 -

回答了问题

2024-05-15

回答了问题

2024-05-15

怎么 清空 单个分区的数据 ?

在阿里云DataWorks中,清空单个分区的数据通常涉及到对分区表的操作。以下是执行这个操作的一般步骤:

登录DataWorks:

- 使用您的阿里云账号登录DataWorks控制台。

进入数据开发:

- 在左侧导航栏中,选择“数据开发”或类似选项,进入数据开发工作台。

选择项目和工作空间:

- 选择您正在工作的项目和工作空间。

访问表详情:

- 在数据开发页面,找到并打开包含你要清空分区的表。

分区管理:

- 在表详情页面,找到并点击“分区管理”选项卡。

选择要删除的分区:

- 在分区管理界面,找到并选择要清空的分区。通常,分区信息会以键值对的形式显示,例如

ds='20240515'。

- 在分区管理界面,找到并选择要清空的分区。通常,分区信息会以键值对的形式显示,例如

执行删除操作:

- 确认选择的分区正确无误后,执行删除操作。这通常会有一个确认提示,因为删除操作是不可逆的。

使用SQL操作:

- 如果在界面上没有直接的删除分区选项,你可以编写SQL语句来删除分区。例如,在支持DDL操作的数据库(如Hive或MySQL)中,可以使用如下语句:

sql ALTER TABLE table_name DROP PARTITION (partition_key=value);将`table_name`替换为你的表名,`partition_key=value`替换为实际的分区键值。- 执行SQL:

- 在DataWorks的数据开发面板中,创建一个新的SQL任务,输入上述SQL语句,然后运行任务来删除指定的分区。

监控任务:

- 确保删除操作成功执行,可以在任务的运行历史中查看状态和日志。

请注意,具体操作可能会根据DataWorks界面的更新有所变化,建议始终参考最新的官方文档或直接在控制台中查找相关功能。

赞0 踩0 评论0 -

回答了问题

2024-05-15

回答了问题

2024-05-15

DataWorks想请问一下是否支持通过接口单独触发业务流程里面的某些节点运行?

是的,DataWorks 支持通过接口单独触发业务流程里面的某些节点运行。为了实现这一功能,您可以使用DataWorks提供的HTTP触发器节点。以下是关键步骤和概念:

开通相应版本:确保您已开通DataWorks企业版及以上版本,因为HTTP触发器节点等功能可能在基础版本中不可用。

创建业务流程:在DataWorks的数据开发模块(DataStudio)中,创建或打开一个现有的业务流程。

添加HTTP触发器节点:

- 在业务流程图中,您可以插入一个HTTP触发器节点。这个节点作为流程的一部分,其执行可以通过外部HTTP请求来触发。

- 配置该节点时,需要设定触发URL、请求方法(如GET或POST)、认证方式以及请求参数等信息。

配置任务依赖:如果需要,设定HTTP触发器节点与其他任务节点之间的依赖关系,确保按照预期顺序执行。

编写外部请求:在需要触发节点时,通过编程或工具向配置好的HTTP地址发送请求。这可以是定时任务、用户操作触发的后台逻辑或其他系统的回调。

监控与调试:在DataWorks的监控界面查看触发节点的执行状态和日志,确保触发机制正常工作。

赞0 踩0 评论0 -

回答了问题

2024-05-15

回答了问题

2024-05-15

如何实现dataworks脱敏配置的流程?

在阿里云DataWorks中实现数据脱敏配置的流程如下:

登录DataWorks:

- 使用您的阿里云账号登录DataWorks控制台。

进入数据开发:

- 在左侧导航栏中,找到并点击“数据开发”或类似选项,进入数据开发工作台。

选择数据脱敏:

- 在数据开发页面,找到并点击“数据脱敏”功能入口,进入数据脱敏管理页面。

配置数据源和表:

- 在数据脱敏管理页面,选择您需要进行脱敏操作的数据源。

- 从数据源中选取要脱敏的表。

添加脱敏规则:

- 点击“添加规则”按钮,开始配置脱敏规则。

- 选择需要脱敏的字段。

- 选择合适的脱敏方式,DataWorks提供了假名、哈希和掩盖等多种脱敏方法。

- 对于每个字段,可以配置特定的脱敏规则,如保留数据格式、保持原始数据间的关联性等。

保存和应用规则:

- 保存您的脱敏规则设置。

- 应用这些规则到选定的数据源或表上。

验证和测试:

- 可以预览脱敏效果,确认脱敏后的数据符合预期。

- 如果需要,可以调整规则并再次保存和应用。

启用和监控:

- 启用脱敏规则,确保在数据同步或查询时应用这些规则。

- 监控数据脱敏任务的执行情况,确保数据处理正常。

持续管理:

- 脱敏规则可以随时编辑和更新,以适应业务需求的变化。

- 如果需要删除已配置的规则,可以在管理界面中找到相应的操作进行删除。

赞0 踩0 评论0 -

回答了问题

2024-05-15

回答了问题

2024-05-15

DataWorks离线数据同步的主键更新模式,如果源表删除了某条数据,目的表也会删除吗?

一般而言,主键更新模式主要用于当源表中的数据发生变化时(如更新某些字段的值),确保这些变化能够反映到目标表中对应记录上。然而,对于源表数据的删除操作,标准的主键更新模式可能不会直接导致目标表中相应记录的删除。通常,数据同步工具在设计上偏向于插入和更新操作,而不会自动执行删除操作以避免误删风险。

如果需要实现源表数据删除后,目标表也对应删除的功能,可能需要采用更复杂的数据同步策略,比如全量同步加差异对比删除,或者利用特定的同步任务设置及后处理脚本实现。在DataWorks中,可以通过自定义SQL转换、使用调度任务结合临时表进行比对删除等方式间接实现这一需求。

赞0 踩0 评论0 -

回答了问题

2024-05-14

回答了问题

2024-05-14

为什么程序员害怕改需求?

程序员们对需求变更的恐惧,其实是有道理的。首先,就像建筑工人不能随便改图纸一样,程序员写的每一行代码都是按照最初的需求来设计的。一旦需求变了,这就意味着之前的努力可能要推倒重来,这不就是相当于告诉建筑师他已经盖了一半的楼要换设计吗?时间、精力和成本都会大大增加,你说他们能不紧张吗?

其次,需求变更可能导致整个项目的延期。你想想,修改一个小功能可能会影响到其他模块的代码,甚至牵一发而动全身。程序员得重新梳理逻辑,测试新的功能,这就像解开一团乱麻,很费劲的。

再说了,变更频繁会让程序员很难保持专注。他们得不断适应新的需求,难以进入深度工作状态,效率自然就降低了。而且,持续的变动也会让团队士气受挫,大家可能会觉得项目没有明确的方向,不知道什么时候是个头。

最后,还有一点,那就是客户满意度。如果需求变更过于频繁,最终产品可能偏离最初的设想,客户可能不满意,这对程序员来说也是一种压力,因为他们希望自己的工作能得到认可。

赞6 踩0 评论0 -

回答了问题

2024-05-14

回答了问题

2024-05-14

“AI黏土人”一夜爆火,图像生成类应用应该如何长期留住用户?

这“黏土AI”风潮听起来真是挺逗的,让用户们玩得不亦乐乎,上传照片一秒钟变丑萌黏土人,简直成了社交圈的新宠儿。但话说回来,要想让这种热度不只是短暂的流星,而是成为夜空中持久闪耀的星星,图像生成类应用可得动动脑筋,来点长远规划。

我觉得首先,得保持新鲜感,不断创新。就像时尚界一样,得不断推出新风格、新滤镜、新功能,让用户总有新奇的东西可以尝试。比如,可以考虑引入用户自定义风格的功能,让大家自己动手创造独一无二的“丑萌”风格,这样既增加了互动性,又能激发用户的创造力。

其次,社区建设很重要。建立一个活跃的用户社区,让大家不仅能分享自己的作品,还能相互交流创作心得,形成一种文化氛围。可以举办线上挑战赛、最佳作品评选,甚至邀请艺术家合作,提升整个应用的艺术性和专业度。

再者,得注重用户体验,优化操作流程,让即使是技术小白也能轻松上手,同时保证生成速度和画质,毕竟谁都不想等半天看到的是模糊的小泥人对吧。

还有,得紧跟技术潮流,不断升级算法,提高图像生成的质量和逼真度。技术是这类应用的核心竞争力,保持技术领先,才能在众多同类应用中脱颖而出。

最后,别忘了商业化探索。合理的盈利模式能让应用走得更远。可以考虑推出高级付费功能、品牌合作定制滤镜、或者与电商平台联动,让用户能将自己的作品印制在实物上,比如做成个性化的公仔或装饰品,这样既能增加收入,又提高了用户粘性。

赞31 踩0 评论0 -

回答了问题

2024-05-14

回答了问题

2024-05-14

Flink 写入Doris数据异常

这个问题看起来是由于Flink作业在尝试写入Doris时,发现实际的列数(28)与预期的列数(29)不匹配。即使你确认表的字段数量是28个,报错信息仍然指出有29个。这里有几个可能的原因和解决方案:

代码或配置错误:

- 检查你的Flink作业代码,确保你没有在代码中硬编码了错误的列数。确保列的映射与Doris表的实际结构匹配。

- 确认你的Flink连接器配置(如DorisSink)中指定的列数是否正确。

数据源问题:

- 如果你的Flink作业是从其他数据源读取数据,检查源头数据是否有可能包含额外的隐藏字段或者意外的分隔符导致多解析出一个字段。

版本更新:

- 如果这个任务之前一直正常运行,可能是Flink、Doris或连接器的某个更新导致了这个问题。检查最近是否有任何依赖库的升级。

临时性错误:

- 可能是短暂的网络问题或Doris服务端的瞬时状态导致的。尝试重启作业或稍后再试。

日志和调试:

- 查看Flink作业的完整日志,可能有更多的错误信息或堆栈跟踪可以帮助定位问题。

- 在Doris端检查是否有相关的错误日志或警告。

连接器配置检查:

- 确认Flink的Doris连接器配置是否正确设置了列分隔符和行分隔符。错误信息中提到的列分隔符是

[],这通常是不常见的,通常应该是逗号或制表符。

- 确认Flink的Doris连接器配置是否正确设置了列分隔符和行分隔符。错误信息中提到的列分隔符是

字段顺序问题:

- 确保数据源中的字段顺序与Doris表的字段顺序完全一致。

如果以上检查都没有发现问题,可能需要更深入地调查代码和数据流,或者向Flink社区或Doris的开发者寻求帮助,以确定具体原因。

赞0 踩0 评论0 -

回答了问题

2024-05-14

回答了问题

2024-05-14

DSW实例的terminal为什么没有命令行提示符了?本来应该是root@主机名 + 路径

看起来你正在尝试修复一个没有正确初始化的DSW (Data Science Workbench) 实例终端。当你提到只有“#”而没有命令行提示符时,这通常意味着你以超级用户权限(root)登录,而通常root用户的提示符就是“#”。

关于

.bashrc和.bash_profile,这些文件是Bash shell的配置文件,它们定义了用户登录时执行的环境设置。在某些Linux发行版中,尤其是较旧的版本,.bash_profile用于设置root用户的环境,而在用户主目录下,.bashrc则包含用户级别的配置。你遇到的问题可能是

.bash_profile不存在于你的系统中,这在某些现代的Linux发行版中是正常的,因为它们可能使用.bashrc来管理root用户的环境。如果你确实需要创建一个.bash_profile,你可以手动创建它,或者将.bashrc的内容复制过去。考虑到你提到的错误,你可以尝试创建一个新的.bash_profile文件:touch /root/.bash_profile然后,你可以编辑这个文件,添加以下内容来确保它读取

.bashrc:cat << EOF > /root/.bash_profile # ~/.bash_profile # If not running interactively, don't do anything [ -z "$PS1" ] && return # Source .bashrc source ~/.bashrc EOF保存文件后,退出并重新登录DSW实例,看看是否解决了提示符的问题。如果问题仍然存在,可能需要进一步检查你的DSW实例配置或联系阿里云的技术支持获取更专业的帮助。

赞1 踩0 评论1