平台上flink sql 写hive表 有模版么?

平台上flink sql 写hive表 有模版么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

阿里云大降价~

Flink SQL支持写入Hive表,并且有相应的模板和文档可以参考。

Flink与Hive的集成主要体现在两个方面:

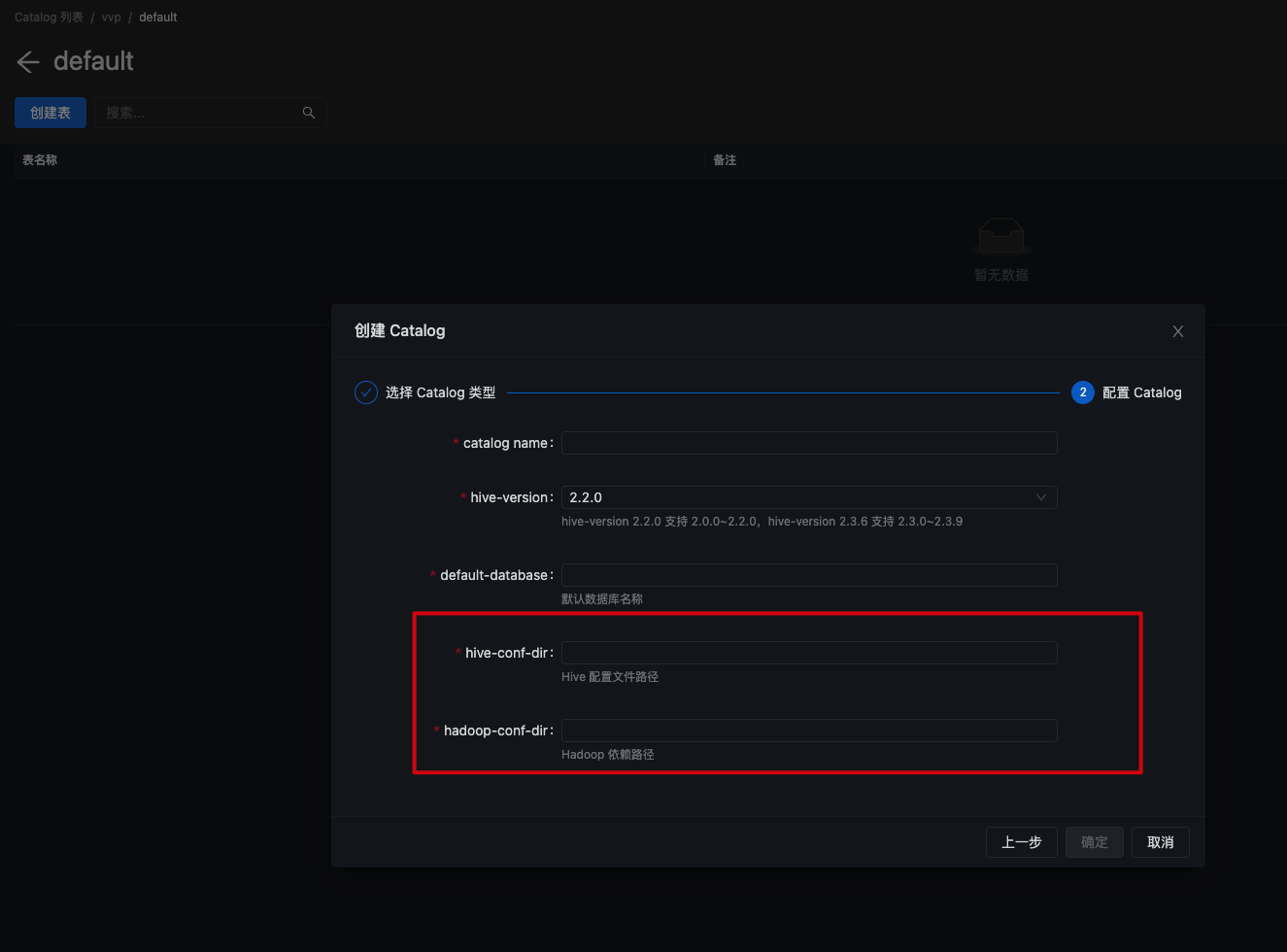

- 使用Hive的MetaStore作为持久化的Catalog:通过HiveCatalog,用户可以将Flink的元数据存储到Hive Metastore中,这样可以在不同的会话中重用这些数据。例如,用户可以将Kafka表或Elasticsearch表存储在Hive Metastore中,并在后续的SQL查询中重新使用它们。

- 直接读写Hive表:Flink提供了与Hive良好的兼容性,用户可以直接使用Flink SQL来读写Hive中的表。这意味着用户可以像使用Spark SQL或Impala操作Hive数据一样,使用Flink来操作Hive表。

具体到写入Hive表的操作,Flink 1.11版本对SQL进行了大量优化,其中包括完善了对Hive的支持。现在不仅可以使用Hive作为持久化的Catalog,还可以使用原生的Flink SQL流式地写数据到Hive中。官方文档中提供了“Streaming Writing”案例,展示了如何流式地将数据写入Hive表。

此外,Flink也支持从已经存在的表中创建视图(VIEW),这在离线的Hive SQL中是常见的做法。在Flink中,也可以基于已有的表创建视图,这些视图通常是基于SQL逻辑查询结果的。

综上所述,如果需要编写Flink SQL来写入Hive表,可以参考Flink官方文档中的相关案例和教程,这些文档通常会提供详细的指导和模板,帮助用户完成具体的操作。同时,也可以考虑使用视图来简化复杂的查询操作。

2024-02-29 20:53:10赞同 展开评论 -

请参考此文档https://help.aliyun.com/zh/flink/user-guide/manage-hive-catalogs?spm=a2c4g.11174283.0.i2

--此回答整理自钉群“实时计算Flink产品交流群”2024-02-28 17:00:30赞同 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

在平台上编写Flink SQL来操作Hive表,通常有一些模板可以参考。这些模板可以帮助你快速地构建SQL语句,以便进行数据的查询、转换和写入等操作。

以下是一个基本的Flink SQL模板,用于将数据从Hive表中读取并写入到另一个Hive表中:

读取Hive表数据:

SELECT * FROM hive_database.hive_table;对数据进行处理:

SELECT column1, column2, ... FROM hive_database.hive_table WHERE condition;将处理后的数据写入新的Hive表:

INSERT INTO hive_database.new_hive_table SELECT column1, column2, ... FROM hive_database.hive_table WHERE condition;使用UDF(用户自定义函数)进行处理:

SELECT udf_function(column) FROM hive_database.hive_table;聚合操作:

SELECT column1, COUNT(column2), AVG(column3) FROM hive_database.hive_table GROUP BY column1;窗口函数:

SELECT column1, COUNT(column2), TUMBLE_START(timestamp, INTERVAL '1' MINUTE) as window_start, TUMBLE_END(timestamp, INTERVAL '1' MINUTE) as window_end FROM hive_database.hive_table GROUP BY column1, TUMBLE(timestamp, INTERVAL '1' MINUTE);

请注意,上述模板中的

hive_database和hive_table需要替换为实际的数据库名和表名。此外,具体的SQL语句会根据你的需求和数据结构进行调整。在使用Flink SQL操作Hive表时,确保已经正确配置了Hive的连接信息,包括Hive的元数据存储地址、认证信息等。这样,Flink才能顺利地与Hive进行交互。

希望以上模板对你有所帮助!如果需要更具体的帮助,可以提供更多的信息或需求,以便提供更精确的指导。

2024-02-28 13:39:23赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。