Flink CDC中oracle cdc 如何同步blob或者clob类型的数据呢?

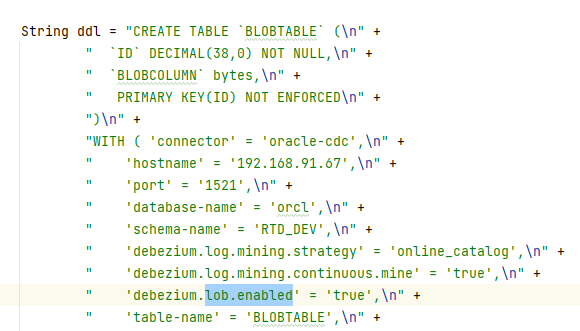

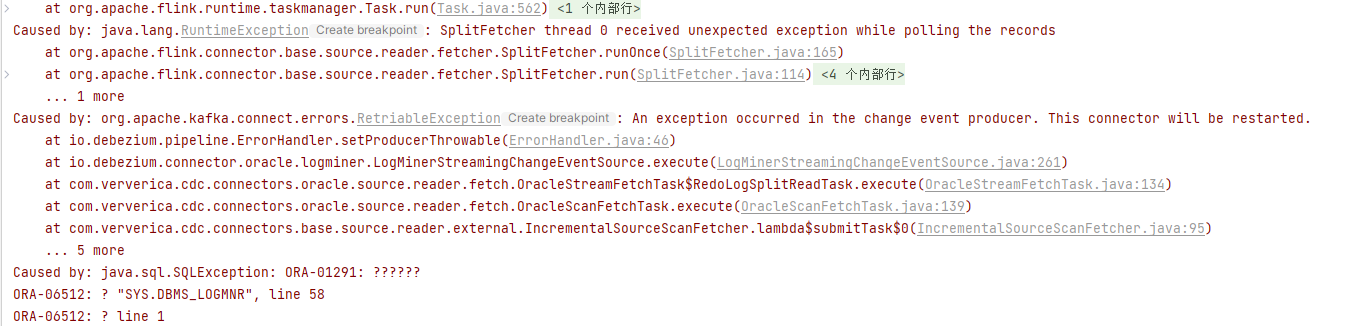

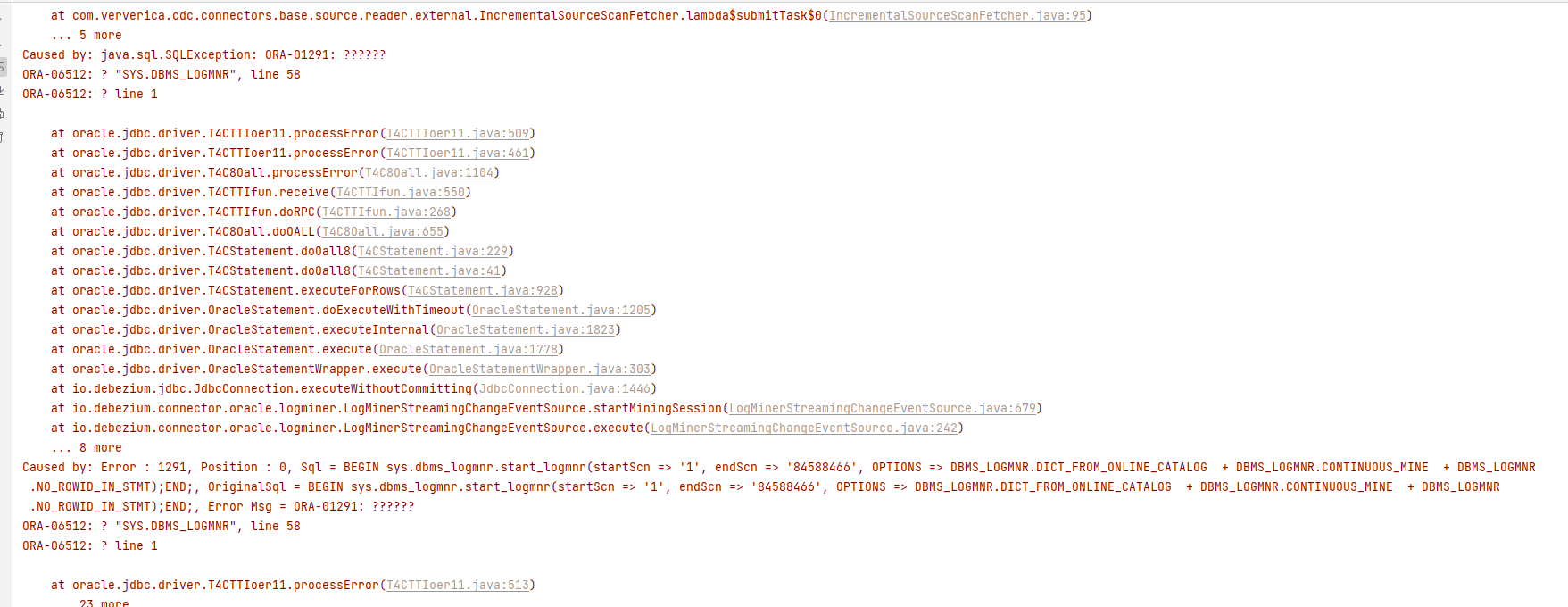

Flink CDC中oracle cdc 如何同步blob或者clob类型的数据呢,我看debezium文档需要开启lob.enable=true,但是开启后就会报错,有没有大佬解决过的?

-

在Flink CDC中,由于Oracle CDC数据源主要基于JDBC的Oracle LogMiner技术,JDBC并不直接支持读取CLOB字段的数据,因此在同步包含CLOB字段的Oracle表时需要采取额外的措施。一个常见的解决方法是将CLOB字段转换为其他数据类型,如VARCHAR2或BLOB。具体操作可以在Oracle中创建一个视图,将CLOB字段转换为VARCHAR2或BLOB字段,然后使用该视图作为Flink CDC的数据源。

对于blob字段类型的数据,目前没有明确的信息说明Flink CDC是否可以直接支持。然而,当在Flink CDC中同步Oracle数据库的更新时,可能会导致BLOB(Binary Large Object)和CLOB(Character Large Object)数据丢失的问题。这是因为Flink CDC默认情况下以JSON格式将变更数据写入到目标系统,而BLOB和CLOB数据类型无法直接以JSON形式表示。解决此问题的一种方法是使用CDC Connector的format参数来配置合适的格式化选项,以支持BLOB和CLOB数据类型的正确序列化和反序列化。可以考虑使用Avro格式,因为Avro是一种二进制数据序列化格式,支持大型对象的处理。

2023-11-30 17:38:10赞同 1 展开评论 打赏 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

Flink CDC 在处理 Oracle 的 BLOB 和 CLOB 类型时可能会遇到一些问题。这是因为 Flink CDC 使用了基于 JDBC 的 Oracle LogMiner 技术,而这种技术可能不支持这些大型对象类型。

以下是一些解决这个问题的建议:

使用 Avro 格式:

- Avro 是一种二进制数据序列化格式,支持大型对象的处理。

- 通过使用 Avro 格式,您可以确保 BLOB 和 CLOB 数据正确地进行序列化和反序列化。

自定义代码处理:

- 如果Avro不能满足您的需求,您可能需要编写自定义代码来处理BLOB和CLOB类型的字段。

- 您可以创建一个用户定义函数(UDF),该函数在流处理过程中读取、转换和写入这些特殊字段。

使用其他工具或库:

- 考虑使用其他的工具或库,比如Debezium,它是一个专门用于捕获数据库变更事件的开源项目,并且已经实现了对Oracle的BLOB和CLOB的支持。

- 虽然您提到开启

lob.enable=true会导致错误,但请检查是否有特定的配置选项或版本兼容性问题导致此问题。

官方文档和社区支持:

- 阅读最新的 Flink CDC 官方文档以获取有关如何处理 Oracle BLOB 和 CLOB 类型的最新指南。

- 参与 Flink CDC 社区讨论,看看是否有人遇到了类似的问题并找到了解决方案。

2023-11-30 15:53:59赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。