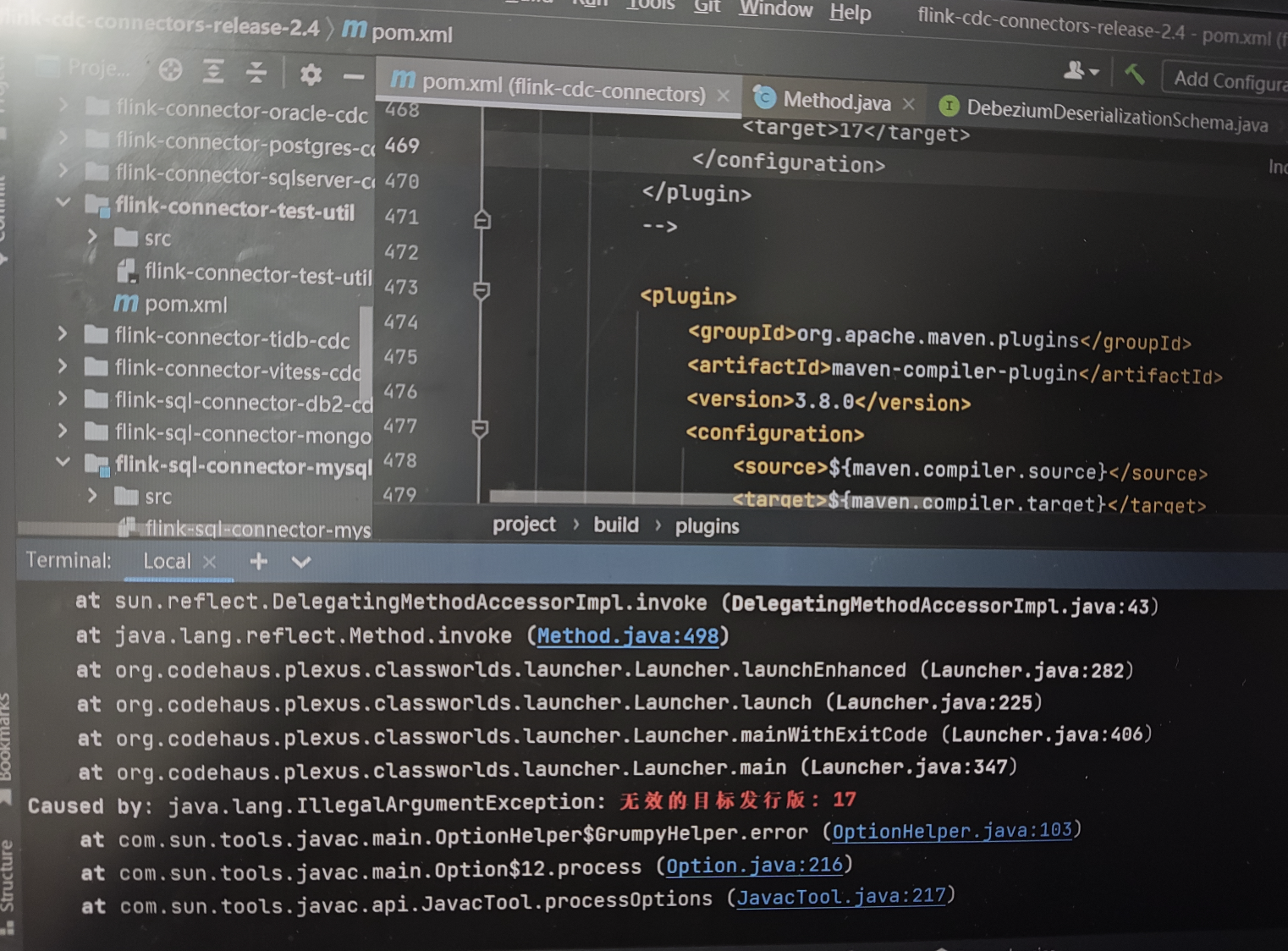

flink cdc是jdk1.8可以编译成功jdk17一直编译不成功,是不是就算自己编译也不行还是?

flink cdc是jdk1.8可以编译成功jdk17一直编译不成功,是不是就算自己编译也不行还是?

一直报这个错?

展开

收起

3

条回答

写回答

写回答

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看

Flink CDC应该支持JDK 8及以上的版本。如果无法在JDK 17上编译成功,请检查您的Flink CDC版本和编译环境,确保正确配置了Maven等工具。

此外,您还可以尝试以下一些步骤来排查问题:- 更新依赖:确认您的Maven仓库中的所有依赖均处于最新状态。

- 清除本地缓存:清空Maven缓存以清除旧的依赖版本。

- 更新项目版本:确认您的项目中使用的所有相关项目的版本都符合Flink CDC的要求。

2023-11-21 23:12:44赞同 展开评论 打赏 -

-

Flink CDC的编译确实需要使用对应的JDK版本。如果你在JDK 17环境下编译Flink CDC,那么你需要确保你使用的JDK版本与Flink支持的JDK版本兼容。然而,尽管你可以在JDK 17环境下成功编译和运行Flink 1.7.1,这并不意味着所有版本的Flink都能在JDK 17下顺利编译。具体支持的JDK版本,请参考Flink官方文档或者GitHub仓库中的说明。

另外,如果你遇到无法获取数据的问题,可能的原因包括但不限于:CDC配置错误、网络问题等。此外,你也可以选择直接从Flink CDC的官方网站下载预编译好的二进制包或通过pom.xml文件中添加相关依赖来使用。

2023-11-21 14:58:48赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

热门讨论

热门文章

flink1.15启动后无法访问webui的问题有人遇到过吗

9987

FlinkCDC MySQL 中 scan.startup.mode 用的是什么模式啊?

2007

flink web UI 是不是本身不支持登录认证,必须通过nginx来加登录认证?

692

Caused by: org.apache.kafka.common.errors.TimeoutE

2387

Flink 语句有啥方法不写字段能直接拥有源表的所有字段?

888

使用Flink CDC,生产环境要申请的服务器如何评估

896

哪位大佬有遇到过Flink这个问题呢?同步pg的时候,是不是类冲突了,所以导致抓不到这个类?

1418

Flink CDC中我使用了自定义聚合函数,但是报错这个需要怎么解决呢?

496

Flink CDC有遇见这个问题的吗?

630

Flink滚动统计一分钟内用户不重复的总数,这个函数怎么写呀?

33

展开全部

Flink⼤状态作业调优实践指南:Flink SQL 作业篇

68934

Flink⼤状态作业调优实践指南:Datastream 作业篇

55842

Flink⼤状态作业调优实践指南:状态报错与启停慢篇

50178

数据仓库介绍与实时数仓案例

41020

权威详解 | 阿里新一代实时计算引擎 Blink,每秒支持数十亿次计算

22865

OPPO数据中台之基石:基于Flink SQL构建实数据仓库

21218

分布式Snapshot和Flink Checkpointing简介

19401

通过Flink实时构建搜索引擎的索引

17117

Flume+Kafka+Flink+Redis构建大数据实时处理系统:实时统计网站PV、UV展示

22155

阿里云实时计算产品案例&解决方案汇总

26157

展开全部