dataworks中parquet文件的压缩比是多少,有1G导出1.2KB这种情况吗?我们lindorm的表数据1.05G,用离线同步任务导出来的文件大小只有1.2KB

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

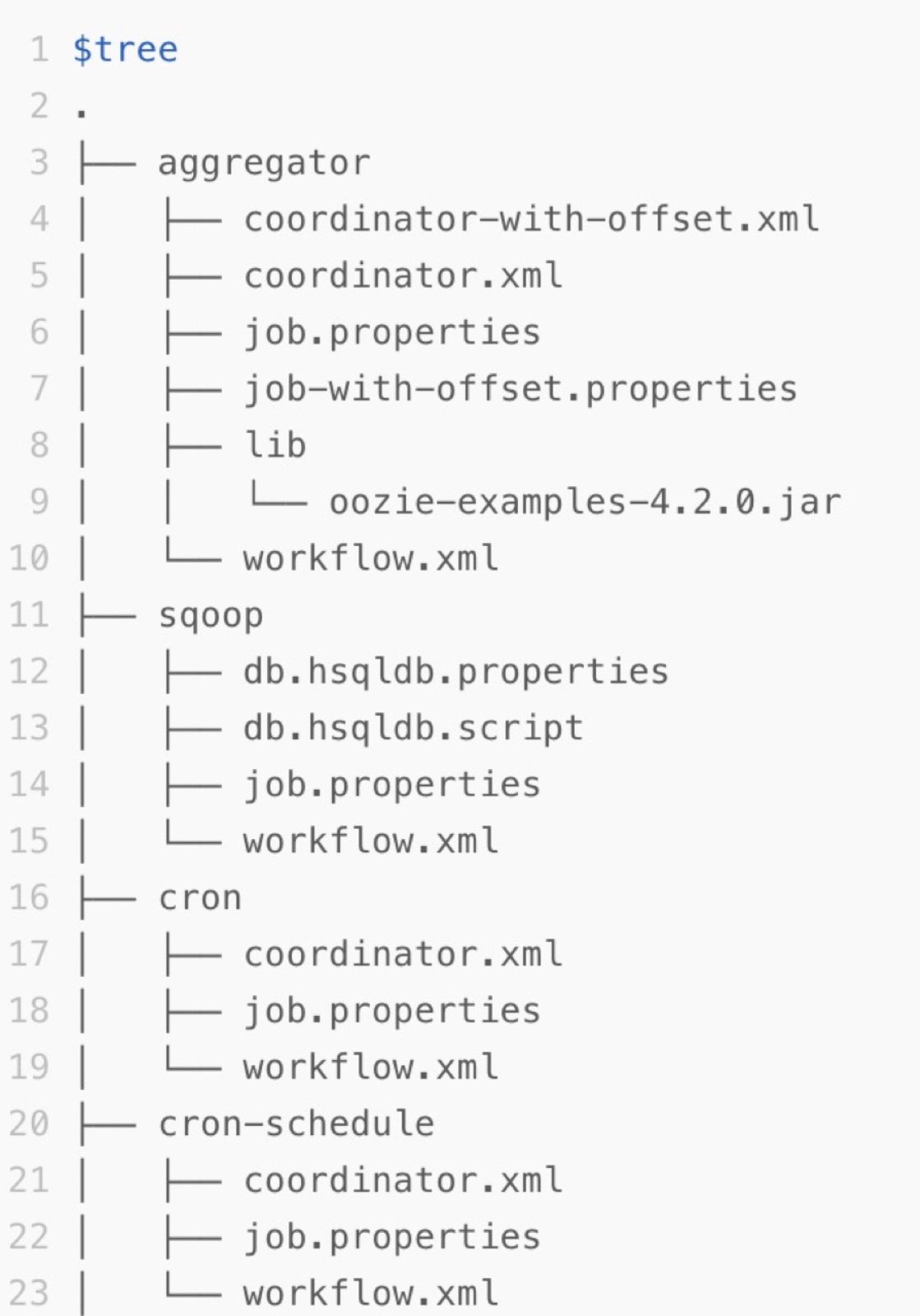

导出文件的要求及结构如下:导出文件的要求 导出的文件需要包含XML和配置项等信息,导出后即为一个Zip包。导出文件的结构Oozie的任务描述在HDFS的某个Path下。以Oozie官方的Examples为例,Examples包中的apps目录下,每个子目录都是一个Oozie的Workflow Job。该子目录包含Workflow的定义XML和配置项等信息。

https://help.aliyun.com/document_detail/181296.html,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

Parquet文件格式支持多种压缩算法,包括Snappy和Gzip等。在不指定压缩方式的情况下生成的 Parquet 文件也比纯文本文件(如csv)要小很多。具体来说,Parquet文件的压缩比取决于所选用的压缩算法以及数据本身的特性。例如,使用gzip压缩比snappy压缩时具有更高的压缩比。

不过,值得注意的是,虽然Parquet文件的压缩性能较好,但不同压缩算法在压缩率、压缩速度和解压速度等方面可能存在差异。因此,选择哪种压缩算法需要根据具体的应用场景和需求来决定。

关于您提到的离线同步任务导出的.parquet文件大小只有1.2KB的问题,这可能是因为该任务中没有实际的数据,或者在导出过程中出现了问题。建议您检查离线同步任务的配置和日志,确保任务正确地执行并导出了所需的数据。

在DataWorks中,Parquet文件的压缩比是由Parquet文件的压缩算法和数据的特征共同决定的。通常情况下,Parquet文件的压缩比在10%到90%之间,取决于数据的特征和压缩算法的选择。

对于你提到的情况,如果你的Parquet文件的大小只有1.2KB,那么这可能是因为你的数据非常稀疏,即数据中的大部分值都是NULL或者0,导致数据的压缩效果不佳。此外,如果你的Parquet文件的大小只有1.2KB,那么这可能是因为你在导出Parquet文件时,没有正确地设置数据的分块大小和列的压缩方式。

在DataWorks中,parquet文件的压缩比是视具体采用的压缩方式而定的。一般情况下,parquet文件支持gzip、snappy等压缩格式。如果采用非压缩模式或者gzip、snappy进行压缩,根据已有的数据对比,可以达到的压缩比分别大约为12、27和19。此外,使用gzip压缩方式会比snappy有更高的压缩比。

对于你们遇到的1.05G的表数据,通过离线同步任务导出的文件大小只有1.2KB的情况,这并不符合常规的parquet文件压缩表现。可能的原因有以下几种:首先,检查是否误操作或设置错误,例如选择了错误的导出格式或目的地等;其次,该情况也可能是由于某些特定数据导致压缩算法无法有效工作,虽然这种情况较为罕见;最后,也有可能是DataWorks工具或服务出现了一些问题。

DataWorks 中 Parquet 文件的压缩比取决于您使用的压缩算法和数据类型。如果您使用的是 Gzip 压缩算法,那么 Parquet 文件的压缩比通常在 20% 左右。如果您使用的是 Snappy 或者 Lz4 压缩算法,那么 Parquet 文件的压缩比通常在 50% 左右。

至于您提到的导出文件大小只有 1.2KB,这可能是因为导出文件中包含的数据量非常少,或者数据量很大但是数据类型是字符串类型,导致数据被压缩后的大小非常小。如果您需要导出大量的数据,建议您使用 Parquet 文件格式,并使用高效的压缩算法来减少文件的大小。

在DataWorks中,Parquet文件的压缩比取决于数据本身的特性以及使用的压缩算法。通常情况下,Parquet文件的压缩比在50%到90%之间。对于特定的数据集和特定的压缩算法,压缩比可能会有所不同。

对于你提到的1G的数据导出为1.2KB的情况,这可能是由于数据本身具有高度压缩性,或者使用的压缩算法不适合该数据集。此外,离线同步任务可能使用了更高效的压缩算法,导致文件大小大幅度减小。

如果你遇到这种情况,可以尝试更换不同的压缩算法,或者对数据进行预处理,以提高压缩效率。同时,你也可以考虑使用其他格式,如CSV或JSON,来存储和导出数据。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。