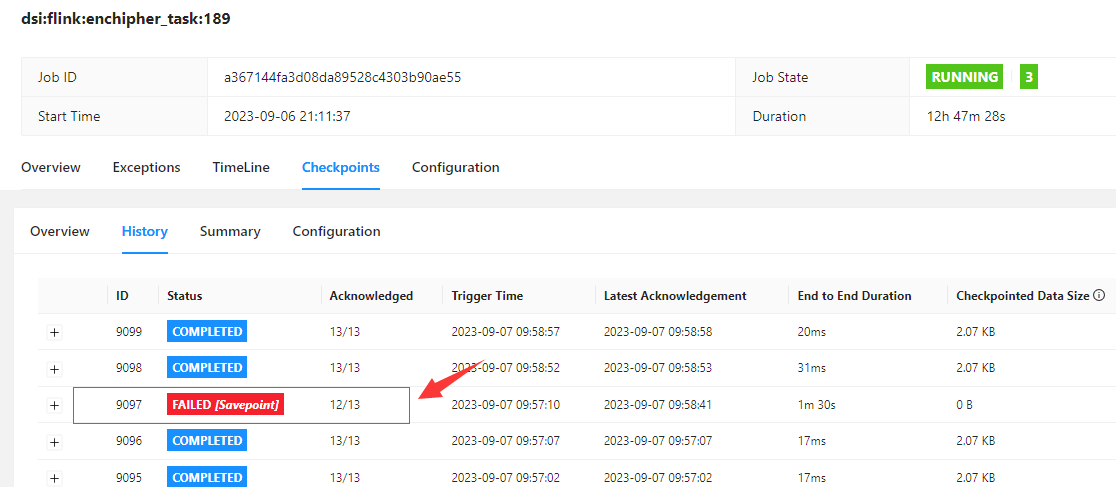

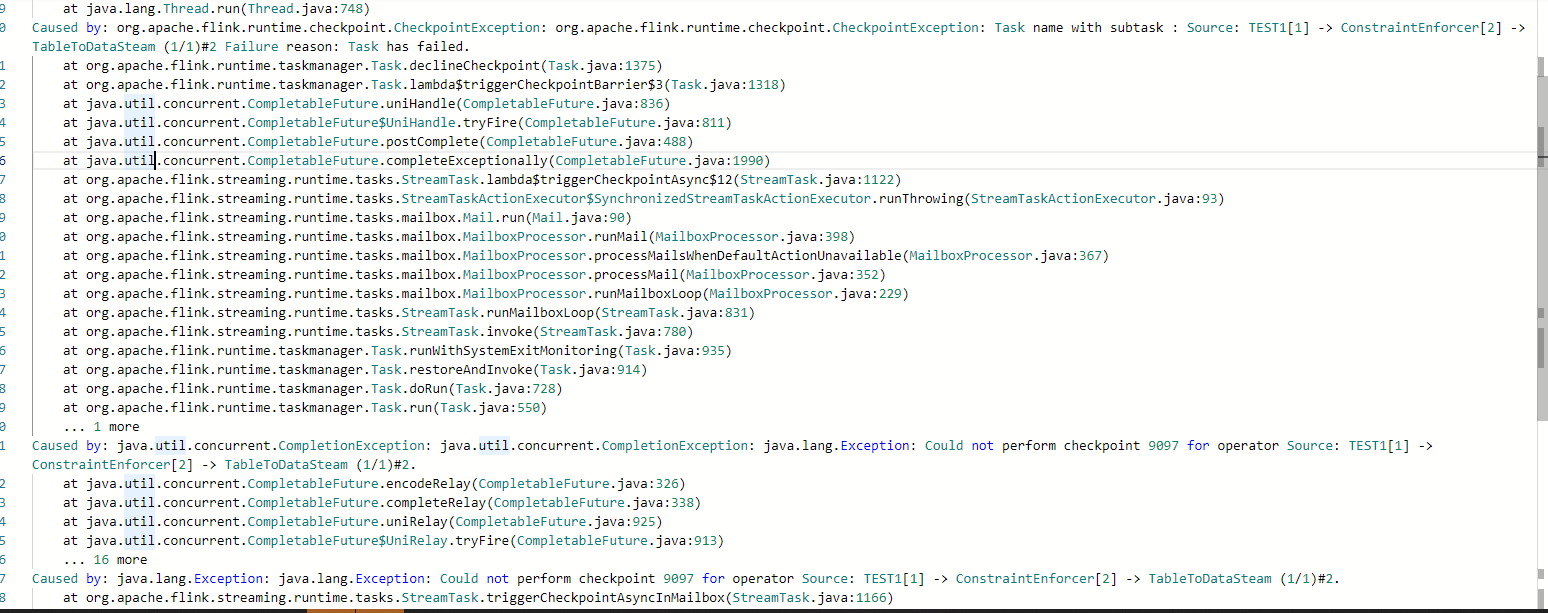

Flink CDC这个是什么问题了,异常信息看不出具体的报错原因?

Flink CDC中oracle-cdc 通过接口调用保存 savepoint 老是报错,checkpoint 是正常的,

,这个是什么问题了,异常信息看不出具体的报错原因

,是 oracle 版本的问题么?oracle 19c?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink CDC中使用oracle-cdc连接器时,通过接口调用保存savepoint失败,而checkpoint正常运行,这种情况可能涉及多个潜在问题。以下是详细分析和解决方案:

1. Savepoint与Checkpoint的区别

Savepoint和Checkpoint虽然都用于保存作业状态,但它们的实现机制有所不同: - Checkpoint:主要用于容错,由Flink自动触发,通常依赖于增量快照机制。 - Savepoint:用户手动触发,用于长期保存作业状态,支持作业的迁移或版本升级。

由于Savepoint需要更完整的状态信息,因此对系统的要求更高,可能会暴露一些Checkpoint未触发的问题。

2. 可能的原因分析

(1) Oracle CDC连接器的兼容性问题

- Oracle 19c 是一个较新的版本,可能存在与Flink CDC连接器的兼容性问题。尽管Checkpoint正常运行,但Savepoint可能对某些特定的状态(如事务日志偏移量)有更高的要求。

- 如果Oracle CDC连接器未正确处理某些状态(例如事务日志的偏移量或元数据),可能导致Savepoint失败。

(2) Savepoint触发时的状态一致性问题

- Savepoint要求所有算子的状态必须一致。如果某个算子(例如Source或Sink)在触发Savepoint时未能正确同步状态,可能会导致失败。

- 特别是Oracle CDC连接器在读取事务日志时,可能因为日志偏移量未正确提交而导致状态不一致。

(3) GeminiStateBackend的版本差异

- 如果您使用的是VVR 6.x或8.x版本,GeminiStateBackend的实现存在差异。从VVR 6.x升级到VVR 8.x时,可能会遇到类似

You are using the new V4 state engine to restore old state data from a checkpoint的报错。 - 这种情况下,Savepoint可能无法正确解析旧的状态数据。

(4) 异常信息不明确

- 如果异常信息未提供具体的错误原因,可能是由于底层日志记录不足或异常未被正确捕获。建议检查Flink的日志级别是否设置为

DEBUG,以获取更详细的日志信息。

3. 解决方案

(1) 检查Oracle CDC连接器的配置

- 确保Oracle CDC连接器的版本与Flink版本兼容。建议使用最新版本的Flink CDC连接器,以获得更好的兼容性和稳定性。

- 检查Oracle数据库的事务日志配置,确保日志保留时间足够长,避免因日志过期导致状态丢失。

(2) 调整Savepoint触发策略

- 在触发Savepoint之前,确保所有算子的状态已同步。可以通过以下方式优化:

- 增加

execution.checkpointing.tolerable-failed-checkpoints参数值,允许更多的Checkpoint失败重试。 - 设置

restart-strategy为fixed-delay,并增加restart-strategy.fixed-delay.attempts的值,以提高作业的容错能力。

- 增加

(3) 升级GeminiStateBackend

- 如果您使用的是VVR 6.x版本,建议升级到VVR 8.x版本,以利用更稳定的状态存储引擎。

- 如果已经升级到VVR 8.x,但仍然遇到状态恢复问题,请参考相关文档解决

You are using the new V4 state engine to restore old state data from a checkpoint的报错。

(4) 启用详细日志

- 将Flink的日志级别设置为

DEBUG,以捕获更详细的异常信息。具体操作如下:log.level: DEBUG - 检查日志中是否有与Oracle CDC连接器相关的异常信息。

(5) 验证Oracle版本兼容性

- Oracle 19c 是一个较新的版本,可能存在与Flink CDC连接器的兼容性问题。建议验证以下内容:

- Oracle数据库的事务日志格式是否与Flink CDC连接器兼容。

- 是否启用了必要的Oracle特性(如LogMiner)。

4. 进一步排查步骤

如果上述方法仍无法解决问题,建议按照以下步骤进一步排查: 1. 复现问题:尝试在测试环境中复现问题,观察是否与生产环境一致。 2. 收集日志:收集Flink作业的日志、Oracle数据库的日志以及Flink CDC连接器的日志。 3. 联系技术支持:将日志和配置信息提供给阿里云技术支持团队,以便进一步分析。

5. 总结

Savepoint失败的原因可能涉及Oracle CDC连接器的兼容性、状态一致性问题或GeminiStateBackend的版本差异。建议从连接器配置、Savepoint触发策略和日志分析入手,逐步排查问题。如果问题仍未解决,请联系技术支持团队获取进一步帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。