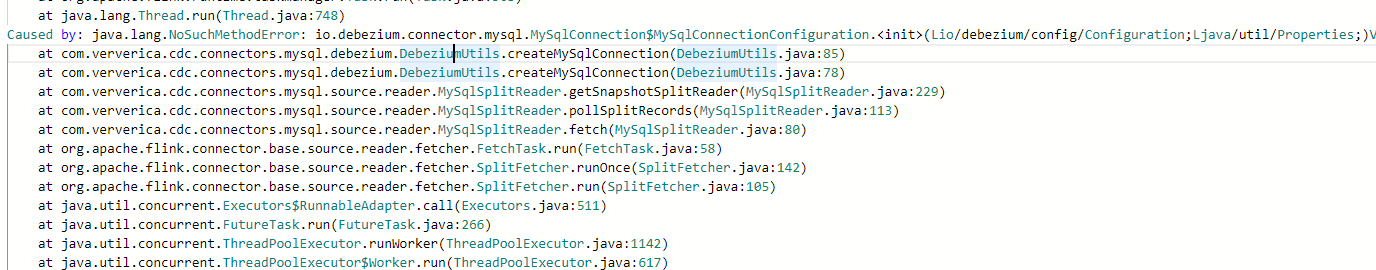

Flink CDC中有这个包,但是还报这个错,这个怎么回事啊?

Flink CDC中有这个包,但是还报这个错,这个怎么回事啊?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

根据提供的信息,你在 Flink CDC 中有一个包,但仍然报错找不到该包。可能的原因和解决方法如下:

1. 确保包名和版本号正确:检查包名是否为

packt.flink.examples.AggFunction,版本号是否为1.0。2. 确认 jar 包的位置:确保你的 jar 包实际上存在,并且可以被访问到。你可以通过以下两种方式进行确认: - 在 IDE(例如 IntelliJ IDEA)中直接添加依赖并编译打包。 - 配置外部 jar 包路径,例如使用

user.class.paths属性来指定 jar 包的位置。3. 检查 jar 包路径的正确性:确保在配置中正确地指定了 jar 包的路径。

4. 在运行 Flink 作业时包含依赖:请考虑以下两种方法: - 将依赖打包到 Flink 作业的 jar 文件中。 - 将依赖部署到可访问的位置(例如 HDFS 或目录),然后在 Flink 中配置相应的路径。

5. 使用 Maven 安装 jar 包:使用

mvn install命令将 jar 包安装到本地仓库中,然后在 Flink 的 IDEA 模块中添加对该依赖的引用。根据具体情况逐一检查上述步骤,找出问题所在并进行修正。希望这些解决方法能够帮助你解决报错的问题。如果还有其他疑问,请随时提问。

2023-07-30 13:02:33赞同 展开评论 -

北京阿里云ACE会长

需要的依赖 packt.flink.examples.AggFunction:jar:1.0 无法被解析。

也就是说 Flink 找不到此 jar 包,从而无法编译和使用你的 AggFunction。

可能的原因有:

你的 jar 包路径写错了

没有正确配置jar包路径

jar包在编译时存在但在运行时不存在了

网络原因无法访问jar包

要解决此问题,需要做以下检查:

确保你的jar包名 packt.flink.examples.AggFunction 以及版本 1.0 是正确的

确认 jar 包的实际位置,你有两种选择:

在 IDE(如 IDEA)中直接添加依赖,然后编译打包

配置外部 jar 包路径,如 user.class.paths

运行 Flink 作业时也需要包含此依赖。你可以:

将依赖打包到 Flink 作业 jar 中

部署到可访问的位置(HDFS/目录),在 Flink 端配置路径

检查 jar 包路径是否正确写法

使用 mvn install 安装 jar包到本地仓库,然后在 Flink IDEA 模块中添加依赖2023-07-30 10:54:56赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。