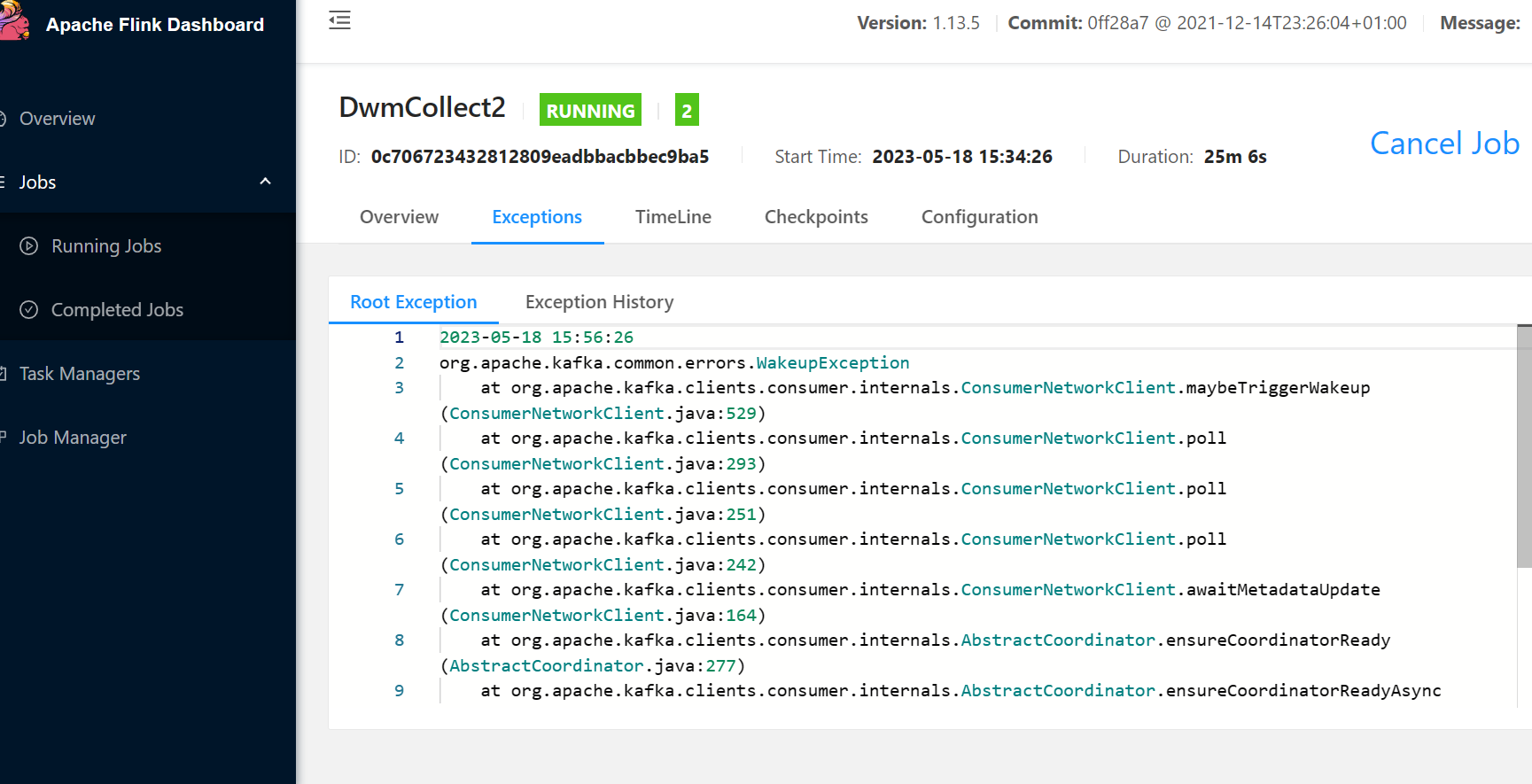

Flink中你们消费kafka 遇到这个问题过吗?

Flink中你们消费kafka 遇到这个问题过吗?

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

在Flink消费Kafka的过程中,可能会遇到各种问题。根据您提供的知识库资料,以下是一些常见问题及其解决方案的详细说明:

1. Flink和Kafka网络连通但无法消费或写入数据

- 问题原因:Flink与Kafka之间可能存在代理或端口映射等转发机制,导致Flink无法正确获取Kafka的元信息。

- 解决方案:

- 直接打通网络:不使用代理或端口映射,直接打通Flink与Kafka之间的网络,使Flink能够直接连通Kafka元信息中显示的Endpoint。

- 修改Kafka配置:联系Kafka运维人员,将转发地址作为Kafka Broker端的

advertised.listeners,以使Kafka客户端拉取的Kafka服务端元信息包含转发地址。

- 注意:仅Kafka 0.10.2.0及以上版本支持将代理地址添加到Kafka Broker的Listener中。

2. Kafka源表数据基于Event Time的窗口后不能输出数据

- 问题原因:Kafka某个分区没有数据,影响Watermark的产生,从而导致基于Event Time的窗口无法触发。

- 解决方案:

- 确保所有分区有数据:检查Kafka的分区是否有数据流入,确保每个分区都有数据。

- 开启空闲监测:在Flink作业中开启源数据空闲监测功能,避免因分区无数据而导致Watermark停滞。

3. Flink Kafka Consumer Offset提交问题

- 问题描述:Flink Kafka Consumer的Offset提交方式取决于是否开启了Checkpoint。

- 解决方案:

- 未开启Checkpoint:依赖Kafka客户端的自动提交机制,需设置

enable.auto.commit和auto.commit.interval.ms参数。 - 开启Checkpoint:Flink会在每次Checkpoint成功时提交Offset到Kafka。此时,Offset提交间隔由Checkpoint间隔决定,建议通过

execution.checkpointing.interval参数调整Checkpoint间隔时间。

- 未开启Checkpoint:依赖Kafka客户端的自动提交机制,需设置

4. Kafka Coordinator切换导致Offset提交失败

- 问题描述:当Kafka Coordinator发生切换时,可能导致Flink作业提交Offset失败,但不会影响作业的正常运行。

- 解决方案:

- 升级Kafka版本:该问题是已知的开源Kafka缺陷,已在Flink 1.16中修复。建议升级到Flink 1.16或更高版本。

- 重启作业:如果无法立即升级,可以通过重启Flink作业恢复Offset提交。

5. 消息堆积问题

- 问题描述:Kafka控制台显示数据堆积,但Flink任务无延迟。

- 可能原因及解决方案:

- 正常情况:如果堆积量保持稳定且最近消费时间接近当前时间,则属于正常现象。

- 异常情况:

- 消费线程卡住:检查客户端消费线程是否卡住,必要时重启消费客户端。

- 消费速度慢:提高消费速度,例如增加Flink作业的并发数或优化消费逻辑。

6. 故障时投递重复的变更事件

- 问题描述:在非正常情况下(如故障发生),CDC工具(如Canal、Debezium、Maxwell)可能投递重复的变更事件到Kafka中,导致Flink消费时出现重复数据。

- 解决方案:

- 启用去重功能:将作业参数

table.exec.source.cdc-events-duplicate设置为true。 - 定义主键:在源表上定义PRIMARY KEY,Flink会生成一个额外的有状态算子,使用PRIMARY KEY对变更事件去重并生成规范化的changelog流。

- 启用去重功能:将作业参数

7. 消费客户端频繁Rebalance

- 问题描述:消费客户端频繁出现Rebalance,可能是由于消费者组配置不当或网络问题导致。

- 解决方案:

- 检查消费者组配置:确保消费者组的

session.timeout.ms和heartbeat.interval.ms参数配置合理。 - 排查网络问题:确认Flink与Kafka之间的网络连通性,避免网络抖动导致Rebalance。

- 检查消费者组配置:确保消费者组的

8. Kafka Commit Offset的作用

- 作用:确保流式数据处理的一致性和可靠性,避免数据重复或丢失。Flink在每次Checkpoint成功时提交当前读取的Offset。

- 注意事项:从Kafka一侧看到的Lag可能并非完全实时,尤其是当Checkpoint间隔较长时,Lag曲线可能会呈现锯齿状。

9. 字段命名冲突

- 问题描述:Kafka数据源的消息键和值中存在相同名称的字段,可能导致字段命名冲突。

- 解决方案:使用

key.fields-prefix属性为键中的字段添加前缀,避免命名冲突。

10. Flink任务状态总览显示数据为0

- 问题描述:如果作业中只有一个节点,Source没有Input只有Output,Sink只有Input没有Output,在作业拓扑图中将无法看到读取和写入的数据量。

- 解决方案:对算子进行分割,将Source算子和Sink算子拆分成独立的算子,并在运行参数中添加

pipeline.operator-chaining: 'false'。

以上是针对Flink消费Kafka过程中可能遇到的问题及其解决方案的详细说明。如果您遇到的具体问题不在上述范围内,请提供更多上下文信息以便进一步分析和解答。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理