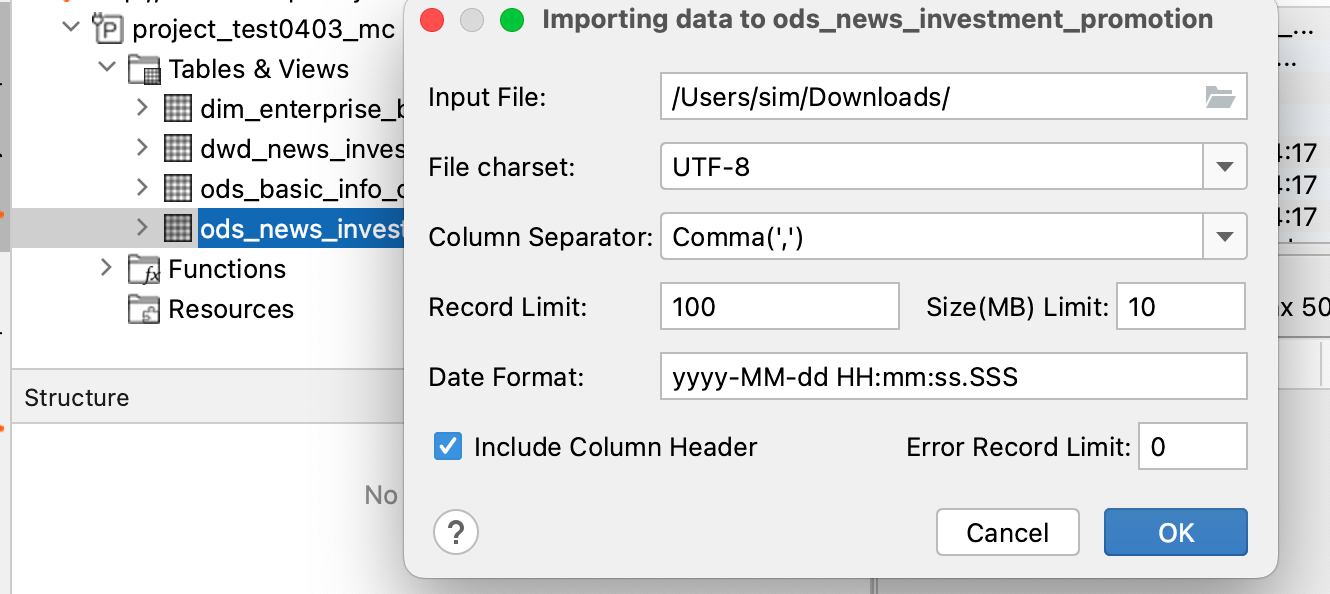

这是导入数据的唯一方式吗?能不能通过python进行批量导入?

这是导入数据的唯一方式吗?能不能通过python进行批量导入?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

公众号:网络技术联盟站,InfoQ签约作者,阿里云社区签约作者,华为云 云享专家,BOSS直聘 创作王者,腾讯课堂创作领航员,博客+论坛:https://www.wljslmz.cn,工程师导航:https://www.wljslmz.com

阿里云大数据开发治理平台DataWorks支持通过Python进行批量导入数据。

具体来说,可以通过以下步骤实现批量导入数据:

-

在DataWorks中创建一个数据集,并将数据集的存储类型设置为"MaxCompute"。

-

使用Python编写代码,读取本地的数据文件,并将数据写入到MaxCompute中。可以使用MaxCompute SDK for Python来实现这个功能。

-

在DataWorks中创建一个同步任务,将MaxCompute中的数据同步到目标表中。

2023-04-27 23:23:22赞同 展开评论 -

-

意中人就是我呀!

可以参考看下这些连接方式 https://help.aliyun.com/document_detail/27968.html?spm=a2c4g.27859.0.0.39ef2011kwQd1s此答案整理自钉群“DataWorks交流群(答疑@机器人)”

2023-04-12 10:09:16赞同 展开评论 -

坚持这件事孤独又漫长。

可以通过Python进行批量导入数据。可以使用PyODPS或MaxCompute SDK连接阿里云数据仓库,并通过Python编写程序实现数据的批量导入。

具体操作步骤如下:

-

安装PyODPS或MaxCompute SDK

PyODPS是一种阿里云ODPS(开放数加)的Python SDK,而MaxCompute SDK是一种阿里云MaxCompute(原名ODPS2.0)的Python SDK。需要根据自己所使用的数据仓库选择对应的SDK进行安装。

-

连接数据仓库

使用PyODPS或MaxCompute SDK连接数据仓库。可以使用以下代码实现连接:

from odps import ODPS o = ODPS('***', '***', '***', endpoint='***', project='***')-

读取本地数据文件

使用Python代码读取本地的数据文件,例如CSV文件。可以使用以下代码实现:

import pandas as pd df = pd.read_csv('data.csv', encoding='utf-8')-

创建数据表

根据数据文件的结构,在数据仓库中创建对应的数据表。可以使用以下代码实现:

o.execute_sql(''' CREATE TABLE IF NOT EXISTS my_table ( id BIGINT, name STRING, age INT ); ''')> 其中,my_table为数据表的名称,id、name、age为数据表的字段名称。-

将数据导入到数据表中

使用Python代码将读取到的本地数据文件导入到数据表中。可以使用以下代码实现:

o.write_table('my_table', df, partition='ds=20230410')> 其中,my_table为数据表的名称,df为数据文件内容,partition为数据表的分区,可以根据需要进行调整。-

执行程序验证

执行Python程序,验证数据是否已经成功导入到数据表中。

需要注意的是,数据的批量导入操作需要根据数据表的结构进行调整,并进行适当的异常处理。

2023-04-11 21:29:36赞同 展开评论 -

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。