我想使用FlinkSink写hdfs。使用snappy压缩。 代码是这样写的: CompressWriterFactory writer = CompressWriters.forExtractor(new DefaultExtractor()) .withHadoopCompression(codec, conf);

FileSink<JSONObject> sink = FileSink

.forBulkFormat(new Path(outputPath), writer)

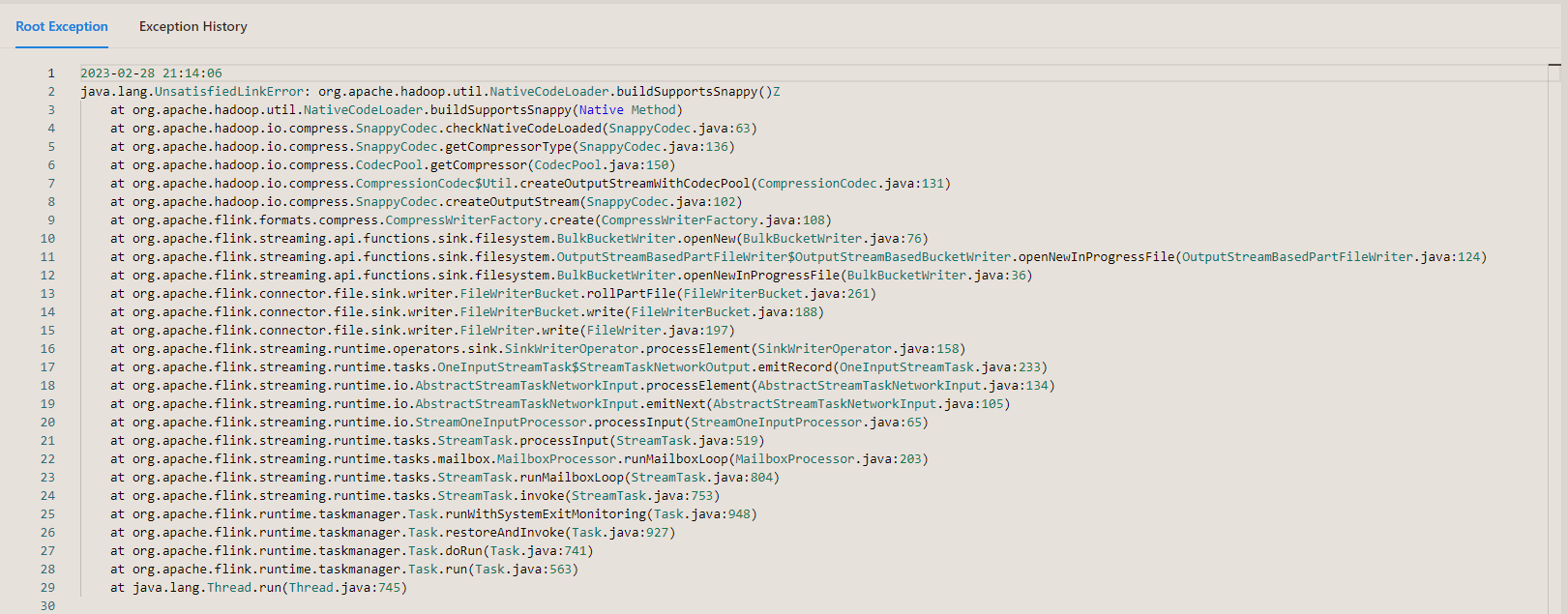

提交到yarn上后报错: 请问是什原因?

请问是什原因?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

缺少so? 高低版本混用? 基本就是依赖的问题。你的包里是不是打了啥不该打的jar。遇到这种问题得分析你自己的依赖引用关系 大概率是高低版本混用。大概率你的jar打包有问题。感觉你是不看第三方库依赖树 疯狂引用依赖 不分运行时和编译时依赖 觉得本地运行没问题 集群运行就没问题了。此答案出自钉群“【③群】Apache Flink China社区”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。