Flink CDC多张流表进行join产生的数据倾斜如何处理和优化的?

Flink CDC多张流表进行join产生的数据倾斜如何处理和优化的?

-

在使用 Flink CDC(Change Data Capture)时,如果你的流表进行 join 操作产生了数据倾斜,这通常意味着在一个或多个 key 上的数据分布是不均衡的。解决数据倾斜问题可以从多个角度进行:

合理设计 Key:

重新思考和设计 join 操作的 key,以确保两个流表在 join key 上的分布是均匀的。尝试选择分布更均匀的字段作为 key。

广播小表:如果有一张表的数据量相对较小,考虑使用 Flink 的 broadcast state 模式。这会将小表的全量数据广播到所有的task,以此减少shuffle的数据量。

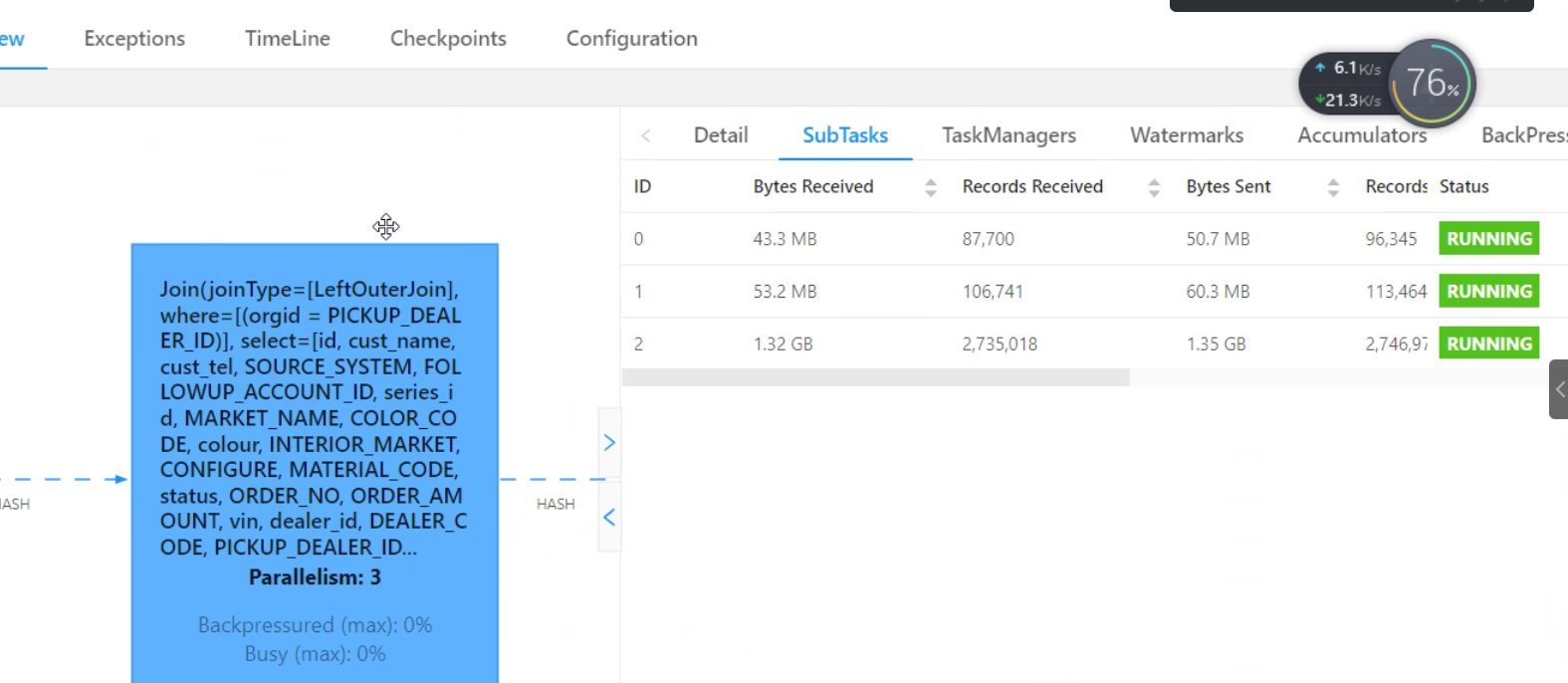

扩大 Flink 任务的并行度:增加任务的并行度可以在一定程度上缓解数据倾斜问题,因为有更多的任务来处理输入数据。

前置过滤:在 join 操作之前,尽量在源头就过滤掉不需要的数据,减少进入 join 操作的数据量。

重分区策略:利用 Flink 的重分区策略,使用 .rebalance() 或 .partitionCustom() 来重新分配 key 以达到更均匀的数据分配。

积极使用窗口和水印:使用窗口和水印技术来拟定数据流间的时间范围,从而控制 join 操作处理数据的范围,进而减少数据倾斜。

使用 Salt Key:为 join key 添加“盐”(随机前缀或后缀)。这个方法可以在打乱数据分布的同时,增加处理的步骤来再次集合相同的 key。

自定义 Partitioner:对于极端的数据倾斜,可能需要实现自定义的 Partitioner 来控制不同节点的数据分布。

监控和识别热点 Key:通过监控和日志分析,识别哪些 key 是数据倾斜的热点,并考虑对它们进行特殊处理。

利用外部系统:对于非常大的数据集和严重的数据倾斜问题,可能需要考虑使用外部系统,例如数据库或键值存储,来处理某些 join 操作。

2024-02-27 15:19:28赞同 展开评论 打赏 -

我把我知道的列举一下给你 1. 尽量减少join的字段数量,只选择必要的字段进行join操作;

-

尽量减少join的表数量,只选择必要的表进行join操作;

-

尽量使用hash join,而不是sort merge join;

-

尽量使用分区join,将join的表按照某个字段进行分区,然后在同一个分区内进行join操作;

-

尽量使用索引,将join的表按照某个字段建立索引,然后在索引上进行join操作;

-

尽量使用缓存,将join的表放入缓存中,然后在缓存中进行join操作;

-

尽量使用分布式缓存,将join的表放入分布式缓存中,然后在分布式缓存中进行join操作;

-

尽量使用分布式索引,将join的表按照某个字段建立分布式索引,然后在分布式索引上进行join操作;

-

尽量使用分布式缓存和分布式索引,将join的表放入分布式缓存中,并建立分布式索引,然后在分布式缓存和分布式索引上进行join操作;

-

尽量使用分布式缓存和分布式索引,并使用分布式缓存和分布式索引的联合查询功能,将join的表放入分布式缓存中,并建立分布式索引,然后在分布式缓存和分布式索引上进行联合查询操作。

2023-02-06 22:07:46赞同 展开评论 打赏 -

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。