处理比较大的数据量的时候会报这个错,数据量较小时不会,问下是什么原因

请问下,在dataworks里部署里一个udf,udf内连接oss读取文件。处理比较大的数据量的时候会报这个错,数据量较小时不会,问下是什么原因

展开

收起

1

条回答

写回答

写回答

-

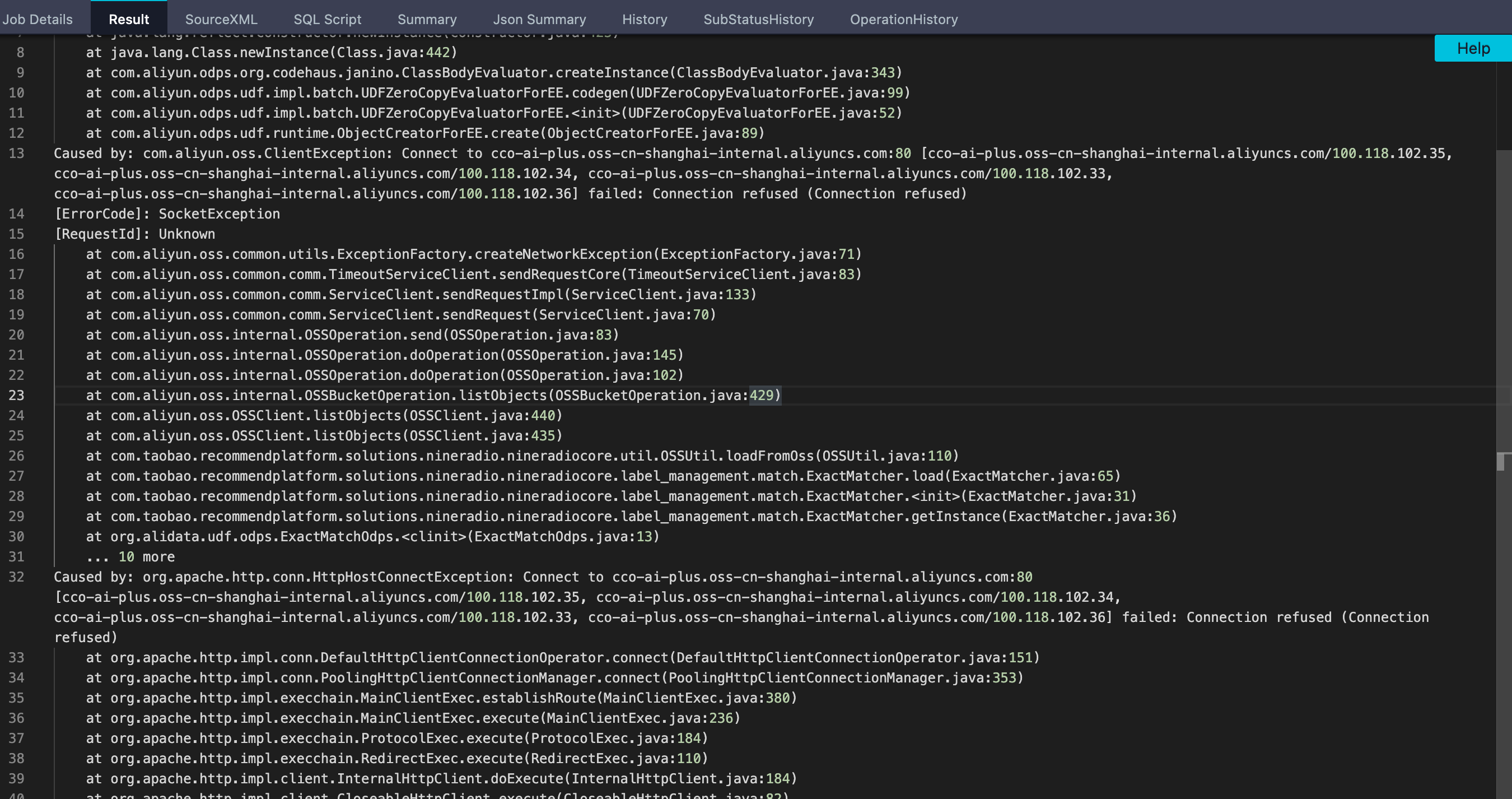

根据您提供的错误截图,可以看到错误信息是“java.io.IOException: Premature EOF”,这意味着在读取OSS文件时,遇到了文件读取到末尾但还未读完的情况。这通常是由于OSS文件无法按照预期大小读取导致的,或者是网络或IO异常导致读取中断而引起的。

在处理大数据量的时候,可能会有大量的数据需要读取和处理,如果网络情况不好或者OSS服务器响应不及时,可能会导致读取数据中断或不完整,进而导致这种错误的发生。为避免这种情况的发生,可以尝试以下几个方案:

- 增加等待时间或延迟读取时间:适当增加OSS文件读取时的等待时间,或将IO超时时间延长,以便更好地等待OSS文件下载完成。

- 分批处理数据:将大文件拆分成多个小文件,分阶段读取和处理,以减少单次读取的数据量,降低网络负担和读取错误的发生率。

- 优化OSS连接:优化您的OSS连接和传输设置,如使用OSS的分块上传、调整传输域名/协议/线路等方式,提高OSS文件的响应效率和传输速度,减少网络波动和数据中断的可能性。

同时,建议您在代码中增加异常处理和日志记录功能,以便更好地捕捉和记录类似错误的发生和处理结果,便于后续调试和优化。

2023-05-17 14:43:43赞同 展开评论 打赏

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

大数据开发治理DataWorks

>

问答

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

相关问答

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。

热门讨论

热门文章

DataWorks如何通过spark访问外网呢?

468

数据来源:com.alibaba.fastjson.JSONException: syntax er

3569

dataworks里面的stg层、ods层、dwd层、dws层、是怎么分层的呢?

1319

DataWorks我该如何访问A项目安装了项目的package资源?

929

dataworks里 left join on的条件如何用like?

246

请教一下DataWorks,doris和starRocks 选型,选哪个?

726

DataWorks中${bdp.system.bizdate}什么意思?

876

Dataphin和 Dataworks 有啥区别呢?

1075

DataWorks数据服务 使用时 出现了canceling的情况 要怎么解决?

423

请问 Argument list too long怎么解决?

1033

展开全部

DataWorks产品使用合集之如何进行mysql的实时同步

144

2万字揭秘阿里巴巴数据治理平台DataWorks建设实践

26535

DataWorks重磅推出Serverless通用型资源组,实现低成本灵活付费和动态平滑扩缩容

54146

DataWorks售前咨询

6099

数据中台的智能进化—阿里巴巴十二年数据平台发展历程

8370

大数据公共数据集上线,免费试用TB级数据分析

7328

大数据&AI的16种可能,2020阿里云客户最佳实践合集下载

72165

《一站式大数据开发治理DataWorks使用宝典》官方电子书开放下载

38936

DataWorks产品使用合集之如何将硬编码的配置值(例如SQL查询中的固定值)更改为调度参数

32

DataWorks产品使用合集之要在已有的分区表上添加新的分区字段,如地区分区,该如何实现

32

展开全部