flink watermark 错乱

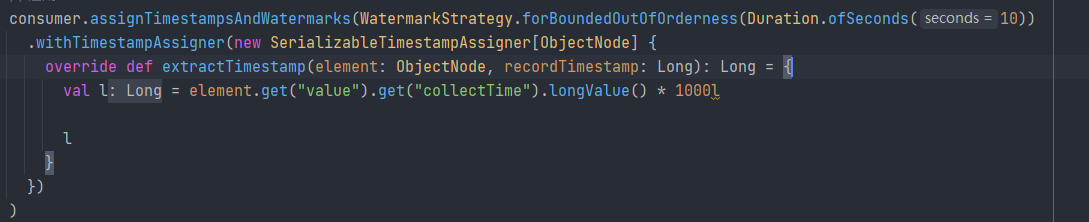

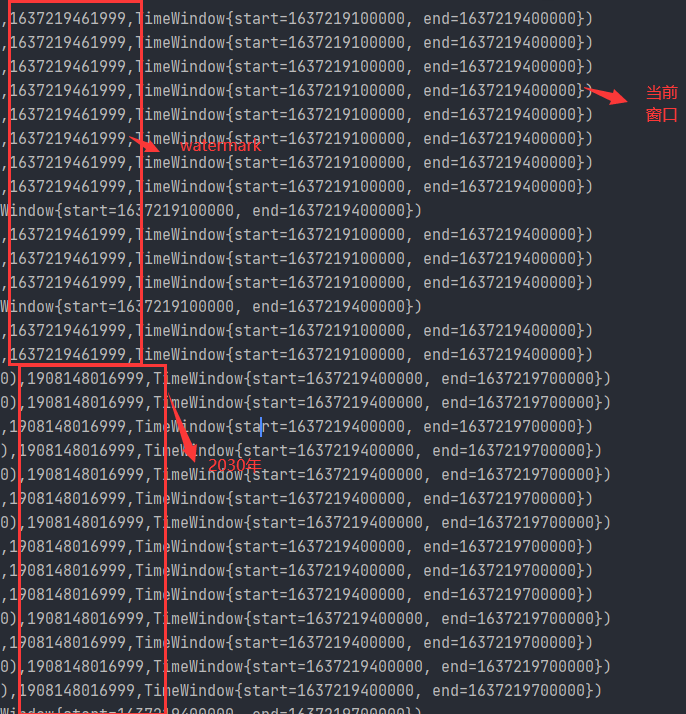

程序运行一段时间,watermark跳到2030年: 背景:flink 1.13.1消费kafka, TumblingEventTimeWindows窗口, 自定义process处理 自定义sink到redis中 1.指定的watermark生成计算出来的时间戳中没有2030年的。  跳到2030年后导致不会再有新的数据进入flink

跳到2030年后导致不会再有新的数据进入flink

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

遇到Flink程序中Watermark跳到一个异常时间点(如2030年),这通常意味着Watermark生成或处理过程中出现了问题。以下是一些可能的原因和解决建议,结合阿里云的环境和产品特性来考虑:

-

检查Event Time与Watermark逻辑:

- 确认你的数据源是否有可能包含未来时间的事件或者错误的时间戳。虽然你说没有指定到2030年的,但可能存在某些边缘情况或错误数据导致。

- 检查自定义Watermark生成器逻辑,确保它正确反映了数据流中的时间进展,并且没有因为错误的数据输入或逻辑错误而生成了远未来的Watermark。

-

数据源验证:

- 使用Kafka Source时,确认Kafka消息的时间戳字段是否正确设置,以及这些时间戳是否符合预期范围。

- 考虑使用Kafka Consumer配置中的时间戳解析选项,确保Flink正确解释Kafka消息的时间戳。

-

监控与日志分析:

- 利用阿里云Log Service或SLS收集Flink作业的日志,仔细检查是否有异常信息或错误提示,特别是与时间戳处理相关的部分。

- 观察并记录Watermark的进展,可以通过Flink Web UI的“Metrics”标签页查看Watermark的实时状态,帮助定位问题。

-

资源与稳定性:

- 确保Flink集群资源充足,避免因资源争抢或任务调度延迟导致的时间计算不准确。

- 阿里云提供了E-MapReduce (EMR) 服务,其中集成了Flink,可以利用EMR的管理功能和监控工具进一步排查问题。

-

版本兼容性与升级:

- 虽然你使用的是Flink 1.13.1,但考虑到软件的持续更新,检查是否有已知的bug影响到了Watermark处理,并考虑是否有必要升级到更高版本以修复潜在问题。阿里云EMR会提供多个版本的Flink供选择。

-

社区与技术支持:

- 如果问题依然无法解决,可以在阿里云开发者论坛、Flink官方社区或Stack Overflow等平台寻求帮助,分享你的问题细节和已尝试的解决方案,可能会有其他用户或专家给出针对性的建议。

记得在进行任何调整或测试时,先在非生产环境中复现问题,以避免对线上服务造成影响。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

收录在圈子:

+ 订阅

实时计算 Flink 版(Alibaba Cloud Realtime Compute for Apache Flink,Powered by Ververica)是阿里云基于 Apache Flink 构建的企业级、高性能实时大数据处理系统,由 Apache Flink 创始团队官方出品,拥有全球统一商业化品牌,完全兼容开源 Flink API,提供丰富的企业级增值功能。

相关文章

热门讨论

热门文章

展开全部

展开全部

还有其他疑问?

咨询AI助理