国际计算语言学协会年会 ACL 2020 按照原定时间已经于 7 月 5 日至 10 日召开,受到疫情影响,本次会议全部改为线上会议。ACL 2020 共收到了 3429 篇论文,收录其中 779 篇论文,包括 571 篇长论文和 208 篇短论文,论文的总接收率为 22.7%。ACL 2020 收录文章数量前五位的主题分别是:机器学习(Machine Learning for NLP)、对话和交互技术(Dialog and Interactive Technologies)、机器翻译(Machine Translation)、信息提取(Information Extraction)和 NLP 应用(NLP Application)。

目前,ACL 2020 收录的文章大部分已经在网上公开。从论文的题目、主题等关键词可以看出,主要的研究方向包括人机对话,多模态、多语言和多领域,图神经网络,以及经典的信息提取类问题,包括实体抽取(NER)、事件抽取以及关系抽取等。研究手段则仍集中于各类机器学习的方法,包括:神经网络、预训练、注意力、知识图谱等。还有一些文章特别关注了低资源、少样本等实际应用中经常会遇到的问题。

我们选择了 ACL 2020 中三篇与知识图谱相关的文章进行详细解读。其中,第一篇重点关注知识图谱本身,提出了一种基于距离的知识图谱中的源实体到目标实体的链接预测(Link Prediction)方法。第二篇文章是知识图谱在摘要生成任务中的应用,第三篇文章是知识图谱在会话生成任务中的应用。

1. Orthogonal Relation Transforms with Graph Context Modeling for Knowledge Graph Embedding

论文地址:https://arxiv.org/pdf/1911.04910.pdf

本文是京东人工智能研究院的一篇文章,具体是提出了一种新的基于距离的知识图谱嵌入方法,称为基于图上下文的正交变换嵌入( orthogonal transform embedding,OTE),以解决知识图谱中 1-to-N、N-to-1 和 N-to-N 的链接预测问题。京东人工智能研究院在关于京东智联云的工作中,应用知识图谱技术构建了基于商品的「商品图谱」,并将「商品图谱」与语言模型相结合实现了营销内容智能生成,可以说是 NLP 技术很好的一个应用实例。本文是关于知识图谱本身构建的工作,目的是改进知识图谱中源实体到目标实体的链接预测水平。

1.1 背景知识介绍

知识图谱(Knowledge Graph)是一种多关系图,其中,节点表示实体,边表示实体之间的关系。知识图谱存储来自不同来源的关于人、地方和世界的事实。这些事实以三元组形式保存(头实体、关系实体、尾部实体),并表示为(h, r, t) 。知识图谱在很多 NLP 领域中应用获得了很好的效果,例如推荐系统、问答系统,文本生成任务等。不过,知识图谱需要定期更新事实,为此,人们提出了许多知识图谱嵌入方法来完成知识图谱的链接预测(Link Prediction)。

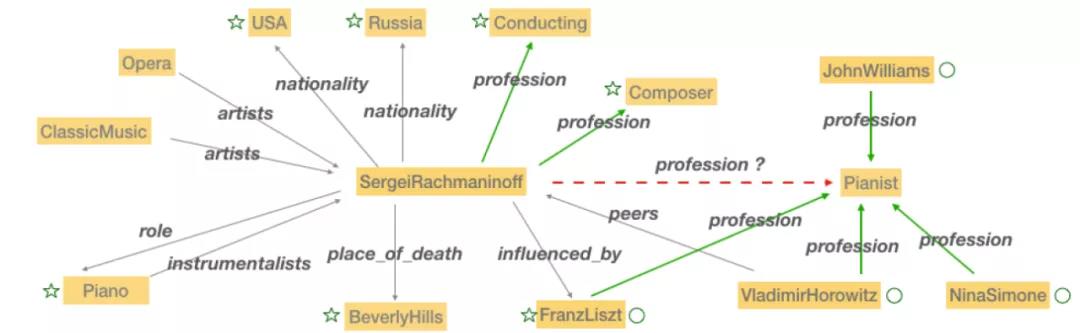

本文重点关注的就是知识图谱中的链接预测问题。1-to-N、N-to-1 和 N-to-N 的链接预测是目前知识图谱链接预测中的主要难点。以图 1 中所示为例,关系「profession」展示了一个 N-to-N 的例子,该示例中重点关注的边被突出显示为绿色。假设三元组(SergeiRachmaninoff, Profession, Pianist)是未知的。链接预测模型以「SergeiRachmaninoff」和关系「Profession」为基础,对知识图谱中的所有实体进行排序,对 「Pianist」(「钢琴家」)进行预测。实体「SergeiRachmaninoff」通过关系「profession」连接到多个作为头实体的实体,而作为尾部实体的「Pianist」也通过关系 「profession」到达多个实体。从单个实体 - 关系对出发,会出现映射到多个不同的实体的情况,这使得 N-to-N 预测变得非常困难。同样的问题也发生在 1-to-N 和 N-to-1 的预测中。

图 1. FB15k-237 中的知识图谱快照,其中,实体用金色块表示。

知识图谱嵌入方法大致可以分为两类 [1]:基于距离的模型和语义匹配模型。基于距离的模型也被称为加性模型,因为它将头和尾部实体投影到同一个嵌入空间,使用两个实体嵌入之间的距离评分来衡量给定三元组的合理性。TransE 是最有代表性的基于距离的模型[2]。语义匹配模型通常采用乘法得分函数来计算给定三元组的似然性。本文采用的是基于距离的模型,通过将上下文信息直接集成到距离评分函数中,实现在链接预测的过程中引入知识图谱的结构以及相邻节点和边的上下文信息。

1.2 方法介绍

把知识图谱看作是一个三元组的集合 D={(h,r,t) },其中 V 是图的节点集,r 是图的边集。每个三元组都有一个头实体 h 和尾部实体 t。关系 r 用从头到尾的方向连接两个实体。1-to-N、N-to-1 和 N-to-N 的链接预测问题是通过如下方法解决的:1)在嵌入空间组上实现的正交关系变换。每个小组都是独立建模和评分的,最终得分是所有小组得分的总和。因此,每个组可以解决实体 - 关系对的不同方面,以解决 1-to-N 和 N-to-N 关系映射问题;2)引入有向图上下文,整合知识图谱结构信息,减少歧义。

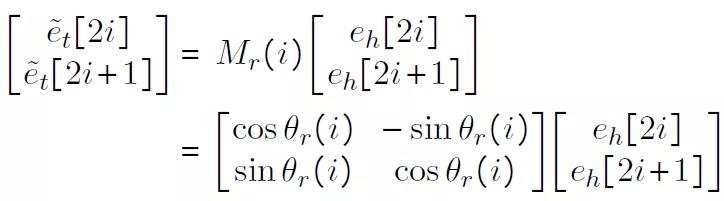

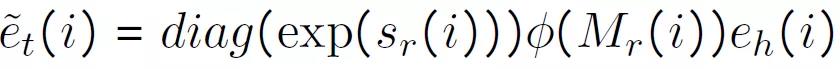

本文的工作主要受到 RotatE 启发[3]。在 RotatE 中,距离评分是通过定义在复域上的 Hadamard 乘积(元素级)来完成的。对于三元组(h,r,t),对应的嵌入为 e_h, θ_r, e_t。对应关系和头实体的 t 的投影 e_t 以正交变换形式表达,如下所示:

其中,M_r(i) 为 2D 正交矩阵。虽然 RotatE 是一种简单有效的知识图链接预测方法,但它定义在二维复域中,建模能力有限。

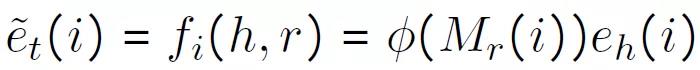

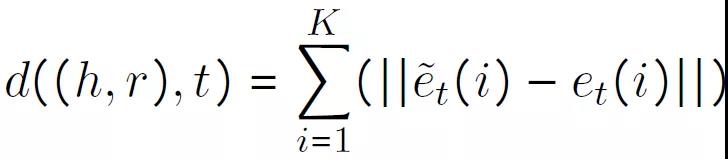

本文考虑的是正交嵌入变换(Orthogonal Transform Embedding,OTE)。使用用 e_h、M_r、e_t 来表示头、关系和尾实体的嵌入。实体嵌入 e_x,其中 x ={ rh, tx},进一步的划分为 K 个子嵌入, e_x=[e_x(1);...;e_x(K)]。对于每个关系 t 的子嵌入 e_t(i),定义从 h 和 r 到 t 的映射为:

ϕ 表示 Gram-Schmidt 过程。ϕ (M_r(i)) 为正交矩阵。进一步的,使用标量张量 s_r(i) 来分别缩放每组嵌入的 L2 范数。则上式改写为:

相应的距离评分函数定义为:

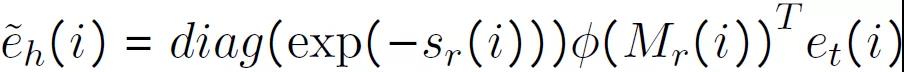

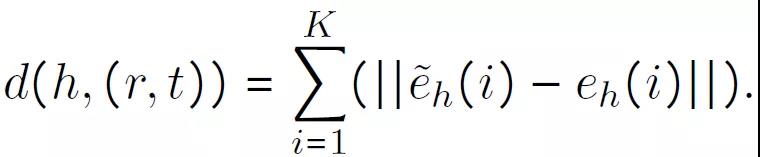

对于头实体 h 的每个子嵌入 e_h(i) ,定义从 r 和 t 到 h 的投影,如下所示:

对应的距离评分函数为:

知识图谱是有向图,即存在(h, r, t),不代表存在(t, r, h)。因此,对于知识图谱中给定的实体,有两种上下文信息:进入它的节点和离开它的节点。特别地,在本文中,对于每个实体 e 考虑以下两个上下文设置:

- 如果 e 是尾,那么尾为 e 的训练三元组中的所有(head, relation)对定义为「头 -- 关系对上下文」(Head Relation Pair Context);

- 如果 e 是头,那么训练三元组中头为 e 的所有 (relation, tail) 对都被定义为「关系—尾对上下文」(Relation Tail Pair Context)。

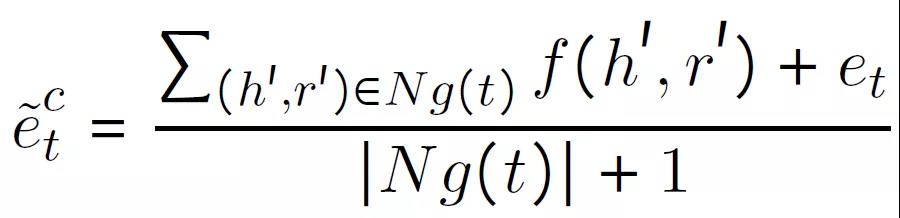

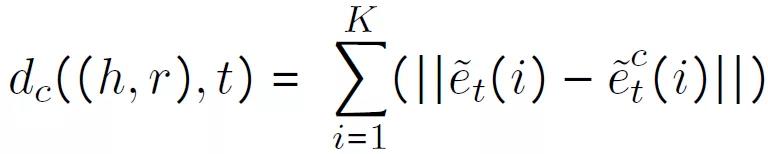

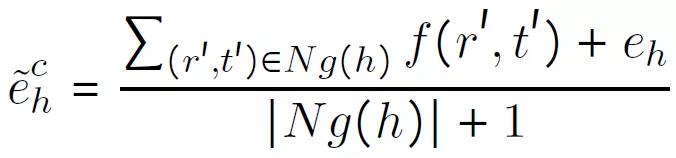

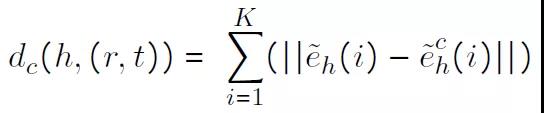

给定一个尾 t,三元组中以 t 为尾的全部头 -- 关系对 (h’, r’) 看作是 t 的图上下文,定义为 N_g(t)。首先,计算头 -- 关系对上下文表示如下:

其中,e_t 为 t 的嵌入,f(h’, r’)为利用公式(2)计算得到的表示。当 N_g(t)为空时,在式(6)中引入 e_t,从而保证上下文表示的计算成为可能。这可以看作是上下文表示计算的一种加性平滑。然后,计算 t 的头相关上下文和相应的基于正交变换的三元组表示的距离,如下所示:

图上下文建模没有引入新的参数,因为消息传递是通过 OTE 实体关系映射来完成的,通过替换 OTE,图上下文可以很容易地应用到其他平移嵌入算法中,如 RotatE 和 TransE 等。

对于给定的头实体 h,将头部为 h 的三元组的所有尾 -- 关系对视为其图形上下文,并表示为 N_g(h) 。首先,计算尾 -- 关系对上下文表示如下:

其中 f(r’,t’)为公式(4)的计算结果。然后,计算 h 的尾 -- 关系对上下文和相应的基于正交变换的三元组表示的距离,如下所示:

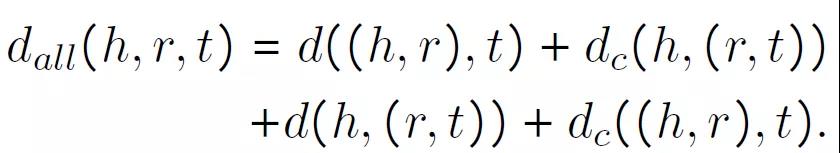

进一步,将上面讨论的四个距离分数(式 3、式 5、式 7 和式 9)结合起来作为图上下文正交变换嵌入(Graph Context-OTE,GC-OTE)的最终距离分数,用于训练和推理。

因此,完整的 GC-OTE 模型可以看作是 K 个局部 GC-OTE 模型的集合。

1.3 实验分析

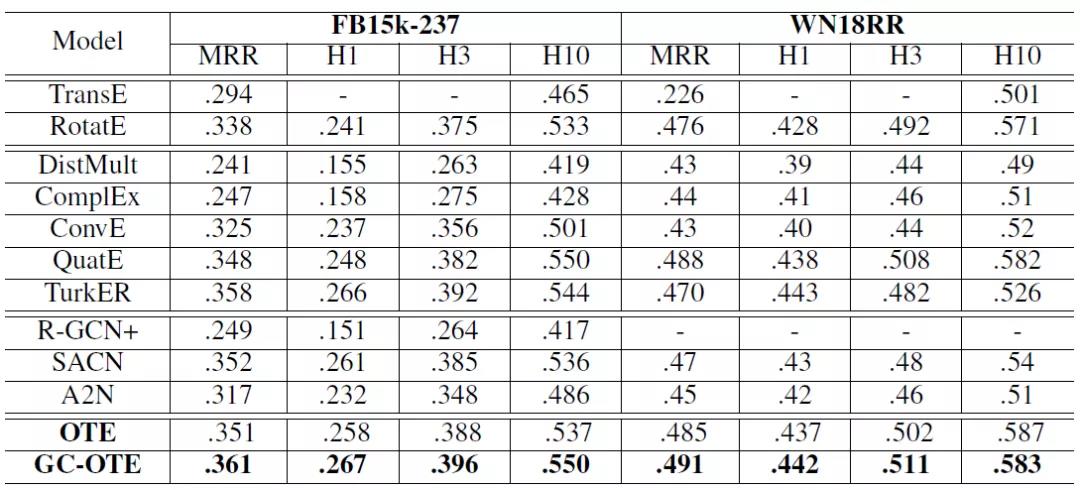

本文使用两个基准数据库(FB15k-237 和 WN18RR)来评估性能。FB15k-237[12]数据集包含知识库关系三元组和自由基实体对的文本提及。FB15k-237 中的知识库三元组是 FB15K[13]的子集,最初取自 Freebase,但在构建 FB15k-237 时取消了逆关系。WN18RR[14]源自 WN18,WN18 是 WordNet 的一个子集。WN18 由 18 个关系和 40943 个实体组成。然而,WN18 中许多文本三元组是通过从训练集中反转三元组得到的。因此,创建 WN18RR 的目的是以确保评估数据集不会因冗余的反向关系而出现测试泄漏。

两个库中的链接预测性能见表 1。从表 1 可以看出:1)在 FB15k-237 上,OTE 的性能优于 RotatE,GC-OTE 在所有指标上都优于其他所有模型。具体地说,MRR 从 0.338(RotatE)增加到 0.361,相对性能提高了约 7%。OTE 将子嵌入维度数从 2 增加到 20,每一个图上下文都贡献了大约一半的改进;2)在 WN18RR 上,OTE 的性能优于 RotatE 和 GC-OTE,达到了最新的最优结果(据作者从已发表的论文中所知)。这些实验结果证明了所提出的 OTE 和图上下文对于知识图谱中缺失链接的预测是有效的。

表 1. FB15k-237 和 WN18RR 实验集中的链接预测性能

1.4 文章小结

本文提出了一种新的基于距离的知识图嵌入方法。它主要包括两个部分:首先,利用正交关系变换将 RotatE 从二维复域扩展到高维空间。第二,提出用图上下文将图结构信息集成到距离评分函数中,以衡量三元组在训练和推理过程中的合理性。

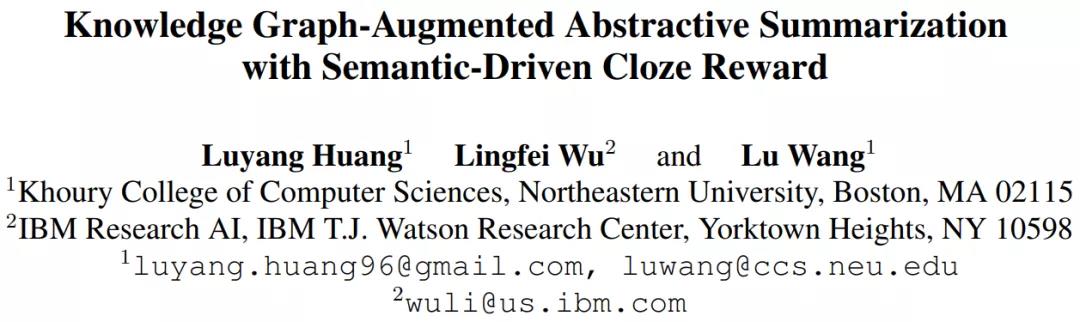

2. Knowledge Graph-Augmented Abstractive Summarization with Semantic-Driven Cloze Reward

论文地址:https://arxiv.org/pdf/2005.01159.pdf

本文是美国东北大学和 IBM 研究人员的研究成果。本文重点关注知识图谱在摘要生成任务中的应用,提出了一种引入图谱增强和语义驱动 RewarD 的摘要生成框架(Abstractive Summarization with Graph Augmentation and semantic-driven RewarD,ASGARD)。使用双编码器(dual encoders):顺序文档编码器和图形结构编码器,来提取知识图谱中实体的全局上下文特征和局部特征。进一步,设计了一个基于多项选择完形填空测试(a reward based on a multiple choice cloze test)的奖励,以驱动模型更好地捕捉实体间的交互信息。

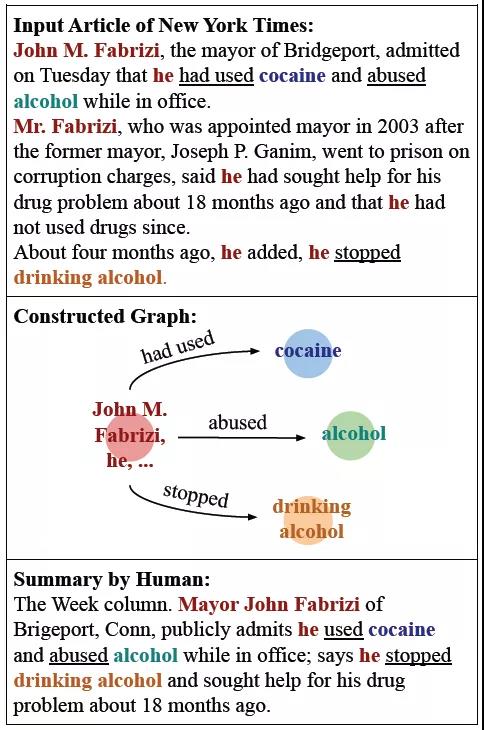

摘要生成(Abstractive Summarization)目的是产生简洁、信息丰富的摘要,从而促进有效的信息消费和知识获取。针对单文档摘要生成任务,基于序列对序列的神经网络模型取得了很好的效果。然而,由于模型结构和基于词预测的学习目标的局限性,这些模型往往产生不真实的内容和过于精练的摘要。这些情况表明,现有的模型缺乏对输入的语义解释,而对语义的正确理解对于摘要生成任务来说是至关重要的。本文作者认为,摘要的信息性和简洁性的生成需要结构化的表示,以便于实现相关主题之间的联系,并保持有全局上下文信息,如实体交互和主题流。以图 1 为示例,与同一实体相关的复杂事件可能跨越多个句子,这使得现有的序列模型难以捕捉这些信息。相反,图表示能够产生一个结构化的摘要,并突出了相关概念的近似性。

图 1. 根据文章片段构造的示例知识图谱,知识图谱将实体或事件的相关信息局部化,并提供全局上下文信息。

本文提出了一个基于图谱增强和语义驱动的抽象摘要框架(Abstractive Summarization with Graph-Augmentation and semantic-driven RewarD,ASGARD)。在编解码框架(encoder-decoder framework)下,利用开放信息抽取(OpenIE)系统的输出,用单独的图结构编码器增强常规文档编码器,以保持实体的全局上下文信息和局部特征。

此外,本文还提出了一种新的多选完形填空(multi-choice cloze)奖励来驱动模型获得对输入文档的语义理解。具体地说,在设计完型填空问题时,移除与谓词相关的成对实体或在人类生成的摘要句中同时出现的实体。而以往的研究中,一般只考虑使用单个实体来构造问题。与知识图谱编码相结合,引入完形填空奖励进一步通过强化学习获得全局实体的交互信息。

2.1 方法介绍

2.1.1 编码器部分

为了从输入文档构建知识图谱,利用 Stanford CoreNLP [4]首先从共指消解(coreference resolution)和开放信息抽取(open information extraction,OpenIE)模型中获得输出 [5]。接下来,利用 OpenIE 提取的 < subject,predicate,object > 三元组,去掉论点(主语或宾语)超过 10 个单词的任何三元组。如果两个三元组只相差一个参数,并且论点重叠,则保留较长的三元组。

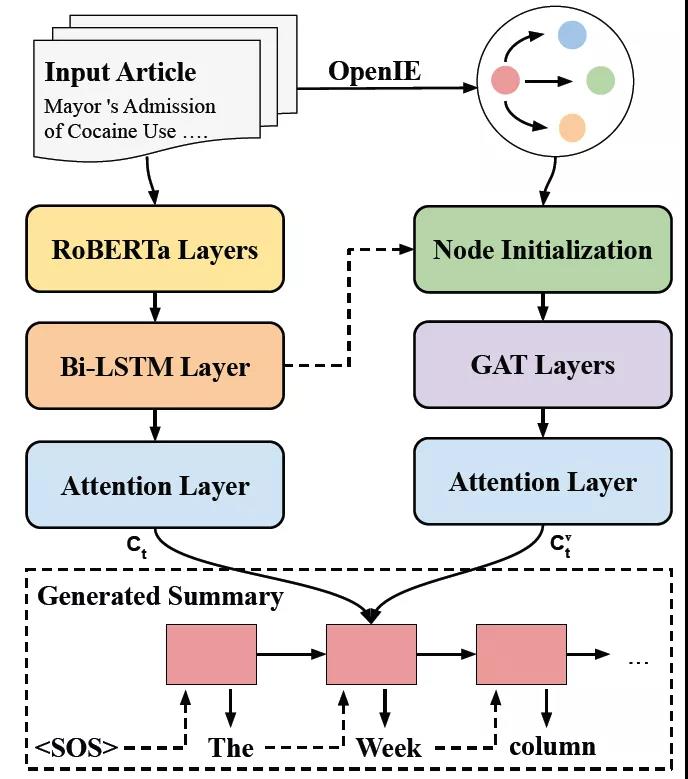

将主客体视为由有向边连接的节点,谓词作为属性。进一步,将同一实体的共同提及考虑为一个节点。通过这一点,可以定位与每个实体相关的显著内容,以及通过图路径连接展开的实体。ASGARD 框架如图 2 所示。

图 2. ASGARD 框架。通过同时关注图谱和输入文档生成摘要。

模型以一个文档作为输入,表示为一系列的符号 x={x_k},以及一个由节点 {v_i} 组成的知识图谱 G。首先将 x 输入 RoBERTa[6],将最后一层的输出作为嵌入。将嵌入输入双向 LSTM(Bi-LSTM),生成 k 时刻的编码隐状态 h_k。利用上文生成的知识图谱,为谓词创建节点。增加从主语到谓语以及从谓语到宾语的有向、无标记的边。进一步,添加反向边和自循环来增强信息流,从而形成知识图谱 G。

节点初始化(Node Initialization)。每个节点通常包含一个实体的多个引用。因此,通过使用其符号的平均嵌入来初始化节点表示 v_i。本文利用文档编码器的隐藏状态 h_k 作为符号的上下文表示。文档中提到的节点次数作为一个额外的编码添加到 v_i 中,以增强实体的显著性。

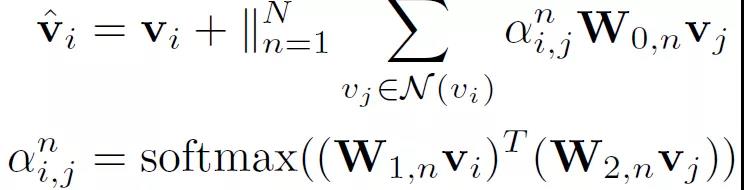

上下文节点编码(Contextualized Node Encoding)。图编码器改进了图注意力网络(Graph Attention Networks,GATs)[7],增加了层间的剩余连接。每个节点 vi 由其相邻节点的加权平均值表示:

其中,|| 表示 n 头连接,每个都生成一个与 v_i 同等维度的向量。上述图编码器通过捕获上述文档的全局关系图和编码图对文档级的文档进行编码,称为 DOCGRAGH。

进一步的,捕获主题移位信息以得到 SEGGRAGH。通过对主题转换和重现进行建模可以识别出文档中的显著内容,从而有利于生成摘要。由于段落自然地将一个文档分成不同的主题段,因此可以直接扩展 DocGragh。首先使用相同的图编码器将每个段落编码为子图 G_p(对于第 p 个段落),然后用 BiLSTM 连接所有子图。首先从最终 GAT 层的输出对子图 G_p 中的所有节点进行最大池化处理。然后将池化的结果用作为 BiLSTM 的输入,以产生 G_p 的最终子图表示(h_p)^g。

2.1.2 摘要解码器

摘要解码器在步骤 t 使用一个单层单向 LSTM 生成隐藏状态 s_t,它通过共同关注输入文档和图来循环生成摘要符号。

注意力图表(Attending the Graph)。在每个解码步骤 t,计算一个带有注意机制的图上下文向量 (c_t)^v:

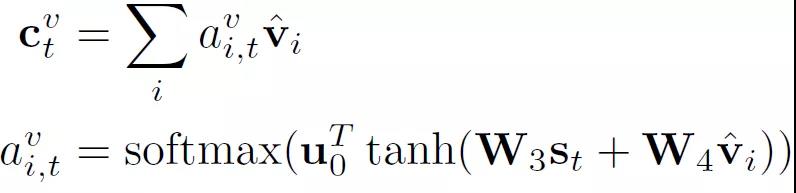

注意力文件(Attending the Document)。类似地,通过考虑图上下文向量(c_t)^v,在输入符号上计算文档上下文 c_t:

符号预测 (Token Prediction)。图和文档上下文向量被视为从两个来源总结得到的文档显著内容,与解码器隐藏状态 s_t 连接以生成词汇分布 P_vocab:

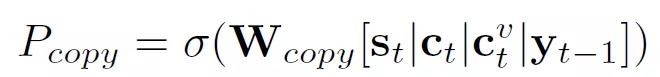

通过使用输入嵌入矩阵和矩阵 W_out 之间的权重共享,以允许复用语言知识。进一步,添加了一个复制机制,计算复制概率为:

类似于上文针对 SegGraph 的处理,引入分级注意机制。使用标量乘法和重整化对输入中的所有节点进行处理,从而将子图中节点的注意(a_t)^g 与先前计算得到的注意(a_t)^v 相结合。

2.1.3 训练

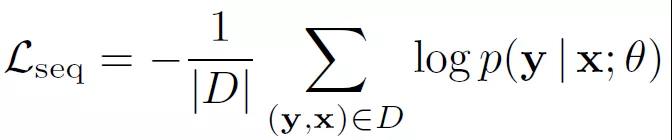

首先考虑一个最大似然(ML)训练目标,最小化下述损失函数:

其中 x 是文档,y 是取自训练集 D 的已知文档,而θ是模型参数。该目标函数的作用是使得生成的文档 x 最大限度的与已知训练集中的已知确定文档保持一致,从而实现对知识图谱中节点所表征的文档的局部特征进行准确描述。

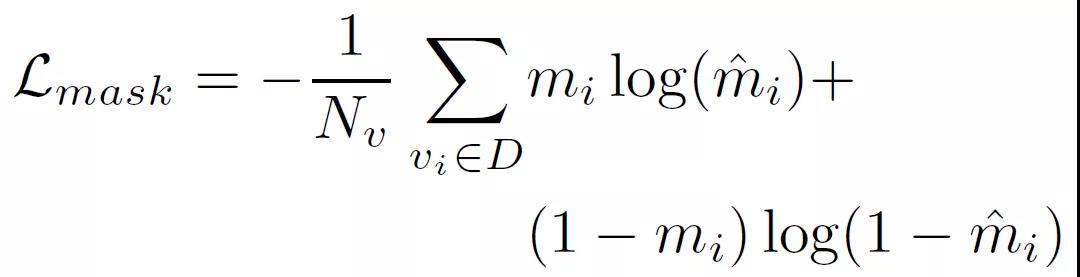

除了对节点的局部特征进行建模外,本文还增加了一个目标函数来标记节点的显著性,即节点显著性标记(Node Salience Labeling)。例如,节点中的实体是否在作为参考的摘要中出现过?在每个节点被传递到图编码器之前,在每个节点中引入一个软掩码层(Soft Mask Layer),用以表征该节点的显著性。该层的作用类似于一个「信息通道(information gate)」。针对每个节点 v_i 预测得到一个实数 m_i(m_i 大小满足[0,1]),使用 m_i 乘以 v_i 得到掩码。对于节点 v_i,掩码计算为:

其中,u_2 为训练参数。在训练期间,如果在参考引用的摘要中包含该节点的至少一个内容词,则该节点的标准掩码 m_i 设置为 1,否则为 0。对数据库 D 中的全部节点都增加下面的目标函数:

最终得到的优化目标函数为:

2.1.4 完形填空强化学习

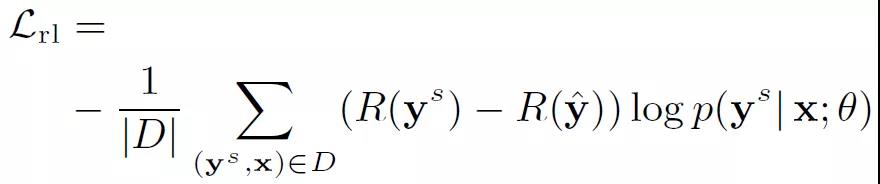

在使用 L_ml 进行极大似然训练后,作者在第二阶段强化学习(RL)中进一步设计了一个多项选择完形填空奖励,使得模型能够生成更真实、信息更丰富的摘要。

对于 RL,本文引入一种自判别策略梯度算法(a self-critical policy gradient algorithm)[8]。在训练过程中,会生成两个摘要:第一,摘要 y^s,在每个解码步骤基于概率分布 p(y^s | x;θ)抽样符号;第二,基线摘要 y^,在每个步骤中贪婪选择概率最高的符号。定义目标函数如下:

本文奖励函数使用 ROUGE 和下面介绍的多项选择完形填空得分的组合:R(y) = R_rouge(y) +γ_clozeR_cloze。ROUGE(Recall-Oriented Understudy for Gisting Evaluation),是一种常用的机器翻译和文章摘要评价指标[9],其表征的意义是系统算法生成的摘要与参考摘要相同的 N-gram 数 / 参考摘要中的 N-gram 总数。本文提出了一种新的多选完形填空奖励,用以引导摘要模型提高实体互动的意识。将系统生成的摘要视为上下文(context)。另外,提供了一组由人手工编写的对应于参考摘要自动生成的问题(questions)。分别训练了一个问答(QA)模型,通过阅读上下文来解决问题。如果系统摘要与参考文献共享了显著信息,问答模型将能够以较高的概率给出正确答案。本文使用正确答案的平均概率作为完形填空的奖励。本文对 RoBERTa 进行微调,以构建 QA 模型。

2.2 实验分析

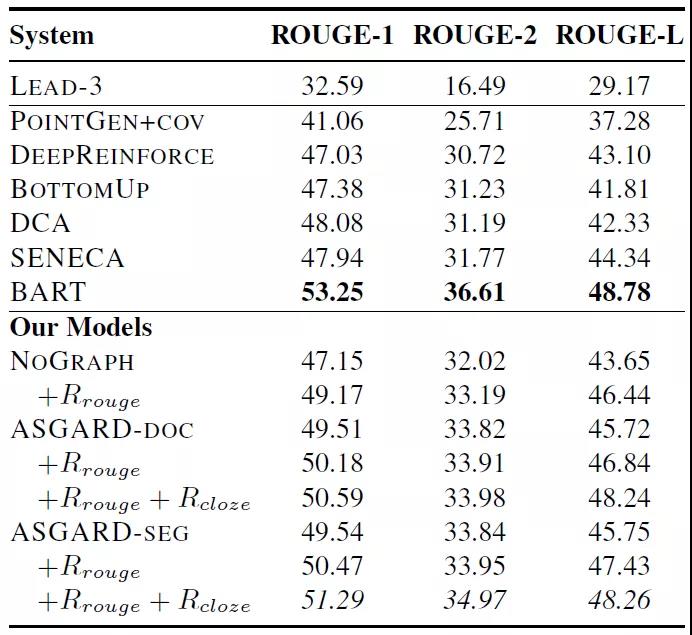

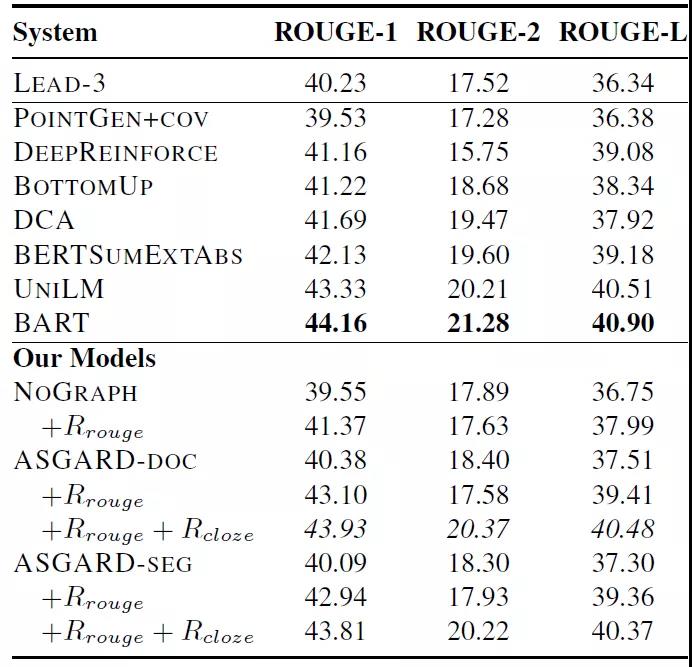

本文实验采用两个包含多个句子的摘要数据集:纽约时报注释语料库(NYT)和 CNN / 每日邮报数据集(CNN/DM)。本文提出的方法与不同基线方法的实验对比结果分别见表 1(NYT 库)和表 2(CNN/DM 库)。对于本文所提出的方法,除了使用 ML 目标训练的 ASGARD-DOC 和 ASGARDSEG 外,表 1 和表 2 的实验中还给出了用 ROUGE 作为奖励(R_rouge)和使用一个额外的完形填空奖励(R_cloze)训练的结果。最后,还给出了一个消除图编码器的变体方法 NOGRAPH 的实验结果。

表 1. NYT 数据库中 ROUGE 自动评价结果,最优结果以粗体表示,本文模型最好的结果以斜体表示

表 2. CNN/DM 数据库中 ROUGE 自动评价结果,最优结果以粗体表示,本文模型最好的结果以斜体表示

2.3 文章小结

本文提出了一种知识图谱增强摘要生成框架,并提出了一种用于强化学习的多项选择完形填空奖励。该模型能够从输入文本中捕捉实体的局部特征和全局交互信息,从而生成高质量的摘要。与图表示相结合,本文引入的多项选择完形填空奖励进一步改进了摘要内容。

3. Grounded Conversation Generation as Guided Traverses in Commonsense Knowledge Graphs

论文地址:https://arxiv.org/pdf/1911.02707v2.pdf

本文是清华大学刘知远老师组与来自于布朗大学、微软的研究人员共同完成的。本文主要关注知识图谱在会话生成任务中的应用,具体提出了一种新的会话生成模型:ConceptFlow,它利用常识知识图谱对会话流进行显式建模。通过将会话连接到概念空间,ConceptFlow 将潜在的会话流表示为沿常识关系在概念空间中的遍历。在概念图中,以图注意力为导向,在概念空间中向更有意义的方向移动,以产生更具语义性和包含更多信息量的会话回答。

随着语言模型和自然语言理解技术的发展,会话生成任务获得了广泛的应用。然而,生成模型可能会产生枯燥和重复的内容,在会话助手应用中,这会导致生成离题和无用的回答,从而损害用户体验。解决这一问题的有效方法是与外部知识(如开放领域知识图谱、常识知识库或背景文档)进行对话。然而,人类的对话并不是「静止的」——人们在谈论一组相关概念的时候,经常会将讨论从一个概念转移到另一个概念,并且可能会完全切换对话主题。

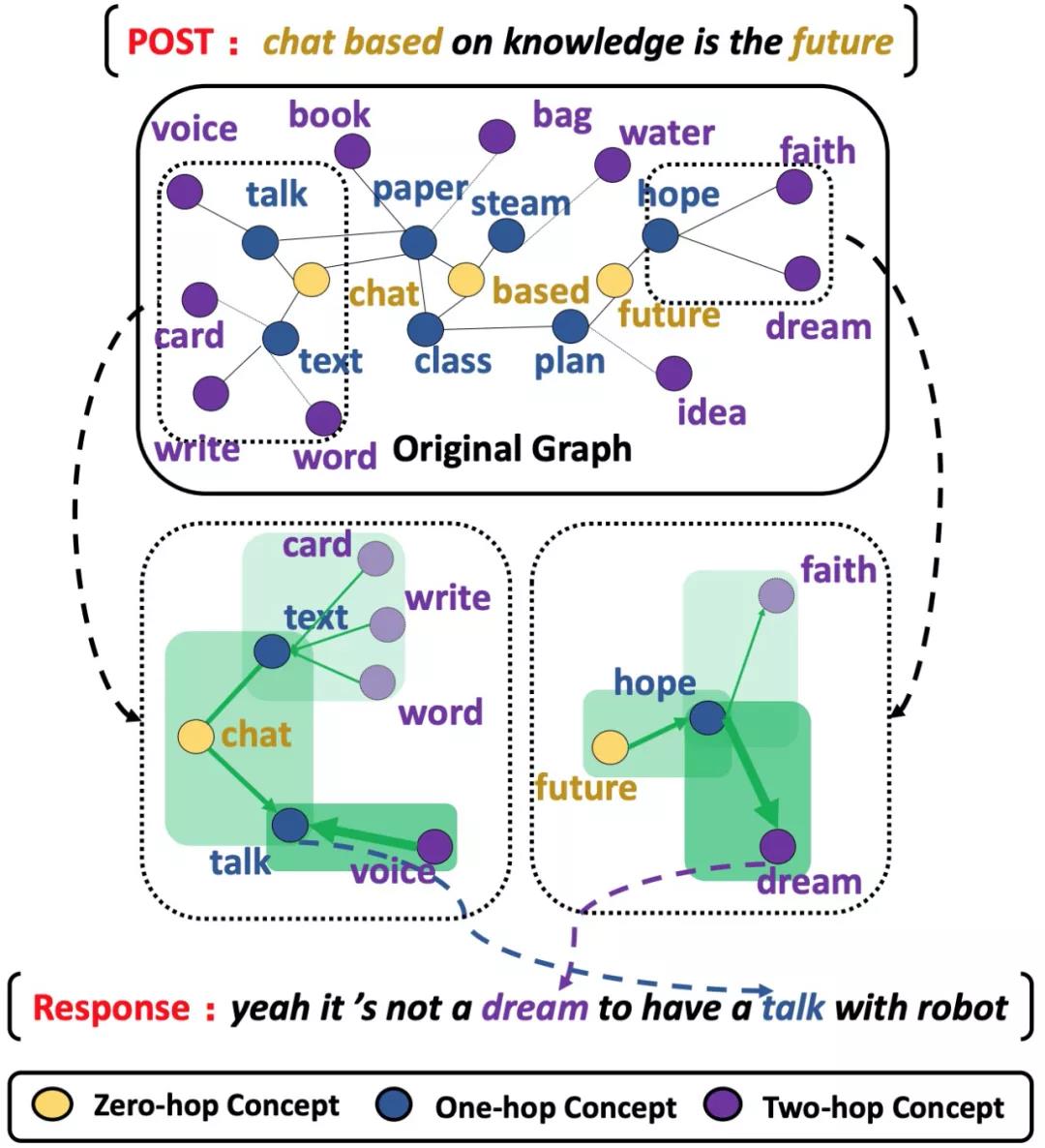

本文提出了概念流(Conversation Generation with Concept Flow,ConceptFlow),它利用常识知识图谱在显式概念空间中对会话流进行建模。例如,如图 1 所示,Reddit 的对话概念从聊天(chat)和未来(future)转移到相邻的概念——对话(talk),还沿着常识关系跳跃到遥远的概念——梦(dream),这是自然对话中的一种非常典型的情况。为了更好地捕捉这种对话结构,ConceptFlow 明确地将会话建模为常识知识图谱中的遍历:它从基础概念(如聊天(chat)和未来(future))开始,并通过沿着常识关系跳转到相关概念(如谈话(talk)和梦想(dream)),从而生成更有意义的对话。概念图中的遍历由 ConceptFlow 的图注意机制引导,通过图神经网络学习,利用会话话语、连接的概念以及它们之间的关系来关注更合适的概念。因此,模型学习在常识知识图中沿着更有意义的关系来建模会话发展。因此,ConceptFlow 学会了通过从会话话语、常识关系跳到更遥远但仍然有意义的概念,来「扩大」基础概念——这将引导生成器能够生成包含更多信息性和更具主题相关性的回答。

图 1. 对话中概念转变的示例。深绿色表示更高的相关性,更宽的箭头表示更强烈的概念转换(由 ConceptFlow 捕获)。

3.1 方法介绍

3.1.1 对话任务构建

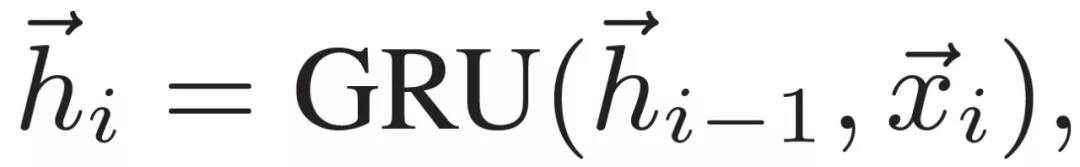

给定一个具有 m 个单词的用户话语 X={x_1;...;x_m},典型的会话生成模型通常使用编解码器架构来生成回答 Y={y_1;...;y_n}。编码器将用户话语 X 表示为表示集 H={h1;...;h_m}。使用门控循环单元(GRU)完成:

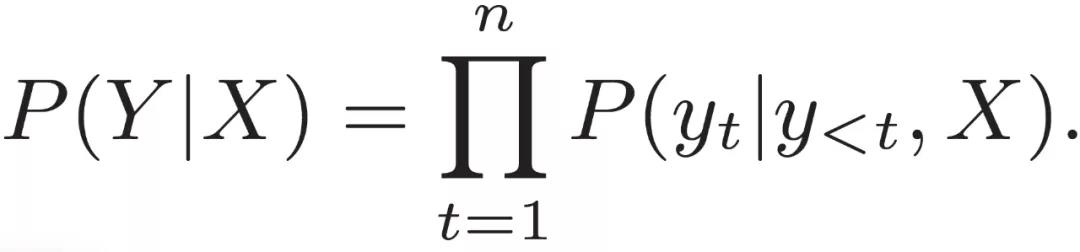

其中,x_i→ 为单词 x_i 的嵌入。解码器根据先前的 t-1 个生成的单词和用户话语 X 生成回答中的第 t 个字:

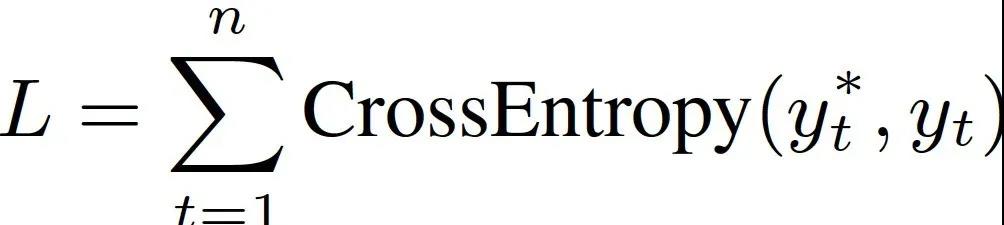

然后将交叉熵损失 L 最小化,并端到端优化所有参数:

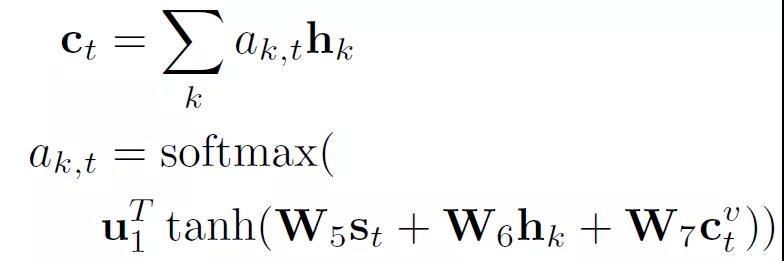

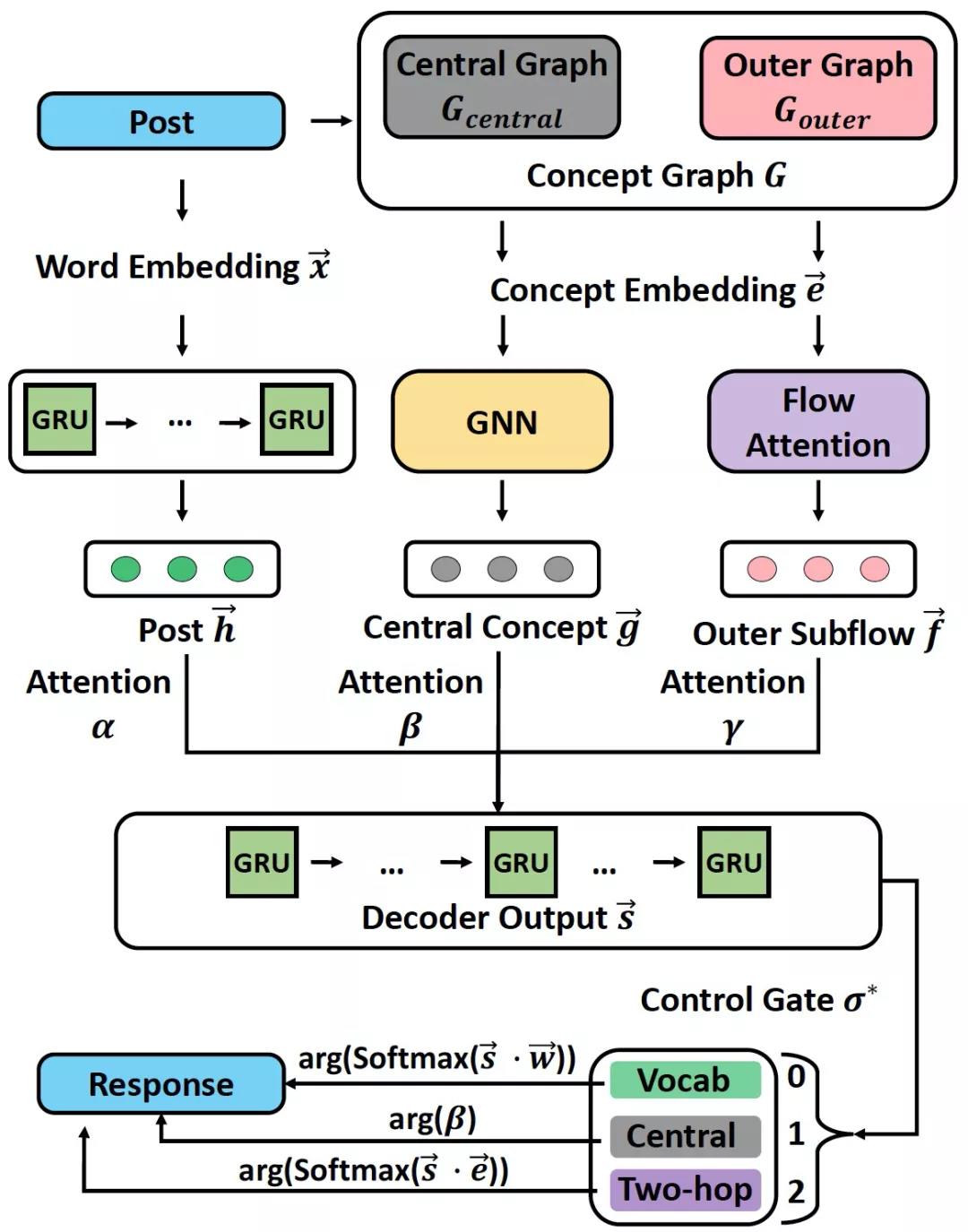

图 2 给出 ConceptFlow 的整体结构。ConceptFlow 首先根据与真实概念之间的距离(hops)构造一个概念图 G,包括中心图 G_central 和外部图 G_outer(3.1.2 小节)。然后利用图神经网络和概念嵌入技术,将中心和外部 ConceptFlow 编码到中心图 G_central 和外部图 G_outer 中(3.1.3 小节)。解码器模块利用 ConceptFlow 和用户话语的编码来生成用于回答的单词或概念(3.1.4 小节)。

图 2. ConceptFlow 整体架构

3.1.2 概念图构造(Concept Graph Construction)

概念图从固定概念(零跳概念(zero-hop):V^0)开始,这些概念出现在会话话语中,并由实体链接系统进行标注。然后,ConceptFlow 用一跳概念(one-hop)v^1 和两跳概念(two-hop)v^2 扩大零跳概念 v^0。v^0 和 v^1 中的概念以及它们之间的所有关系构成了中心概念图 G_central,它与当前的会话主题密切相关。v^1 和 v^2 中的概念及其连接构成了外部图 G_outer。

3.1.3 编码潜在概念流(Encoding Latent Concept Flow)

构造的概念图提供了关于概念如何与常识知识相关的明确语义。ConceptFlow 利用它来建模对话并指导生成回答。它从用户发布开始,经过中心图 G_central 和外部图 G_outer。这一步骤是通过根据用户话语对中心和外部 ConceptFlow 进行编码来实现的。

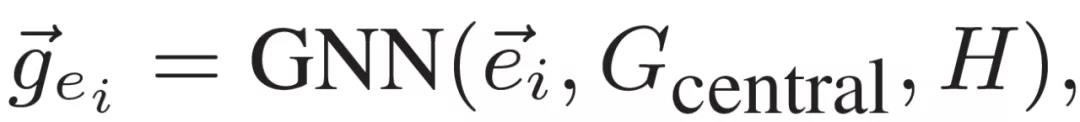

中心流编码(Central Flow Encoding)。中心概念图 G_central 由一个图神经网络编码,该网络将用户话语 H 的信息传播到中心概念图。具体而言,它将概念 e_i 编码生成表示 g_ei:

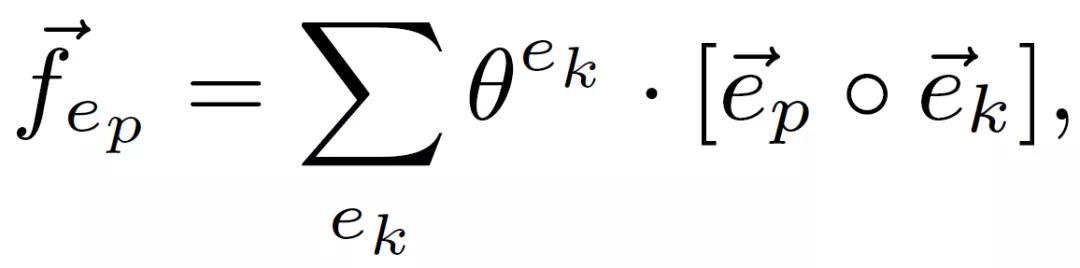

外部流编码(Outer Flow Encoding)。外部流 f_ep 从 e_p 跳转到其连接的两跳概念 e_k,通过注意机制编码生成 f_ep→:

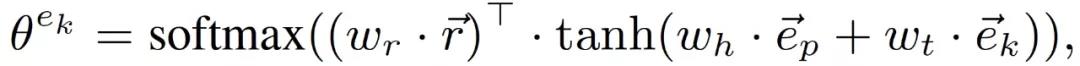

注意力 θ^(e_k) 聚合概念三元组 (e_p,r,e_k) 以得到 f_ep→:

3.1.4 用概念生成文本(Generating Text with Concepts)

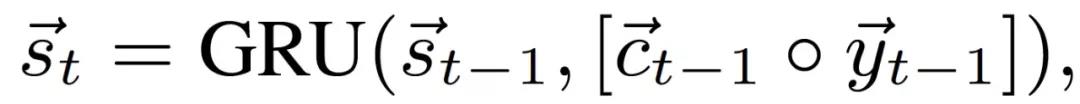

为了生成第 t 个时刻的回答符号,首先根据话语编码和潜在 ConceptFlow 计算 t 次解码的输出上下文表示:

式中,y_t-1→ 是第(t-1)步生成的符号 y_t-1 的嵌入,上下文表示 c_t-1→ 连接基于文本的表示 c_(t-1)^text→ 和基于概念的表示 c_(t-1)^concept->:

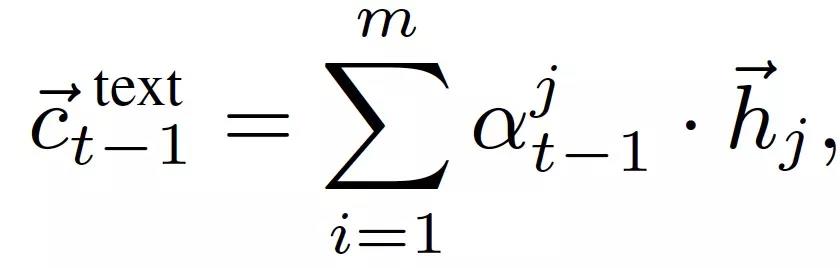

基于文本的表示 c_(t-1)^text→ 以标准的注意机制读取用户的话语编码:

基于概念的表示 c_(t-1)^concept→是中心和外部流的编码组合

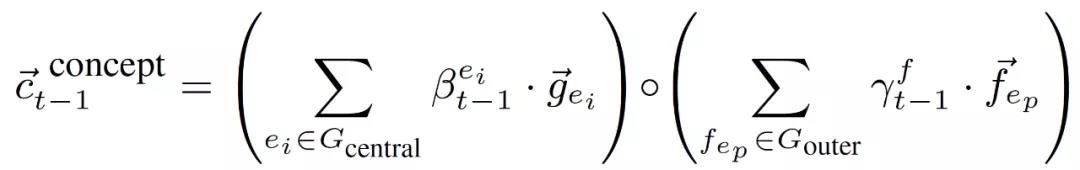

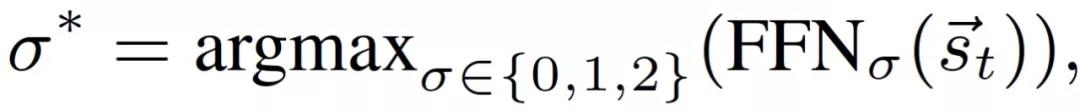

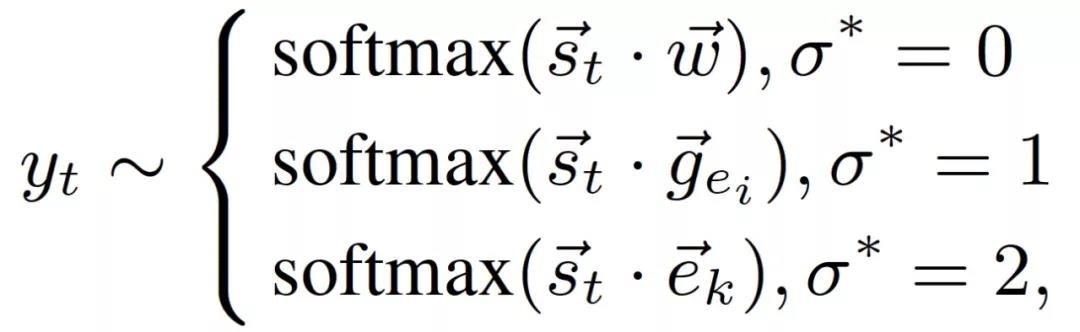

第 t 次输出表示 s_t→包含了来自话语文本、具有不同跳步的概念及其注意机制的信息。解码器利用 s_t→生成第 t 个符号,以形成包含更多信息量的回答。它通过选择单词( σ*=0)、中心概念(V^0,1,σ* =1)和外部概念集(V^2,σ*=2)使用门 σ* 来控制生成:

在词汇表、中心概念集 V^0,1 和外部概念集 V^2 上计算单词 w、中心概念 e_i 和外部概念 e_k 的生成概率:

3.2 实验分析

本文实验使用的是常识会话数据集(Commonsense Conversation Dataset)[10]。该数据集中包含的数据来自于 Reddit 的单轮对话。该数据集共包含 3384185 个训练对、10000 个验证对和 20000 个测试对。本文使用概念网(Concept-Net)作为知识图谱[11]。Concept-Net 包含 120850 个三元组、21471 个概念和 44 个关系类型。对于 Reddit 上的对话,中心概念和两跳概念的平均数量分别为 98.6 和 782.2。

作者选择了六个基线对比算法,这些算法主要属于三类:标准 Seq2Seq、知识增强型系统和微调的 GPT-2 系统。具体包括:Seq2Seq(语言生成任务的最基本的编解码器模型)、知识增强型系统(MenmNet、CopyNet、CCM)、微调的 GPT-2 系统(用于语言生成任务的基本预训练模型 GPT-2 的两种微调:像语言模型一样进行训练的 GPT-2 lang 和用编解码器架构扩展并使用回答数据监控的 GPT-2conv)。此外,本文分别使用 TransE 嵌入和 Glow 嵌入初始化概念表示和单词表示。采用学习率为 0.0001 的 Adam 优化器训练模型。

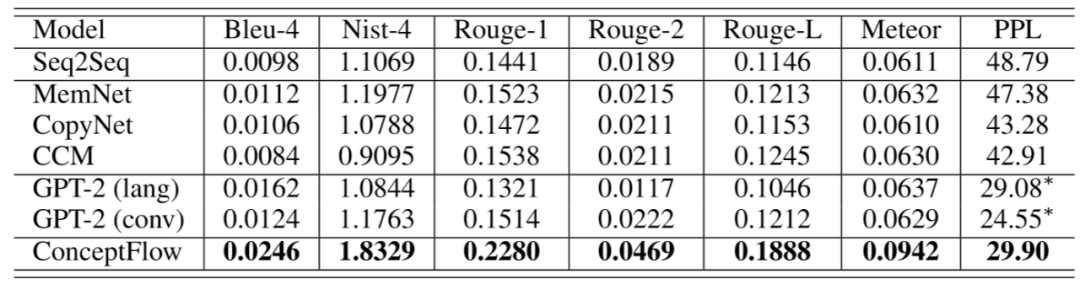

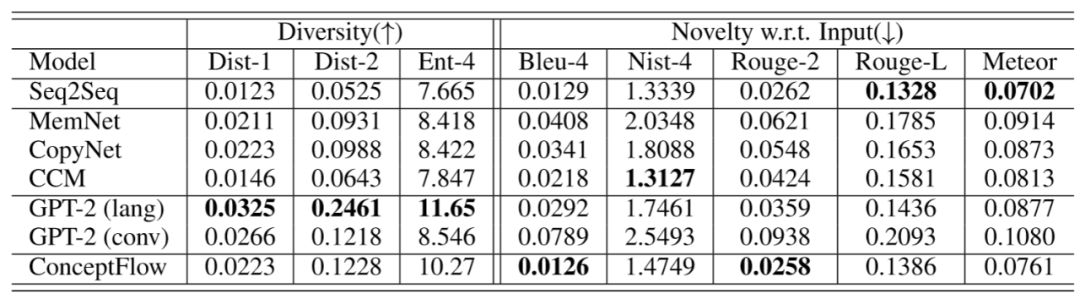

作者使用不同指标从相关性、多样性和新颖性三个方面对生成的对话的回答质量进行评价。表 1 和表 2 给出实验结果。在表 1 中,所有评估指标都用于计算生成的回答和标准回答之间的相关性。ConceptFlow 优于所有基线模型。ConceptFlow 生成的回答更具主题相关性,与基本事实回答更吻合。表 2 中 Dist-1、Dist-2 和 ENT-4 用于衡量所生成回答的多样性,其余指标则是通过将生成的回答与用户的话语进行比较来衡量其新颖性。ConceptFlow 所生成的回答在新颖性和多样性方面都获得了较好的效果。GPT-2 生成的回答更具有多样性,这可能是由它在解码过程中的采样机制所导致的。但是,与 ConceptFlow 相比,GPT-2 生成的回答的新颖性和主题相关性要差一些。

表 1. 生成的回答与标准回答之间的相关性

表 2. 所生成的回答的多样性(越高越好)和新颖性(越低越好)。根据生成的回答中计算多样性;新颖性则是将生成的回答与输入的内容进行比较。

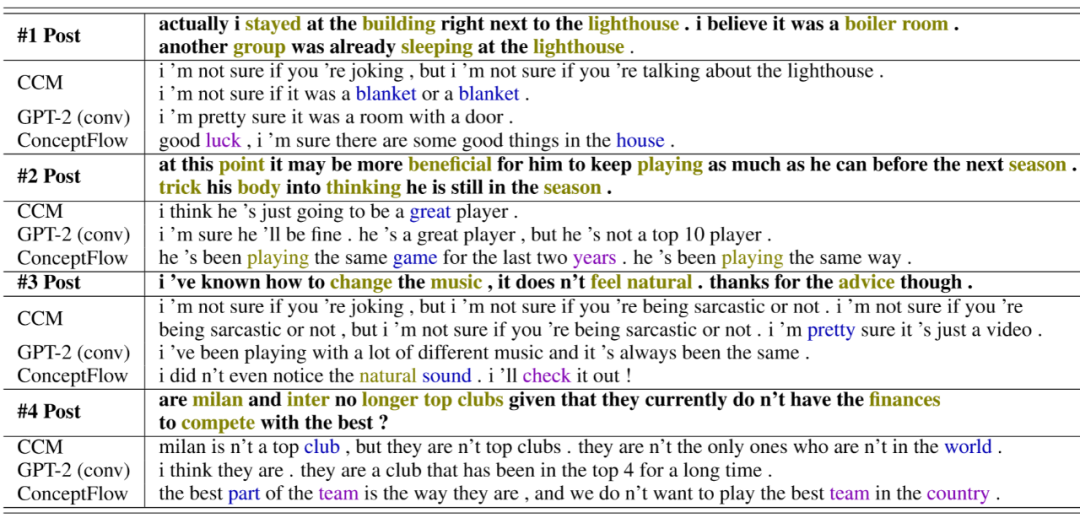

表 3 列出了从三种对话模型生成的一些回答实例。其中,CCM 生成的回答可能会不断重复相同的内容,因为它没有在概念空间中显式地建模遍历。例如,第一个和第三个案例的回答总是重复「我不确定」。GPT-2 能够生成更为流利和顺畅的回答。然而,表 3 中一些 GPT-2 生成的答案案例仅仅是从给定的帖子中复制内容或概念。例如,对于第三种情况,GPT-2(conv)主要讨论概念音乐。相比之下,ConceptFlow 生成的回答比 CCM 和 GPT-2 生成的回答更流畅、更具信息量。例如,在第三种情况下,ConceptFlow 将相关的概念声音(sound)和检查(check)引入到了回答生成中,从而能够从固定的概念音乐(music)和建议(advice)中跳脱出来。引入这些多跳概念有效地提高了所生成回答的信息主题相关性和多样性。

表 3. 不同的模型生成的回答实例,其中,零概念,一跳概念和两跳概念的符号做了突出显示。

3.3 文章小结

本文提出的 ConceptFlow 将会话结构显式地建模为潜在概念空间中的转换,从而能够生成具有更多信息量和更有意义的回答。未来的工作中,作者计划探索如何将多跳概念与预先训练的深层语言模型(即 GPT-2)相结合,以及如何有效地在生成模型中引入更多的多跳概念。

参考文献

[1] Quan Wang, Zhendong Mao, Bin Wang, and Li Guo. Knowledge graph embedding: A survey of approaches and applications. TKDE, 29:2724–2743.[2] Antoine Bordes, Nicolas Usunier, Alberto Garcia-Duran, Jason Weston, and Oksana Yakhnenko. Translating embeddings for modeling multirelational data. In NeurIPS.[3] Zhiqing Sun, Zhi-Hong Deng, Jing Nie, and Jian Tang. Rotate: Knowledge graph embedding by relational rotation in complex space. In ICLR.[4] Christopher D. Manning, Mihai Surdeanu, John Bauer, Jenny Finkel, Steven J. Bethard, and David Mc-Closky. 2014. The Stanford CoreNLP natural language processing toolkit. In Association for Computational Linguistics (ACL) System Demonstrations, pages 55–60.[5] Gabor Angeli, Melvin Jose Johnson Premkumar, and Christopher D. Manning. 2015. Leveraging linguistic structure for open domain information extraction. In Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), pages 344–354, Beijing, China. Association for Computational Linguistics.[6] Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen, Omer Levy, Mike Lewis, Luke Zettlemoyer, and Veselin Stoyanov. 2019.[7] Petar Veliˇckovi´c, Guillem Cucurull, Arantxa Casanova, Adriana Romero, Pietro Li`o, and Yoshua Bengio. 2018. Graph Attention Networks. International Conference on Learning Representations. Accepted as poster.[8] Steven J Rennie, Etienne Marcheret, Youssef Mroueh, Jerret Ross, and Vaibhava Goel. 2017. Self-critical sequence training for image captioning. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 7008–7024.[9] Chin-Yew Lin and Eduard Hovy. 2003. Automatic Evaluation of Summaries Using N-gram Cooccurrence Statistics. In Proceedings of the 2003 Conference of the North American Chapter of the Association for Computational Linguistics on Human Language Technology - Volume 1, pages 71–78.[10] Hao Zhou, Tom Young, Minlie Huang, Haizhou Zhao, Jingfang Xu, and Xiaoyan Zhu. 2018a. Commonsenseknowledge aware conversation generation with graph attention. In IJCAI, pages 4623–4629.[11] Robyn Speer, Joshua Chin, and Catherine Havasi. 2017. Conceptnet 5.5: An open multilingual graph of generalknowledge.[12] Kristina Toutanova and Danqi Chen. 2015. Observed versus latent features for knowledge base and text inference. In Proceedings of the 3rd Workshop on Continuous Vector Space Models and their Compositionality.[13] Antoine Bordes, Sumit Chopra, and Jason Weston. 2014. Question answering with subgraph embeddings. In EMNLP.[14] Andrew M. Saxe, James L. McClelland, and Surya Ganguli. 2013. Exact solutions to the nonlinear dynamics of learning in deep linear neural networks. In ICLR.

分析师介绍:

本文作者为仵冀颖,工学博士,毕业于北京交通大学,曾分别于香港中文大学和香港科技大学担任助理研究员和研究助理,现从事电子政务领域信息化新技术研究工作。主要研究方向为模式识别、计算机视觉,爱好科研,希望能保持学习、不断进步。

关于机器之心全球分析师网络 Synced Global Analyst Network

机器之心全球分析师网络是由机器之心发起的全球性人工智能专业知识共享网络。在过去的四年里,已有数百名来自全球各地的 AI 领域专业学生学者、工程专家、业务专家,利用自己的学业工作之余的闲暇时间,通过线上分享、专栏解读、知识库构建、报告发布、评测及项目咨询等形式与全球 AI 社区共享自己的研究思路、工程经验及行业洞察等专业知识,并从中获得了自身的能力成长、经验积累及职业发展。