损失函数在机器学习和深度学习中扮演着至关重要的角色,它的主要作用包括:

衡量预测误差:损失函数是评估模型预测输出与实际观测目标值之间差异的一种量化方式。它将模型预测的结果映射到一个非负实数上,这个数值反映了预测错误的程度。当模型的预测越接近真实值时,损失函数的值就越小。

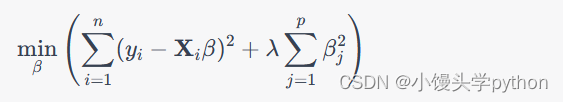

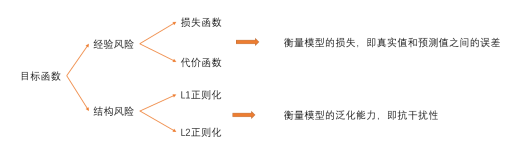

优化目标:在训练模型的过程中,损失函数被当作优化算法的目标函数。模型参数通过反向传播算法和梯度下降等优化方法来调整,目的是最小化整个训练数据集上的平均损失,即最小化经验风险。

模型性能评估:损失函数提供了评价模型好坏的标准。训练结束后,通过测试集上的损失值可以判断模型的泛化能力,也就是模型在未见过的新数据上的预测表现。

模型选择和比较:不同的任务和模型可能需要不同的损失函数。在设计和训练模型时,选择合适的损失函数是至关重要的,这有助于优化模型针对特定问题的表现,并可以在不同模型之间进行公正有效的比较。

常见的损失函数包括但不限于以下几种:

均方误差(Mean Squared Error, MSE):广泛应用于回归问题中,计算预测值与真实值之间的平方误差平均值,对较大的误差惩罚更大。

均方根误差(Root Mean Squared Error, RMSE):是MSE的平方根,也是回归问题中常用的,但它给出的是误差的标准偏差形式,便于直观理解。

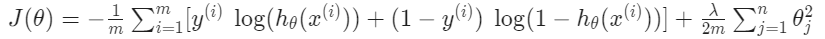

交叉熵损失(Cross-Entropy Loss):主要用于分类问题,尤其是多类别分类和逻辑回归中,也称为二元交叉熵损失(Binary Cross-Entropy)或softmax交叉熵损失(Softmax Cross-Entropy)。

绝对误差(Mean Absolute Error, MAE):也是一种回归损失函数,计算预测值与真实值之间绝对误差的平均值,相比MSE对异常值不敏感。

hinge 损失(Hinge Loss):主要用于最大间隔分类,如支持向量机(SVMs)。

0-1损失(0-1 Loss):在分类问题中最理想的情况是预测完全正确,此时损失为0,否则损失为1,但在实际优化中因其非凸、非连续性不易直接使用,常作为理论上的最优损失。

对数似然损失(Log-Likelihood Loss):在概率模型中常用,尤其是在朴素贝叶斯分类和条件随机场等生成模型中。

Focal Loss:为了应对类别不平衡问题而设计,尤其在目标检测中得到广泛应用。

每种损失函数都有其应用场景和优缺点,选择时需综合考虑模型的性质、数据分布特征以及优化难度等因素。