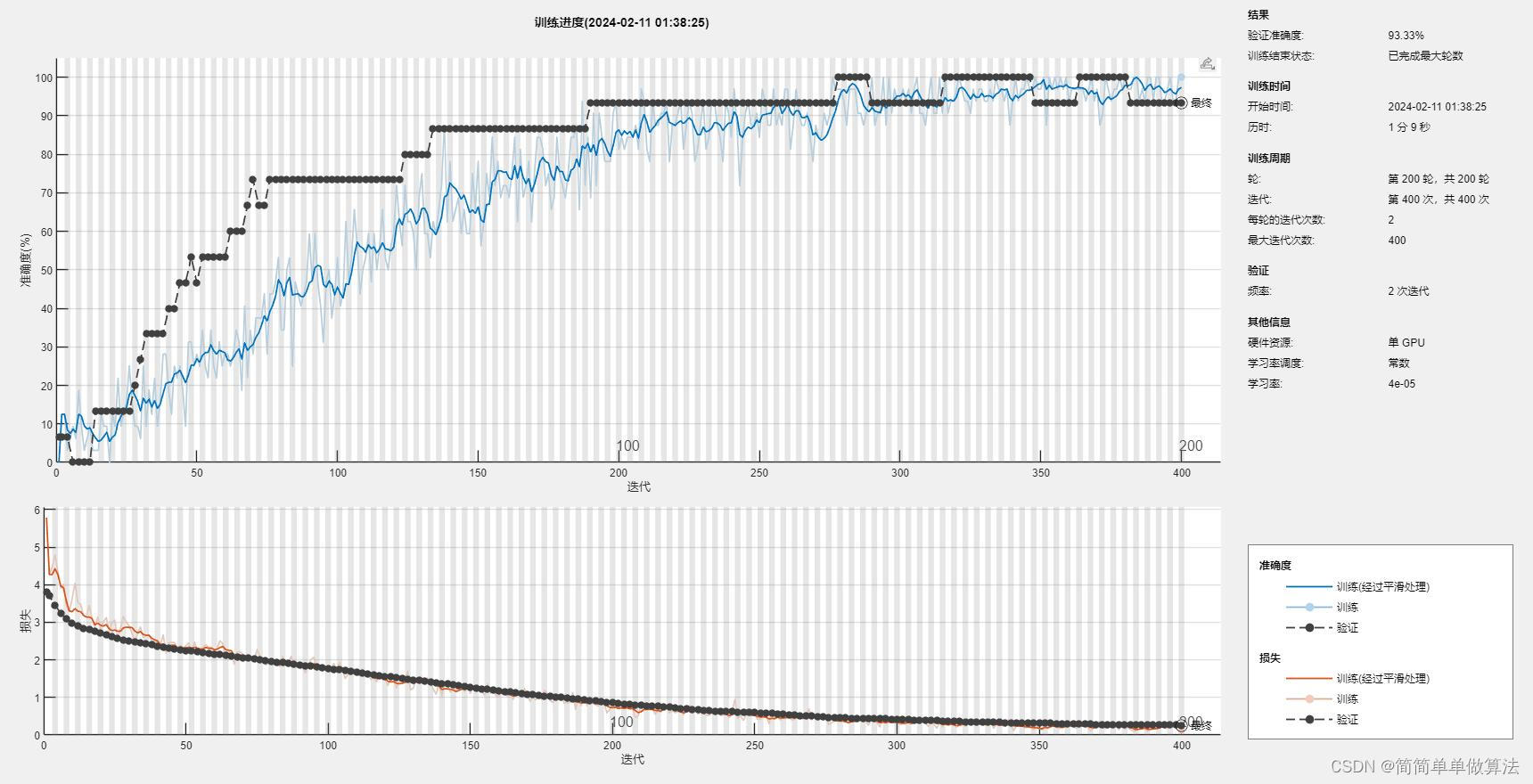

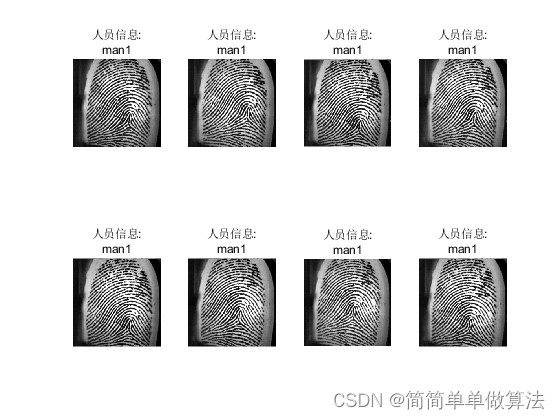

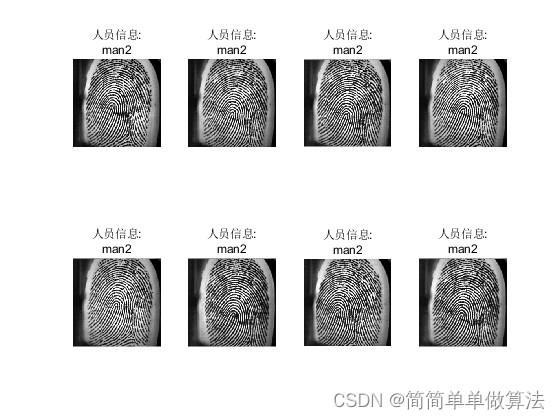

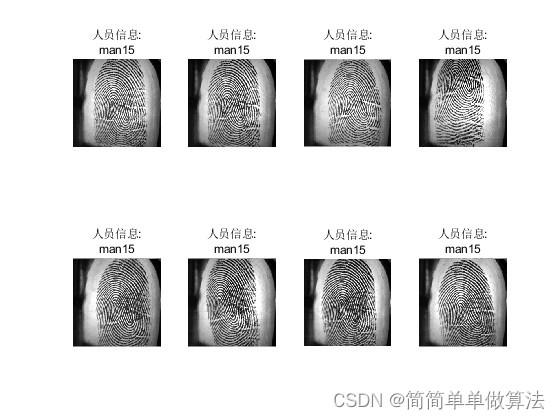

1.算法运行效果图预览

2.算法运行软件版本

matlab2022a

3.算法理论概述

指纹识别技术是一种生物特征识别技术,它通过分析人类手指末端皮肤表面的纹路特征来进行身份认证。深度学习是机器学习的一个分支,特别适用于处理大规模高维数据,并在图像识别、语音识别等领域取得了显著成果。

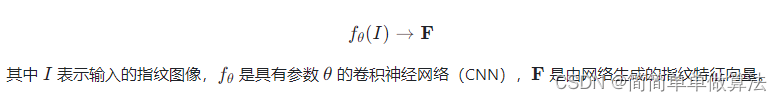

3.1 指纹图像预处理与特征提取

首先,指纹图像需要经过一系列预处理步骤,包括灰度化、二值化、细化、去噪声等,以得到清晰的指纹脊线图。然后,传统方法中通常使用 minutiae 特征(如端点、分叉点)作为关键特征进行提取。而在深度学习框架下,神经网络能够直接从原始或预处理后的指纹图像中自动生成高级抽象特征:

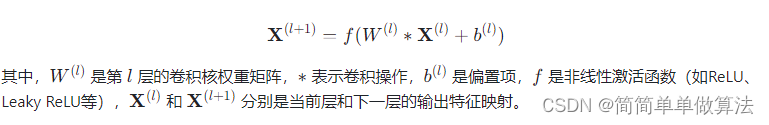

3.2 卷积神经网络架构

一个典型的用于指纹识别的深度学习模型可能包含多个卷积层(Convolutional Layer)、池化层(Pooling Layer)、归一化层(Normalization Layer)以及全连接层(Fully Connected Layer)。卷积层通过对图像进行滤波操作来提取局部特征:

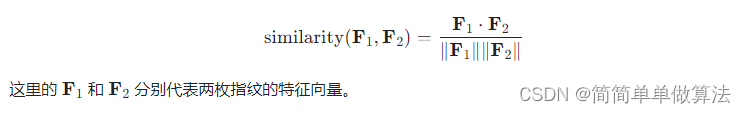

3.3 特征编码与匹配

深度学习指纹识别的核心在于利用网络自动学习到的特征进行身份比对。网络的最后几层通常会形成一个紧凑且可比对的特征向量。对于两个指纹图像,其对应的特征向量可以计算相似度得分,如余弦相似度:

3.4 损失函数与训练

为了训练这样的网络,通常会选择一种适合监督学习任务的损失函数,例如 triplet loss 或者交叉熵损失。对于一对正样本(同一人的不同指纹)和负样本(不同人的指纹),triplet loss 可以表述为:

通过梯度下降或其他优化算法调整网络参数θ ,使得相同个体的指纹特征尽可能接近,而不同个体的指纹特征尽可能远离。

4.部分核心程序

clear;

close all;

warning off;

addpath(genpath(pwd));

rng('default')

load gnet.mat% 载入预训练的GoogLeNet模型

for ij = 1:15

Dataset=[];

% 创建图像数据存储对象,包括图像文件夹,标签等信息

Dataset = imageDatastore(['dataset\man',num2str(ij),'\'], 'IncludeSubfolders', true, 'LabelSource', 'foldernames');

Dataset.ReadFcn = @(loc)imresize(imread(loc),[224,224]);% 设置 im 的读取函数,将读取的图像进行缩放,大小为 [224,224]

% 对测试集进行分类预测

[Predicted_Label, Probability] = classify(net, Dataset);

% 计算分类准确率

accuracy = mean(Predicted_Label == Dataset.Labels);

accuracy

figure

for i = 1:8

subplot(2,4,i)

I = readimage(Dataset, i);% 从测试数据集中读取图像

imshow(I)% 预测的标签

label = Predicted_Label(i);

title(['人员信息:',label]);

end

end