- Q和V 之间的关系:

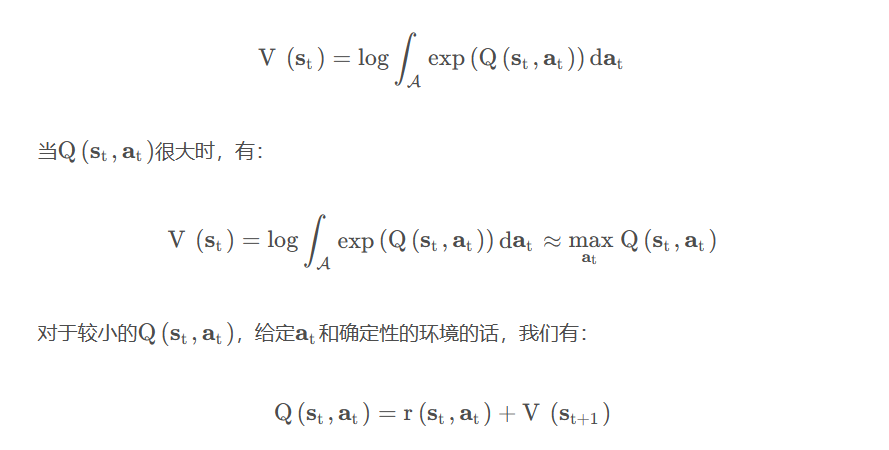

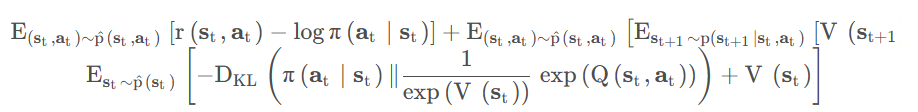

到这我们已经得到了策略,更进一步我们考虑Q 和V 之间的关系。考虑对动作空间下的边缘概率分布积分有:

但是往往环境是随机的,所以我们有:

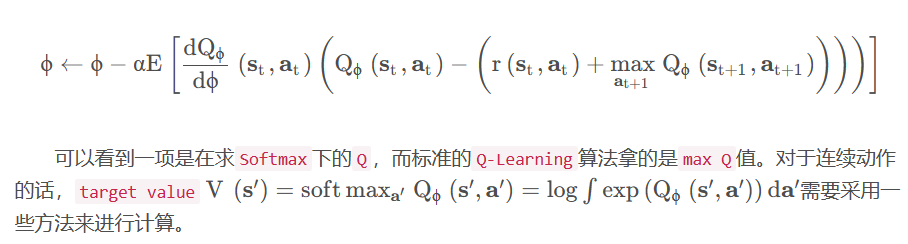

上述的这个反向传播值函数是很特别的,与以往的Q 值函数更新公式不同的地方在于,对于未来状态的状态值函数做了一个softmax这样的东西,这就使得不会突出考虑最大的那个值函数,也能够增加更多的探索。对于随机环境来说会有比较好的效果。

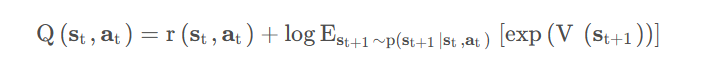

隐目标函数下的最大熵强化学习

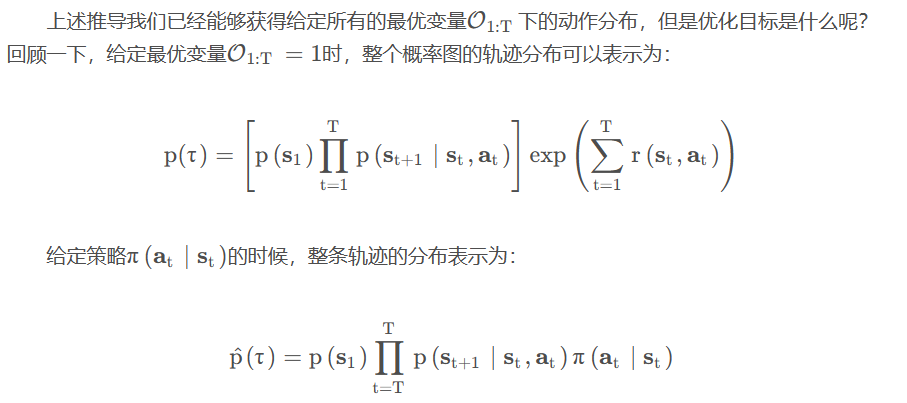

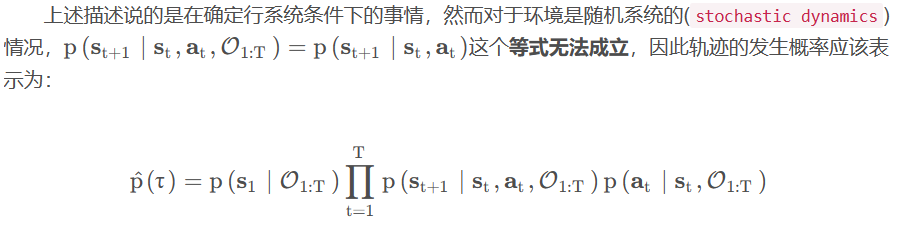

优化目标为这两者的KL散度:

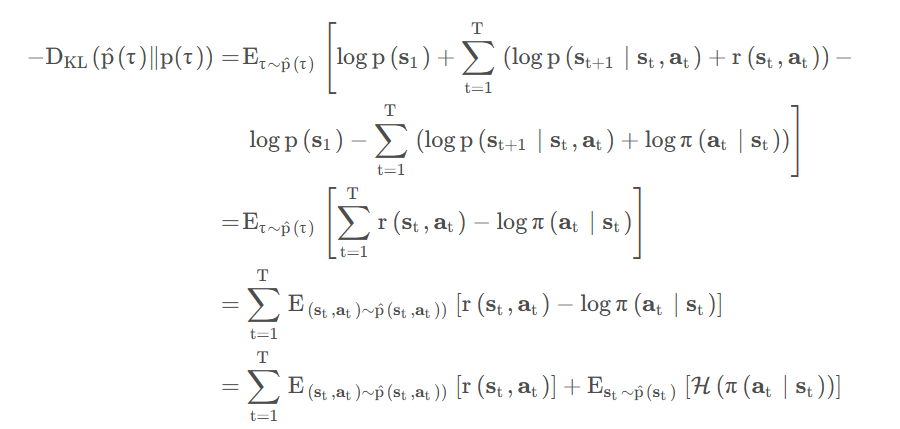

两边取负号,并将其展开可得:

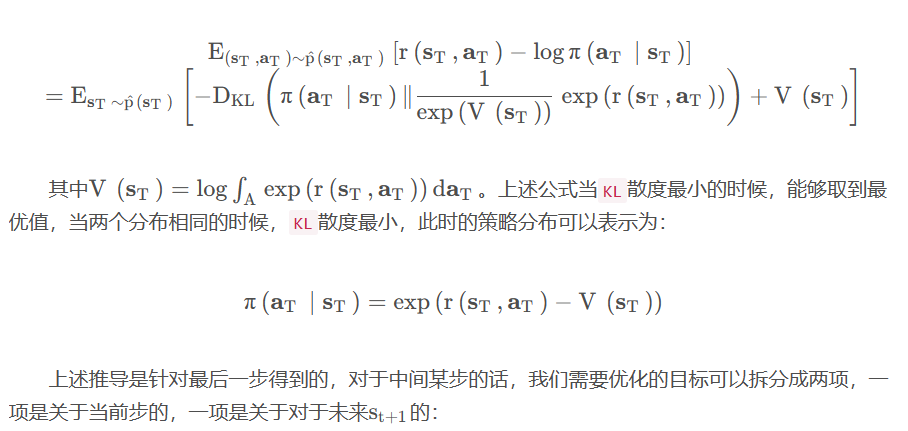

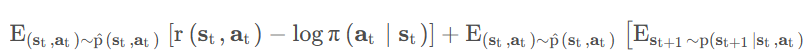

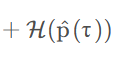

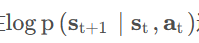

此时最小化KL散度变成了最大化期望奖励和策略的熵。对于最后一步T TT,把末尾项展开,把策略扔到计算期望的函数里面,可以得到如下形式:

整理可得:

可以看出,基于图概率下的策略搜索和基于变分推断做KL散度得到的策略结果是一样的。这也充分说明之前做的police inference就是在解决这个潜在目标函数下的优化问题。

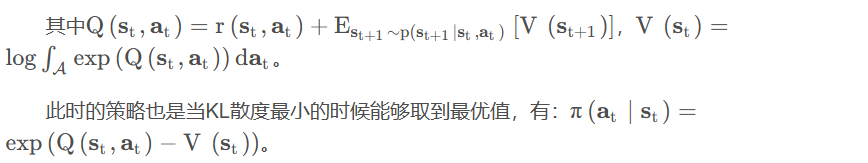

随机环境下的优化

此时的KL散度优化目标可以写为:

由于存在这一项,在无模型的设定里,这一项是比较难优化的。

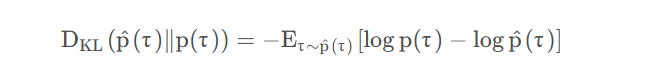

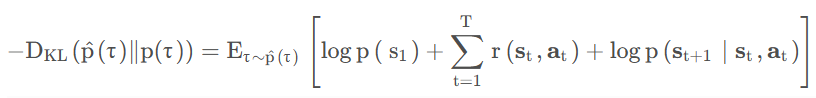

最大熵强化学习与变分推断

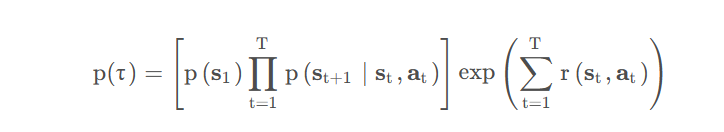

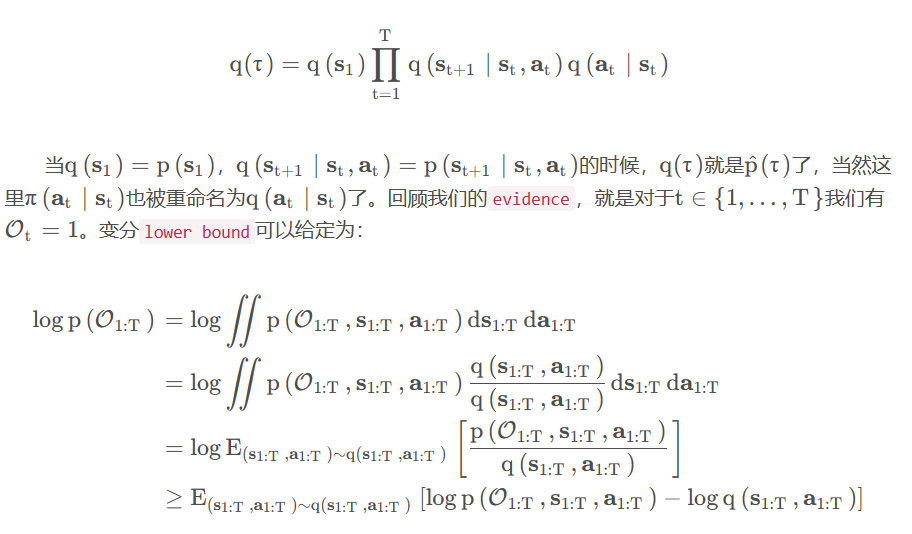

变分推断是用一个简单的变分分布去近似后验分布,在最大熵RL里面的轨迹概率为:

这里我们将需要去近似这个分布的概率设置为:

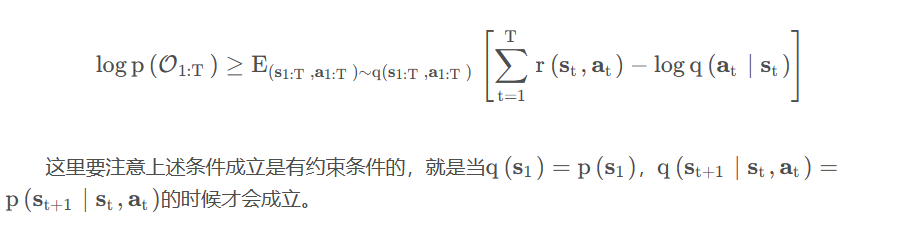

最后一个不等式是通过Jensen’s inequality推导得到的。再依据p ( τ ) 和q ( τ )的定义,带入上述方程中,我们可以得到如下不等式:

上述用图模型思考强化学习问题的时候,目标函数会带一个entropy项。

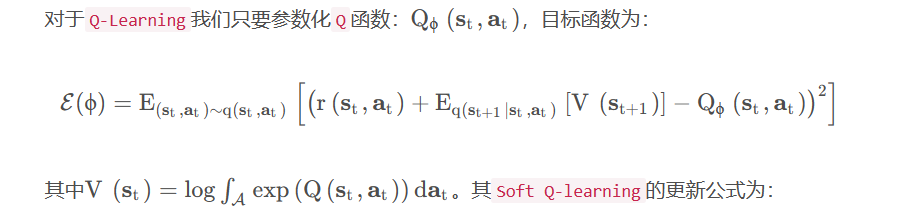

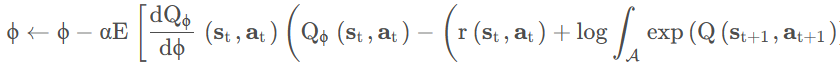

Soft Q-Learning

为了与标准的Q-Learning算法对比,我们给出标准的Q-Learning算法的更新公式:

- Liu Q , Wang D . Stein Variational Gradient Descent: A General Purpose Bayesian Inference Algorithm[C]// 2016.

- Haarnoja, T., Tang, H., Abbeel, P., and Levine, S. (2017). Reinforcement learning with deep energy- based policies. In International Conference on Machine Learning (ICML).

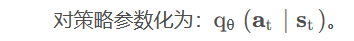

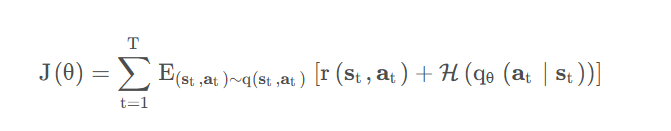

最大熵策略梯度

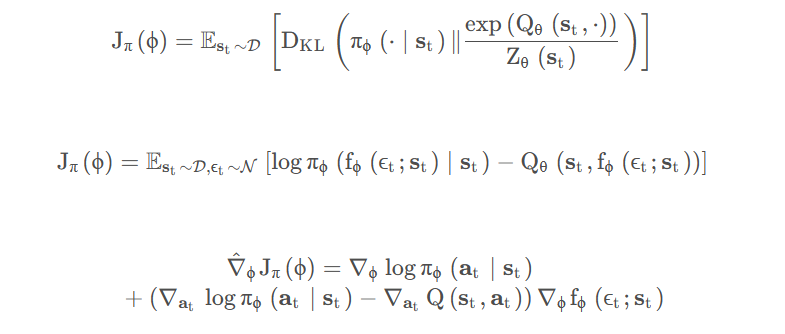

目标函数可以定义为:

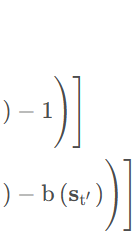

对其求梯度有:

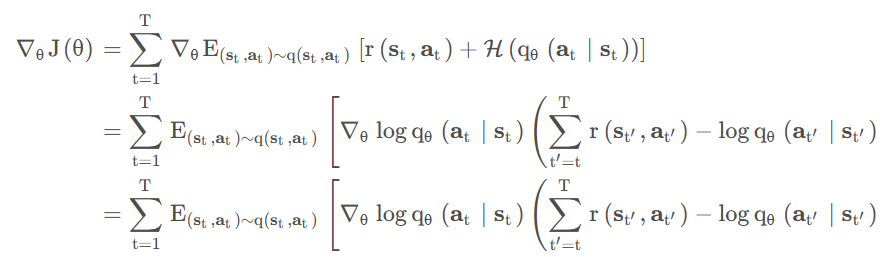

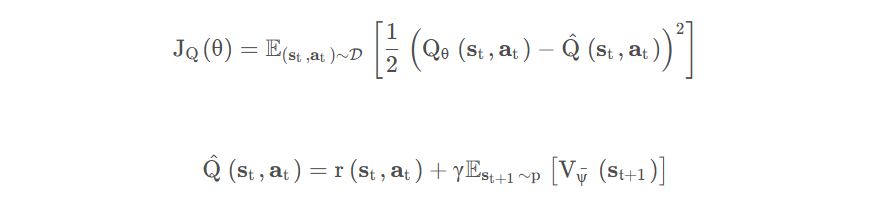

Soft Actor-Critic

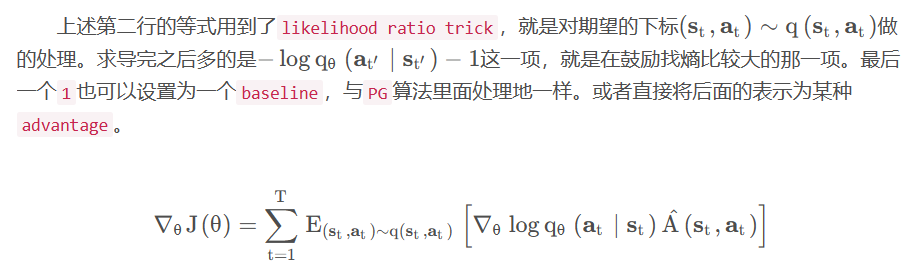

SAC就是将优势函数也进行参数化,变成一个off-policy的算法。优化目标为:

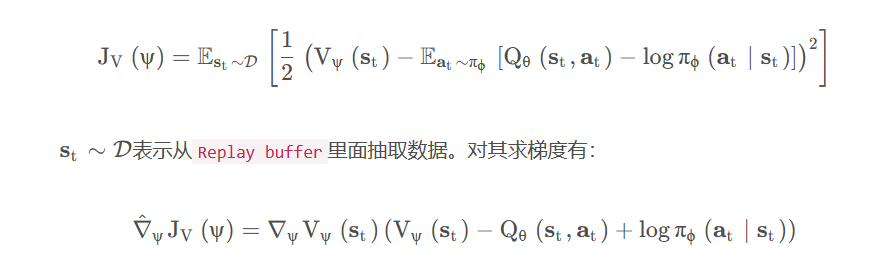

对Q 值函数一样,有:

对其求导有:

策略优化目标为:

伪代码:

参考文献

- Pattern recognition and machine learning by Bishop 2006

- Levine, S., 2018. Reinforcement learning and control as probabilistic inference: Tutorial and review. arXiv preprint arXiv:1805.00909

- Haarnoja, T., Tang, H., Abbeel, P., and Levine, S. (2017). Reinforcement learning with deep energy- based policies. In International Conference on Machine Learning (ICML).

- Tuomas Haarnoja*, Aurick Zhou*, Kristian Hartikainen*, George Tucker, Sehoon Ha, Jie Tan, Vikash Kumar, Henry Zhu, Abhishek Gupta, Pieter Abbeel, Sergey Levine. Soft Actor-Critic Algorithms and Applications. arXiv preprint, 2018.

- Kappen. (2009). Optimal control as a graphical model inference problem: frames control as an inference problem in a graphical model

- Ziebart. (2010). Modeling interaction via the principle of maximal causal entropy: connection between soft optimality and maximum entropy modeling.