「Python」Pandas-相关操作

前言:本文主要讲解使用pandas如何读取csv文件;对pandas中的数据类型-Series,DataFrame的基本操作,如:排序,去重,一些基本运算和去重操作;层次化索引以及数据挖掘中热力图的制作。详细请点击目录进行预览。

读取csv

# 如果数据集中有中文的话,最好在里面加上 encoding = 'gbk' ,以避免乱码问题。 # 后面的导出数据的时候也一样 # header-关键字,告诉Pandas哪些是数据的列名。如果没有列名的话就将它设定为 None。 df = pd.read_csv('uk_rain_2014.csv', header=0) df.head(5) # 查看前5行 df.tail(5) # 查看后5行 len(df) # 总行数 df.columns = ['','',..] # 修改列名

数据操作

排序

Series,DataFrame类型的数据用sort_index()按索引排序,sort_values()按值排序。

举个例子🌰:

按索引排序:

# new一个Series obj = Series(range(4), index=['d','a','b','c']) obj.sort_index() Out[74]: a 1 b 2 c 3 d 0 dtype: int64 # reshape 重新指定dataframe的形状大小,即二行四列。 # index指定索引名, column指定列名 frame = DataFrame(np.arange(8).reshape((2,4)),index=['three', 'one'],columns=['d','a','b','c']) Out: d a b c three 0 1 2 3 one 4 5 6 7 # 按索引值排序 frame.sort_index() Out: d a b c one 4 5 6 7 three 0 1 2 3

按值排序:

frame.sort_index(axis=1, ascending=False) ''' help(pd.DataFrame.sort_index) 查看用法 axis 只有两个值 : 0 and 1, df中只有两个index分别是表最左一列的时间和表最上一行的dabc axis=0对应的是对左边一列的index进行排序, ascending=False代表降序,ascending=True代表升序 axis=1对应的是对上边一行的index进行排序, so,res = Out: ----> d c b a three 0 3 2 1 one 4 7 6 5 ''' # 按值排序 frame = DataFrame({'b':[4, 7, -3, 2], 'a':[0, 1, 0, 1]}) frame.sort_values(by='b') #DataFrame必须传一个by参数表示要排序的列 Out[97]: a b 2 0 -3 3 1 2 0 0 4 1 1 7

删除

在pandas中,删除Series的元素或DataFrame的某一行(/列),

使用的是

drop(index, axis=0)删除行

drop(columns, axis=1)删除列。

需要注意的是drop()返回的是一个新对象,原对象不会被改变。

举个例子🌰:

# 三行三列的dataframe,并制定相应的索引和列名 df = DataFrame(np.arange(9).reshape(3,3), index=['a','c','d'], columns=['oh','te','ca']) Out[18]: oh te ca a 0 1 2 c 3 4 5 d 6 7 8 df.drop('a') # 默认删除行 Out[19]: oh te ca c 3 4 5 d 6 7 8 df.drop(['oh','te'],axis=1) # axis = 1删除列 Out[20]: ca a 2 c 5 d 8

基本运算

在DataFrame中的算术运算是df中对应位置的元素的算术运算,如果没有共同的元素,则用NaN代替。

可用fill_value = ?传入填充值

举个例子🌰:

df1 = DataFrame(np.arange(12.).reshape((3,4)),columns=list('abcd')) df2 = DataFrame(np.arange(20.).reshape((4,5)),columns=list('abcde')) df1+df2 # 或者df1.add(df2,fill_value = 0)这里设置的填充值为0 ''' Out[9]: a b c d e 0 0 2 4 6 NaN 1 9 11 13 15 NaN 2 18 20 22 24 NaN 3 NaN NaN NaN NaN NaN '''

dataframe数据类型的其他基本操作:

df.mean() # 算术平均数 df.mode() # 众数 df.median() # 中位数 df.max() # 最大值 df.min() # 最小值 df.std() # 标准差 df.values # 取值 返回二维形式[[]] df.values.flatten() # 二维转化为一维 df.kurt() # 峰度系数 df.skew() # 偏态系数 df.quantile([0.25,0.5,0.75]) # 四分位点

去重

DataFrame的duplicated方法返回一个布尔型Series,表示各行是否是重复行。

使用drop_duplicates()方法可以去除重复的行数。

举个例子🌰:

df = DataFrame({'k1':['one']*3 + ['two']*4, 'k2':[1,1,2,3,3,4,4]}) Out[2]: k1 k2 0 one 1 1 one 1 2 one 2 3 two 3 4 two 3 5 two 4 6 two 4 df.duplicated() # 返回的都是布尔值 Out[3]: 0 False 1 True 2 False 3 False 4 True 5 False 6 True dtype: bool df.drop_duplicates() # 去除重复值 Out[4]: k1 k2 0 one 1 2 one 2 3 two 3 5 two 4

数据处理可能用到的小技巧:

如果需要获取某一列出现的所有值可以使用df['xx'].unique()

加上 .tolist()就可以转变为列表形式。

索引操作

dataframe以及series中的索引操作还是很厉害的。 举个例子🌰:

data = Series(np.random.randn(10), index = [['a', 'a', 'a', 'b', 'b', 'b', 'c', 'c', 'd', 'd' ],[1,2,3,1,2,3,1,2,2,3]]) Out[2]: a 1 0.169239 2 0.689271 3 0.879309 b 1 -0.699176 2 0.260446 3 -0.321751 c 1 0.893105 2 0.757505 d 2 -1.223344 3 -0.802812 # 取某个区间内的所有的行 data['b':'d'] # 取b-d行 Out[3]: b 1 -0.699176 2 0.260446 3 -0.321751 c 1 0.893105 2 0.757505 d 2 -1.223344 3 -0.802812 # 取特定的某一列 data[:, 2] # 每一种index里面的第二个 Out[4]: a 0.689271 b 0.260446 c 0.757505 d -1.223344

取特定行:

data.iloc[:5] # iloc是最内层索引,所以取的是前5个 Out[5]: a 1 0.169239 2 0.689271 3 0.879309 b 1 -0.699176 2 0.260446

data.loc['a'] Out[5]: a 1 0.169239 2 0.689271 3 0.879309

如果有多列可以通过嵌套的方式获取自己想要的列。比如有name、age、sex三列但是只想要其中的name、age,就可以使用data[['name','age']]来实现

Series和DataFrame的转换

# 将Series转化成DataFrame: data.unstack() Out[5]: 1 2 3 a 0.169239 0.689271 0.879309 b -0.699176 0.260446 -0.321751 c 0.893105 0.757505 NaN d NaN -1.223344 -0.802812

数据挖掘

数据过滤

当今,我们拿到的数据往往都不一定是我们需要的,所以对数据进行过滤就显得尤为重要了。那么如何利用Python的方法对数据进行出的预处理(过滤)呢?请往下看👇:

data.select_dtypes(exclude=['object']) # 过滤非数值列 data[col].isnull().any() # 判断这一列是否存在空值数据

接下来补充一下数据分析中可能用到的可视化图像。

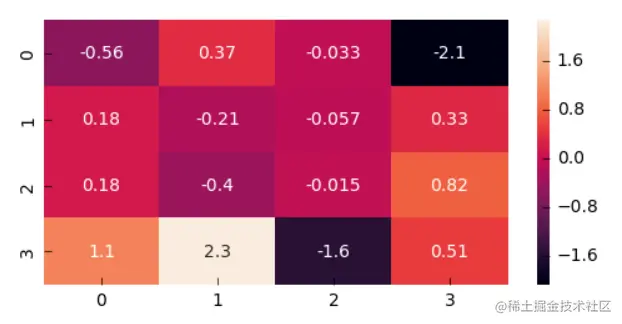

第一个上场的是热力图:

热力图

热力图的作用:可以查看数据特征中两两的相似图情况。能够反映出相关性最高的两个数据特征。

调用方法:

seaborn.heatmap(data, vmin=None, vmax=None, cmap=None, center=None, robust=False, annot=None, fmt='.2g', annot_kws=None,linewidths=0, linecolor='white', cbar=True, cbar_kws=None, cbar_ax=None, square=False, xticklabels='auto', yticklabels='auto',mask=None, ax=None, **kwargs)

参数说明:

- data:矩形数据集。可以是numpy的数组(array),也可以是pandas的DataFrame。

- 如果是DataFrame,则df的index/column信息会分别对应到heatmap的columns和rows,即df.index是热力图的行标,df.columns是热力图的列标

- vmax,vmin:分别是热力图的颜色取值最大和最小范围

- cmap:从数字到色彩空间的映射,取值是matplotlib包里的colormap名称或颜色对象,或者表示颜色的列表

- annot :默认取值False;如果是True,在热力图每个方格写入数据

- fmt:字符串格式代码,矩阵上标识数字的数据格式,比如保留小数点后几位数字

其他相关参数请参照 seaborn中文文档

使用1:关系矩阵 pandas中利用corr()方法可以获得关系矩阵。此时直接利用关系矩阵就可绘制热力图啦~

本次pandas的有关操作暂且更新到这了。