Spark:pyspark的WordCount实现

本次基于pyspark

新建一个data.txt文件用于本次作业

hello this is a spark demo!

welecome to here

a hot day

hot本地读取文件

#读取本地文本文件

lines = sc.textFile("data.txt")

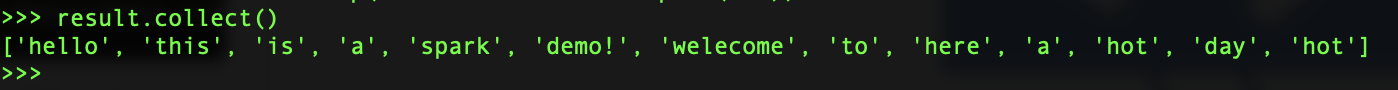

#通过flatMap操作把所有数据转行成rdd,把数据压成一列

result = lines.flatMap(lambda line : line.split(' ')

result.collect()

输出结果如下:

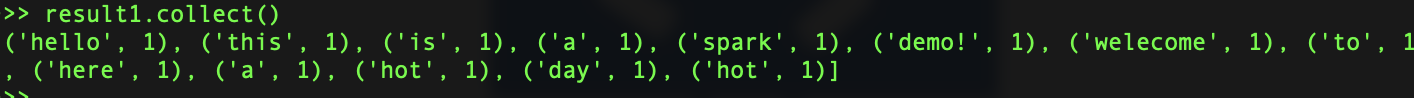

#把每一个元素转化成元组

result1 = result.map(lambda word : (word,1))输出结果如下:

#按key聚合累加

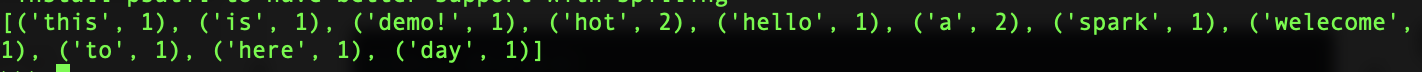

result2 = result1.reduceByKey(lambda a,b:a+b)

result2.collect()

输出结果如下: