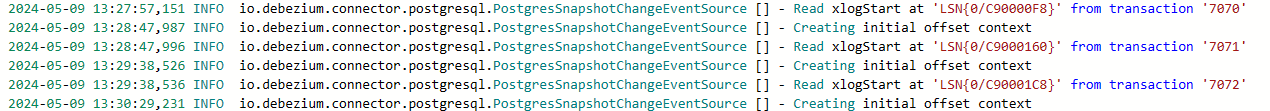

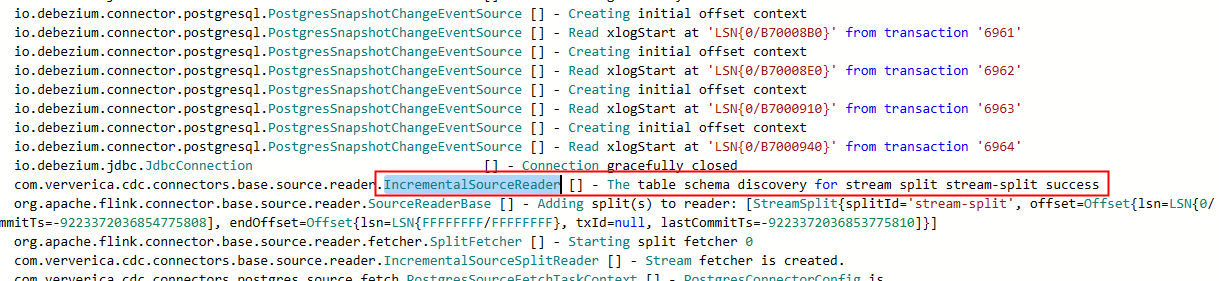

Flink CDC 如果选择一两个表的话, 是没问题的。 多个表的时候, 不知道为啥一直停留在 ,这个阶段,正常一两个表的时候 read xlogstart很快结束了, 然后到The table schema discovery for stream split stream-split success , 是不是多表的时候一直要轮训pg查看元数据?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink CDC 在处理多个表时卡在某个阶段(如 read xlogstart),而单表或少量表时可以正常完成。这种情况可能与 PostgreSQL 的元数据轮询机制、资源限制或配置问题有关。以下是详细分析和解决方案:

Flink CDC 在 PostgreSQL 中通过读取 WAL(Write-Ahead Logging)日志来捕获变更数据。在多表场景下,Flink CDC 需要对每个表进行元数据发现(Schema Discovery),这可能导致频繁轮询 PostgreSQL 的系统表(如 pg_class 和 pg_attribute)以获取表结构信息。如果表数量较多,这种轮询可能会显著增加数据库的压力,并导致作业卡住。

debezium.snapshot.mode 为 exported 或 initial,避免频繁扫描元数据。table-name 参数指定正则表达式来匹配表名,而不是为每个表单独配置 Source。例如:

'table-name' = 'schema_name.table_prefix_.*'

这样可以减少元数据发现的次数。

max_connections 参数,确保其值足够大以支持多表同步。例如:

SHOW max_connections;

SET max_connections = 200;

SET 'execution.checkpointing.interval' = '60s';

SET 'execution.checkpointing.unaligned' = 'true';

在多表场景下,开启 Source 复用可以显著减少数据库的压力。具体操作如下: 1. 在 SQL 作业中启用 Source 复用功能:

SET 'table.optimizer.source-merge.enabled' = 'true';

server-id 外)相同,以便实时计算引擎能够合并这些 Source。如果不需要全量数据同步,可以通过 scan.startup.mode 参数跳过 Snapshot 阶段,直接从增量数据开始读取。例如:

'scan.startup.mode' = 'latest-offset'

这样可以避免全量阶段的元数据发现和数据读取过程。

SELECT pg_drop_replication_slot('slot_name');

currentEmitEventTimeLag 指标判断是否已完成全量数据同步。如果该指标大于 0,则表示已进入增量阶段。通过优化元数据轮询、增加资源分配、合理配置 Checkpoint、开启 Source 复用以及跳过 Snapshot 阶段,可以有效解决 Flink CDC 在多表场景下的卡顿问题。建议根据实际业务需求选择合适的优化策略,并持续监控作业运行状态以确保稳定性。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。