我们关联进行数据处理后需要实时更新维表。Flink这个维表更新怎么保证是在逻辑处理以后呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

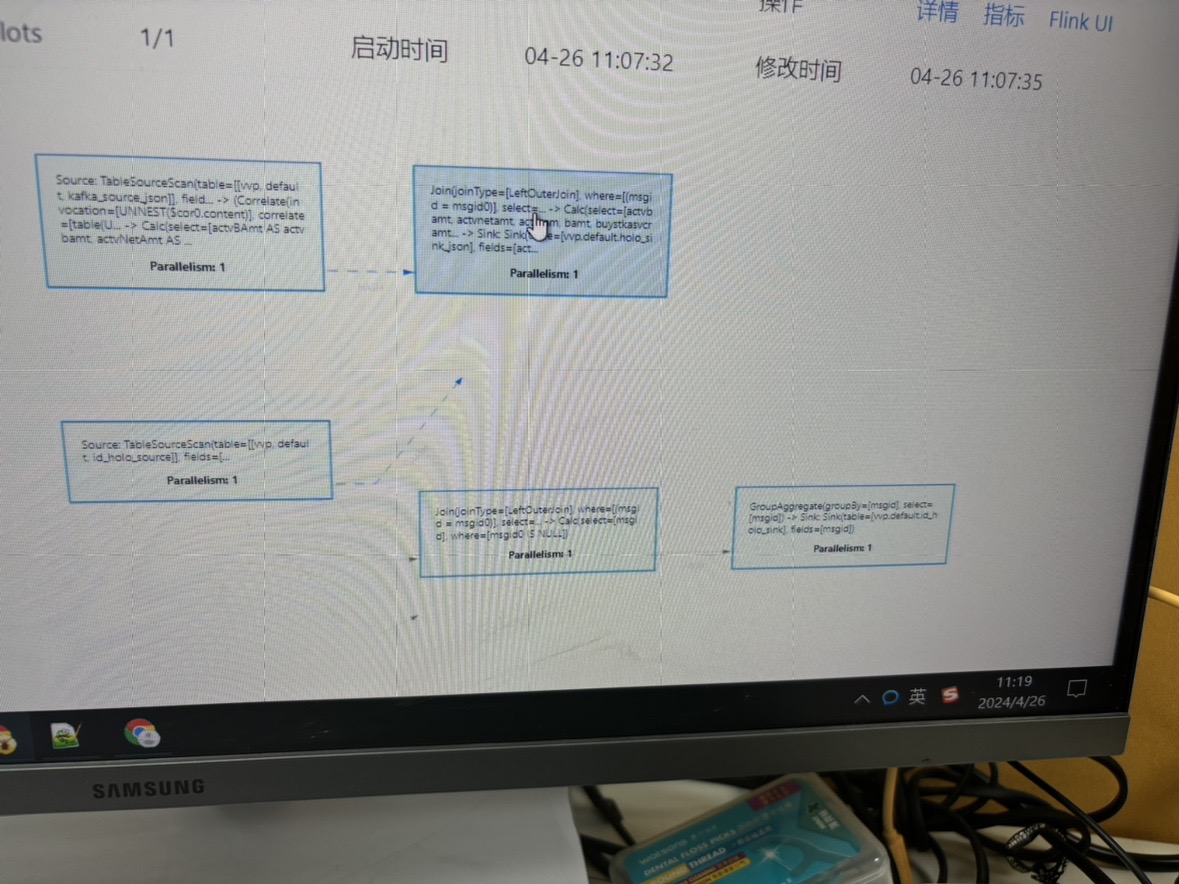

在使用Apache Flink进行数据处理时,确保维表(即维度表)的更新在逻辑处理之后进行,通常可以通过以下几种策略来实现:

ProcessFunction来控制事件处理的顺序。

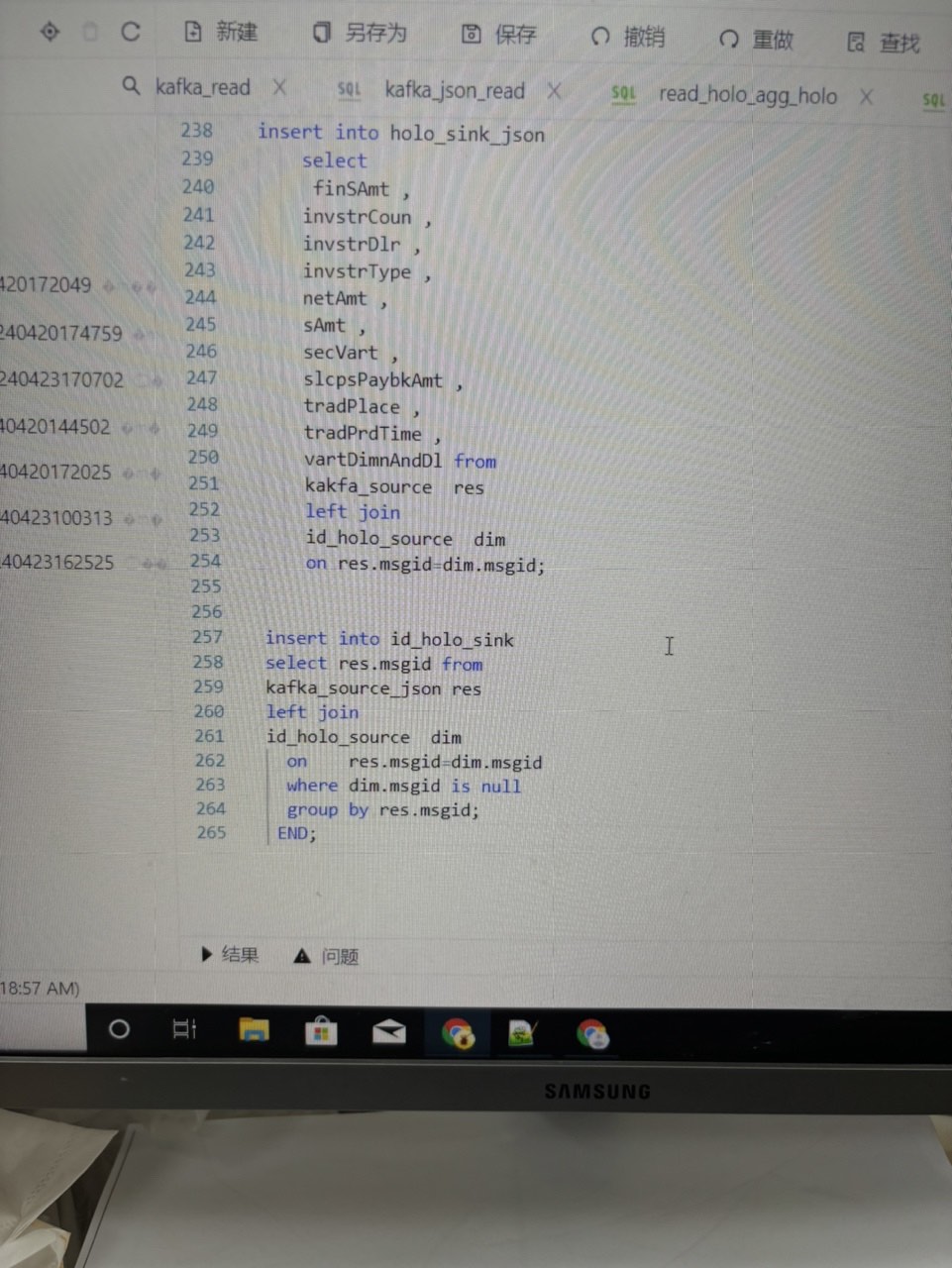

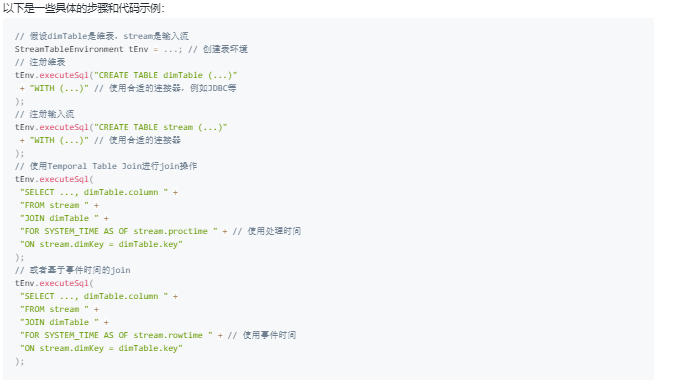

在上面的示例中,FOR SYSTEM_TIME AS OF子句确保了join操作是在指定的时间(处理时间或事件时间)进行,因此维表的更新是在逻辑处理之后。

最后,确保维表更新在逻辑处理之后的关键是理解你的业务逻辑和Flink的时间概念,合理设计你的数据处理流程。在实现时,可能需要根据具体场景调整策略。

使用异步IO操作:Flink提供了异步IO API,允许你在数据处理流程中非阻塞地执行外部服务调用,如维表更新。这样,数据处理逻辑可以继续执行,而维表更新操作则在后台异步完成。确保异步更新逻辑在数据处理链路的下游,即可保证更新操作在逻辑处理之后执行。

基于时间或事件的触发器:设计数据流处理逻辑时,可以利用TimeWindow或EventTimeWindow,结合ProcessFunction或WindowFunction,在窗口触发时执行维表更新。这样,所有的逻辑处理在窗口内完成,窗口触发后才执行维表的更新操作,确保了更新时机的正确性。

使用Side Outputs与自定义Sink:在复杂的数据处理逻辑中,可以利用Side Outputs功能将需要更新维表的数据分流出来,然后通过自定义Sink在数据处理流程的尾部执行维表更新。这样,只有当数据经过全部处理步骤后,才会被发送到自定义Sink进行维表更新。

依赖Flink SQL的 temporal table join或temporal table function:在使用Flink SQL处理数据时,可以利用时间相关的表连接(temporal table join)或临时表函数(temporal table function)来实现维表的实时更新与查询。通过定义合适的事件时间窗口和水印机制,可以确保维表的更新操作基于正确的逻辑时间顺序执行。

配置合理的缓存策略与更新机制:根据参考资料合理配置维表的缓存策略(如LRU、ALL)和最大缓存条数、超时时间等,可以优化维表的查询效率和更新时机。例如,使用LRU策略可以在内存中维护最近查询的记录,同时设定适当的缓存超时时间,确保数据新鲜度,间接控制了维表更新的逻辑顺序。

,通过异步处理、窗口机制、Side Outputs、SQL的高级特性以及合理的缓存管理,可以有效地控制维表更新操作在数据逻辑处理之后执行,确保数据处理流程的正确性和时效性。

相关链接

MySQL WITH参数 https://help.aliyun.com/zh/flink/developer-reference/mysql-connector

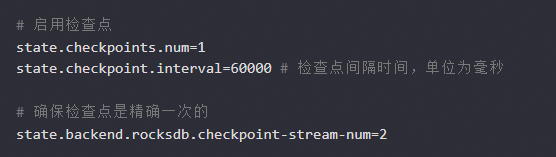

在Apache Flink中,你可以使用状态和检查点机制来确保维表的更新是原子的,并且发生在逻辑处理之后。你可以在你的Flink作业中创建一个有状态的状态对象(如ValueState、ListState等),并将维表的数据存储在这个状态对象中。然后,在每次逻辑处理完成后,你可以更新这个状态对象中的维表数据。为了确保更新是原子的,并且发生在逻辑处理之后,你需要启用Flink的检查点机制。检查点机制会在Flink作业运行时定期保存当前的状态快照。这样,如果发生故障或需要恢复,Flink可以从最近的检查点重新开始执行,而不是从头开始。要启用检查点,你需要在Flink作业的配置文件中设置以下属性:

每当逻辑处理完成并更新了维表数据后,Flink就会自动触发一个检查点操作,将当前的状态快照保存到持久化存储中。如果发生故障或需要恢复,Flink会从最近的检查点重新开始执行,从而确保维表的更新是原子的,并且发生在逻辑处理之后。

可以利用 broadcast State 将维度数据流广播到下游所有 task 中。这个 broadcast 的流可以与事件流进行 connect,然后在后续的 process 算子中进行关联操作即可。

当维度信息修改后,不只是要把维度信息更新到 MySQL 中,还需要将维度信息更新到 Kafka 中。Flink 的 broadcast 流实时消费 kafka 中数据,就可以实时读取到维表的更新,然后配置就会在 Flink 任务生效,通过这种方法及时的修改了维度信息。broadcast 可以动态实时更新配置,然后影响另一个数据流的处理逻辑。

——参考链接。

在Apache Flink中,维表(维度表)通常用于增强流处理中的事件数据,例如,通过将事件ID映射到完整的描述信息。为了实现在逻辑处理后更新维表,并确保数据的一致性,Flink提供了多种机制来管理这种类型的更新,其中最常用的是使用状态后端(State Backend)和定时器(Timer)。

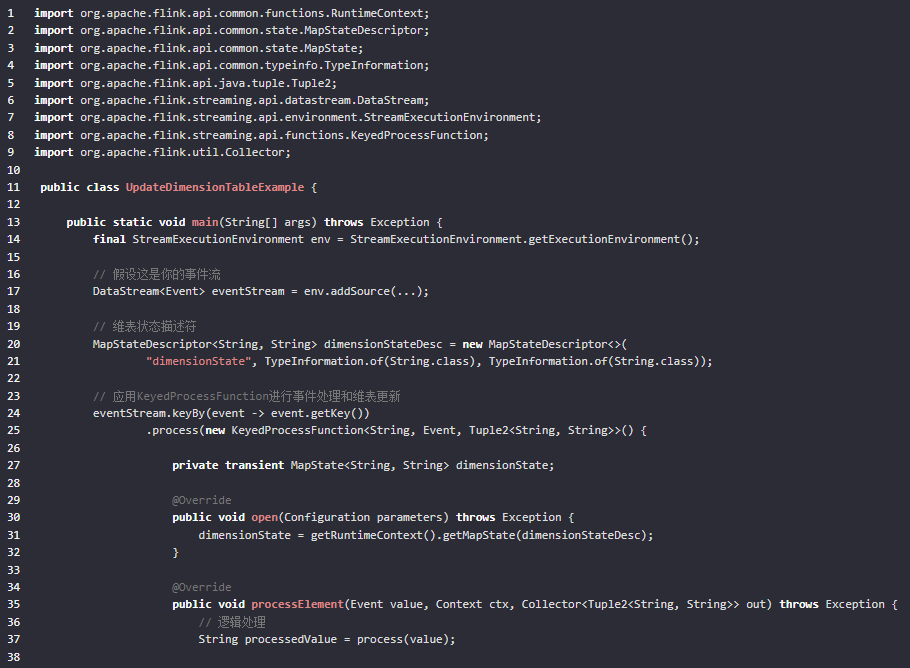

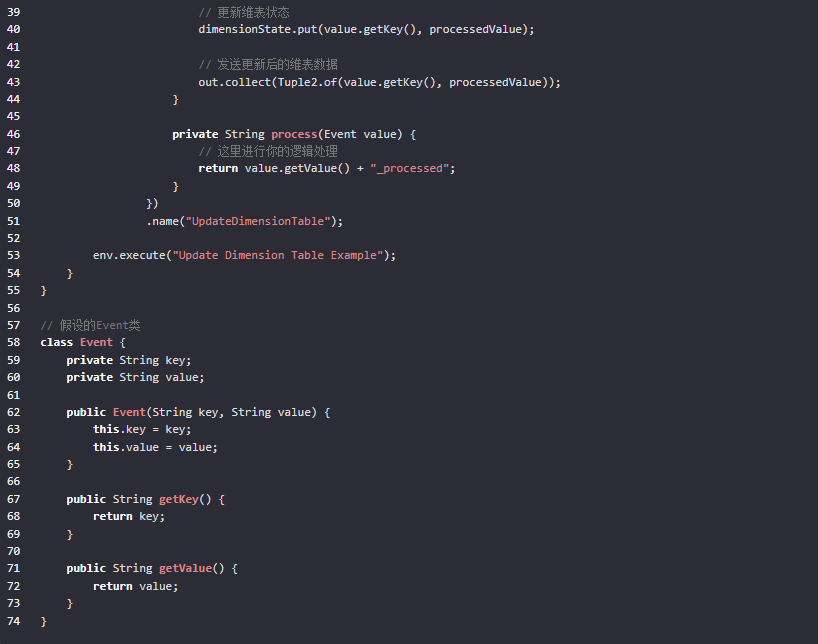

下面是一个示例,展示了如何在Flink中使用KeyedProcessFunction来实现逻辑处理后更新维表:

在这个示例中,我们使用了KeyedProcessFunction来处理每个事件,并在处理后更新维表状态。维表状态是通过MapState接口实现的,它允许键值对的存储和检索。

请注意,Flink的更新操作是异步的,因此在processElement方法中立即更新状态后,这些更新将在稍后的时间点传播到所有并行实例。Flink的状态一致性是由其分布式快照算法(Chandy-Lamport算法)保证的,这确保了所有并行实例在处理同一事件时看到相同的状态。

为了进一步确保数据的一致性和时效性,你还可以使用定时器(Timers)来安排更复杂的更新逻辑,例如基于时间窗口的更新。这将使你能够在处理完所有到达的事件后,再执行一次维表的批量更新,从而避免即时更新可能带来的延迟和一致性问题。

在使用Flink进行流处理时,如果要确保维表的更新发生在逻辑处理之后,需要

使用事件时间:通过使用事件时间,您可以确保所有与特定事件相关的操作都在该事件发生的时间点之后执行。这可以通过为每个事件分配一个基于其生成时间的时间戳来实现。

使用检查点(Checkpoints):Flink支持定期创建检查点,这些检查点可用于恢复系统状态。当您更新维表时,可以在检查点之间完成此操作,以确保任何后续处理都基于最新的维表状态。

使用双流Join:如果您有两个流,一个用于原始数据,另一个用于维表更新,则可以将这两个流连接在一起,并确保在应用任何其他转换之前先执行Join操作。

使用Watermark和EventTime:Watermark是一种机制,它允许您处理迟到的数据。通过使用Watermark和事件时间,您可以确保即使在处理过程中出现延迟的情况下也能正确地更新维表。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。