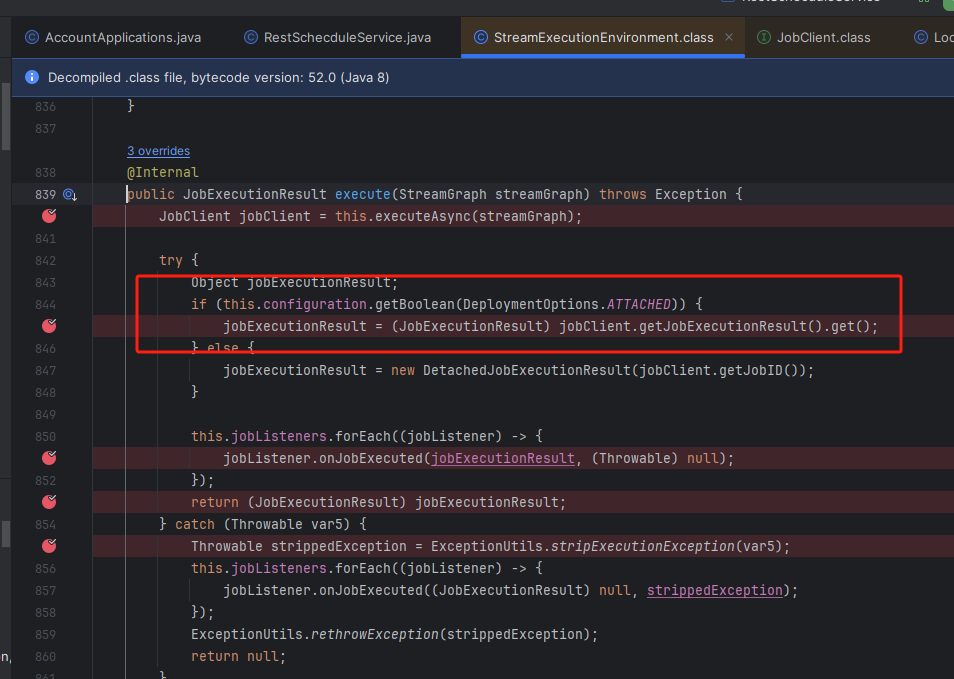

本地调试flink cdc, 为何执行到这一步, 一直没返回?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在本地调试 Flink CDC 作业时,如果执行到某一步一直未返回结果,可能是由于以下几个原因导致的。以下是详细的分析和解决方案:

numRecordsInOfSource 指标,确认 Source 输入是否有数据。scan.incremental.snapshot.enabled 是否启用。env.enableCheckpointing(10000); // 设置 Checkpoint 间隔为 10 秒

table.exec.source.idle-timeout 参数,标明分区无数据时的过期时间,避免 Watermark 被阻塞。table.exec.source.idle-timeout: 1s

jobmanager.retrieve-taskmanager-hostname: false

ClassNotFoundException 或其他类加载相关的异常。Configuration conf = new Configuration();

conf.setString("pipeline.classpaths", "file:///path/to/uber-jar.jar");

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(conf);

batchsize)。batchsize 参数,避免因缓存过大导致数据延迟写入。batchsize 设置过小可能导致下游数据库 I/O 压力过大。print 结果表将计算结果打印到日志中,分析日志以定位问题。通过以上步骤,您可以逐步排查本地调试 Flink CDC 作业卡住的原因。重点检查以下方面: 1. 上游数据是否正常进入; 2. Checkpoint 和 Watermark 配置是否合理; 3. 网络连通性和依赖配置是否正确; 4. 下游存储的缓存机制是否影响数据写入。

如果问题仍未解决,请提供更详细的日志信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。