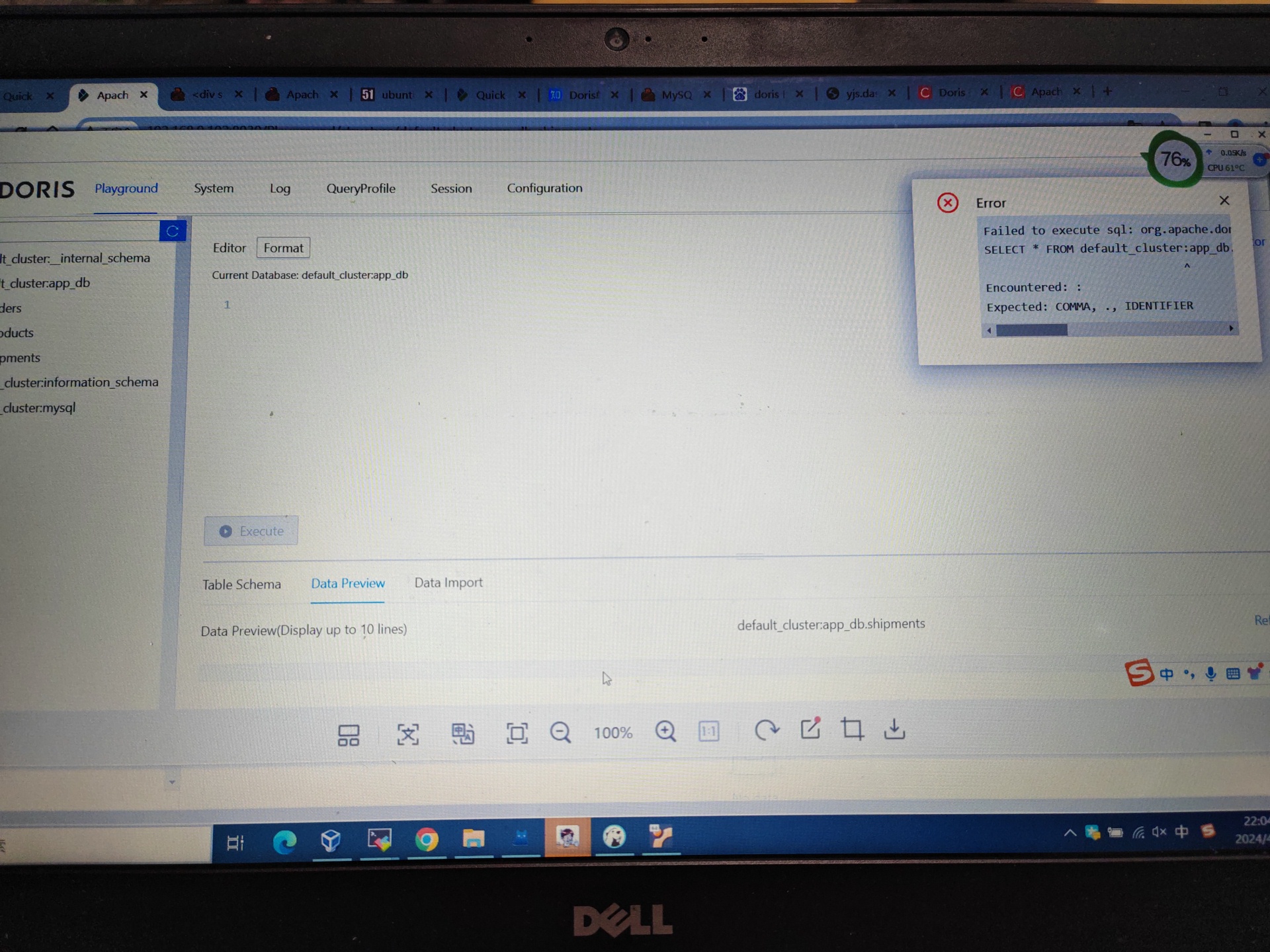

Flink CDC里大佬们doris预览数据报了这个错误怎么回事呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误描述“Flink CDC里大佬们doris预览数据报了这个错误”,虽然具体的错误信息未明确,但结合知识库中的相关资料,我们可以从以下几个方面进行排查和解决:

sink模块的type字段需要指定为Doris连接器类型,并且需要提供正确的Doris表名、数据库名以及相关的认证信息(如用户名和密码)。sink:

type: doris

database: <替换为Doris数据库名>

table: <替换为Doris表名>

username: <替换为Doris用户名>

password: <替换为Doris密码>

# 其他可选参数

batch-size: 1000

flush-interval: 1000

batch-size和flush-interval等参数设置合理,避免因缓存机制导致数据写入延迟或失败。transform模块中定义转换规则。例如:

transform:

- source-table: flink_test.customers

projection: id, username, age

filter: id > 10

ignoreDelete参数设置为false,则支持回撤更新数据。但需要注意,Doris对UPDATE和DELETE操作的支持性能较低,可能导致写入效率下降。ignoreDelete参数设置为true,以提高写入性能。CREATE TABLE doris_sink (

id INT,

name STRING,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'doris',

'ignoreDelete' = 'true'

);

NullPointerException或其他异常,但没有详细的错误栈,可以通过以下方式获取更多信息:

env.java.opts: "-XX:-OmitStackTraceInFastThrow"

join、window或where等算子,可能会导致数据被过滤。可以通过以下步骤排查:

pipeline.operator-chaining: 'false',将节点拆分。Bytes Received(输入)和Bytes Sent(输出),确定数据是否在某个节点被过滤。根据上述分析,您可以按照以下步骤逐步排查问题: 1. 检查Doris连接器配置是否正确。 2. 确保数据格式与Doris表结构匹配。 3. 调整Doris表的主键与更新策略。 4. 获取详细的错误日志以定位问题。 5. 验证数据是否被过滤或丢失。 6. 检查下游存储是否存在死锁。

如果问题仍未解决,请提供具体的错误信息或日志内容,以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。