Caused by: java.lang.ClassNotFoundException: org.apache.kafka.connect.data.Schema

Caused by: java.lang.ClassNotFoundException: org.apache.kafka.connect.data.Schema

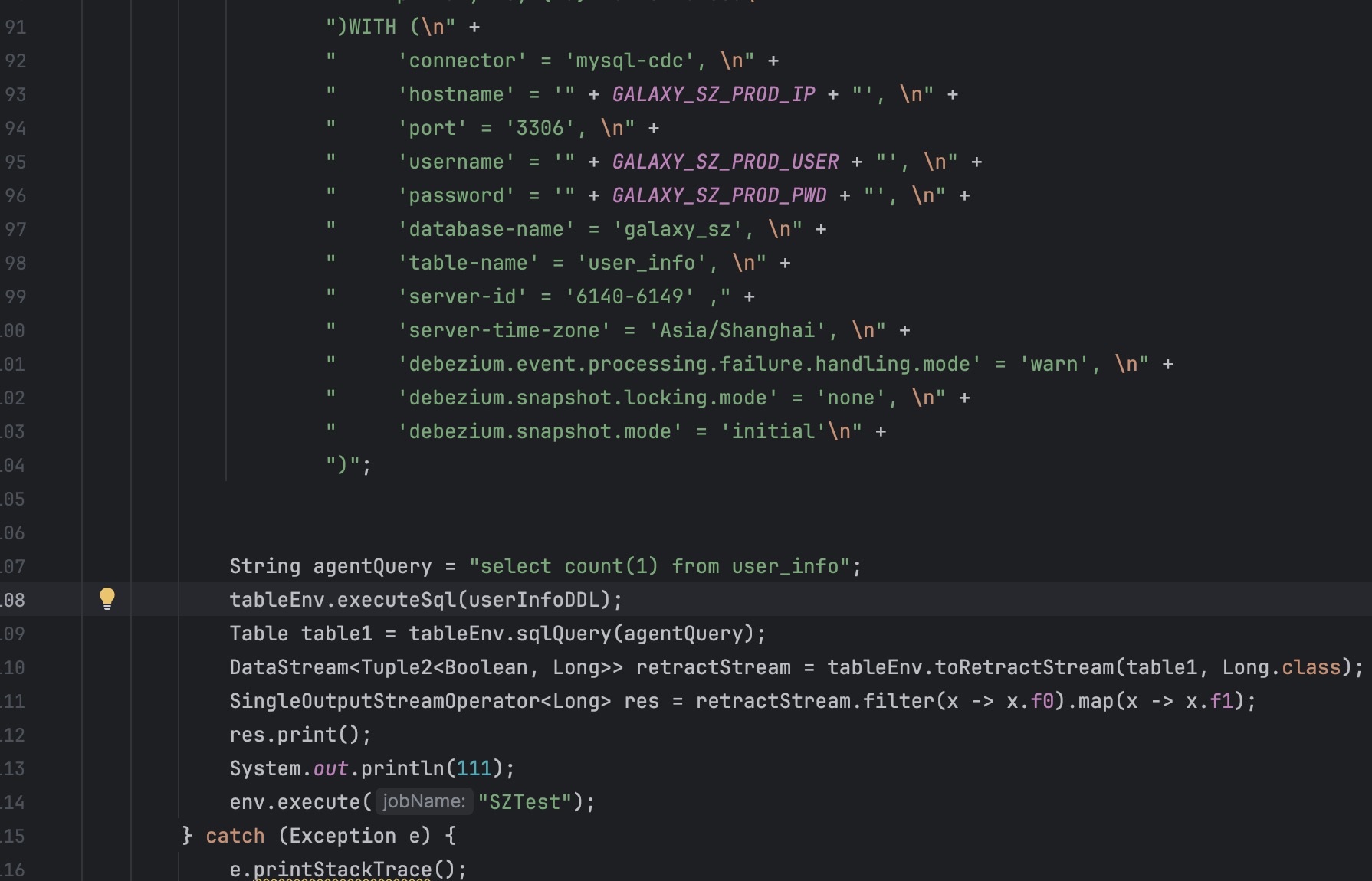

有大佬遇到过这个报错吗,使用flinkcdc读取一个表,然后转换成流做其他操作,发现任务一启动就报上面的错误,这个类都没引用这个包,很奇怪

尝试过把flinkcdc去掉,改成读sockt流,任务是可以正常启动的,所以就感觉是flankcdc的包没配置对

flink 版本是1.13.5

flinkcdc 版本是 2.2.1。已经解决了包冲突的问题,把pom中有关kafka的依赖都去掉了,发现还是会报错。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的信息,报错 java.lang.ClassNotFoundException: org.apache.kafka.connect.data.Schema 表明在运行时未能找到 org.apache.kafka.connect.data.Schema 类。这通常是由于以下原因之一导致的:

结合知识库中的相关资料,我们可以进一步分析并解决此问题。

org.apache.kafka.connect.data.Schema 类属于 Kafka Connect 的核心依赖,通常位于 kafka-connect-api 或 kafka-clients 中。请检查您的 pom.xml 文件,确保以下依赖已正确引入:

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>connect-api</artifactId>

<version>2.8.0</version> <!-- 请根据实际需求选择版本 -->

</dependency>

如果您的项目中使用了 Flink CDC,建议确认其与 Kafka 的版本兼容性。Flink CDC 2.2.1 通常需要 Kafka 2.8.0 或更高版本的支持。

根据您的描述,Flink 版本为 1.13.5,Flink CDC 版本为 2.2.1。虽然这两个版本理论上是兼容的,但仍需确保以下几点:

dependency:tree 命令检查依赖树,确保没有重复或冲突的依赖。mvn dependency:tree | grep kafka

exclusions 排除不必要的依赖。例如:<dependency>

<groupId>com.ververica</groupId>

<artifactId>flink-connector-mysql-cdc</artifactId>

<version>2.2.1</version>

<exclusions>

<exclusion>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

</exclusion>

</exclusions>

</dependency>

ClassNotFoundException 通常与类路径设置不当有关。请确保以下几点:

pom.xml 中的依赖已正确下载并打包到最终的 JAR 文件中。java -cp "your-app.jar:lib/*" com.your.MainClass

如果上述方法仍无法解决问题,可以尝试调整 Kafka 或 Flink CDC 的版本。例如:

Flink 的类加载机制可能导致某些类无法被正确加载。您可以尝试调整 Flink 的 ClassLoader 配置,确保 Kafka 相关类能够被正确加载。例如,在 flink-conf.yaml 中添加以下配置:

classloader.resolve-order: parent-first

如果按照上述步骤操作后问题仍未解决,建议进行以下操作:

通过以上步骤,您可以逐步排查并解决 java.lang.ClassNotFoundException: org.apache.kafka.connect.data.Schema 的问题。重点在于确保依赖的正确引入、版本的兼容性以及类路径的正确设置。如果仍有疑问,请随时提供更多上下文信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。