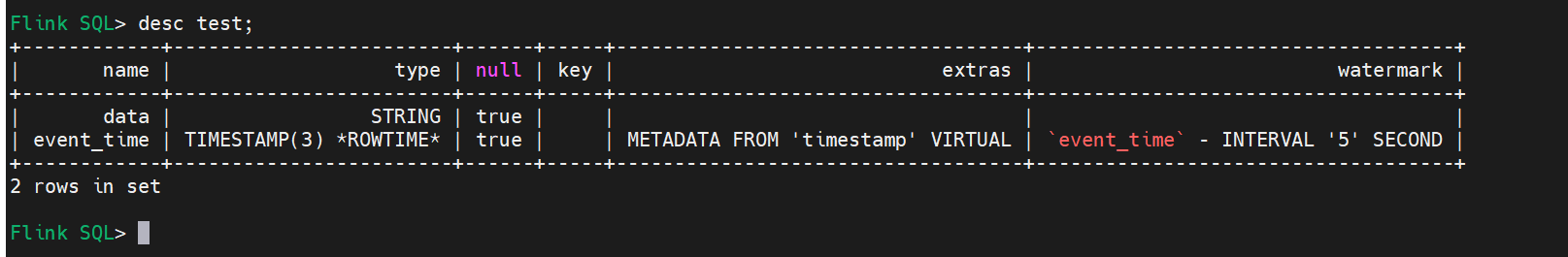

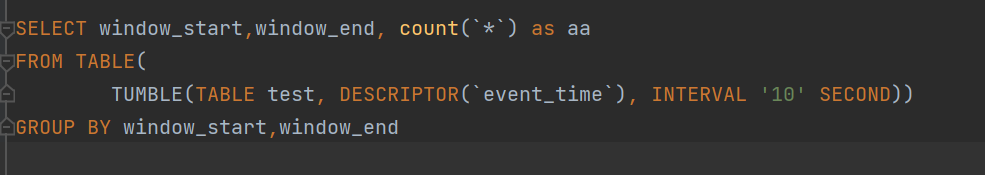

大佬们,求助,使用的版本1.13, 建表如下图中, 但是聚合的时候:SELECT window_start, window_end, COUNT(data) as num FROM TABLE(TUMBLE(TABLE line_kafka_source, DESCRIPTOR(event_time), INTERVAL '10' SECOND)) GROUP BY window_start, window_end;

结果没有数据。手动发送模拟数据,频率降低后,是可以聚合的。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

已找到问题,kafka有多个partition,只有一个partition更新数据,并行度设置为1,导致水位线被无数据的partition拉高,数据落不到窗口范围内,更改并行度后解决

这个问题可能是由于Flink的窗口大小设置不合适导致的。你可以尝试调整窗口大小,例如将窗口大小设置为5秒,看看是否能解决问题。修改后的SQL语句如下:

SELECT window_start, window_end, COUNT(data) as num FROM TABLE(TUMBLE(TABLE line_kafka_source, DESCRIPTOR(event_time), INTERVAL '5' SECOND)) GROUP BY window_start, window_end;

如果问题仍然存在,建议检查Kafka的数据源配置,确保数据源正确连接到Kafka,并且数据格式正确。同时,可以查看Flink的日志,看是否有其他错误信息。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。