DataWorks帮忙看看这个问题?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

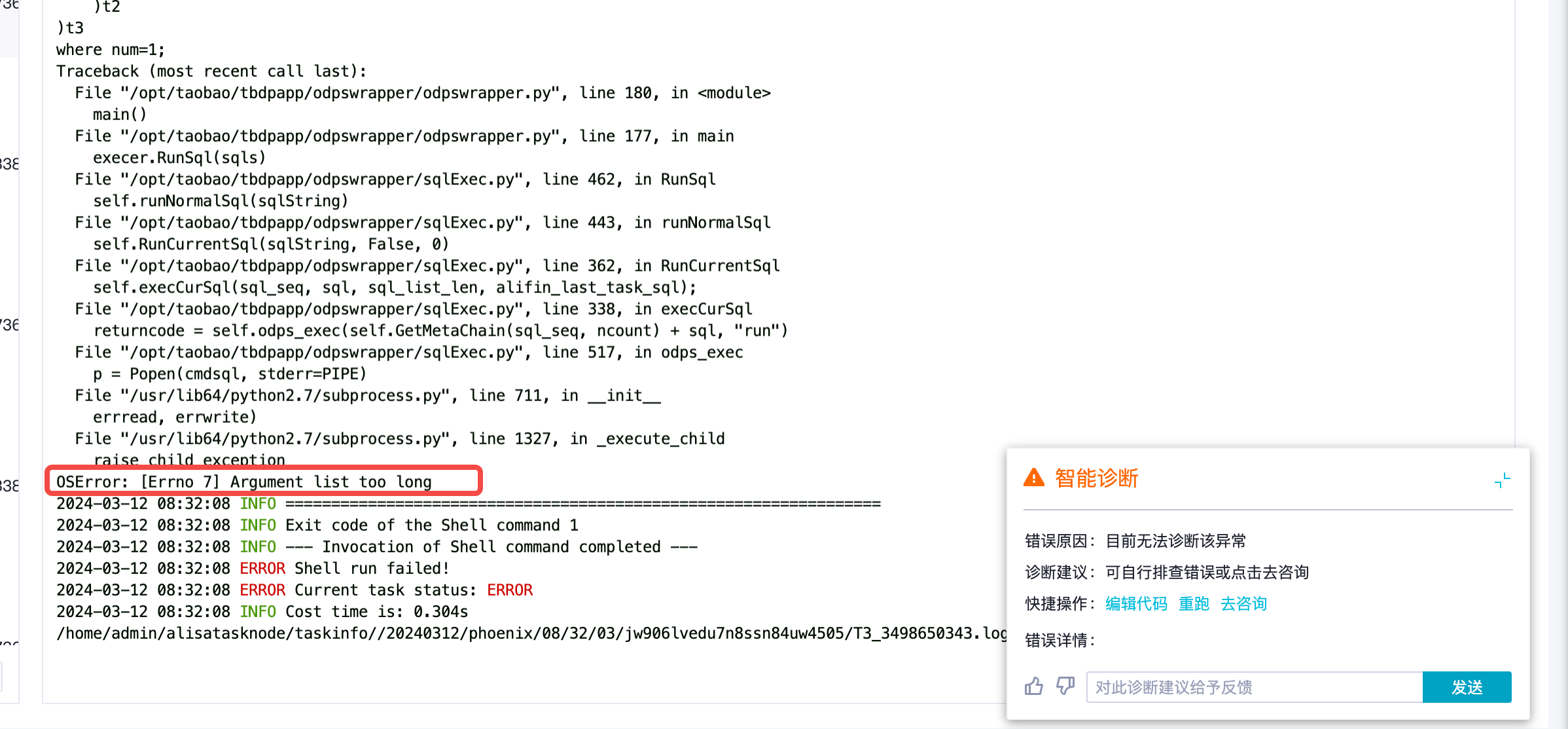

拆分一下脚本试试 应该是单个脚本太大了,文件大小超过了限制 建议减少中文注释、拆分sql等方式解决 ,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

在阿里云DataWorks中遇到“OSERROR: argument list too long”的错误,通常表示在执行命令或脚本时传递的参数列表长度超过了操作系统的最大限制。这可能是由于一次性处理的数据文件路径、数量过多,或者SQL语句中的IN子句包含的值过多等原因导致。

解决方法可以考虑以下几点:

如果是在进行数据同步、清洗等过程中出现此问题,尝试将任务拆分成多个小批次进行,减少每次处理的数据量。

对于SQL查询,如果使用了大量ID通过IN子句查询,可尝试将其分为多个查询语句或改用JOIN等其他方式来实现过滤条件。

检查并优化相关脚本,避免一次性传入过长的参数列表,例如在循环内部多次调用命令行工具,而不是一次性传入所有参数。

根据操作系统(如Linux)的特性,可能需要调整系统的参数来允许更大的命令行参数列表,例如在Linux下可以通过修改/etc/security/limits.conf文件增加max_ARG_MAX的值。

如果是大量的文件路径,可以先将这些路径写入一个临时文件,然后在命令行中引用这个临时文件而非直接列出所有路径。

在DataWorks中执行大数据任务时,尽量遵循最佳实践,避免一次性处理过多的数据单元或资源对象。

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。