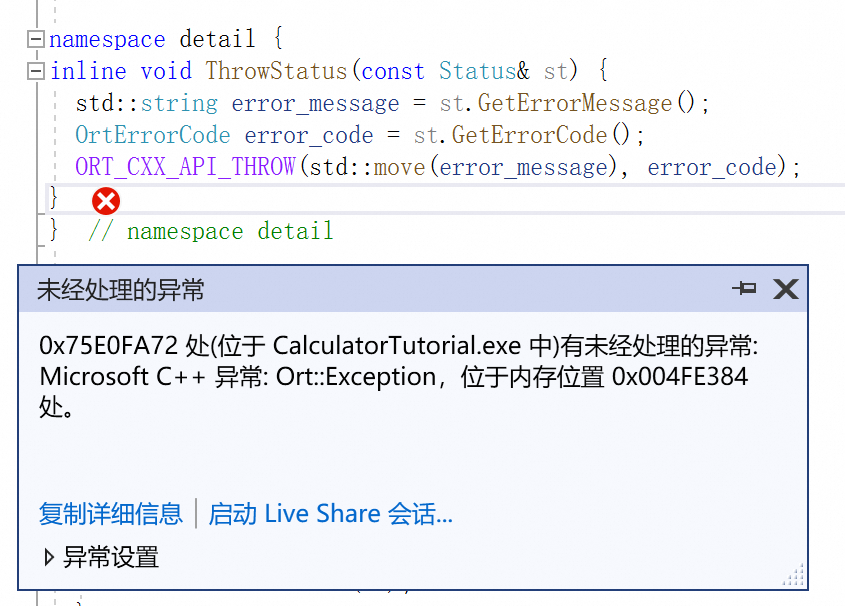

modelscope-funasr的onnxruntime推理的时候报这个错误,啥原因啊?

根据您提供的错误信息以及知识库中的相关资料,以下是对问题的详细分析和解决方法:

在使用 modelscope-funasr 进行 ONNX Runtime 推理时出现错误,可能的原因包括以下几个方面:

硬件与软件环境不匹配

ONNX Runtime 的推理性能依赖于底层硬件和软件环境。如果使用的硬件(如 CPU 或 GPU)与 ONNX Runtime 的后端(如 OpenVINO、CUDA 等)不兼容,可能会导致推理失败。

模型格式或配置问题

如果模型未正确导出为 ONNX 格式,或者模型的输入/输出配置与推理代码不一致,也会引发错误。

依赖版本冲突

ONNX Runtime 和其他依赖库(如 PyTorch、TensorRT 等)的版本不匹配可能导致运行时错误。

缺少必要的依赖或插件

某些特定的推理后端(如 OpenVINO 或 TensorRT)需要额外安装对应的插件或驱动程序。如果这些依赖未正确安装,推理过程会失败。

确认硬件类型

如果使用的是 Intel 硬件,请确保安装了支持 OpenVINO 的 ONNX Runtime 版本(如 onnxruntime-openvino)。如果是 NVIDIA GPU,请确保安装了支持 CUDA 和 TensorRT 的 ONNX Runtime 版本。

验证 ONNX Runtime 后端

使用以下命令检查 ONNX Runtime 是否加载了正确的执行提供程序(Execution Provider):

import onnxruntime as ort

print(ort.get_available_providers())

输出中应包含您期望的后端(如 CUDAExecutionProvider 或 OpenVINOExecutionProvider)。如果未包含,请重新安装对应版本的 ONNX Runtime。

检查模型是否正确导出为 ONNX 格式

使用以下命令验证 ONNX 模型的完整性:

python -m onnxruntime.tools.check_onnx_model <path_to_model.onnx>

如果模型有问题,请重新导出。参考知识库中关于 PyTorch 模型导出为 ONNX 的步骤。

检查输入/输出配置

确保推理代码中的输入数据格式(如形状、数据类型)与模型的配置一致。可以使用 Netron 工具可视化 ONNX 模型,查看其输入/输出定义。

检查 ONNX Runtime 和其他库的版本兼容性

参考知识库中关于 ONNX Runtime 和 OpenVINO 的版本要求,确保所有依赖库的版本一致。例如:

更新或降级依赖库

如果发现版本冲突,可以通过以下命令更新或降级:

pip install onnxruntime==1.15.0

pip install openvino==2023.1.0

安装 OpenVINO 插件

如果使用的是 Intel 硬件,请确保安装了 OpenVINO 插件,并按照知识库中的说明配置环境。

安装 CUDA 和 cuDNN 驱动

如果使用的是 NVIDIA GPU,请确保安装了与 ONNX Runtime 兼容的 CUDA 和 cuDNN 驱动。参考知识库中关于 TensorRT 的配置说明。

启用 ONNX Runtime 调试模式

在推理代码中启用调试日志,获取更详细的错误信息:

import onnxruntime as ort

session = ort.InferenceSession("<path_to_model.onnx>", providers=["CUDAExecutionProvider"])

根据日志定位具体问题。

检查错误堆栈

如果错误信息中包含具体的异常类型(如 RuntimeError 或 ValueError),请根据异常类型进一步排查。

硬件适配性

ONNX Runtime 的推理性能高度依赖硬件环境,请确保硬件与所选后端(如 OpenVINO 或 CUDA)匹配。

版本一致性

确保 ONNX Runtime、OpenVINO、CUDA 等依赖库的版本一致,避免因版本冲突导致的运行时错误。

模型验证

在推理前务必验证 ONNX 模型的完整性和配置,以减少运行时错误的可能性。

通过以上步骤,您可以逐步排查并解决 modelscope-funasr 在 ONNX Runtime 推理时的错误。如果问题仍未解决,请提供具体的错误信息以便进一步分析。