用streampark搞过Flink CDC吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的知识库资料,目前没有直接提到 StreamPark 与 Flink CDC 的集成或相关实践。然而,我们可以从已有的资料中提取相关信息,并结合 Flink CDC 的特性为您提供一个专业且结构化的解答。

虽然 StreamPark 本身并未在知识库中明确提及,但其作为 Flink 作业的管理工具,理论上可以用来管理和部署基于 Flink CDC 的作业。

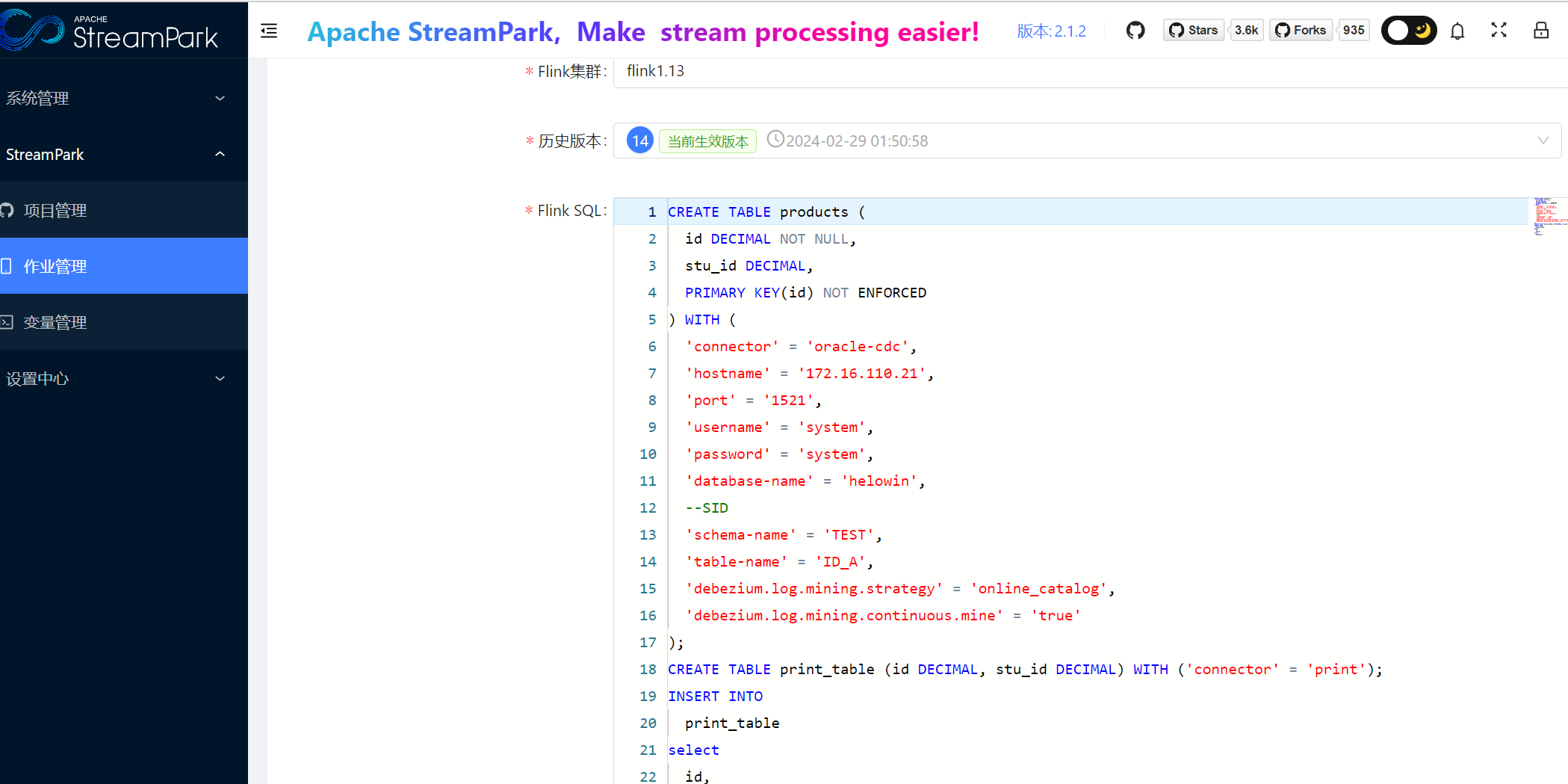

StreamPark 支持 Flink SQL 和 DataStream API 的作业部署,而 Flink CDC 提供了以下两种主要开发方式: 1. SQL 作业开发:通过 Flink SQL 定义数据同步逻辑,例如使用 CREATE TABLE 和 INSERT INTO 语句完成数据同步。 2. YAML 数据摄入作业:通过 YAML 文件定义复杂的 ETL 流程,自动转化为 Flink 运算逻辑。

因此,您可以将 Flink CDC 的 SQL 或 YAML 作业打包为 Flink 作业 JAR 文件,并通过 StreamPark 进行部署和管理。

以下是使用 StreamPark 部署 Flink CDC 作业的通用步骤:

SQL 模式:

CREATE TABLE source_table (

id INT,

name STRING,

PRIMARY KEY (id) NOT ENFORCED

) WITH (

'connector' = 'mysql-cdc',

'hostname' = 'your-mysql-host',

'port' = '3306',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'your-database',

'table-name' = 'your-table'

);

CREATE TABLE sink_table (

id INT,

name STRING

) WITH (

'connector' = 'hologres',

'url' = 'your-hologres-url',

'tablename' = 'your-target-table'

);

INSERT INTO sink_table SELECT * FROM source_table;

YAML 模式:

pipeline:

name: "CDC YAML Job"

schema.change.behavior: "LENIENT"

route:

- source-table: "mydb.orders"

sink-table: "sink_db.orders"

- source-table: "mydb.orders"

sink-table: "backup_sink_db.orders"

上传作业 JAR 文件:

配置作业参数:

启动作业:

LENIENT、EXCEPTION 等),请根据业务需求选择合适的配置。虽然知识库中未直接提及 StreamPark 与 Flink CDC 的集成案例,但通过 StreamPark 部署 Flink CDC 作业是完全可行的。您可以根据业务需求选择 SQL 或 YAML 模式开发作业,并通过 StreamPark 进行统一管理和部署。

如果您有更多具体需求或遇到问题,欢迎进一步补充说明!

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。