ModelScope中咨询下LoRA增量权重与LoRA merged的权重有啥区别吗? lora增量权重是只使用lora的权重进行推理?

lora增量权重是只使用lora的权重进行推理?

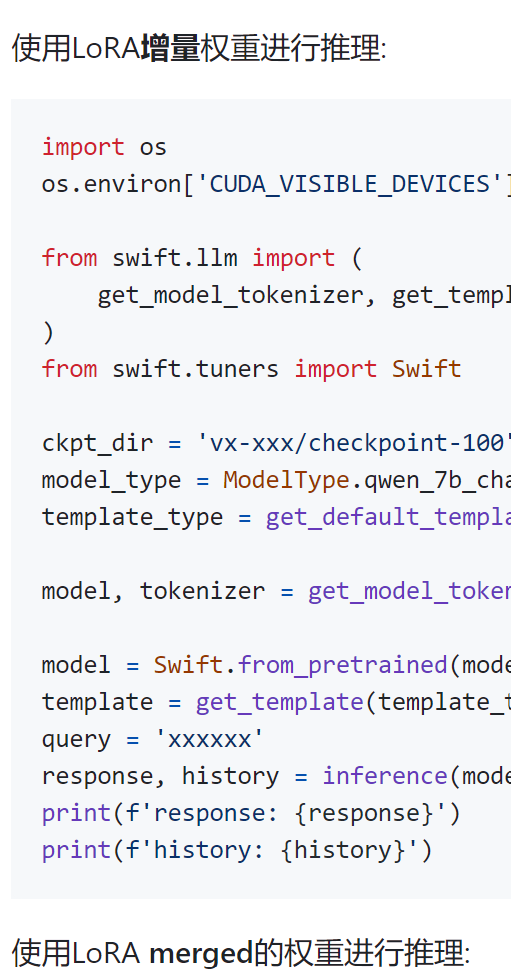

在ModelScope中,LoRA增量权重与LoRA merged权重是两种不同的微调策略。以下是具体分析:

总的来说,LoRA增量权重专注于通过低秩矩阵捕捉模型微调过程中的学习变化,而LoRA merged权重则是将这些学习成果整合回原始模型权重中,以便模型能够在实际应用中发挥出更好的性能。

merged是lora权重和原来模型的权重进行了合并。一般vllm推理时会要求合并权重。原来的模型权重也用。此回答来自钉群魔搭ModelScope开发者联盟群 ①。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352