flinkcdc pg to kafka,报如下错误如何解决?

flinkcdc pg to kafka,报如下错误initial slot snapshot too large如何解决

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

-

当你使用 Flink CDC(Change Data Capture)从 PostgreSQL 读取数据并写入 Kafka 时,遇到 "initial slot snapshot too large" 的错误,这通常意味着 PostgreSQL 的逻辑复制初始快照太大,导致 Flink CDC 在尝试获取它时遇到了问题。

这个错误可能由以下几个原因引起:

- 表数据量过大:如果你要捕获的 PostgreSQL 表包含大量数据,初始快照可能会非常大。

- 网络问题:如果 Flink 与 PostgreSQL 之间的网络连接不稳定或带宽有限,传输大量的初始快照数据可能会失败。

- 配置问题:Flink CDC 或 PostgreSQL 的配置可能不适合处理大量数据的初始快照。

要解决这个问题,你可以尝试以下几个方法:

- 分批处理:如果你不能一次性处理所有的数据,可以考虑分批处理。例如,你可以先处理一部分表的数据,然后再处理另一部分。

- 优化网络:确保 Flink 与 PostgreSQL 之间的网络连接稳定且带宽足够。

- 调整配置:检查并调整 Flink CDC 和 PostgreSQL 的相关配置。例如,你可以尝试增加 Flink 的任务并行度,或者调整 PostgreSQL 的逻辑复制参数。

- 考虑其他方法:如果 Flink CDC 不适合你的用例,你可能需要考虑使用其他的数据集成方法,如使用专门的 ETL 工具或自定义解决方案。

2024-03-04 16:30:20赞同 1 展开评论 -

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

遇到"initial slot snapshot too large"错误通常是由于Flink CDC(Change Data Capture)在从PostgreSQL数据库读取数据时,初始快照的大小超过了Kafka的最大消息大小限制。

要解决这个问题,你可以尝试以下几种方法:

增加Kafka的消息最大值:你可以增加Kafka的

max.message.bytes配置参数的值,以允许更大的消息通过。你可以在Kafka的配置文件中设置这个参数,或者在启动Kafka时使用命令行参数进行设置。例如,将max.message.bytes设置为50MB:# 在Kafka的配置文件中添加或修改以下行 max.message.bytes=52428800或者在启动Kafka时使用以下命令行参数:

bin/kafka-server-start.sh config/server.properties --override max.message.bytes=52428800请注意,增加消息最大值可能会影响Kafka的性能和资源消耗,因此需要根据系统的实际情况进行调整。

调整Flink CDC的配置:你还可以尝试调整Flink CDC的配置,以减小初始快照的大小。具体而言,你可以尝试减少并行度、调整缓冲区大小或调整其他相关参数。这些配置可以在Flink CDC的配置文件中进行设置。

优化数据流处理:如果以上方法仍然无法解决问题,你可以考虑优化数据流的处理方式。例如,你可以使用更高效的序列化方式来减小消息的大小,或者对数据进行压缩以减少传输的数据量。

需要注意的是,具体的解决方法可能因你的环境和需求而有所不同。建议根据你的实际情况进行尝试和调整,并参考Flink和Kafka的官方文档以获取更多详细的信息和支持。

2024-03-04 13:27:30赞同 展开评论 -

"initial slot snapshot too large" 错误通常是由 Flink CDC(Change Data Capture)任务在连接 PostgreSQL 数据库时,初始快照数据量过大导致的。这可能会导致 Flink 作业无法正常启动或者处理数据。

以下是一些可能的解决方案:

增加资源:尝试增加 Flink 作业运行的资源,如内存和 CPU,以便更好地处理初始快照数据。可以通过增加 TaskManager 的数量、提高 TaskManager 的堆内存大小等方式来增加资源。

调整并发度:尝试调整 Flink 作业中不同算子的并发度,以及整体作业的并发度设置。通过适当调整并发度,可以更好地分配资源并减少初始快照数据的压力。

增加 Checkpoint 频率:增加 Flink 作业的 Checkpoint 频率,可以帮助作业更快地完成初始快照数据的处理。较频繁的 Checkpoint 可能会在某种程度上减少初始快照数据的影响。

分阶段加载数据:考虑采用分阶段加载数据的方式,逐步增加数据量的处理。可以先加载部分数据,等待作业正常运行后再逐步增加数据量,以避免一次性加载过多数据导致的问题。

优化 SQL 查询:如果可能的话,优化 Flink CDC 任务中的 SQL 查询,确保查询逻辑简洁高效。复杂的查询可能会导致初始快照数据量过大,影响作业的性能。

检查 PostgreSQL 配置:确保 PostgreSQL 数据库的配置合理,比如连接数、资源限制等。可以根据实际情况对 PostgreSQL 数据库进行调整,以更好地支持 Flink CDC 任务的运行。

通过以上方法中的一种或多种,你可能能够解决 "initial slot snapshot too large" 错误,使 Flink CDC 任务能够正常运行并处理 PostgreSQL 到 Kafka 的数据流。

2024-03-04 12:08:24赞同 展开评论 -

北京阿里云ACE会长

具体程序信息不同,结果也不同。

调整 Flink 配置:增加 Flink 的内存、CPU 资源或并行度,以更好地处理大量数据

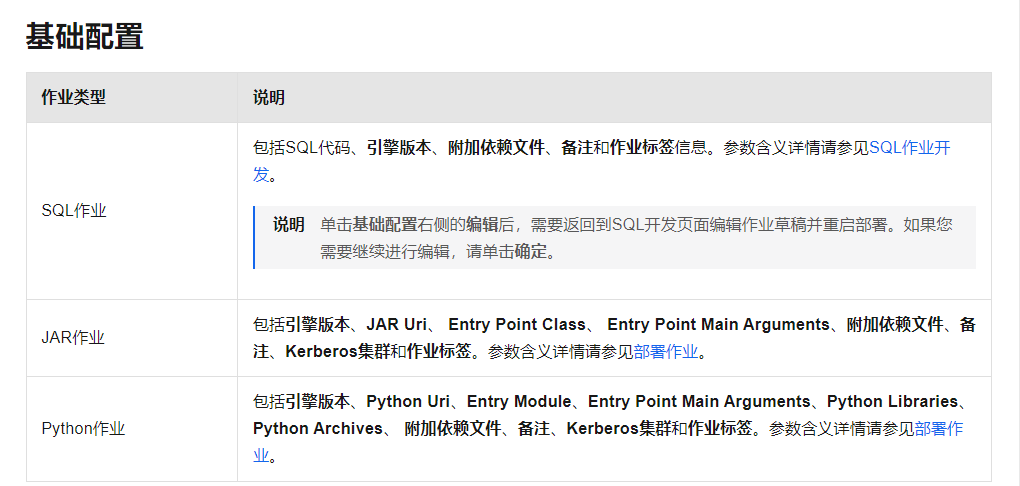

参考;https://help.aliyun.com/zh/flink/user-guide/configure-a-deployment?spm=a2c4g.11186623.0.i104

2024-03-04 11:48:37赞同 展开评论

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。