pgsql的 flinkcdc 怎么传给kafka?

我想pgsql库实时同步到另一个pgsql库 source database->flinkcdc->kafka->target

database, 这个路线可以吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要实现 PostgreSQL 数据库的实时同步(source database -> Flink CDC -> Kafka -> target database),您可以通过以下步骤完成。以下是详细的实现方案和操作步骤:

您的技术路线是可行的,具体流程如下: - Flink CDC 用于捕获 PostgreSQL 源数据库的变更数据(CDC,Change Data Capture)。 - 将捕获的数据通过 Flink 写入 Kafka。 - 使用 Flink 或其他工具从 Kafka 中读取数据,并写入目标 PostgreSQL 数据库。

此方案适用于需要解耦数据流、支持高吞吐量和实时处理的场景。

在开始之前,请确保满足以下条件: 1. PostgreSQL 源数据库配置: - 开启逻辑复制功能(wal_level=logical)。 - 创建逻辑复制槽(Logical Replication Slot),例如使用 wal2json 插件: sql SELECT 'init' FROM pg_create_logical_replication_slot('test_slot', 'wal2json'); - 确保源数据库表有主键,否则 Flink CDC 无法正确捕获变更数据。

Kafka 配置:

Flink 配置:

目标 PostgreSQL 数据库:

postgresql.conf,启用逻辑复制:

wal_level = logical

SELECT 'init' FROM pg_create_logical_replication_slot('test_slot', 'wal2json');

在 Kafka 中创建一个 Topic,用于存储从 PostgreSQL 捕获的变更数据。例如:

kafka-topics.sh --create --topic pg_cdc_topic --bootstrap-server localhost:9092 --partitions 3 --replication-factor 1

在 Flink 中创建一张表,用于捕获 PostgreSQL 的变更数据:

CREATE TABLE PostgresSourceTable (

`id` BIGINT,

`name` STRING,

`age` INT,

`primary_key` BIGINT,

`event_time` TIMESTAMP(3) METADATA FROM 'value.source.timestamp' VIRTUAL,

`shard` BIGINT METADATA FROM 'partition' VIRTUAL,

`meta_offset` BIGINT METADATA FROM 'offset' VIRTUAL,

PRIMARY KEY (`primary_key`) NOT ENFORCED

) WITH (

'connector' = 'postgres-cdc',

'hostname' = 'source-db-host',

'port' = '5432',

'username' = 'your-username',

'password' = 'your-password',

'database-name' = 'source_db',

'schema-name' = 'public',

'table-name' = 'your_table',

'slot.name' = 'test_slot'

);

将捕获的数据写入 Kafka:

CREATE TABLE KafkaSinkTable (

`id` BIGINT,

`name` STRING,

`age` INT,

`primary_key` BIGINT,

`event_time` TIMESTAMP(3),

`shard` BIGINT,

`meta_offset` BIGINT

) WITH (

'connector' = 'kafka',

'topic' = 'pg_cdc_topic',

'properties.bootstrap.servers' = 'localhost:9092',

'format' = 'json'

);

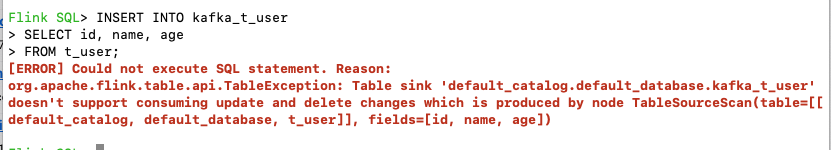

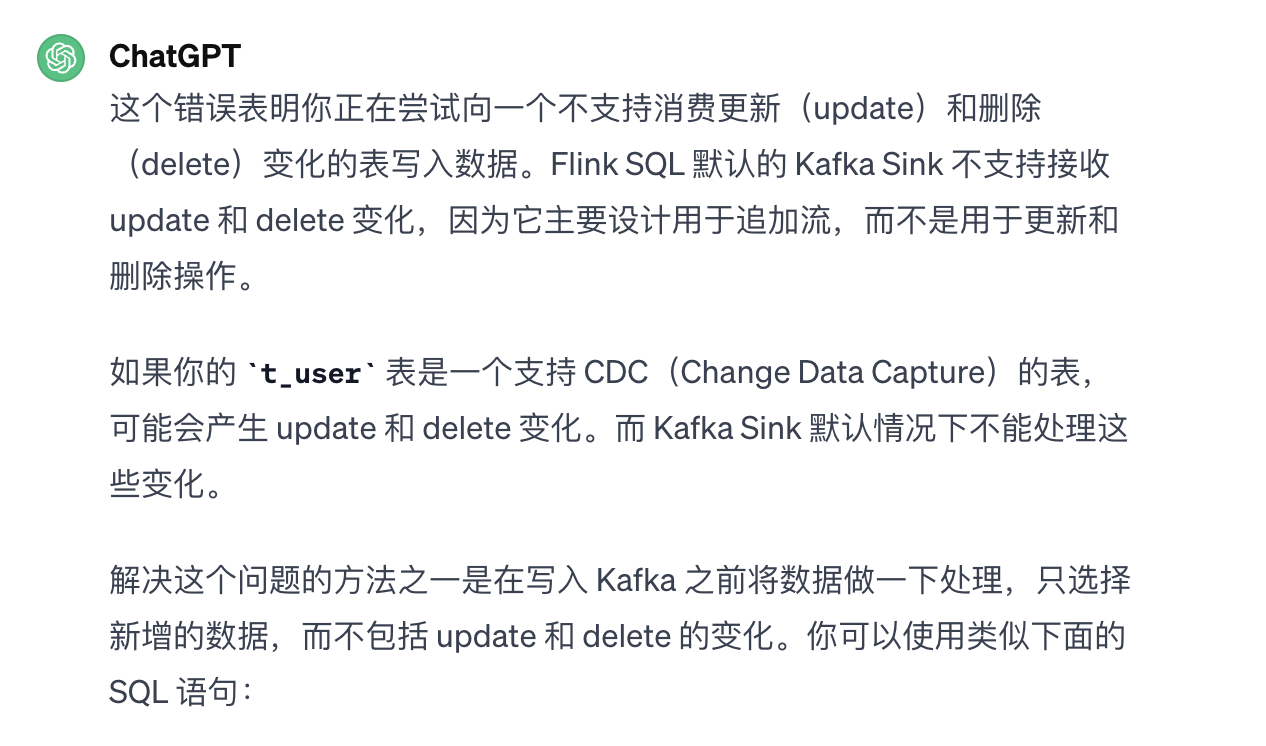

INSERT INTO KafkaSinkTable SELECT * FROM PostgresSourceTable;

在 Flink 中创建一张表,用于读取 Kafka 数据:

CREATE TABLE KafkaSourceTable (

`id` BIGINT,

`name` STRING,

`age` INT,

`primary_key` BIGINT,

`event_time` TIMESTAMP(3),

`shard` BIGINT,

`meta_offset` BIGINT

) WITH (

'connector' = 'kafka',

'topic' = 'pg_cdc_topic',

'properties.bootstrap.servers' = 'localhost:9092',

'format' = 'json',

'scan.startup.mode' = 'earliest-offset'

);

在目标 PostgreSQL 数据库中创建目标表:

CREATE TABLE TargetTable (

id BIGINT,

name VARCHAR(255),

age INT,

primary_key BIGINT PRIMARY KEY

);

将 Kafka 数据写入目标 PostgreSQL 数据库:

CREATE TABLE PostgresTargetTable (

`id` BIGINT,

`name` STRING,

`age` INT,

`primary_key` BIGINT,

PRIMARY KEY (`primary_key`) NOT ENFORCED

) WITH (

'connector' = 'jdbc',

'url' = 'jdbc:postgresql://target-db-host:5432/target_db',

'table-name' = 'TargetTable',

'username' = 'your-username',

'password' = 'your-password'

);

INSERT INTO PostgresTargetTable SELECT * FROM KafkaSourceTable;

通过上述步骤,您可以实现 PostgreSQL 数据库的实时同步(source database -> Flink CDC -> Kafka -> target database)。此方案利用了 Flink CDC 的高效数据捕获能力、Kafka 的高吞吐量消息队列特性以及 Flink 的灵活数据处理能力,适合需要实时数据同步的场景。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。