Flink多并发sink 更新 redis 值,如何保证数据能按事件时间来更新数据?一致性如何保证?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在 Apache Flink 中,要确保多并发 sink 同时更新 Redis 值时,数据能按事件时间有序地更新并且保持一致性,可以采取以下策略:

事件时间处理:

Watermark 机制:

窗口聚合:

Redis 的事务与锁:

幂等性设计:

并行度和分区:

故障恢复与 checkpoint:

综合上述方法,可以构建一个既按事件时间顺序更新又能保证数据一致性的 Redis Sink。需要注意的是,具体实现细节会依赖于业务需求和 Redis 数据模型,可能需要定制化开发 Redis Sink。

在 Flink 中,处理多个并发任务更新 Redis 值时,确保数据按照事件时间进行更新并维护数据一致性是一个挑战。以下是一些建议和方法来确保数据按事件时间更新和保证一致性:

使用 Redis 的事务功能:

Redis 支持事务操作,这允许你将多个命令打包成一个原子操作执行。你可以利用这个特性来确保一系列更新操作的原子性。

设计合适的 Redis 键结构:

设计 Redis 键以包含足够的信息来识别每个事件。例如,你可以使用事件时间作为键的一部分,这样每个事件都会有一个唯一的键。

使用 Redlock 算法保证分布式锁:

在分布式环境中,你可能需要确保在更新 Redis 值时只有一个 Flink 任务能够执行更新。Redlock 算法是一个分布式锁解决方案,可以在多个 Redis 实例之间实现分布式锁。

使用 Redis 的乐观锁:

如果 Redis 值包含版本号或时间戳,你可以使用乐观锁来确保更新操作的正确性。在更新之前,先检查版本号或时间戳是否仍然有效,如果无效则放弃更新。

调整 Flink 的并行度:

确保 Flink 任务的并行度与 Redis 的写入能力相匹配,避免过多的并发更新导致 Redis 性能瓶颈。

事件时间窗口:

使用 Flink 的事件时间窗口来处理延迟数据和乱序事件。通过将事件分组到窗口中,你可以控制何时处理事件,并基于窗口内的最新事件来更新 Redis 值。

使用 Redis 的过期策略:

为 Redis 中的键设置合理的过期时间,以确保旧的数据不会永久存在。这有助于在数据不一致的情况下恢复。

监控和告警:

实现监控和告警机制,当检测到数据不一致或更新失败时,能够迅速响应并处理。

回滚机制:

在 Flink 程序中实现回滚机制,以便在检测到数据不一致时能够撤销错误的更新。

文档和测试:

确保有详细的文档记录你的数据处理逻辑和 Redis 的使用方式,并进行充分的测试,以确保在各种情况下都能保证数据的一致性和正确性。

需要注意的是,Flink 和 Redis 的组合使用可能会引入复杂性,特别是在处理高并发和分布式环境中的数据一致性问题时。因此,仔细设计你的解决方案,并进行充分的测试和验证,以确保系统的稳定性和可靠性。

在使用Flink进行多并发sink更新Redis值时,确保数据按照事件时间更新并保证一致性是一个重要的考虑因素。以下是一些方法和最佳实践:

使用窗口操作:在Flink中,可以使用窗口操作来处理事件时间。通过定义窗口,可以指定一个时间间隔,在这个时间间隔内的事件将被聚合或处理。这样可以确保数据按照事件时间进行更新。

使用Watermark机制:Watermark是Flink中用于处理乱序数据的一种机制。通过设置合适的Watermark延迟,可以确保即使有乱序事件到达,也能正确地按照事件时间进行处理。

使用Redis事务:Redis支持事务功能,可以通过MULTI、EXEC、DISCARD和WATCH命令来实现。在更新Redis值之前,可以使用WATCH命令监视相关键,然后在事务中执行更新操作。这样,如果多个并发sink尝试同时更新同一个键,只有一个事务能够成功提交,从而保证数据的一致性。

使用Redis锁:另一种方法是使用Redis的SETNX或SET key value NX EX seconds命令来实现分布式锁。在更新Redis值之前,先尝试获取锁,如果成功获取到锁,则执行更新操作,然后释放锁。这样可以确保同一时刻只有一个并发sink能够更新数据。

序列化和反序列化:确保在Flink任务中使用正确的序列化和反序列化方式,以保证数据在传输过程中的完整性。

幂等性:设计更新操作具有幂等性,即多次执行相同的操作结果相同。这样即使有多个并发sink同时更新同一个键,最终的结果也是一致的。

监控和日志:实施适当的监控和日志记录机制,以便及时发现和解决潜在的一致性问题。

综上所述,通过使用Flink的窗口操作、Watermark机制,结合Redis的事务、锁以及幂等性设计,可以有效地保证多并发sink更新Redis值时的数据一致性和按事件时间更新。

在 Flink 中实现多并发 Sink 更新 Redis 值,并且保证数据按事件时间来更新以及保证一致性,可以通过以下步骤来实现:

确保 Flink 作业在处理数据时使用事件时间,而不是处理时间(Processing Time)。通过在 Flink 程序中配置 Watermark 和 Event Time,可以确保事件按照事件时间顺序进行处理。

编写自定义的 Redis Sink,其中需要考虑以下几点来保证数据能按照事件时间更新到 Redis,并保证一致性:

在 Flink 作业中设置适当的并行度,确保每个 Redis Sink 实例处理的数据量适中,避免数据倾斜和性能问题。同时,合理分配资源,例如内存、CPU 等,以确保每个 Sink 实例能够有效地处理数据。

建议在作业中加入监控机制,及时监控 Sink 更新到 Redis 的情况。同时,考虑实现故障恢复机制,例如检测更新失败并进行重试,以确保数据的一致性和完整性。

通过以上步骤,可以保证在 Flink 中多并发更新 Redis 值时,数据能按事件时间更新到 Redis,并且保证更新的一致性。自定义 Sink 的实现需要考虑事件时间的处理、原子性更新和并发处理等方面,以确保数据更新的正确性和可靠性。

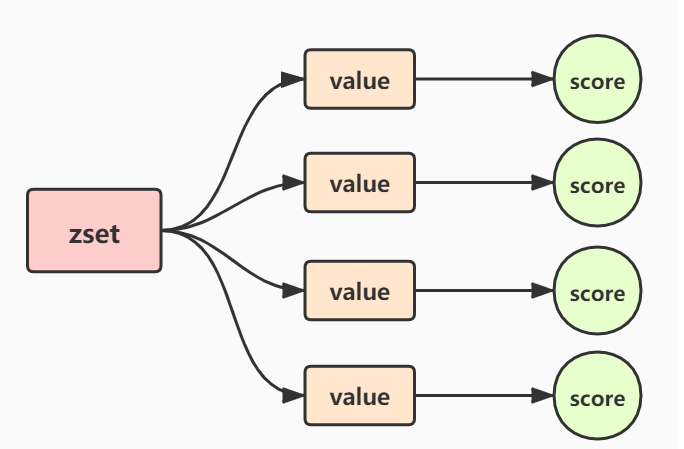

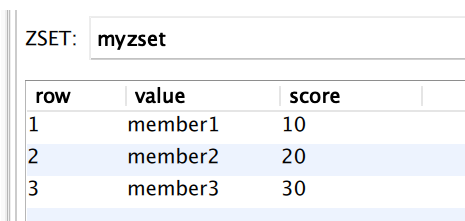

Redis提供了如ZSET(有序集合)这样的数据结构,它允许你存储带有分数(通常用作排序的关键)的字符串。你可以使用时间戳作为分数,这样你可以根据时间戳对元素进行排序和检索。

使用ZADD命令来添加或更新元素,并使用ZRANGE或ZREVRANGE来检索元素。这样,当你尝试更新一个键时,你可以首先检查该键是否已存在,并且它的时间戳是否小于你要更新的时间戳。如果是,则进行更新。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。