测试效果比较好的模型;

测试效果比较好的模型;

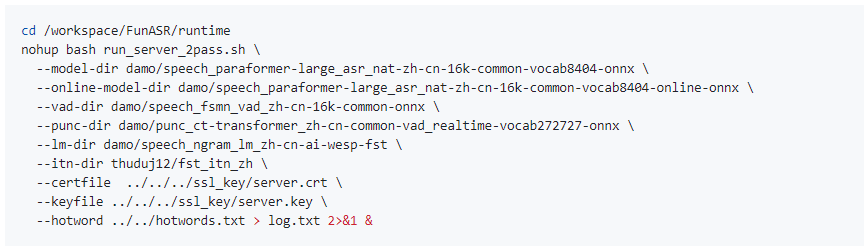

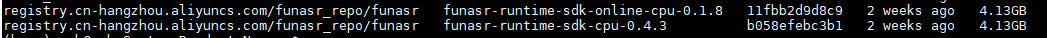

这个是通过docker运行的模型。请问modelscope-funasr这个是不是pt和onnx不是同一个模型转换的?

最新的两个docker版本都下载测试了,效果比较差,没有直接用model = AutoModel效果好。

根据知识库中的信息,以下模型在测试中表现较好: - 语音合成模型:damo/speech_sambert-hifigan_tts_zh-cn_16k,该模型能够生成高质量的语音合成结果。 - 文本向量模型: - damo/nlp_bert_entity-embedding_chinese-base(中文通用领域,向量维度768)。 - thomas/text2vec-large-chinese(中文大模型,向量维度1024)。 - DeepSeek-R1系列模型:如/deepseek-r1-7b,在推理任务中表现出色,例如对“云计算”和“容器”的定义生成了逻辑清晰且准确的回答。

如果您正在寻找特定领域的模型,建议优先选择上述经过验证的模型进行测试。

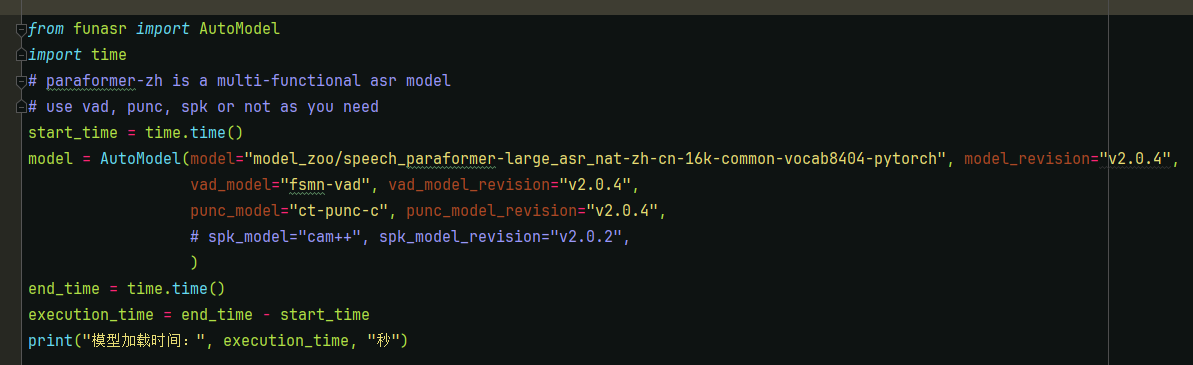

根据知识库中的描述,modelscope-funasr的安装和使用主要基于PyTorch(PT)框架。然而,关于其ONNX版本的说明并未明确提及。通常情况下,PyTorch模型可以通过工具(如torch.onnx.export)转换为ONNX格式,但转换后的模型可能会因以下原因导致性能差异: - 算子支持问题:某些PyTorch算子可能无法完全映射到ONNX,导致精度损失。 - 优化差异:ONNX模型通常需要通过TensorRT等工具进一步优化,以提升推理性能。如果未进行优化,ONNX模型的性能可能不如原生PyTorch模型。 - 动态输入支持:如果模型的输入形状是动态的(如批量大小可变),ONNX模型可能需要额外配置dynamic_axes参数,否则可能导致推理失败或效果下降。

因此,modelscope-funasr的PT和ONNX版本可能不是完全一致的模型,尤其是在未经充分优化的情况下。

您提到通过Docker运行的模型效果较差,可能的原因包括以下几点: 1. 环境配置问题: - Docker镜像中可能缺少必要的依赖项或优化工具(如TensorRT),导致模型性能下降。 - 硬件加速(如GPU)未正确配置,可能导致推理速度慢或精度降低。 2. 模型版本不一致: - Docker镜像中的模型版本可能与直接使用AutoModel加载的版本不同,导致效果差异。 3. 推理参数设置: - 模型的推理参数(如temperature、max_tokens等)可能未调整到最佳状态,影响输出质量。 4. 数据预处理差异: - Docker环境中可能对输入数据的预处理方式与本地环境不一致,导致模型表现不佳。

为了提升Docker运行模型的效果,您可以尝试以下方法: 1. 检查模型版本一致性: - 确保Docker镜像中的模型版本与直接使用AutoModel加载的版本一致。 2. 优化ONNX模型: - 如果使用ONNX格式,建议通过TensorRT对模型进行优化,确保推理性能达到最佳。 3. 调整推理参数: - 根据具体任务需求,调整temperature、max_tokens等参数,以获得更优的输出效果。 4. 验证硬件加速: - 确保Docker容器能够正确访问GPU资源,并安装了必要的驱动和CUDA库。 5. 对比测试: - 在相同环境下分别测试PT和ONNX模型的表现,找出性能差异的根本原因。

综上所述,modelscope-funasr的PT和ONNX模型可能存在差异,尤其是在未经优化的情况下。建议您优先使用经过验证的模型(如damo/speech_sambert-hifigan_tts_zh-cn_16k或/deepseek-r1-7b),并针对Docker环境进行详细配置和优化,以提升模型的推理效果。