Flink CDC里dinky 最新1.0.0-rc3 启动报错,是我部署问题么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

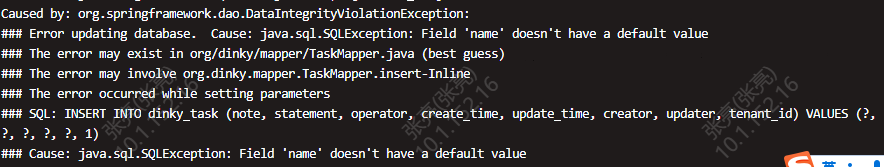

根据您提供的问题描述,Flink CDC中使用Dinky最新版本(1.0.0-rc3)启动时出现报错,可能是由于部署配置或环境问题导致的。以下是可能的原因及解决方案,供您参考:

如果您的作业中使用了自定义连接器(如MySQL CDC连接器),但未将其上传到OSS(对象存储服务),可能会导致作业无法正常运行。

解决方案: - 确保所有自定义连接器已正确上传到OSS。 - 在作业配置中指定正确的连接器路径。

Dinky 1.0.0-rc3 可能依赖特定版本的Flink CDC连接器。如果使用的Flink引擎版本与连接器版本不匹配,可能会导致启动失败。

解决方案: - 检查Dinky官方文档,确认其支持的Flink版本范围。 - 确保使用的Flink CDC连接器版本与Flink引擎版本兼容。例如: - 如果使用 flink-sql-connector-mysql-cdc,建议选择稳定版本(如 flink-sql-connector-mysql-cdc-2.1.0.jar),而不是SNAPSHOT版本。

如果您的MySQL数据库的Binlog格式为Mixed或Statement,而Flink CDC要求ROW格式,可能会导致解析失败。

解决方案: - 登录MySQL服务器,执行以下命令检查并修改Binlog格式:

SHOW VARIABLES LIKE 'binlog_format';

SET GLOBAL binlog_format=ROW;

如果数据库用户缺少必要的权限,可能会导致CDC作业无法正确读取表结构或数据变更事件。

解决方案: - 确认数据库用户是否具有以下权限: - REPLICATION SLAVE - REPLICATION CLIENT - SELECT 权限(针对目标表) - 如果权限不足,请联系DBA进行授权。

如果工作空间的CU(计算单元)资源已耗尽,可能会导致任务启动失败。

解决方案: - 检查当前工作空间的资源使用情况。 - 如果资源不足,可以尝试: - 扩容工作空间的CU数量。 - 减少作业请求的资源(如内存、CPU)。

如果上述步骤未能解决问题,请查看Flink作业的日志,定位具体的错误原因。常见错误包括: - Schema不匹配:Encountered change event for table xxx.xxx whose schema isn't known to this connector。 - 解决方案: - 确保 'debezium.snapshot.mode' 配置为非 never 模式。 - 添加参数 'debezium.inconsistent.schema.handling.mode' = 'warn'。 - GTID不可用:The connector is trying to read binlog starting at GTIDs ..., but this is no longer available on the server。 - 解决方案: - 增加Binlog保留时间: sql SET GLOBAL expire_logs_days=7;

Dinky作为Flink SQL的开发平台,其配置可能影响作业的启动。请确保以下配置正确: - Flink集群地址:Dinky需要正确连接到Flink集群。 - 依赖管理:确保所有依赖(如CDC连接器)已正确加载到Dinky的classpath中。

以上是可能导致Flink CDC在Dinky中启动失败的常见原因及解决方案。建议您按照以下步骤逐一排查: 1. 检查自定义连接器是否上传至OSS。 2. 确认Flink引擎与CDC连接器版本兼容。 3. 修改MySQL Binlog格式为ROW。 4. 确保数据库用户具有必要权限。 5. 检查工作空间资源配额。 6. 查看日志定位具体错误,并根据错误信息调整配置。

如果问题仍未解决,请提供具体的错误日志,以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。