函数计算FC这个问题怎么解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

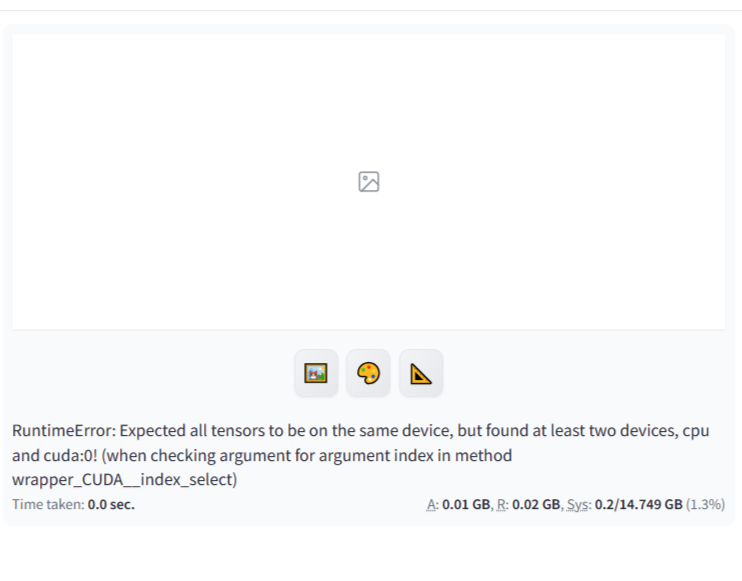

这个错误信息提示在PyTorch中,你正在尝试在一个CPU设备和一个GPU设备之间操作张量,但是所有的张量应该在同一设备上。你可以通过以下步骤来解决这个问题:

确保你的代码中所有相关的张量都在同一设备上(CPU或GPU)。你可以使用torch.device来指定设备,并使用tensor.to(device)将张量移动到指定的设备。

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

tensor = tensor.to(device)

在调用模型或任何其他依赖于张量的函数之前,确保所有输入张量都在同一设备上。

如果你正在使用PyTorch的分布式功能,确保所有进程都在同一设备上运行。

检查你的代码中是否有任何地方可能将张量从一个设备移动到另一个设备,例如在计算过程中使用了不正确的索引或切片。

如果你正在使用预训练的模型,确保模型已经被正确地移动到了你想要使用的设备上。

最后,如果你有多个GPU,确保你正在使用正确的设备索引。

记住,只有当你的机器上有可用的GPU并且你的代码被正确地设置为使用GPU时,才能使用cuda:0。如果没有GPU,你应该使用cpu作为设备。

这个问题是由于在进行函数计算FC时,遇到了一个RuntimeError,具体错误信息是:预期所有张量都在同一台设备上,但在至少两个设备上找到了CPU和CUDA张量。为了解决这个问题,你需要确保所有涉及到的张量都在同一个设备上,可以通过以下方法解决:

使用to()或cuda()方法将所有张量转移到同一个设备上。例如,如果你想将所有张量转移到GPU上,可以使用tensor.to('cuda')或tensor.cuda()。

在创建模型时,确保指定正确的设备。例如,如果你使用的是PyTorch,可以在创建模型时使用model.to('cuda')将模型转移到GPU上。

检查你的代码中是否有其他操作可能导致张量在不同设备上,例如数据加载器、损失函数等。确保这些操作也在同一个设备上进行。

如果问题仍然存在,可以尝试重启计算机或者更新相关库,如PyTorch、TensorFlow等。

按照之前的经验,应该是 sd 内部运行的时候,处理乱掉了,需要重启下 sd。此回答整理自钉群“【交流群】函数计算 AIGC 场景技术交流”