大数据计算MaxCompute的desc extended 命令报错怎么办?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

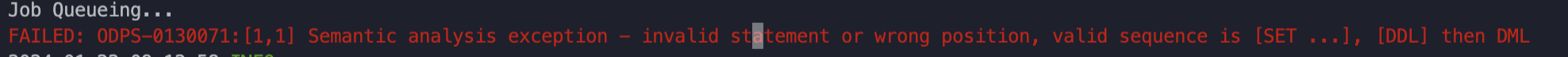

在使用MaxCompute的desc extended命令时,如果遇到报错,可能是由于多种原因导致的。以下是针对可能问题的详细分析和解决措施:

如果报错信息中提到与Tunnel Endpoint相关的问题(例如Failed to create download session with tunnel endpoint),需要检查并修正Tunnel Endpoint的配置。

验证Tunnel Endpoint是否可访问

在报错设备的命令行窗口,使用curl命令连接报错信息中的Tunnel Endpoint,验证其是否可以正常访问。

curl <tunnel_endpoint>

aliyun.com结尾。aliyun-inc.com结尾。网络连通性检查

确保访问的网络环境与Tunnel Endpoint匹配。例如,外网设备不能直接访问VPC网络的Endpoint。

当表或分区的文件数量过多时,执行desc extended命令可能会超时或报错。

查看表或分区的文件数量

使用以下命令查看表或分区的文件数量:

desc extended <table_name> [partition(partition_spec)];

返回结果中的FileNum字段表示文件数量。

合并小文件

如果文件数量超过1000个,建议合并小文件以优化性能:

set odps.merge.cross.paths=true;

set odps.merge.max.partition.count=100; -- 默认优化10个分区,此处设置为优化100个分区

ALTER TABLE <table_name> [partition] MERGE SMALLFILES;

注意:聚簇表(Clustering Table)不支持通过MERGE SMALLFILES方法进行合并优化。

如果用户没有足够的权限访问表或分区,执行desc extended命令可能会报错。

检查权限配置

确保当前用户对目标表或分区具有DESCRIBE权限。如果没有权限,请联系项目管理员授予相应权限。

下载行级权限表时的特殊处理

如果表启用了行级权限,desc extended命令会返回执行数据过滤SQL的信息。确保行级权限配置正确,并且用户满足过滤条件。

如果目标表是外部表(如Tablestore或OSS外部表),可能存在外部存储配置错误或数据格式不匹配的问题。

检查外部表配置

执行以下命令查看外部表的详细信息:

desc extended <table_name>;

检查返回的Extended Info部分,确认StorageHandler和Location等配置是否正确。

脏数据处理

如果外部表存在脏数据,可能导致desc extended命令失败。可以通过以下参数调整脏数据处理方式:

set tablestore.read.mode=permissive; -- 跳过脏数据

set tablestore.corrupt.column=<column_name>; -- 指定脏数据写入列

注意:tablestore.corrupt.column只能指定为外部表的最后一列,且不能是主键列。

如果上述方法均未解决问题,可以尝试以下通用排查步骤:

确保使用的MaxCompute客户端版本支持desc extended命令。建议升级到最新版本(如v0.46.5-public及以上)。

通过Logview工具获取作业的详细日志信息,定位具体报错原因:

WAIT <instance_id>

Logview链接会显示作业的执行状态和错误详情。

如果问题仍然存在,尝试清理本地缓存后重新执行命令。

通过以上步骤,您可以逐步排查并解决desc extended命令报错的问题。如果问题仍未解决,请提供具体的报错信息以便进一步分析。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。