Flink CDC里配置这2个监听的时候为什么不能创建topic,写数据进进kafka,还需要自己再写一个KafkaProducer吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

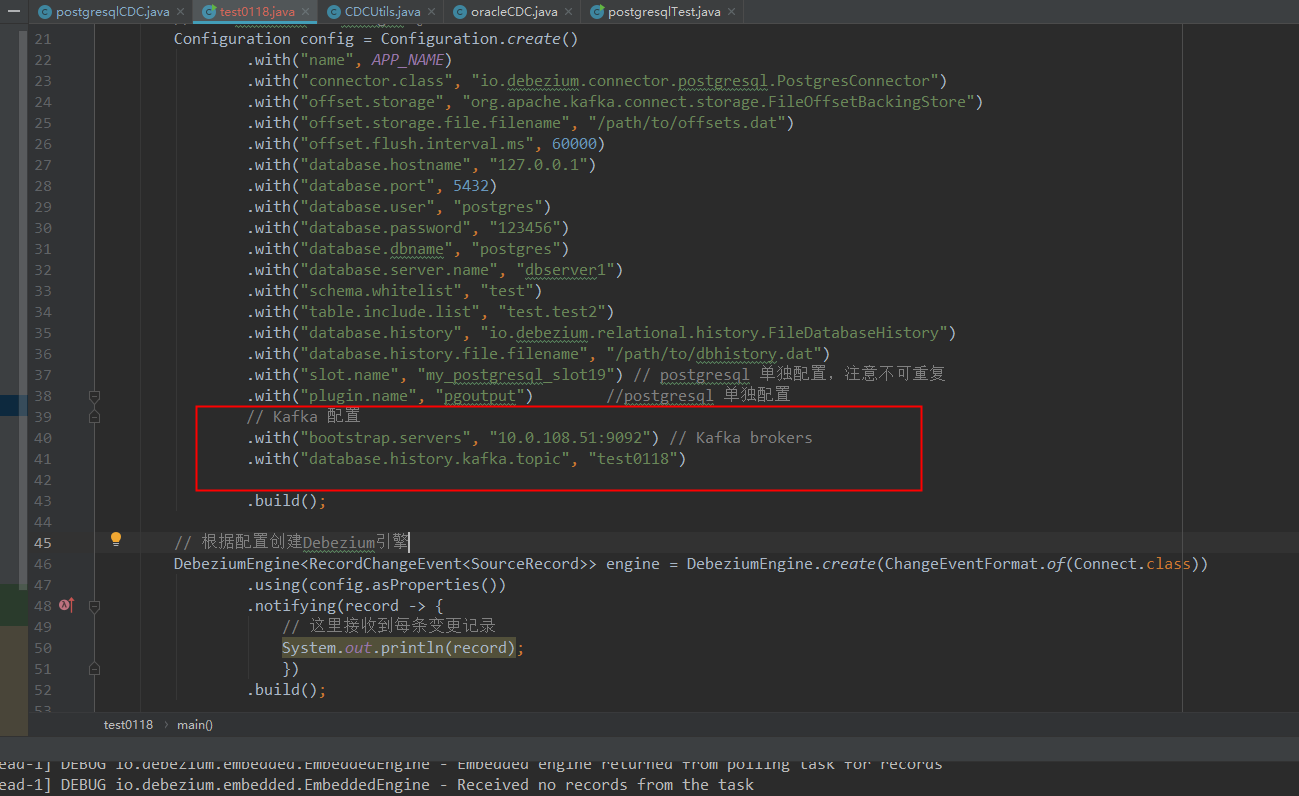

在使用 Flink CDC 将数据写入 Kafka 时,如果无法自动创建 Topic 并写入数据,可能与以下几个关键因素有关。以下是详细分析和解决方案:

阿里云消息队列 Kafka 版默认不开启自动创建 Topic 功能。这意味着,如果目标 Topic 不存在,Flink CDC 不会自动为您创建 Topic,而是需要您手动预先创建对应的 Topic。

Flink CDC 的 Kafka Sink 配置中,如果没有正确设置 topic 或 route 模块,可能会导致数据无法写入 Kafka。

topic 参数:如果未显式指定 topic,Flink CDC 默认会根据表名生成 Topic 名称(格式为 databaseName.tableName)。如果该 Topic 不存在且未开启自动创建功能,则写入会失败。route 模块:通过 route 模块可以自定义源表与目标 Topic 的映射关系。如果未正确配置 route,可能导致数据无法写入预期的 Topic。sink:

type: kafka

name: Kafka Sink

properties.bootstrap.servers: ${kafka.bootstraps.server}

topic: kafka_test # 显式指定目标 Topic

通常情况下,Flink CDC 的 Kafka Sink 已经内置了 KafkaProducer 的功能,无需额外编写 KafkaProducer。但如果遇到以下情况,可能需要手动实现 KafkaProducer:

all-to-zero 和 hash-by-key),但如果需要更复杂的分区逻辑,可能需要自定义 Producer。Properties props = new Properties();

props.put("bootstrap.servers", "${kafka.bootstraps.server}");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

KafkaProducer<String, String> producer = new KafkaProducer<>(props);

ProducerRecord<String, String> record = new ProducerRecord<>("kafka_test", "key", "value");

producer.send(record);

producer.close();

幂等性配置:阿里云消息队列 Kafka 版不支持幂等和事务写入。作为数据摄入目标端时,需要在 Flink CDC 的配置中显式关闭幂等写入功能:

properties.enable.idempotence: false

权限问题:确保 Flink 全托管实例所在的 VPC 网段已添加到 Kafka 白名单中,否则可能导致网络连接失败。

Flink CDC 本身已经具备将数据写入 Kafka 的能力,但在以下情况下可能需要额外操作: 1. 如果目标 Topic 不存在且未开启自动创建功能,则需要手动创建 Topic。 2. 如果有复杂的数据转换或分区需求,可能需要手动实现 KafkaProducer。 3. 确保正确配置 topic 或 route 模块,并检查 Kafka 的权限和网络连通性。

通过以上步骤,您可以解决 Flink CDC 写入 Kafka 时无法创建 Topic 的问题,并避免额外编写 KafkaProducer 的需求。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。