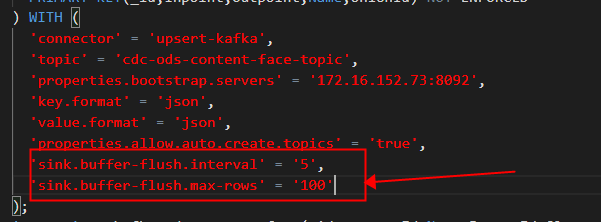

Flink CDC里请问upsert-kafka增加参数: 'sink.buffer-flush.interval' = '5', 'sink.buffer-flush.max-rows' = '100'后报错是什么原因?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

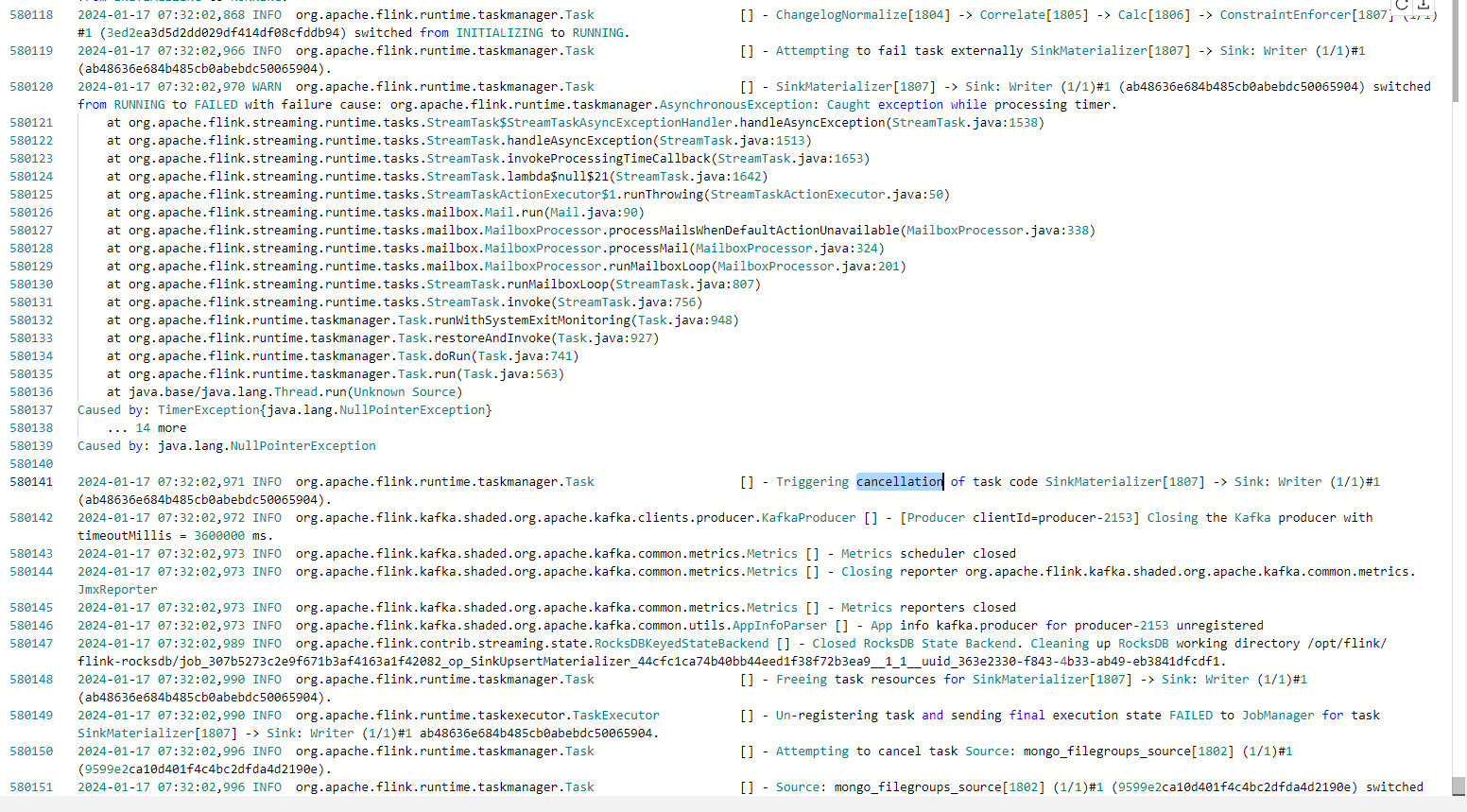

根据您提供的错误信息和截图,问题可能出在以下几个方面:

参数设置错误:请检查您的Flink CDC配置中的'sink.buffer-flush.interval'和'sink.buffer-flush.max-rows'参数是否正确设置。这两个参数分别表示缓冲区刷新的时间间隔和最大行数。请确保它们的值是合法的整数。

依赖版本不兼容:请检查您的Flink CDC连接器(如Debezium)和Kafka的版本是否兼容。如果不兼容,可能会导致配置错误或运行时错误。您可以查阅相关文档或社区讨论,了解不同版本之间的兼容性情况。

日志输出:查看Flink CDC的日志输出,以获取更详细的错误信息。日志中可能会包含有关错误的详细信息,帮助您定位问题所在。

网络连接问题:如果您的网络连接不稳定或存在防火墙限制,可能导致与Kafka的连接出现问题。请检查您的网络环境,确保Flink CDC能够正常连接到Kafka。

资源限制:如果Flink集群的资源不足,可能导致任务无法正常运行。请检查您的Flink集群资源使用情况,如有需要,可以调整资源配置以满足需求。

建议您根据以上建议逐一排查问题,找到具体原因并进行修复。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。