Flink CDC里这种报错是为什么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

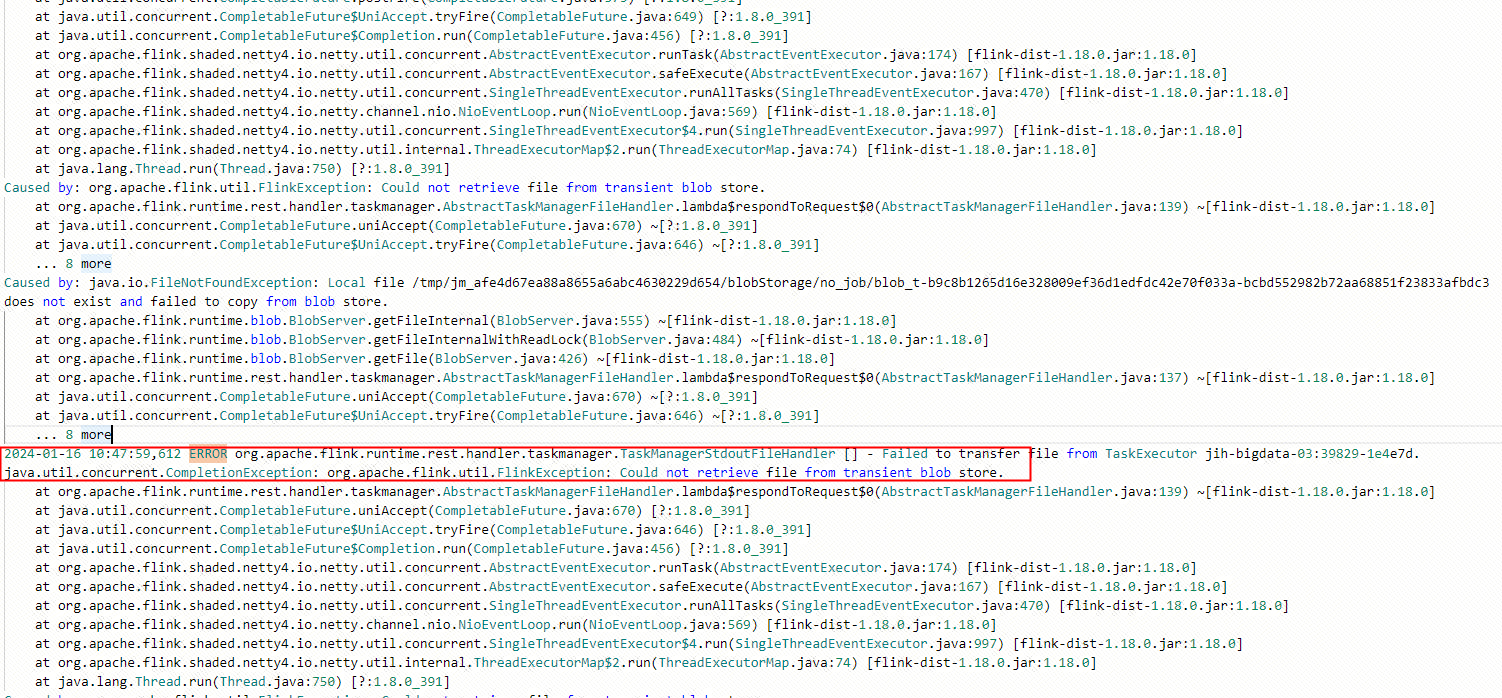

根据您提供的报错信息,以下是可能的原因及对应的解决方案。由于未明确具体的报错内容,请参考以下常见问题及其原因分析:

报错原因

PostgreSQL的CDC(Change Data Capture)作业中,当作业异常停止时,未正确释放复制槽(Replication Slot),导致该槽被标记为“active”,无法重新使用。

解决方案

可以通过以下两种方式解决: - 手动释放slot

在PostgreSQL中执行以下命令:

SELECT pg_drop_replication_slot('rep_slot');

如果遇到错误ERROR: replication slot "rep_slot" is active for PID xxxxx,说明slot正在被某个进程占用。需要先终止该进程,再释放slot:

SELECT pg_terminate_backend(162564);

SELECT pg_drop_replication_slot('rep_slot');

'debezium.slot.drop.on.stop' = 'true'

警告:启用此参数会导致WAL日志被回收,重启作业时可能导致数据丢失,无法保证At-Least-Once语义。

报错原因

MySQL的Binlog格式设置不正确,当前格式为STATEMENT或MIXED,而Flink CDC要求Binlog格式为ROW。

解决方案

1. 检查当前Binlog格式:

SHOW VARIABLES LIKE 'binlog_format';

ROW:

SET GLOBAL binlog_format = 'ROW';

报错原因

Debezium在捕获变更事件时,发现表的Schema信息未知。可能是由于表结构发生了变更,但CDC连接器未及时更新Schema信息。

解决方案

1. 确保表结构变更后,上游有新增数据或数据变更触发Schema同步。 2. 如果问题依旧存在,可以尝试重启作业,并确保scan.incremental.snapshot.enabled参数设置为true。

报错原因

PostgreSQL表的REPLICA IDENTITY未设置为FULL,导致更新或删除事件的before字段为空。

解决方案

执行以下SQL命令,将表的REPLICA IDENTITY设置为FULL:

ALTER TABLE yourTableName REPLICA IDENTITY FULL;

如果问题仍未解决,可以在作业配置中添加以下参数:

'debezium.slot.drop.on.stop' = 'true'

报错原因

1. 配置的表名在数据库中不存在。 2. Flink作业使用的账号没有访问某些数据库的权限。

解决方案

1. 检查配置的表名是否存在于数据库中。 2. 确保Flink作业使用的账号具有所有相关数据库的访问权限。

报错原因

在MySQL CDC源表中启用了增量快照功能(scan.incremental.snapshot.enabled),但表缺少主键。

解决方案

为表添加主键,或者禁用增量快照功能:

'scan.incremental.snapshot.enabled' = 'false'

报错原因

自建DNS域名解析延迟较大,导致TaskManager无法及时响应JobManager的心跳请求。

解决方案

在作业配置中关闭TaskManager的域名解析:

jobmanager.retrieve-taskmanager-hostname: false

报错原因

Flink与Kafka之间的网络连通性存在问题,可能是Kafka Broker返回的Endpoint无法被Flink访问。

解决方案

1. 使用ZooKeeper工具检查Kafka Broker的metadata信息:

zkCli.sh

ls /brokers/ids

get /brokers/ids/{your_broker_id}

以上是Flink CDC常见报错的原因及解决方案。如果您能提供具体的报错信息,我们可以进一步定位问题并提供更精确的解答。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。