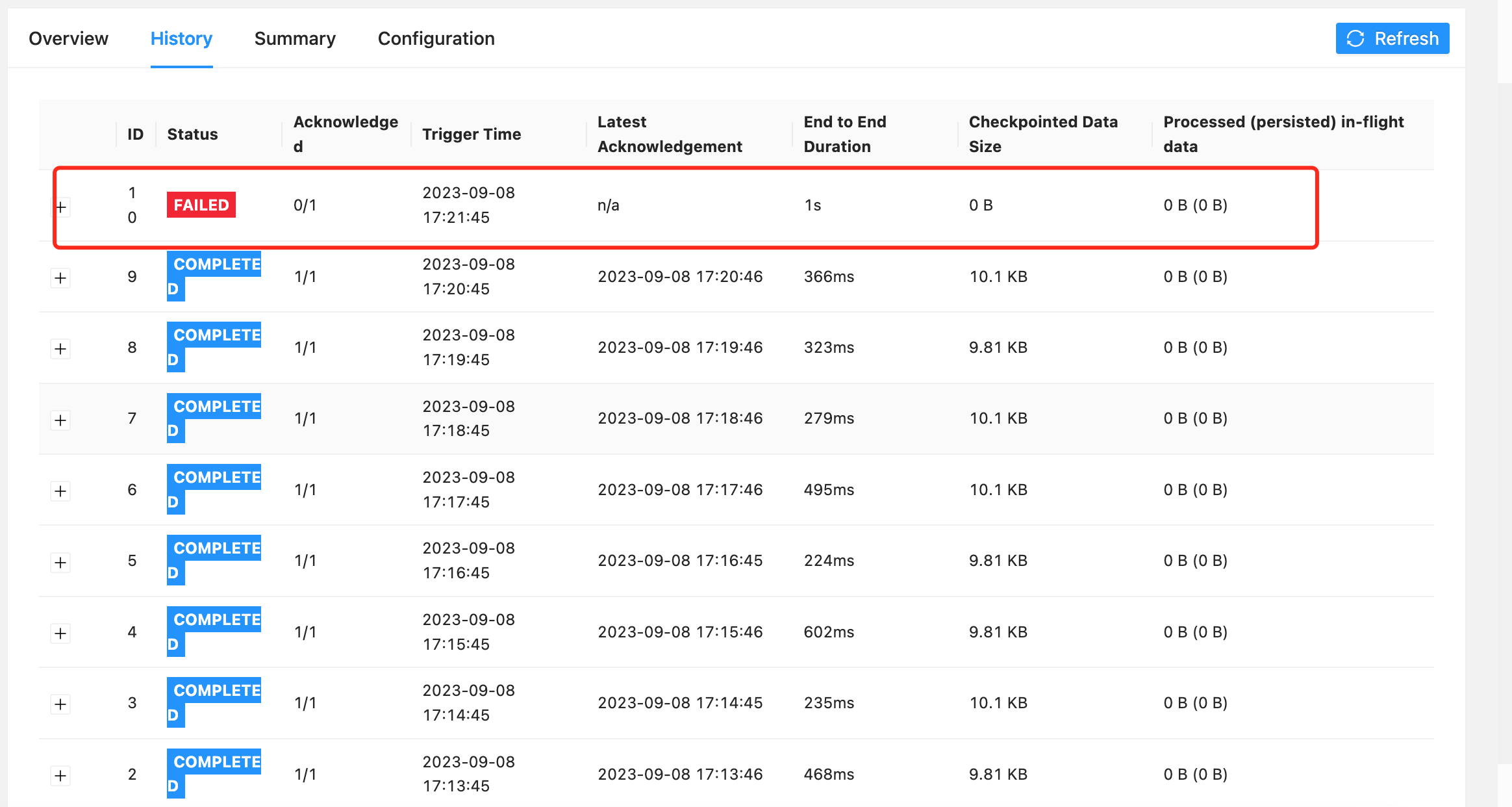

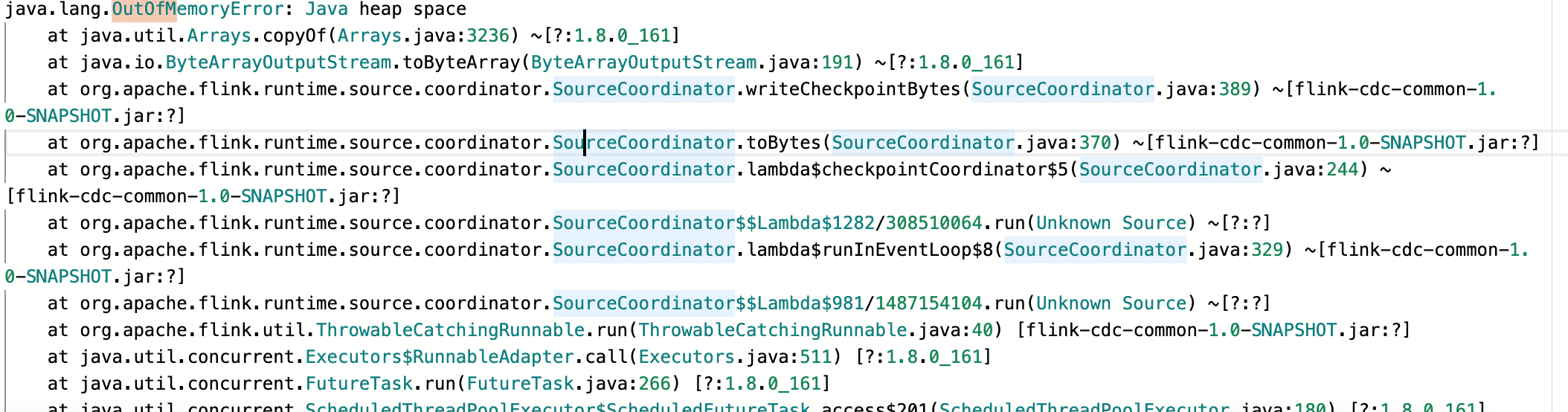

有人遇到过Flink CDC这种类似的问题吗?拉全量的时候做checkpoint失败,checkpoint明明只有几k但是确报:java.lang.OutOfMemoryError: Java heap space

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

是的,有人遇到过类似的问题。Flink CDC 在拉取全量数据时,如果 Checkpoint 失败并且报错为 "java.lang.OutOfMemoryError: Java heap space",通常是因为系统内存不足导致的。

这种情况可能是由于以下原因之一引起的:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。