Flink CDC中,我使用多个cdc连接器有冲突,有人有用多个Flink CDC的经验吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

你是同时引入了 多个cdc的connector吧,我记得 mysql 和MongoDB的 cdc 是冲突的, pg 和mysql 底层都是debezium 应该不会冲突 ,此回答整理自钉群“Flink CDC 社区”

是的,用户可以在 Flink 中同时使用多个CDC(Change Data Capture, 数据变更捕获)源。每个CDC源都可以处理不同的数据流,从而实现多路输入的数据处理需求。这样做的好处是可以提高数据管道的灵活性和可扩展性,使得能够更好地应对不同来源的变化数据。

然而,需要注意的是,虽然理论上可以通过这种方式支持多种数据源,但在实践中还需要考虑到以下几个方面:

性能优化: 多个CDC源会导致更多的并发请求,因此需要评估整个集群资源分配的有效性和负载均衡能力。否则,过多的并发请求可能会消耗大量的CPU和内存资源,甚至引发性能瓶颈等问题。

监控和管理复杂度增加: 在单个 CDC 源的情况下,管理和监控相对简单;而如果有多个 CDC 源,就需要额外关注各个源头之间的协调工作,防止因为某个源头出现问题而导致整体流程中断。

兼容性和稳定性: 不同的 CDC 提供商可能存在一些差异,比如 API 接口、版本要求等都可能有所不同。为了保证稳定性和兼容性,建议选择经过验证且具有良好社区支持的产品和服务提供商。

成本效益分析: 虽然引入多个 CDC 源有助于提升数据处理效率,但同时也增加了运维的成本。所以在决定采用这种方案之前,应该进行详细的成本效益分析,权衡利弊后再做决策。

是的,Flink CDC支持多个CDC连接器。你可以根据需要配置不同的连接器来同步不同数据库表的数据。每个连接器都有自己的配置参数和连接信息,可以根据具体情况进行选择和配置。

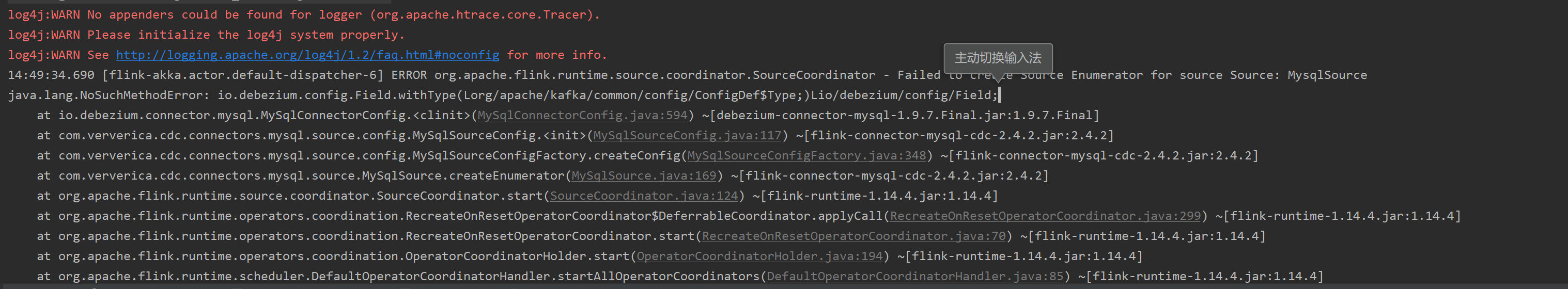

关于你提到的日志警告信息,它表示没有找到适合的appender来处理loggen(org.apache.htrace.core.Tracer)的日志。这可能是因为缺少了适当的日志配置文件或初始化日志系统的方式不正确。

要解决这个问题,你需要确保你的项目中包含了正确的日志配置文件,并且正确地初始化了Log4j系统。你可以按照以下步骤进行操作:

检查项目的依赖中是否包含了Log4j的相关库。确保你的项目中包含了log4j-api、log4j-core等必要的依赖。

在项目的类路径下创建一个名为log4j.properties的文件,用于配置Log4j的日志输出方式和格式。你可以根据你的需求自定义该文件的内容。

确保你的代码中正确导入了Log4j相关的类,并使用Log4j提供的API进行日志记录。例如,你可以使用Logger类来获取日志对象,并使用info()、warn()、error()等方法记录不同级别的日志。

下面是一个示例的Log4j配置文件内容:

# 设置日志级别为INFO

log4j.rootLogger=INFO, console

# 配置控制台输出

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.Target=System.out

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %-5p %c{1}:%L - %m%n

请根据你的实际项目需求修改配置文件的内容,并确保正确导入了Log4j相关的类。这样应该可以解决你遇到的日志警告问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。