Flink CDC文档的案例都跑不起来怎么办?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

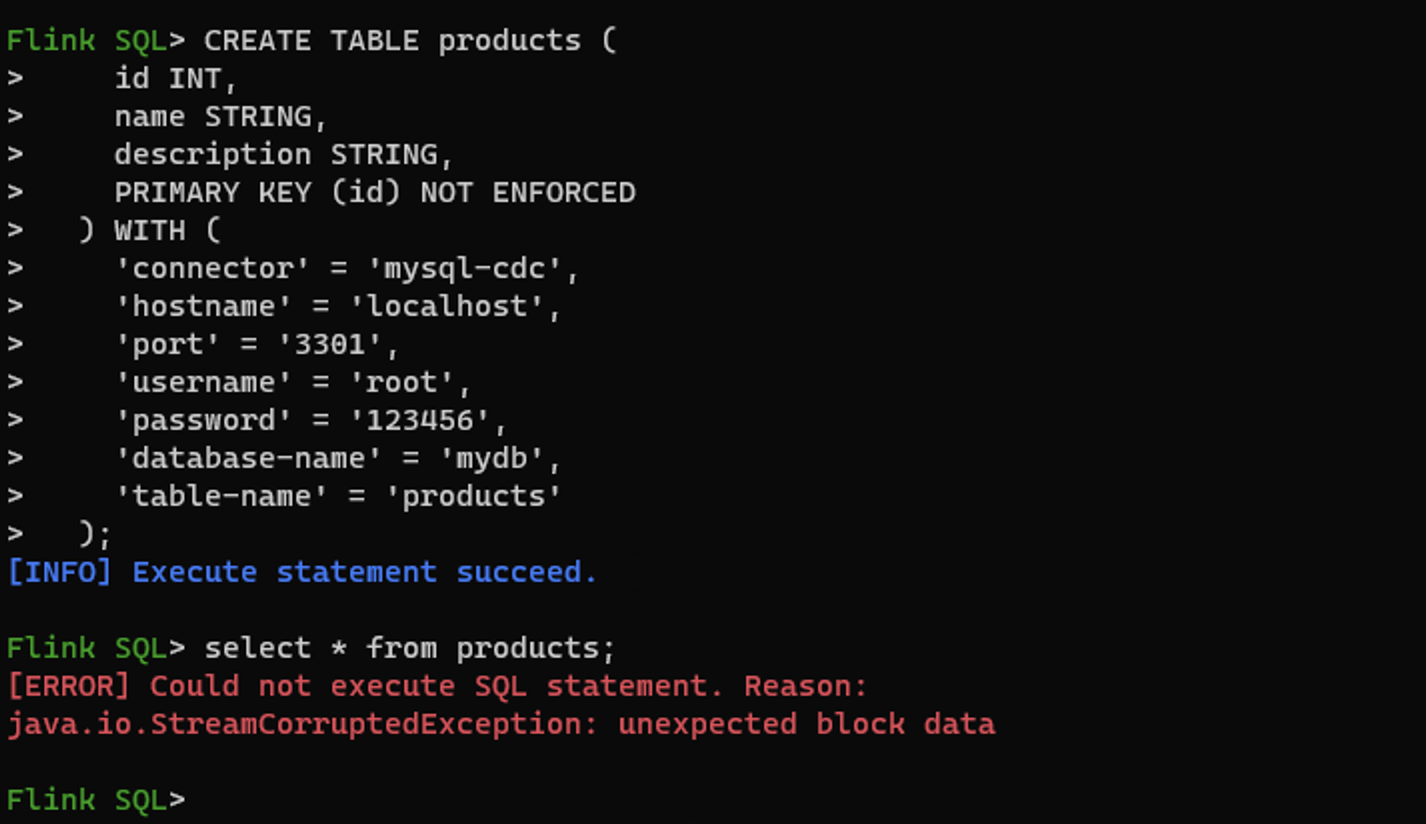

如果在运行Flink CDC文档中的案例时遇到问题,可以按照以下步骤进行排查和解决:

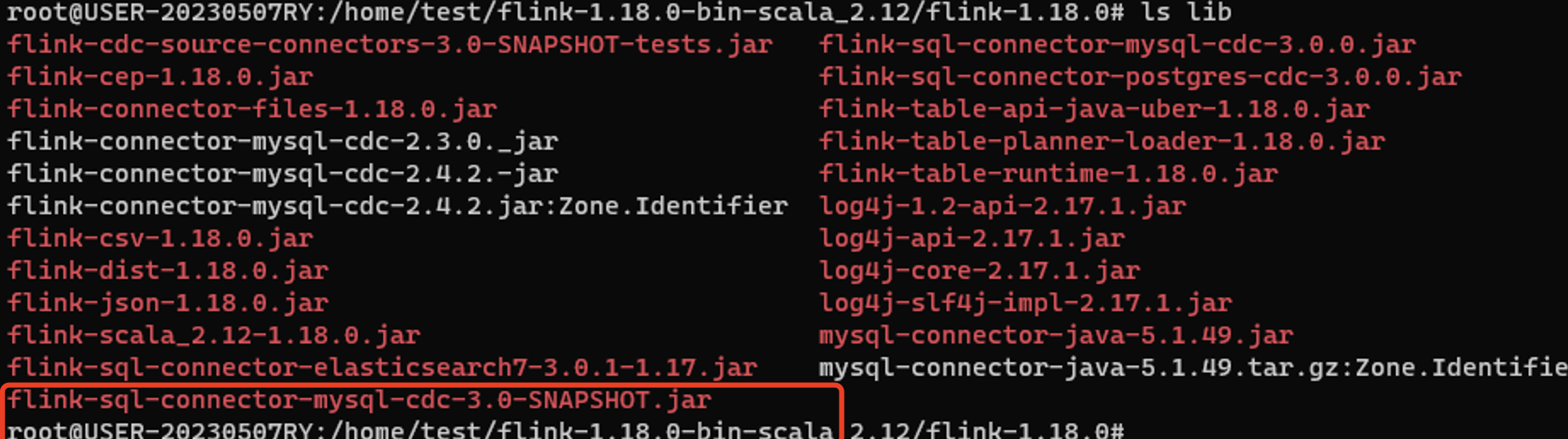

确保您的运行环境满足Flink CDC的最低要求: - Flink版本:确认您使用的Flink版本与CDC连接器兼容。例如,某些CDC功能可能需要特定版本的Flink支持。 - 依赖库:确保所有必要的依赖库(如Debezium、MySQL驱动等)已正确添加到项目中。可以通过Maven或手动下载JAR文件的方式引入依赖。 - 数据库权限:检查MySQL用户是否具有读取Binlog的权限。例如,REPLICATION SLAVE和REPLICATION CLIENT权限是必须的。

Flink CDC作业的配置参数对运行结果至关重要。请逐一检查以下关键配置: - MySQL连接信息: - 确保hostname、port、username和password正确无误。 - 如果使用RDS MySQL,建议避免使用只读实例或备库,因为这些实例可能不支持增量数据读取。 - 表名匹配规则: - 如果使用正则表达式匹配表名,请确保正则表达式符合Debezium的要求。例如,避免在正则表达式中使用逗号,改用括号组合多个表达式。 sql 'table-name' = '(t_process_wi_history_\d{1}|t_process_wi_history_\d{2})' - 重启策略: - 默认情况下,Flink会尝试重启失败的作业。如果希望作业失败后彻底退出,可以修改重启策略: yaml restart-strategy: fixed-delay restart-strategy.fixed-delay.attempts: 2 restart-strategy.fixed-delay.delay: 10 s

根据知识库中的常见问题,以下是一些可能的错误及其解决方案:

SHOW VARIABLES LIKE 'binlog_expire_logs_seconds';

如果值过小,建议调整为更大的值(例如7天)。

useSSL=false或allowPublicKeyRetrieval=true参数。GRANT DELETE ON database_name.table_name TO 'userName'@'%';

FLUSH PRIVILEGES;

log4j.properties中设置:

logger.flink.name = org.apache.flink

logger.flink.level = DEBUG

execution.checkpointing.interval: 60000 # 每60秒触发一次Checkpoint

窗口函数替代方案: 如果案例中涉及窗口函数,而MySQL CDC源表不支持窗口函数,可以使用非窗口聚合实现类似效果。例如:

SELECT

shop_id,

DATE_FORMAT(order_ts, 'yyyy-MM-dd HH:mm') AS window,

COUNT(*) AS order_count,

SUM(price) AS amount

FROM order_mysql_cdc

GROUP BY shop_id, window

重复事件处理: 在故障场景下,CDC工具(如Canal、Maxwell)可能会投递重复的变更事件。建议启用去重机制:

table.exec.source.cdc-events-duplicate: true

并在源表上定义主键以生成规范化的changelog流。

如果以上方法仍无法解决问题,建议联系阿里云技术支持团队,提供以下信息以便快速定位问题: - 错误日志:包括完整的堆栈信息。 - 配置文件:如Flink作业的YAML配置、SQL脚本等。 - 环境信息:包括Flink版本、CDC连接器版本、数据库版本等。

通过以上步骤,您可以系统性地排查和解决Flink CDC案例运行失败的问题。如果仍有疑问,请随时补充具体错误信息以便进一步分析。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。