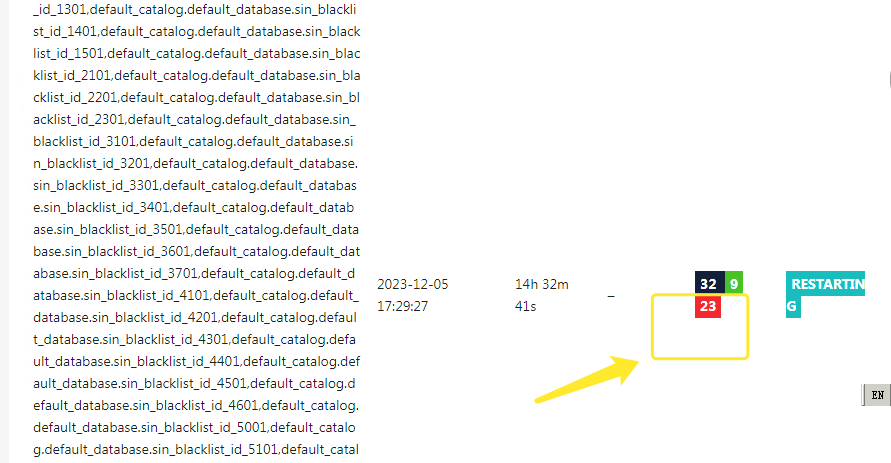

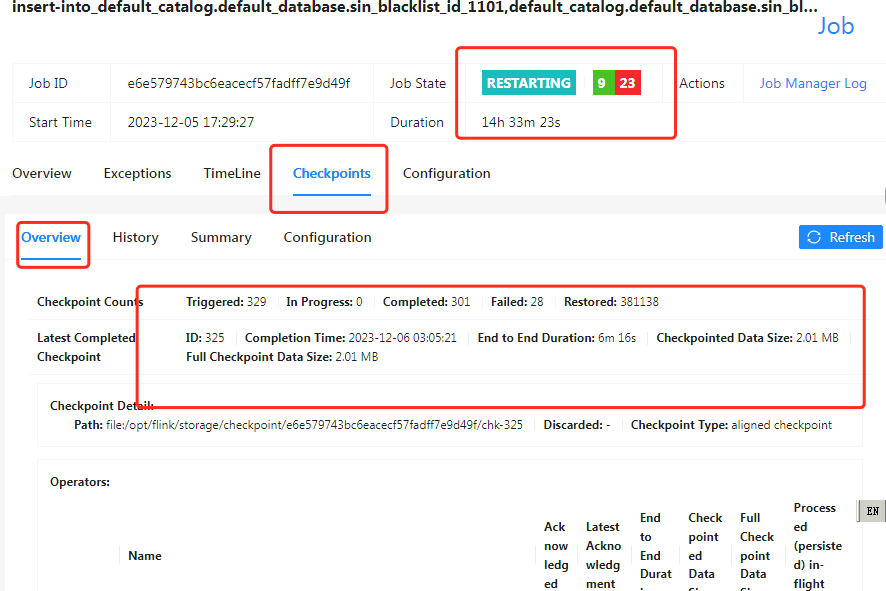

Flink CDC调整了binlog保存时间后运行任务。又出现了报错。如下图。查看日志似乎是找不到checkpoint了。能否帮忙看一下呀?。下面是提交的运行语句,报错图和日志:./bin/flink run-application --target kubernetes-application -Dkubernetes.cluster-id=cluster231205aa -Dkubernetes.rest-service.exposed.type=NodePort -Dkubernetes.namespace=flink -Dkubernetes.jobmanager.service-account=flink-service-account -Dkubernetes.container.image.ref=swr.cn-north-4.myhuaweicloud.com/commons/toll_pro_02:1.17.1 -Dkubernetes.container.image.pull-secrets=regcred3 -Dtaskmanager.memory.process.size=7000m -Dtaskmanager.numberOfTaskSlots=1 --pyModule ls_card_blacklist_id_32 --pyFiles /opt/python_codes/ls_card_blacklist_id_32.py

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

从您提供的信息来看,Flink CDC在调整binlog保存时间后运行任务时出现了报错。报错信息显示找不到checkpoint。这可能是由于以下原因导致的:

execution.checkpointing.interval: 5000

execution.checkpointing.min-pause: 5000

state.backend: fs

state.backend.fs.checkpointdir: hdfs:///user/flink/checkpoints/

确保您的Flink集群中有足够的磁盘空间来存储checkpoint文件。您可以使用df -h命令查看磁盘空间使用情况。

检查您的Flink日志文件(如flink-*.log),看是否有关于找不到checkpoint的错误信息。这有助于进一步诊断问题。

如果问题仍然存在,您可以尝试在Flink配置文件中增加checkpoint的超时时间。例如:

execution.checkpointing.timeout: 600000

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。