数据处理时,源表字段类型为date,结果表字段类型为TIMESTAMP,使用Flink SQL做转换CAST(date AS TIMESTAMP(6)还是会报错,数据库长度为TIMESTAMP(6)

报错如下截图:

想问有什么办法将date类型在处理时转换为TIMESTAMP类型吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果您在使用 Flink SQL 将 PostgreSQL 的 date 类型字段转换为 TIMESTAMP 类型时遇到问题,您可以尝试以下方法:

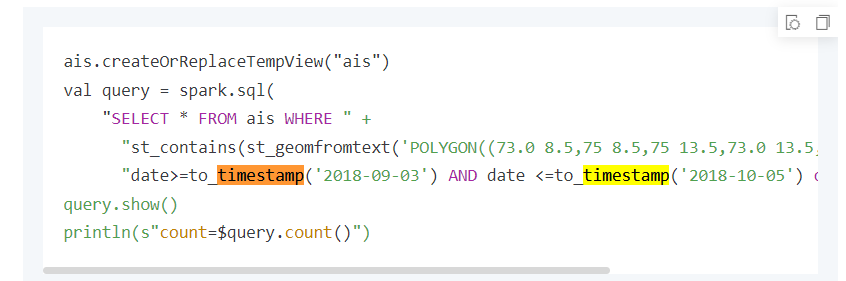

使用函数 TO_TIMESTAMP:Flink SQL 支持使用 TO_TIMESTAMP 函数将字符串或日期类型转换为 TIMESTAMP。您可以尝试使用该函数来进行转换,如下所示:

TO_TIMESTAMP(CAST(date AS VARCHAR), 'YYYY-MM-DD') AS timestamp_column

这个例子中,假设您的 date 字段是一个 date 类型,将其先转换为 VARCHAR 字符串,然后使用 TO_TIMESTAMP 函数指定日期格式将其转换为 TIMESTAMP 类型。

修改 PostgreSQL 驱动程序的配置:有时,PostgreSQL 驱动程序对于某些数据类型的默认映射可能会导致转换错误。您可以尝试修改 Flink 的 PostgreSQL 驱动程序配置,将 date 类型映射为适当的 TIMESTAMP 类型。

在 Flink 的 flink-conf.yaml 配置文件中添加以下配置:

table:

planner:

type-creation: "CUSTOM"

type-creation.class: "org.apache.flink.table.types.logical.utils.PgTypeDefaultConversion"

保存并重启 Flink 集群后,再次尝试使用 CAST(date AS TIMESTAMP) 进行转换。

请注意,这些解决方法可能因您的具体场景和 Flink 版本而有所不同

因为PostgreSQL方言只支持1到6位精度的时间戳。要解决这个问题,您可以尝试将源表中的date字段转换为TIMESTAMP类型,然后再使用Flink SQL进行处理。

将date字段转换为TIMESTAMP类型:

ALTER TABLE source_table

ALTER COLUMN plan_start_time TIMESTAMP;

plan_start_time的date字段转换为了TIMESTAMP类型。这样,当您使用Flink SQL处理这个字段时,就不需要再使用CAST函数了。

您可以通过在Flink SQL中使用TO_TIMESTAMP函数来将date类型转换为TIMESTAMP类型。TO_TIMESTAMP函数接受一个日期值,并将其转换为时间戳。

SELECT TO_TIMESTAMP('2021-08-01', 'YYYY-MM-DD') AS timestamp;

date值 '2021-08-01' 转换为了一个时间戳。

这个问题是由于Flink SQL在处理日期类型时,将源表字段类型为date转换为结果表这个问题是由于Flink SQL在处理日期类型时,将源表字段类型为date转换为结果表字段类型为TIMESTAMP时,精度超出了PostgreSQL支持的范围。为了解决这个问题,你可以尝试使用以下方法:

SELECT CAST(date_column AS TIMESTAMP) as timestamp_column

FROM source_table;

CAST函数进行转换时,指定一个更大的时间戳精度范围。例如,将TIMESTAMP(6)改为TIMESTAMP(9):SELECT CAST(date_column AS TIMESTAMP(9)) as timestamp_column

FROM source_table;

这样应该可以解决你遇到的问题。

数据库驱动不支持:某些数据库驱动可能不支持将date类型直接转换为TIMESTAMP类型。在这种情况下,你可以尝试先将date类型转换为字符串类型,然后再将其转换为TIMESTAMP类型。

数据格式问题:确保你的日期数据格式与TIMESTAMP类型所期望的数据格式相匹配。例如,如果TIMESTAMP类型需要'YYYY-MM-DD HH:MM:SS'格式的日期,而你的日期数据是'YYYY/MM/DD'格式,那么就会出现错误。

字段长度问题:虽然你提到数据库长度为TIMESTAMP(6),但请确保你在SQL语句中指定的精度也与之匹配。例如,如果你在CAST函数中使用了TIMESTAMP(3),那么它可能会因为精度不匹配而导致错误。

解决这个问题的一种可能的方法是使用CONCAT函数和TO_TIMESTAMP函数来组合和转换日期字段。例如:

SELECT TO_TIMESTAMP(CONCAT(CAST(your_date_column AS STRING), ' 00:00:00'), 'yyyy-MM-dd HH:mm:ss') AS timestamp_column

这个查询首先将date字段转换为字符串,然后添加时间部分(在这个例子中是午夜),最后使用TO_TIMESTAMP函数将其转换为TIMESTAMP类型

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。