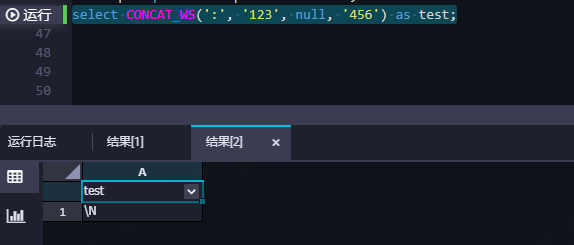

大数据计算MaxCompute正常spark那些他应该变成:123::456才对?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在MaxCompute中,如果你想让Spark的行为更接近Hive,你可以设置odps.sql.hive.compatible为TRUE。然后,你可以使用CONCAT_WS函数来连接字符串,其中null值将被忽略。

你的查询应该修改为:

SET odps.sql.hive.compatible=TRUE;

SELECT CONCAT_WS(':', '123', NULL, '456') AS test;

这将返回一个结果,其中包含三个字段的值,即'123:NULL:456'。注意,NULL值被忽略了,而不是被视为空白。

spark-sql> select concat_ws(':','avg',null,'34');

avg:34

Time taken: 0.101 seconds, Fetched 1 row(s)

这个函数会忽略参数为null的值,但不会忽略空字符串。 ,此回答整理自钉群“MaxCompute开发者社区2群”

在MaxCompute中,数据类型是按照列存储的,而不是按照行存储的。因此,如果您想将一个字符串类型的值转换为数字类型,需要使用相应的转换函数。例如,如果您想将字符串"123::456"转换为数字类型,可以使用如下代码:

from pyspark.sql import SparkSession

# 创建SparkSession对象

spark = SparkSession.builder.appName("example").getOrCreate()

# 读取数据

data = spark.read.text("path/to/your/data")

# 定义转换函数

def convert_string_to_number(value):

return int(value.split(':')[1])

# 应用转换函数并显示结果

result = data.selectExpr("convert_string_to_number(value) as number").show()

在这个例子中,我们首先创建了一个SparkSession对象,然后使用read.text方法读取了文本文件中的数据。接下来,我们定义了一个名为convert_string_to_number的转换函数,该函数接受一个字符串参数并将其转换为数字类型。最后,我们使用selectExpr方法应用了转换函数,并将结果打印出来。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。