我直接用Flink CDC代码消费kafka数据没问题,大家有遇到过这种问题不?

我直接用Flink CDC代码消费kafka数据没问题,

但是用flinksql消费kafka数报警告,大家有遇到过这种问题不?

2023-11-17 09:45:39 WARN (org.apache.kafka.clients.consumer.ConsumerConfig:logUnused) - The configuration 'partition.discovery.interval.ms' was supplied but isn't a known config.

-

面对过去,不要迷离;面对未来,不必彷徨;活在今天,你只要把自己完全展示给别人看。

您的警告消息表明,在Kafka消费者配置中设置了一个未知的配置项“partition.discovery.interval.ms”。这是由于"partition.discovery.interval.ms"并不是KafkaConsumer的标准配置项,它仅适用于Kafka源。

要解决此问题,请忽略警告,或者取消在Kafka消费者配置中设置此参数,因为它是专门为Kafka源设计的。2023-11-29 14:20:19赞同 展开评论 打赏 -

这个是ddl写错了吧,connecter信息,只要格式没错,就不会报语法错误的,你看看kafka的conf是不是前面要加一个 properties.

properties.partition.discovery.interval.ms这样试试

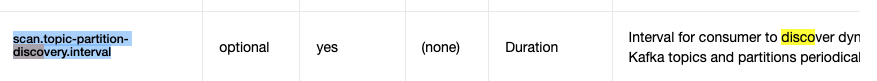

scan.topic-partition-discovery.interval

,此回答整理自钉群“Flink CDC 社区”2023-11-22 11:59:56赞同 1 展开评论 打赏 -

是的,我遇到了这个问题。这个警告是因为Flink SQL的Kafka connector中不包含"partition.discovery.interval.ms"这个配置项,而CDC的Kafka connector则包含了这个配置项。你可以忽略这个警告,它不会影响你的程序运行。

2023-11-22 08:54:36赞同 展开评论 打赏

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。